Werbung

Overclocking ist für viele zum Volkssport geworden, auch weil es so einfach gemacht wird und die Hersteller teilweise Automatismen entwickelt haben, die das Overclocking unterstützen sollen. Doch viele Anwender möchten auch gerne wissen was bei einem Overclocking der Grafikkarte überhaupt passiert, worauf zu achten ist und welche Tricks es dabei gibt, das ideale Ergebnis zu erreichen. Am Beispiel der aktuellen High-End-Modelle von AMD und NVIDIA wollen wir die Entwicklung und Ausarbeitung eines Overclockings einmal genauer beleuchten, denn mit einer einfachen Erhöhung von Takt und Spannung ist es heute nicht mehr getan.

Die Einführung von Boost-Mechanismen bei den Grafikkarten haben den Prozess des Overclockings verändert. Nicht mehr nur Takt und Spannung sind zu beachten, sondern weitere Faktoren spielen mit hinein und können den Nutzer bei der Findung des besten OC-Ergebnisses entweder unterstützen oder im schlimmsten Fall auch behindern. Dazu muss erst einmal erklärt werden, welche Mechanismen hinter GPU-Boost bei NVIDIA und PowerTune von AMD stecken.

Am Beispiel zweier Grafikkarten erläutern wir den OC-Prozess dann im Detail. Die Mechanismen lassen sich auch auf die kleineren Modelle von AMD und NVIDIA übertragen. Mit der Radeon R9 290X und GeForce GTX 980 haben wir uns aber die beiden schnellsten Karten geschnappt und versucht das Maximum aus den GPUs zu quetschen. Zunächst aber etwas Theorie.

[h3]AMD PowerTune[/h3]

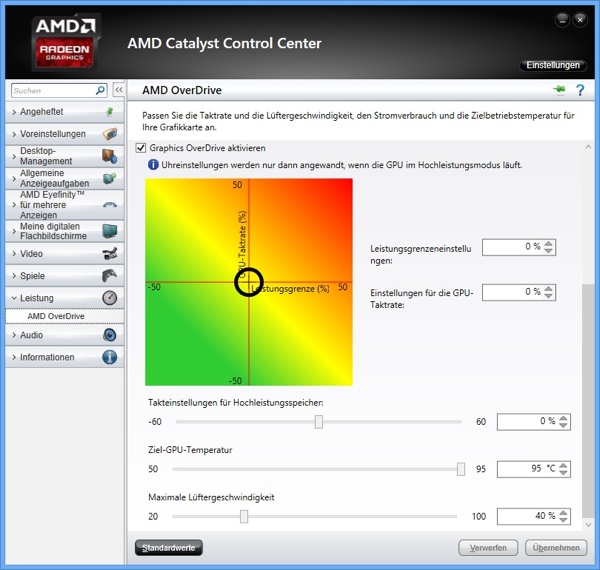

PowerTune heißt bei AMD die Technik hinter der Steuerung von Takt und Spannung bei den eigenen GPUs. Anhand bestimmter Profile werden unterschiedliche Zustände beschrieben, die wiederum Takt und Spannung festlegen. Wie auch bei den Boost-Mechanismen bei den Prozessoren sind Takt und Spannung aber längst nicht mehr die einzigen Abhängigkeiten innerhalb der Methodik. Mit den "Hawaii"-Karten führte AMD eine weitere Komponente zu PowerTune hinzu: die Temperatur. Auf Seiten der Hardware werden seither Temperatur und ein hochgerechneter Verbrauch ermittelt, sowie ein neuer VR-Controller verwendet, der seine Daten ebenfalls an die SMU-Firmware weitergibt. Aus diesen drei Datensätzen werden dann die richtigen Einstellungen ermittelt, die dann wiederum an die Hardware weitergegeben werden. Aus den entsprechenden Voreinstellungen folgen dann die Taktfrequenz, Spannung und auch Drehzahl des Lüfters.

Für die aktuelle PowerTune-Implementation verwendet AMD einen neuen Serial-VID (Spannungscontroller). Dieser kommt im Zusammenspiel mit allen neuen GPUs zum Einsatz. Besonders die Geschwindigkeit in denen Änderungen der Spannung möglich sind, haben sich dazu geführt, dass die Karten sowohl sparsamer sind, aber bei Bedarf auch mehr Leistung abrufen können. Bei den AMD-Karten erreicht der Spannungscontroller Änderungen im Bereich von 10 µs. Eine weitere wichtige Rolle spielt die Genauigkeit, mit der die Spannung eingestellt wird. Auch hier hat PowerTune in der 2. Generation einen großen Sprung gemacht und kommt inzwischen auf 6,25-mV-Schritte. Bei einer möglichen Arbeitsspannung zwischen 0 und 1,55 Volt ergeben sich hier eigentlich 248 Spannungs-Schritte, wenngleich AMD 255 mögliche Schritte angibt (vermutlich wegen der Ansteuerung über 8 Bit). Doch auch die Daten die vom Controller für PowerTune zur Verfügung stehen, sind laut AMD entscheidend. So werden die Messwerte für Strom und Spannung in 40 kHz angefragt und über eine 20 Mbps breite Datenverbindung an die SMU-Firmware übertragen. Auf einige dieser Werte hat der Nutzer über eine geeignete Overclocking-Software Zugriff, doch dazu kommen wir später.

[h3]GPU-Boost 2.0[/h3]

Mit dem "Kepler"-Vollausbau in Form des GK110 auf der GeForce GTX Titan versuchte sich auch NVIDIA an einer Erweiterung des Boost-Mechanismus. Bei GPU-Boost 1.0 wird noch ein maximaler Verbrauch anhand der aktuell anspruchsvollsten Spiele gesucht. Die von der GPU erreichte Temperatur spielt hier noch keine Rolle und tritt allenfalls in Erscheinung, wenn die Shutdown-Temperatur erreicht wird, die mit 105 °C aber meist jenseits von Gut und Böse liegt. Der maximale Takt wurde also auf Basis der relativen Spannung ermittelt. Der Nachteil ist offensichtlich: GPU-Boost 1.0 konnte nicht verhindern, dass selbst bei einer eigentlich unkritischen Spannung eine zu hohe Temperatur erreicht wurde.

Datenschutzhinweis für Youtube

An dieser Stelle möchten wir Ihnen ein Youtube-Video zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Youtube setzt durch das Einbinden und Abspielen Cookies auf ihrem Rechner, mit welchen Sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf den Play-Button. Das Video wird anschließend geladen und danach abgespielt.

Ihr Hardwareluxx-Team

Youtube Videos ab jetzt direkt anzeigen

Mit GPU-Boost 2.0, wie er auf allen aktuellen Karten von NVIDIA angewendet wird, spielen zwei weitere Werte eine wichtige Roll: Spannung und Temperatur. Zukünftig wird die relative Spannung (Vrel) also anhand dieser beiden Parameter bestimmt. Die Abhängigkeit der einzelnen GPUs aufgrund der Fertigung und Ausbeute bleibt aber natürlich bestehen und somit bleibt es auch dabei, dass nicht jede Karte wie die andere funktioniert. NVIDIA aber gibt an, dass technisch normiert ein 3-7 Prozent höherer Boost-Takt durch das Einbeziehen der Temperatur möglich ist.

GPU Boost 2.0 bezieht die Temperatur mit ein, kann bei niedriger Temperatur also noch mehr Spannung geben als zuvor. 80 °C sind die per Default gesetzte Zieltemperatur (Ttarget). Dies kommt vor allem Nutzern von Karten zu Gute, die eine Wasserkühlung verwenden, was für die GPU niedrige Temperaturen zur Folge hat. Extremere Kühlungen, z.B. mit LN2, bieten diesen Vorteil natürlich auch.