Nun wollen wir zu den Benchmarks übergehen. Wir haben uns dagegen entschieden bis auf wenige Ausnahmen die üblichen synthetischen Benchmarks zu verwenden. Stattdessen wollen wir einmal eher praxisorientiert an die Sache heran gehen und haben uns daher für ein zahlreiche Rendering-Aufgaben sowie einen Deep-Learning-Benchmark entschieden. Auf die Details werden wir noch genauer eingehen.

Als Testsytem kamen folgende Komponenten zum Einsatz:

- Intel Core i7-3960X 3,3 @ 3,9 GHz

- Corsair H110i GT All-in-One-Wasserkühlung

- ASUS P9X97 Deluxe

- 16 GB DDR3

- OCZ Arc 100 240 GB

- Seasonic Platinum Series 1.000 Watt

- Windows 10 64 Bit

Als Treiber haben wir den NVIDIA Quadro-Treiber R384 U4 und AMD Radeon Pro Software 17.Q3.1. Für die Render-Benchmarks haben wir zudem die dazugehörigen Software-Pakete wie den Radeon ProRenderer installiert, um die volle Potenzial der Hardware auch umsetzen zu können. Gleiches gilt für die entsprechenden NVIDIA-Pakete.

Luxmark 3.0

Den Anfang macht der Luxmark in der Version 3.0, den wir für die Messung der OpenCL-Leistung verwendet haben. Wir haben die drei Presets für alle getestet und die Samples pro Sekunde als Wert genommen.

Luxmark 3.0

Hotel Lobby

Werbung

Luxmark 3.0

Neuman

Luxmark 3.0

LuxBall

Blender

Als zweiten Benchmark haben wir Blender gewählt. Hier haben wir den bekannten Blender-Benchmark genommen, also eine vom Entwickler zur Verfügung gestellte 3D-Szene, die berechnet werden muss. Damit Blender auch die GPU für das Rendering verwendet, muss in den Einstellungen die dazugehörige Hardware in Form der GPU ausgewählt werden. Auch in den Render-Einstellungen ist die Auswahl der GPU als Rechenhardware notwendig. Zudem haben wir die Batch-Size, also die Größe der Kachel die pro Thread berechnet wird, von 16 auf 256 Pixel erhöht. Dies kommt der Vorgesehensweise einer GPU mit mehreren hundert oder gar tausend Shadereinheiten entgegen. Aufgenommen haben die Dauer in Sekunden, um die Szene vollständig zu berechnen.

Blender

Blender-Benchmark

Adobe After Effects

Adobe After Effects haben wir verwendet, um unser Intro für die Videos in 4K-Auflösung mit Alphakanal zu rendern. Üblicherweise rendern wir das Intro für die Messen einmal neu und verwenden dann für alle zukünftigen Videos eben dieses Pre-Rendered-Intro. Die sechs Workstation-Karten mussten die Szene aber jeweils einmal neu berechnen. Aufgenommen haben die Dauer in Sekunden, um die Szene vollständig zu berechnen.

Adobe After Effects

4K-Intro Rendering

V-Ray Benchmark

Weiter geht es mit dem V-Ray Benchmark. Dabei handelt es sich um einen synthetischen Benchmark der Chaosgroup, die als Macher des Plugins V-Ray für zahlreiche 3D-Render-Pakete bekannt sind. Auch hier wird wieder die Dauer in Sekunden zur Fertigstellung der Szene aufgenommen.

V-Ray

V-Ray-Benchmark

Unreal Engine Infiltrator Rendering

Eine weiterer, eher praxisorientierter Vergleich ist sicherlich das Rendering der Infiltrator-Demo in der Unreal Engine 4. Die Infiltrator-Demo wurde von NVIDIA häufiger bei Produktpräsentationen gezeigt und konnte lange Zeit nicht in Echtzeit ausgeführt werden. Um alle Assets und 3D-Modelle in einer lauffähigen Demo zu aus dem Unreal-Engine-Editor zu starten, benötigt viel Rechenleistung. Wir haben wieder die Zeitdauer aufgenommen.

Unreal Engine

Infiltrator Rendering

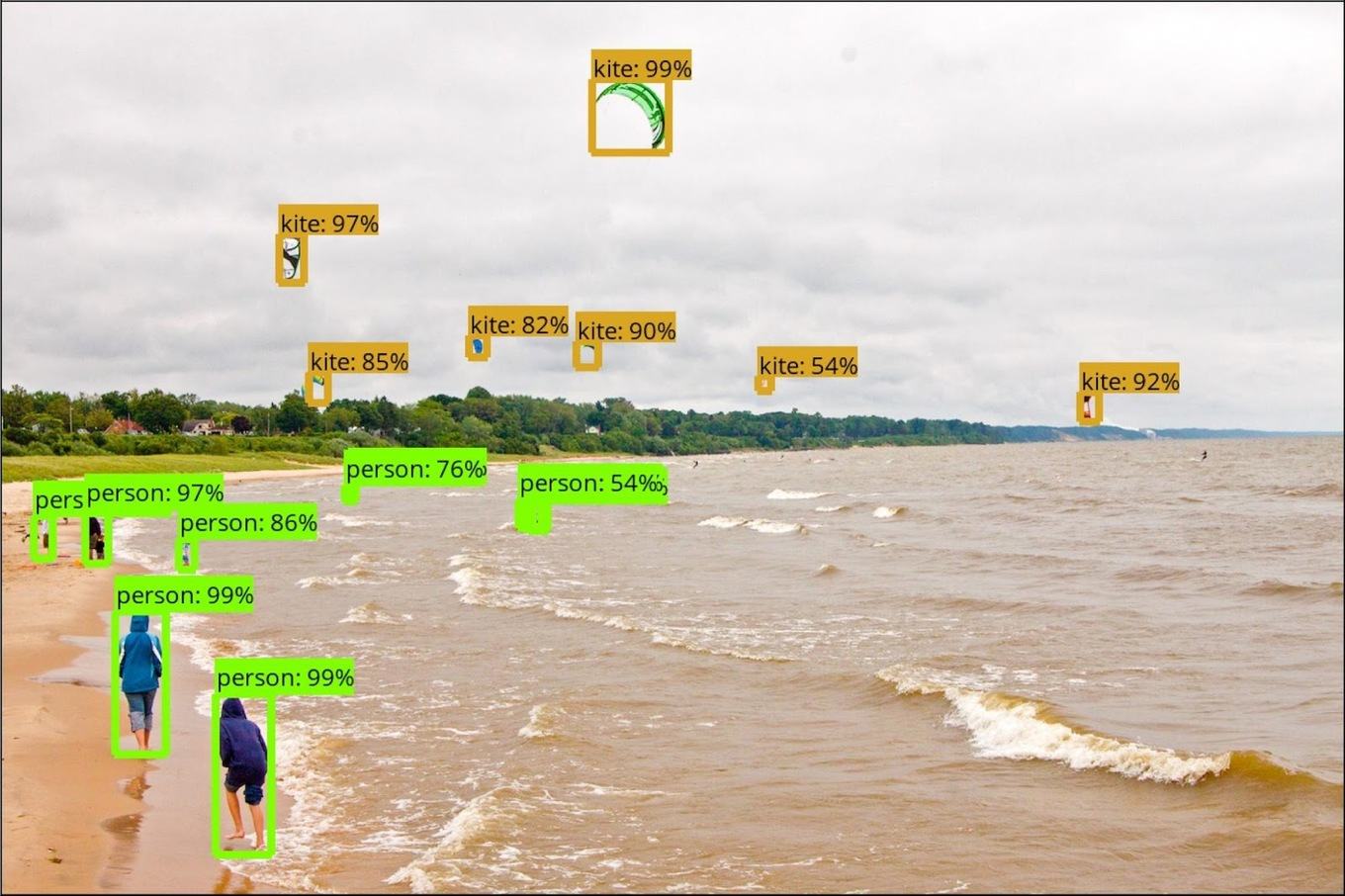

Deep Learning Benchmark

In einem letzten Vergleich haben wir uns die Leistung für das Training eines kleines Deep-Learning-Netzwerkes angeschaut. Zuvor sei aber gesagt, dass ein Training eines solchen Netzwerkes keine echte Domäne der Workstation-Karten ist. Dennoch aber setzen viele Anwender solcher Netzwerke auf eben diese Hardware – wenngleich NVIDIA mit den Tesla-Karten und AMD zukünftig mit den Radeon-Instinct-Karten spezielle Hardware anbieten.

Wir haben uns eine Beispielbibliothek für das Training einer Fotobibliothek von TensorFlow genommen und diese auf einem Ubuntu 14.04 zusammen mit den dazugehörigen Deep-Learning-Schnittstellen für AMD und NVIDIA installiert. Die von uns gewählte Beispielbibliothek umfasst 200 GB an Bilddaten (ungefähr 40.000 Fotos). Die Beispielbibliothek wird daraufhin komplett durchlaufen, jedes Bild in Kacheln mit einer Größe von 32 x 32 Pixel aufgeteilt und entsprechend der abgebildeten Gegenstände mit den dazugehörigen Metainformationen versehen. Dazu gehören beispielsweise Flugzeug, Auto, Katze, Gesicht, Schiff und vieles mehr.

Aufgrund der geringen Größe der Beispielbibliothek haben wir nicht die Gesamtdauer für die Fertigstellung aufgenommen, sondern die Anzahl der Bilder pro Sekunde. Dies wäre für größere Datenmengen der entscheidende Faktor.

Deep Learning

TensorFlow Bilderkennung