Werbung

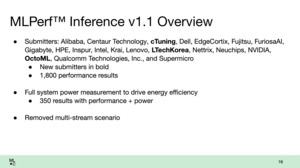

In einem sechsmonatigen Rhythmus hat MLCommons die Version 1.1 der Inferencing-Resultate veröffentlicht. Wie immer stammen die Ergebnisse von Dell, HPE, Inspur, Intel, Lenovo, NVIDIA, Qualcomm, Gigabyte, Supermicro und einigen mehr. Eine gegenseitige Review-Schleife eröffnet jedem Teilnehmer die Möglichkeit, die Resultate des anderen zu prüfen. MLCommons überprüft die Resultate natürlich ebenfalls.

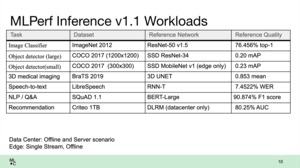

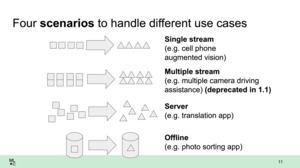

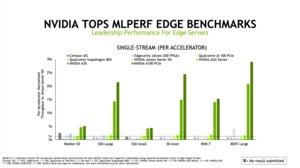

Die Inferencing-Ergebnisse in der Version 1.1 können ab sofort abgerufen werden. Unterschieden wird dabei zwischen dem Datacenter-Einsatz mit den entsprechenden Ergebnissen sowie dem Edge-Einsatz. Während die Effizient vor allem bei den Edge-Servern von entscheidender Bedeutung ist, geht es im Datacenter vor allem um die Skalierung der komplexen Datensätze.

AI- und ML-Benchmarks sind allerdings nicht ganz so einfach, wie der Start eines 3DMark-Durchlaufs oder dergleichen. Schon für unsere Serverbenchmarks ergibt sich in unseren Tests ein gehöriger Aufwand. Für die MLPerf-Benchmarks ist die Komplexität noch einmal deutlich höher. Es gibt daher sogenannte Closed-Ergebnisse, bei denen es strenge Vorgaben für die Verarbeitung der Daten gibt. Layer und die Gewichtung der Daten dürfen nicht verändert werden. Über Frameworks und das Datenlayout können die eingereichten Ergebnisse jedoch optimiert werden. In den Open-Model-Ergebnissen können weitaus weitreichendere Optimierungen vorgenommen werden. Diese Ergebnisse sind allerdings nicht mehr zwangsläufig miteinander vergleichbar.

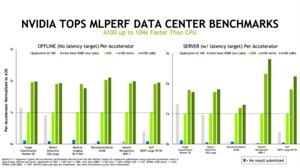

Im Vergleich zu den Inferencing-Ergebnissen der Version 1.0 aus dem Frühjahr sind nicht allzu viele neue Hardware-Konfigurationen hinzugekommen. Qualcomm steuert mit seinem Cloud-AI-100-Beschleuniger deutlich mehr Ergebnisse bei und kämpft in dieser Hinsicht vor allem mit den Systemen von NVIDIA.

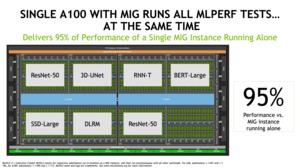

Auffällig ist überwiegend: Da sich in den Hardwarekonfigurationen recht wenig getan hat, zeigen sich die Softwareoptimierungen besonders deutlich. Hier geht es Mal von wenigen Prozentpunkten bis um den Faktor zwei nach oben – nur durch die Art und Weise wie die Daten von der Hardware verarbeitet werden.

Qualcomm will die Großen ärgern

Besonders Qualcomm tut sich bei den Inference-1.1-Ergebnissen hervor und proklamiert für sich eine führende Positionen in den wichtigsten Anwendungsbereichen. Qualcomm ist vielen sicherlich nicht aus diesem Bereich bekannt. Mit dem Cloud-AI-100-Beschleuniger will man im Datacenter und für Edge-Server nun aber Fuß fassen.

Einige Beispiele, in denen der Cloud-AI-100-Beschleuniger seine Stärken ausspielen können soll, ist der ResNet-Offline-Benchmark, bei dem 16 Cloud AI 100 mit jeweils 75 W schneller sein sollen, als acht A100 Tensor GPUs mit jeweils 500 W. Die Effizienz soll eine der Stärken der Hardware von Qualcomm sein. Für Edge-Systeme sind die 75 W des Cloud-AI-100-Beschleunigers ebenfalls gut geeignet und sollen auch hier effizienter als die A10- und A40-GPUs von NVIDIA sein.

Eine weiterer Faktor für diese Systeme ist die Latenz. Aber auch hier sieht Qualcomm sich gut aufgestellt und bietet mit der eigenen Hardware geringe Latenzen und einen pro Inferencing-Vorgang geringeren Stromverbrauch.

NVIDIA sieht das größere Bild

Für NVIDIA stand das größere Bild im Fokus und auch wenn Qualcomm ihnen in einigen Teilbereichen die Butter vom Brot nehmen konnte, so sieht sich NVIDIA dennoch weiter in führender Position für das Inferencing. Auch bei NVIDIA gab es in fast allen Teilbereichen eine Leistungssteigerung, die aufgrund fehlender neuer Hardware ausschließlich auf Softwareoptimierungen zurückzuführen ist. Der komplette Software-Stack ist ohnehin eine der Stärken von NVIDIA – inzwischen arbeiten bei NVIDIA doppelt so viele Software-Entwickler wie Hardware-Ingenieure.

NVIDIA sieht die aufkommende Konkurrenz durch den Cloud-AI-100-Beschleuniger von Qualcomm allen voran für die kleinere Inference-Lösung A30. Dort, wo der Stromverbrauch keine große Rolle spielt, bzw. es darum geht, auch beim Inferencing möglichst schnell zu arbeiten, soll die A100 Tensor GPU weiterhin das Maß aller Dinge sein. Wie immer gilt es nicht einfach nur die Länge der Balken zu betrachten, sondern das gesamte Spektrum.

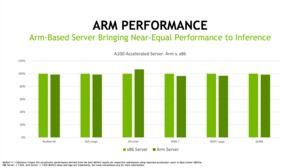

Eines ist in den Resultaten, bzw. deren Präsentation durch NVIDIA auffällig: Häufig werden Vergleiche zwischen x86- und ARM-Servern gezogen und NVIDIA wurde nicht müde zu betonen, dass ARM-Server auch im Datacenter eine zunehmend größere Rolle spielen werden und sich nicht mehr hinter den x86-Servern verstecken müssen. Da NVIDIA den Kauf von ARM beabsichtigt (zahlreiche Regulierungsbehörden müssen dem noch zustimmen), sind die Verweise auf ARM-Prozessoren natürlich im ureigenen Interesse für NVIDIA.

MLPerf mit eigener App

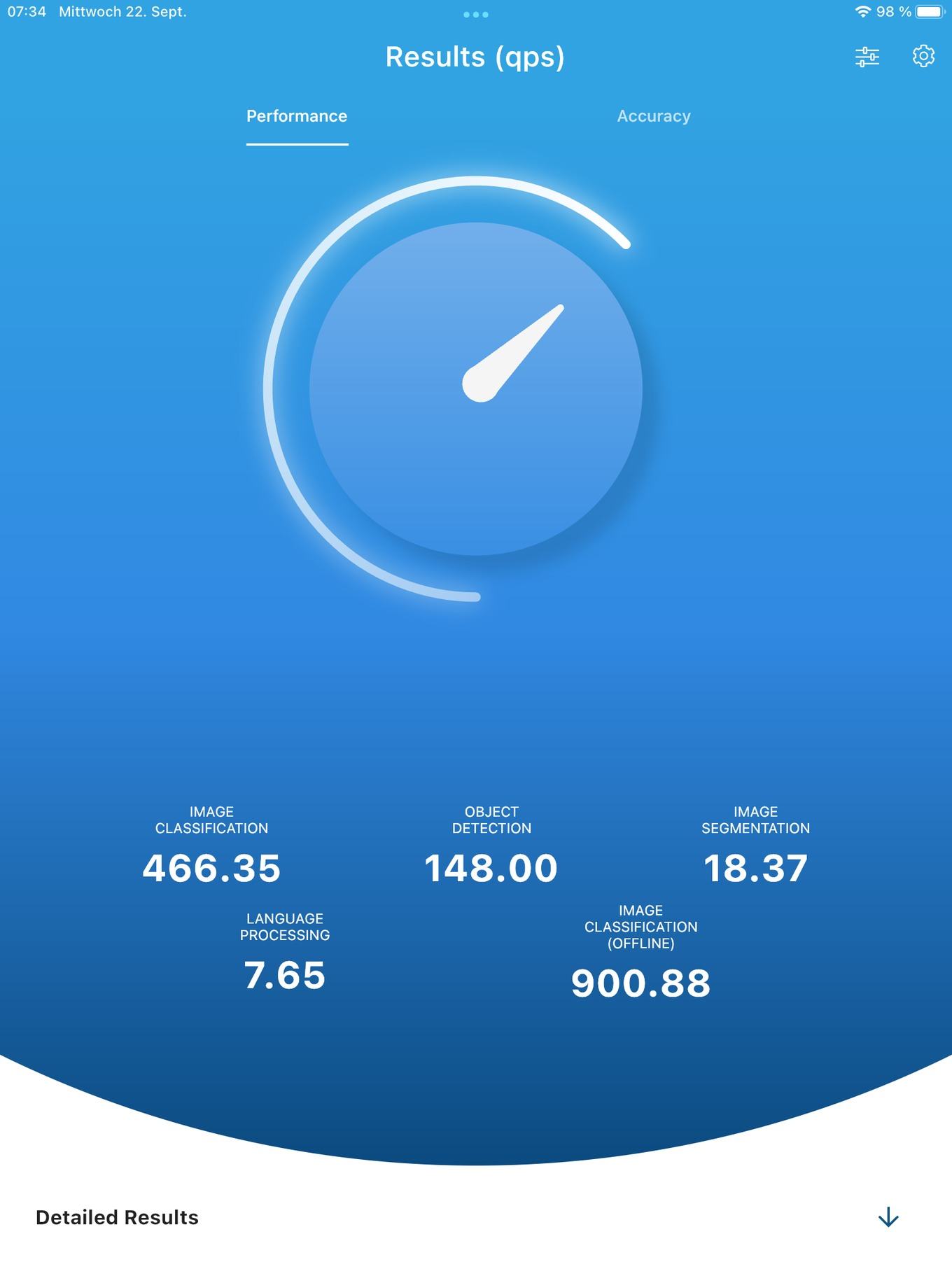

Womöglich in dieser Woche wird MLPerf zudem eine App vorstellen, die im App-Store für iOS und Google Play erhältlich sein wird. Die App soll typische Inferencing-Anwendungen simulieren und Ergebnisse liefern, die einen Vergleich zwischen den verschiedenen Mobilgeräten ermöglichen.

Wir konnten eine Beta-Version von MLPerf testen und haben den Benchmark auf einem iPhone X, iPhone 12 und einem iPad 2020 durchgeführt.

In gewisser Weise können wir anhand der drei Ergebnisse schon sehen, wohin die Reise in den letzten drei bss vier Jahren gegangen ist. Nicht nur Apple, auch die SoC-Hersteller setzen verstärkt auf AI-Beschleuniger und deren Leistung zeigt sich anhand des A12 im iPad sowie dem A14 Bionic im iPhone 12. Das iPhone X hingegen muss noch mit einem A11 auskommen und liefert deutlich schlechtere Ergebnisse.

Inwieweit solche Benchmark-Ergebnisse aussagekräftig sind, ist schwer zu beurteilen. Natürlich lässt sich die verbaute Hardware damit 1:1 vergleichen, ob der Nutzer nun aber in der Praxis auch spürt, dass eine Bilderkennung schnell stattfindet, steht auf einem anderen Blatt. Bei Apples iPhone findet die Analyse der vorhandenen Bilddaten nachts statt, wenn das iPhone geladen wird. Wenn in der Nutzung in den Bildern dann nach einem Gattungsbegriff gesucht wird, wird nur noch nach den entsprechenden Tags gesucht. Eine Online-Bilderkennung ist meist durch die Anbindung des Geräts an das Internet limitiert und nicht an die Rechenleistung des SoCs.

Als Hilfsmittel ist der MLPerf-Benchmark im Rahmen zukünftiger Reviews sicherlich sinnvoll.