Werbung

In seinem Engineering-Blog erklärt Meta, wie man seine Infrastruktur für AI-Cluster aufbaut, betreibt und optimiert. Meta verwendet KI-Systeme in fast all seinen Services. Das letztendliche Ziel ist eine allgemeine künstliche Intelligenz (AGI), die nicht mehr auf eine spezielle Aufgabe ausgelegt ist, sondern über alle Bereiche hinweg arbeiten kann.

Für das Training seiner Large Language Models (LLMs) verwendet Meta große Cluster mit jeweils 24.576 H100-Beschleuniger von NVIDIA. Dies zeigt dann auch, bis zu welcher Systemgröße diese Beschleuniger inzwischen zusammen verwendet werden können. NVIDIAs eigener Supercomputer EOS kommt mit 4.096 H100-Beschleuniger und liegt aktuell auf Platz neun der schnellsten Supercomputer. Die zwei AI-Cluster von Meta müssten demnach in etwa sechsmal schneller sein.

Aktuell arbeitet Meta am Training seiner nächsten Generation eines AI-Modells namens Llama 3.

Einmal mehr wird offensichtlich, dass die Interconnect- und Netzwerk-Verbindungen in einem solchen Cluster von großer Bedeutung sind. Cluster 1 verwendet Remote Direct Memory Access (RDMA) über ein Ethernet-Fabric (RoCE) unter Verwendung von Arista 780, Wedge40 und Minipack2 OCP Netzwerkhardware. Das Cluster 2 setzt auf NVIDIAs Quantum2 InfiniBand mit 400 GBit/s.

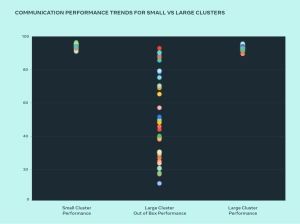

Über den Aufbau, Nutzung und Optimierung auf RoCE und InfiniBand lernt Meta viel über den Aufbau solcher AI-Cluster. Diese sind erst in den letzten Monaten über mehrere tausend Beschleuniger hinausgewachsen. Auch für HPC-Cluster ist die Skalierung über mehreren tausend Beschleuniger häufig die größte Herausforderung. Viele Unternehmen setzen daher auf eher kleine Cluster, da sie diese besser auslasten können. Große LLMs sind aufgrund der enormen Datenmengen aber darauf angewiesen, dass diese Daten sich bestenfalls komplett in den Speichern der Beschleunigern befinden. Entsprechend wuchsen die AI-Cluster immer weiter an.

Ohne eine entsprechende Optimierung konnten diese Systeme in der Vergangenheit nur eine Auslastung zwischen 10 und 90 % erreichen. Das Ziel sind jedoch konstante und vorhersehbare 90+ % an Auslastung. Eben dieses hat Meta in den zwei Clustern nun erreicht.

Für 2024 hat Meta das Ziel ausgerufen, in der gesamten Infrastruktur etwas 350.000 H100-Beschleuniger einzusetzen. Damit gehört man sicherlich zu den größten Kunden NVIDIAs und sorgt dort für extreme Gewinne. Über die gesamte Infrastruktur hinweg werden aber auch andere Beschleuniger zum Einsatz kommen, deren Äquivalent dem von 600.000 H100-Beschleunigern entspricht. AMD dürfte sich über einige Bestellungen freuen.