Werbung

Im Rahmen einer Fragerunde mit NVIDIA-CEO Jensen Huang konnten Journalisten einige Fragen zu den Neuvorstellungen oder der grundsätzlichen Ausrichtung von NVIDIA stellen. Daneben hat es eine weitere Fragerunde mit GPU-Architektur-Entwickler Jonah Alben gegeben, so dass wir zur Ankündigung der Blackwell-Architektur und der dazugehörigen GB100-GPU ein paar weitere Details haben.

Zunächst einmal sind die Blackwell-Architektur und die GB100-GPU eine der größten Investitionen, die NVIDIA bisher getätigt hat. 10 Milliarden US-Dollar sind in die Entwicklung geflossen. Zugleich wurde nach der Keynote ein vermeintlicher Preis für einen B100-Beschleuniger genannt, der zwischen 30.000 und 40.000 US-Dollar liegen soll. Jensen Huang wollte diese Zahl nicht bestätigen – man habe noch keinen Preis für die neuen Produkte, die ja auch erst gegen Ende des Jahres verfügbar sein sollen. Die aktuellen H100/H200-Beschleuniger liegen ebenfalls bereits in diesem Preisbereich, ein B100/B200-Beschleuniger wird ungleich teurer sein, denn NVIDIA bringt hier gleich zwei Chips zum Einsatz. Beim Grace Blackwell Superchip sind es gleich vier Chips auf zwei GB100-GPUs plus einer Grace-CPU.

Zudem verwies Jensen darauf, dass NVIDIA keine einzelnen GPUs verkaufe. Stattdessen verkaufe man Systeme. Dies lässt die Frage offen, ob es einzelne B100-Beschleuniger zu kaufen geben wird, oder diese immer gleich in einem DGX- oder GB200-NVL72-System stecken.

In gewisser Weise mit der Frage des Preises gekoppelt, ist das Upgrade-Pfad, der mit den B100-Beschleunigern eingegangen werden kann. DGX-H100-Systeme können auch mit den neuen B100-Beschleunigern bestückt werden. Hier besteht eine sogenannte In-Drop-Kompatibilität. B200-Beschleuniger werden nicht mehr kompatibel sein, auch weil diese eine TDP von 1.000 W vorzuweisen haben.

Mit der Blackwell-Architektur findet laut NVIDIA eine Verschiebung in Richtung des Inferencing, also der Nutzung von GenAI-Modellen, statt. Das Training rückt hier etwas in den Hintergrund. Natürlich werden die Modelle immer wieder trainiert werden müssen, da jedoch mehr und mehr Ressourcen für das noch immer teure und aufwändige Inferencing aufgewendet werden müssen, ist eine entsprechende Ausrichtung auf diesen Anwendungsbereich sicherlich sinnvoll.

Der immer höhere Inferencing-Bedarf besteht einerseits aus mehr und mehr Nutzern, die Generative AI in seinen verschiedensten Ausprägungen nutzen und zum anderen auch darin, dass die Modelle mit immer mit Tokens pro Abfrage angewendet werden, was den Inferencing-Aufwand erhöht.

Blackwell in FP64 weniger schnell

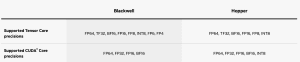

NVIDIA nennt für die Blackwell-GPU die Rechenleistung über die Tensor Cores, schweigt sich über die vorhandenen Shadereinheiten und deren Rechenleistung aus. Bereits anhand der technischen Daten, die NVIDIA offiziell für die Tensor Cores nennt, wird allerdings klar, dass es hier für die doppelte Genauigkeit (FP64) einen Rückschritt gibt. Ein H100-Beschleuniger kommt über die Tensor Cores auf eine Rechenleistung von 67 TFLOPs, für den B100- und B200-Beschleuniger sollen es nun 30, bzw. 40 TFLOPS sein.

Blackwell unterstützt – bis auf INT8 – alle Datenformate, die bereits von Hopper unterstützt werden. Aber NVIDIA sieht FP64 in der Gewichtung der Anforderungen in der Genauigkeit nicht mehr als derart wichtig an. Viele Anwendungen, die bisher auf FP64 gesetzt haben, würden genauso gut und mit der Verwendung von FP32 sogar schneller laufen, als dies mit FP64 der Fall ist. Die Anwendung von Mixed Precision ist laut NVIDIA in vielen Bereich von Vorteil. Schraubt man die Anforderungen an die Genauigkeit von FP64 auf FP32 zurück, verdoppelt sich die Rechenleistung theoretisch. Natürlich muss man dann sicherstellen, dass die verarbeiteten Daten weiterhin korrekt sind, auch wenn die Genauigkeit zurückgeschraubt wurde.

Aber wie gesagt, die genauen Details stehen hier noch aus, denn NVIDIA nennt keine weiteren Details zur Architektur und der Vektor-Rechenleistung der Shader. Zum grundsätzlichen Aufbau wollte man sich ebenfalls in keinem Detail äußern.

GB200 NVL72 angeschaut

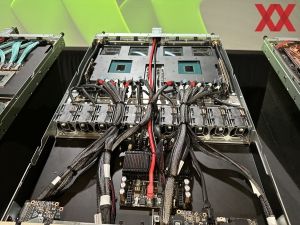

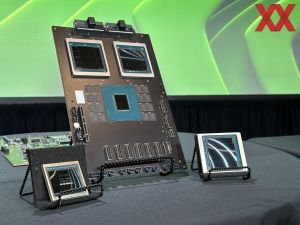

Zudem hatten wir die Gelegenheit, uns ein GB200 NVL72 genauer anzuschauen. Beim GB200 NVL72 handelt es sich um ein komplettes Rack, welches auf das Training und Inferencing von LLMs ausgelegt ist. NVIDIA will das GB200 NVL72 als Ganzes, aber in verschiedenen Ausbaustufen, bzw. mit einer unterschiedlichen Anzahl an Racks verkaufen.

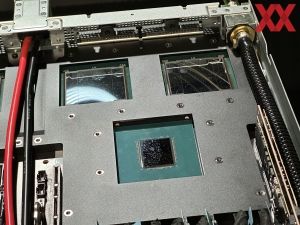

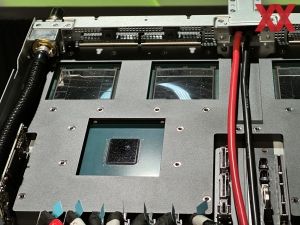

Jedes Rack besteht aus 18 Compute-Nodes mit jeweils zwei Grace Superchips und zwei daran gekoppelten GB100-GPUs. Insgesamt kommen in einem Rack also 36 Grace Superchips und 72 Blackwell-GPUs zum Einsatz. Die Gesamtspeichermenge, die damit zur Verfügung steht, liegt bei 13,5 TB an HBM3e mit einer Speicherbandbreite von insgesamt 576 TB/s. Ihren Teil zur Rechenleistung tragen 2.592 ARM-Kerne bei, die in den Grace Superchips stecken. An diese angebunden befinden sich zudem noch 17 TB an LPDDR5X mit 18,4 TB/s im System.

Das gesamte Rack ist auf eine Leistungsaufnahme von 120 kW ausgelegt. Sämtliche Nodes werden wassergekühlt. Das Datacenter muss also entsprechend auf den Verbrauch und die Anforderungen an die Kühlung ausgelegt sein. NVIDIA arbeitet hier mit den Betreibern der Datacenter zusammen und hilft diesen, die Infrastruktur entsprechend vorzubereiten.

Schaut man von Vorne auf das Rack, befinden sich oben zehn und unten acht Compute-Nodes mit den GB200-Beschleunigern. In der Mitte wiederum befinden sich die neun NVLink-Switches, welche die 72 Blackwell-GPUs miteinander verbinden. All diese Nodes sind in dem goldenen Rahmen eingefasst. Darunter und darüber befinden sich mehrere Netzteile und Switches für die InfiniBand- und Ethernet-Verbindungen.

Auf der Rückseite sind durch die Mesh-Gitter die Glasfaserkabel zu erkennen. In der Mitte sitzt das "Rückenmark" des Racks, denn durch den schmalen, vertikalen Kanal verlaufen die Kupferleitungen für die NVLink-Verbindungen. NVIDIA hat die SerDes (Serialisierer/Deserialisierer) des neuen NVLink-Switch-Chips so ausgelegt, dass diese direkt über die Kupferleitungen mit den SerDes der Beschleuniger kommunizieren können.

Für die bisherigen NVLink-Switches waren 256 direkte Verbindungen das Maximum, der neue Switch kann bis zu 576 Blackwell-GPUs und demnach 288 GB200 miteinander verbinden. Jeder Blackwell-Chip ist mit 1,8 TB/s angebunden.

Den Preis eines Racks mit GB200 NVL72 nennt NVIDIA nicht. Wir dürften hier aber von einem mittlere, einstelligen Millionenbetrag sprechen. Ab acht dieser Racks spricht NVIDIA von einem DGX GB200 SuperPod.