Werbung

Der aktuelle AI-Trend rund um GPT-4 dürfte vor allem die Unternehmen freuen, die Hard- oder Software dazu anbieten. NVIDIA ist einer der Hardwarehersteller hinter den Systemen des Large Language Modells (LLM).

Noch laufen die Systeme größtenteils auf Beschleuniger der A100-Serie – zumindest alles, was GPT-4 bei OpenAI, bzw. Microsoft umfasst. Aber die noch einmal leistungsstärkeren H100-Beschleuniger kommen zunehmend zum Einsatz und werden in den kommenden Wochen und Monaten in den entsprechenden Cloud-Instanzen verfügbar sein, bzw. sind es in einem gewissen Umfang bereits.

Die immer höheren Anforderungen in diesem Bereich nimmt NVIDIA zum Anlass, eine weitere GH100-Variante auf den Markt zu bringen: H100 NVL. Diese ist eine Art Zwitter aus der SXM5- und PCI-Express-Variante des H100-Beschleunigers. Während NVIDIA auf der PCI-Express-Karte eine kleinere Ausbaustufe der GH100-GPU zum Einsatz brauchte, waren es in der SXM5-Variante nicht die vollen 18.432 FP32-Recheneinheiten und auch nicht die vollen 96 GB an HBM3, die es hätten theoretisch sein können. Aber auch schon bei der GA100-GPU konnte NVIDIA nur fünf der sechs HBM2-Chips verwenden, was mit der Ausbeute des Chips und damit des gesamten Packages zusammenhängt

Mit der H100 NVL ändert sich daran nur teilweise etwas. Während die GPU weiterhin in der gleichen Ausbaustufe wie in der SXM5-Variante zum Einsatz kommt, kann NVIDIA nun endlich alle sechs HBM3-Speicherchips verwenden und kommt somit auf eine höhere Speicherbandbreite. Allerdings sind es nur 94 anstatt der erwarteten 96 GB, was NVIDIA mit "optimizations in manufacturing" begründet. Was sich genau dahinter verbirgt, ist nicht bekannt. Wir vermuten, dass NVIDIA keinen Snoop-Filter in Funktion bringen konnte, der alle 96 GB des Adressbereichs verarbeiten kann.

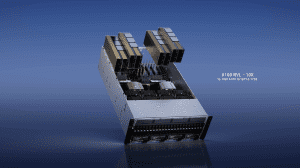

Die H100 NVL besteht aus zwei PCBs, auf der sich jeweils ein Package mit jeweils einer GH100-GPU befindet. Die Karte wird per PCI-Express 5.0 an das Host-System angebunden. OEMs und SIs haben die Möglichkeit, bis zu vier dieser Dual-Karten in ihren Servern einzusetzen. Untereinander verbunden sind die GPUs per NVLink mit bis zu 600 GB/s.

| GH100 (Vollausbau) | H100 NVL | H100 SXM5 | H100 PCIe | |

| GPCs | 8 | 2x 8 | 8 | 7 oder 8 |

| TPCs | 72 | 2x 66 | 66 | 57 |

| SMs | 144 | 2x 132 | 132 | 114 |

| FP32-Einheiten | 18.432 | 2x 16.896 | 16.896 | 14.592 |

| L2-Cache | 60 MB | 2x 50 MB | 50 MB | 50 MB |

| Tensor Cores | 576 | 2x 528 | 528 | 456 |

| Speicher | 96 GB HBM3/HBM2E | 2x 94 GB HBM3 | 80 GB HBM3 | 80 GB HBM2E |

| Bandbreite | - | 2x 3,94 TB/s | 3,35 TB/s | 2 TB/s |

| Interconnect | - | NVLink 600 GB/s | NVLink 900 GB/s | NVLink 600 GB/s |

| Schnittstelle | - | PCIe 5.0 x16 | PCIe 5.0 x16 | PCIe 5.0 x16 |

| TDP | - | 2x bis zu 400 W | bis zu 700 W | bis zu 350 W |

Die Rechenleistung entspricht der zweier H100 in der SXM5-Variante. Der größere Speicherausbau dürfte in den AI-Anwendungsfeldern nützlich sein. Über Preise macht NVIDIA keine Angaben. Die H100-Variante mit PCI-Express-Interface ist im Handel noch nicht zu finden. Der A100-Vorgänger kostet fast 17.000 Euro. Die H100 NVL soll erst in der zweiten Jahreshälfte verfügbar sein.

In den nächsten Quartalsberichten dürfte sich der AI-Boom bei NVIDIA bemerkbar machen. Eine Schwäche bei den GeForce-GPUs dürfte sich damit also mehr als ausreichend kompensieren lassen.