News und Artikel durchsuchen

{{#data.error.root_cause}}

{{/data.error}}

{{^data.error}}

{{#texts.summary}}

[{{{type}}}] {{{reason}}}

{{/data.error.root_cause}}{{texts.summary}} {{#options.result.rssIcon}} RSS {{/options.result.rssIcon}}

{{/texts.summary}} {{#data.hits.hits}}

{{#_source.featured}}

FEATURED

{{/_source.featured}}

{{#_source.showImage}}

{{#_source.image}}

{{/_source.image}}

{{/_source.showImage}}

{{/data.hits.hits}}

{{{_source.title}}} {{#_source.showPrice}} {{{_source.displayPrice}}} {{/_source.showPrice}}

{{#_source.showLink}} {{/_source.showLink}} {{#_source.showDate}}{{{_source.displayDate}}}

{{/_source.showDate}}{{{_source.description}}}

{{#_source.additionalInfo}}{{#_source.additionalFields}} {{#title}} {{{label}}}: {{{title}}} {{/title}} {{/_source.additionalFields}}

{{/_source.additionalInfo}}

Hopper

-

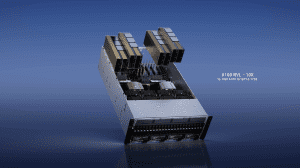

Neue KI-Hardware: NVIDIA kündigt H200 NVL und GB200 NVL4 an

Zur Supercomputing-Konferenz präsentiert NVIDIA zunächst einmal neue NIM-Microservices, die im wissenschaftlichen Umfeld bei Berechnung komplexer Zusammenhänge zum Einsatz kommen sollen. Mit Omniverse Blueprint kombiniert werden verschiedene Microservices in Form eines Foundation Model, Trainings-Netzwerk sowie digitaler Stellvertreter, die dann zusammen mit 3D-Modellen komplexe Simulationen durchführen können. Für die Omniverse Blueprints... [mehr]

Zur Supercomputing-Konferenz präsentiert NVIDIA zunächst einmal neue NIM-Microservices, die im wissenschaftlichen Umfeld bei Berechnung komplexer Zusammenhänge zum Einsatz kommen sollen. Mit Omniverse Blueprint kombiniert werden verschiedene Microservices in Form eines Foundation Model, Trainings-Netzwerk sowie digitaler Stellvertreter, die dann zusammen mit 3D-Modellen komplexe Simulationen durchführen können. Für die Omniverse Blueprints... [mehr] -

Inflection AI: Startup baut Supercomputer mit 22.000 H100-GPUs

Ob Meta, Google, Microsoft oder anderen Cloud-Anbieter – NVIDIA wird sich vor Nachfrage nach den H100-Beschleunigern wohl kaum retten können. In welchen Mengen die Hardware hier an den Mann gebraucht wird, zeigt sich deutlich in einer Ankündigung eines engen Partners von NVIDIA: Dem AI-Startup Inflection AI, welches inzwischen mit 1,5 Milliarden US-Dollar bewertet wird und in das Personen wie Bill Gates und Eric Schmidt sowie eben NVIDIA... [mehr]

Ob Meta, Google, Microsoft oder anderen Cloud-Anbieter – NVIDIA wird sich vor Nachfrage nach den H100-Beschleunigern wohl kaum retten können. In welchen Mengen die Hardware hier an den Mann gebraucht wird, zeigt sich deutlich in einer Ankündigung eines engen Partners von NVIDIA: Dem AI-Startup Inflection AI, welches inzwischen mit 1,5 Milliarden US-Dollar bewertet wird und in das Personen wie Bill Gates und Eric Schmidt sowie eben NVIDIA... [mehr] -

Wenig überraschend: TDP von Datacenter-CPUs und GPUs werden steigen

Eine geleakte Präsentation der Server-Sparte von Gigabyte führt die Leistungsaufnahme einiger Server-Komponenten auf und geben einen Ausblick darauf, was uns in den kommenden Jahren in diesem Bereich erwarten wird. Größtenteils sind die Daten aber bereits zu erwarten gewesen – auch weil die Hersteller dies bereits so angekündigt hatten. Veröffentlicht wurde die Folie von Twitterer @9550pro. Sie zeigt eine Übersicht der Prozessoren, PCIe-, SXM-... [mehr]

Eine geleakte Präsentation der Server-Sparte von Gigabyte führt die Leistungsaufnahme einiger Server-Komponenten auf und geben einen Ausblick darauf, was uns in den kommenden Jahren in diesem Bereich erwarten wird. Größtenteils sind die Daten aber bereits zu erwarten gewesen – auch weil die Hersteller dies bereits so angekündigt hatten. Veröffentlicht wurde die Folie von Twitterer @9550pro. Sie zeigt eine Übersicht der Prozessoren, PCIe-, SXM-... [mehr] -

H100 NVL: Weitere Hopper-GPU mit mehr HBM3-Speicher

Der aktuelle AI-Trend rund um GPT-4 dürfte vor allem die Unternehmen freuen, die Hard- oder Software dazu anbieten. NVIDIA ist einer der Hardwarehersteller hinter den Systemen des Large Language Modells (LLM). Noch laufen die Systeme größtenteils auf Beschleuniger der A100-Serie – zumindest alles, was GPT-4 bei OpenAI, bzw. Microsoft umfasst. Aber die noch einmal leistungsstärkeren H100-Beschleuniger kommen zunehmend zum Einsatz und... [mehr]

Der aktuelle AI-Trend rund um GPT-4 dürfte vor allem die Unternehmen freuen, die Hard- oder Software dazu anbieten. NVIDIA ist einer der Hardwarehersteller hinter den Systemen des Large Language Modells (LLM). Noch laufen die Systeme größtenteils auf Beschleuniger der A100-Serie – zumindest alles, was GPT-4 bei OpenAI, bzw. Microsoft umfasst. Aber die noch einmal leistungsstärkeren H100-Beschleuniger kommen zunehmend zum Einsatz und... [mehr] -

NVIDIA stellt Drive Thor und IGX für Medizin-Anwendungen vor

NVIDIA hat auf der Herbst-GTC eine Reihe an Neuerungen vorgestellt. Zunächst einmal wurde man nicht müde zu betonen, dass die ersten Hopper-Beschleuniger alias H100 noch im Oktober ausgeliefert werden sollen. Dabei handelt es sich um die PCI-Express-Varianten, währen die SXM4-Modelle noch etwas auf sich warten lassen. In der vergangenen Woche stellte NVIDIA im Rahmen der MLPerf-Zahlen erstmals unabhängige Benchmark-Ergebnisse zum... [mehr]

NVIDIA hat auf der Herbst-GTC eine Reihe an Neuerungen vorgestellt. Zunächst einmal wurde man nicht müde zu betonen, dass die ersten Hopper-Beschleuniger alias H100 noch im Oktober ausgeliefert werden sollen. Dabei handelt es sich um die PCI-Express-Varianten, währen die SXM4-Modelle noch etwas auf sich warten lassen. In der vergangenen Woche stellte NVIDIA im Rahmen der MLPerf-Zahlen erstmals unabhängige Benchmark-Ergebnisse zum... [mehr] -

AMD und NVIDIA dürfen GPU-Beschleuniger nicht mehr nach China exportieren

Von der US-Regierung sind neue Einschränkungen für den Handel mit China erlassen worden – dies berichtet Reuters unter Berufung auf Unternehmenskreise bei NVIDIA. Da die Export-Beschränkungen allerdings eine ganze Produktgruppe betreffen, ist von auszugehen, dass auch andere Hersteller ihre Produkte nicht mehr nach China exportieren dürfen. Dies beträfe dann sogar AMD und Intel. Betroffen seien aber nicht sämtliche GPU-Beschleuniger,... [mehr]

Von der US-Regierung sind neue Einschränkungen für den Handel mit China erlassen worden – dies berichtet Reuters unter Berufung auf Unternehmenskreise bei NVIDIA. Da die Export-Beschränkungen allerdings eine ganze Produktgruppe betreffen, ist von auszugehen, dass auch andere Hersteller ihre Produkte nicht mehr nach China exportieren dürfen. Dies beträfe dann sogar AMD und Intel. Betroffen seien aber nicht sämtliche GPU-Beschleuniger,... [mehr] -

Neue Tensor Cores, FP8 und mehr Takt: NVIDIAs Verbesserungen der GH100-GPU

Zur GPU Technology Conference im Frühjahr stellte NVIDIA die GH100-GPU auf Basis der Hopper-Architektur, bzw. den H100-Beschleuniger vor. Zur Hotchips 34 sprach NVIDIA über die Herausforderungen eines solches Designs und wie eine GPU mit 16.896 FP32-Recheneinheiten, 528 Tensor Cores, 50 MB an L2-Cache und 80 GB an HBM3 auszulasten ist – ganz zu schweigen davon, mehrere hundert oder gar tausend GPUs zusammenarbeiten zu lassen. Die... [mehr]

Zur GPU Technology Conference im Frühjahr stellte NVIDIA die GH100-GPU auf Basis der Hopper-Architektur, bzw. den H100-Beschleuniger vor. Zur Hotchips 34 sprach NVIDIA über die Herausforderungen eines solches Designs und wie eine GPU mit 16.896 FP32-Recheneinheiten, 528 Tensor Cores, 50 MB an L2-Cache und 80 GB an HBM3 auszulasten ist – ganz zu schweigen davon, mehrere hundert oder gar tausend GPUs zusammenarbeiten zu lassen. Die... [mehr] -

H100-GPU: NVIDIA spart Zeit und Platz durch AI-gestütztes Chip-Design

Mit inzwischen weit über 50 Milliarden Transistoren auf einer Fläche von 800+ mm² haben moderne Chips eine Komplexität erreicht, die sich in vielen Phasen der Entwicklung und des Designs durch den Menschen nicht mehr erfassen lässt. EDA-Werkzeuge (Electronic Design Automation) sind die Hilfsmittel der Wahl, die den Prozess eines Designs in die Fertigung überführen sollen. Ziel ist es dabei natürlich die Schaltkreise auf möglichst... [mehr]

Mit inzwischen weit über 50 Milliarden Transistoren auf einer Fläche von 800+ mm² haben moderne Chips eine Komplexität erreicht, die sich in vielen Phasen der Entwicklung und des Designs durch den Menschen nicht mehr erfassen lässt. EDA-Werkzeuge (Electronic Design Automation) sind die Hilfsmittel der Wahl, die den Prozess eines Designs in die Fertigung überführen sollen. Ziel ist es dabei natürlich die Schaltkreise auf möglichst... [mehr] -

SK hynix liefert ersten HBM3 an NVIDIA

Bereits bekannt ist, dass NVIDIA für seinen H100-Beschleuniger auf Basis der Hopper-Architektur HBM3-Speicher verwenden will. Nun hat SK hynix bestätigt, dass der Speicher vom südkoreanischen Hersteller stammen wird und dass man gemeinsam mit NVIDIA die Validierung abgeschlossen habe. Ab dem dritten Quartal 2022 sollen die ersten H100-Beschleuniger ausgeliefert werden. Dies deckt sich mit den Ankündigungen von NVIDIA. "NVIDIA has recently... [mehr]

Bereits bekannt ist, dass NVIDIA für seinen H100-Beschleuniger auf Basis der Hopper-Architektur HBM3-Speicher verwenden will. Nun hat SK hynix bestätigt, dass der Speicher vom südkoreanischen Hersteller stammen wird und dass man gemeinsam mit NVIDIA die Validierung abgeschlossen habe. Ab dem dritten Quartal 2022 sollen die ersten H100-Beschleuniger ausgeliefert werden. Dies deckt sich mit den Ankündigungen von NVIDIA. "NVIDIA has recently... [mehr] -

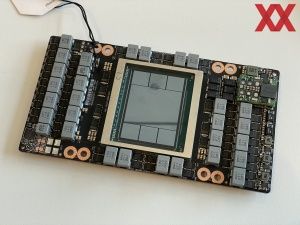

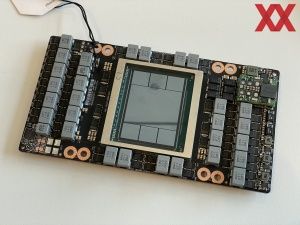

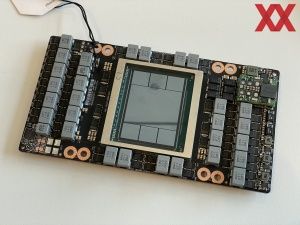

GH100 abgelichtet: NVIDIAs Hopper-Chip zeigt sich erstmals vor der Kamera

Auf der GPU Technologies Conference 2022 Mitte März präsentierte NVIDIA die ersten Details zur Hopper-Architektur und dem dazugehörigen GPU-Beschleuniger H100. Patrick Kennedy von ServeTheHome hatte bereits die Gelegenheit, sich das dazugehörige SMX4-Modul genauer anzuschauen. Die GH100-GPU kommt in 4 nm gefertigt auf Abmessungen von 814 mm². Von den sechs sichtbaren HBM3-Chips sind nur fünf aktiv und ermöglichen einen... [mehr]

Auf der GPU Technologies Conference 2022 Mitte März präsentierte NVIDIA die ersten Details zur Hopper-Architektur und dem dazugehörigen GPU-Beschleuniger H100. Patrick Kennedy von ServeTheHome hatte bereits die Gelegenheit, sich das dazugehörige SMX4-Modul genauer anzuschauen. Die GH100-GPU kommt in 4 nm gefertigt auf Abmessungen von 814 mm². Von den sechs sichtbaren HBM3-Chips sind nur fünf aktiv und ermöglichen einen... [mehr]