Werbung

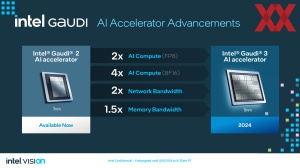

Zuletzt präsentierte sich Intel mit seinem Gaudi-2-Beschleuniger als preisliche und vor allem verfügbare Alternative zu NVIDIAs allgegenwärtigen KI-Beschleunigern. Geht es jedoch um die Rohleistung, so dürfte kaum ein Weg an NVIDIA vorbeiführen und am schnellen Markt der KI-Beschleuniger wirkt Intels Lösung schon recht überholt – ohne dabei überhaupt auf AMDs Instinct MI300X/A einzugehen, die sich hinsichtlich ihrer Leistung zwischen NVIDIA und Intel positionieren dürften, aber zu denen es kaum belastbare Zahlen gibt und deren installiertes Volumen noch recht klein zu sein scheint.

Doch nun will Intel den Angriff wagen: Auf der Vision 2024 wurde nun der Gaudi-3-Beschleuniger vorgestellt, der auch aus technischer Sicht zu NVIDIA aufholen und letztendlich mehr als nur die zweitbeste Lösung sein soll.

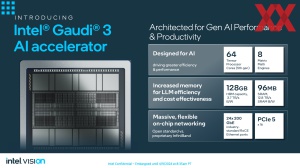

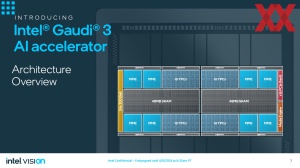

Hinsichtlich der Architektur sind sich Gaudi 2 und Gaudi 3 sehr ähnlich. Der Aufbau des Package ist dem der Blackwell-GPU von NVIDIA nicht genau unähnlich. Intel packt zwei Compute-Dies zusammen. Gefertigt werden diese in 5 nm bei TSMC.

Der recht ähnliche Aufbau wird deutlich, wenn man sich die Details genauer anschaut. Gaudi 2 setzt auf 24 Tensor Processor Cores (TPC). Gaudi 3 setzt auf 2x 32 der TPCs, die auf einer VLIW-Architektur (Very Long Instruction Word) basieren. Es handelt sich dabei um SIMD (Single Instruction Multiple Data) Vektoreinheiten, die 2.048-Bit-Operationen mit verschiedensten Datentypen unterstützen. An dieser grundsätzlichen Architektur ändert sich also bis auf die Anzahl der TPCs nichts.

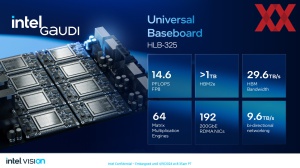

Pro Chip setzt Gaudi 3 auf 48 MB an SRAM. Der KI-Beschleuniger kommt insgesamt auf 96 MB, bei Gaudi 2 waren es als Single-Chip-Lösung 48 MB. Die 96 MB an SRAM kommen auf eine Bandbreite von 12,8 TB/s. Relativ wenig Fortschritt gibt es beim Speicher und dessen Ausbau. War dieser bei Gaudi 2 96 GB groß und kam auf 2,45 TB/s, sind es bei Gaudi 3 nun 128 GB und 3,7 TB/s. Es kommt weiterhin HBM2E zum Einsatz. Für HBM3 war es in der Entwicklung des Gaudi-3-Beschleunigers offenbar zu spät.

Für einen KI-Beschleuniger und das Training sowie Inferencing wichtig ist außerdem die Anbindung der Chips an weitere, die in einem Cluster zusammenarbeiten. An dieser Stelle setzt Gaudi 3 auf PCI-Express 5.0 und 16 Lanes. Aber auch eine schnelle Ethernet-Verbindung spielt beim Gaudi-Beschleuniger eine wichtige Rolle. Anstatt 24x 100 GbE wie bei Gaudi 2 verdoppelt Intel die zur Verfügung stehende Bandbreite auf 24x 200 GbE.

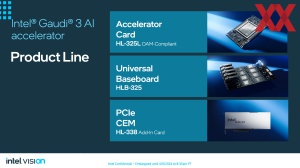

Verschiedene Bauformen

Intel wird den Gaudi-3-Beschleuniger in drei Varianten auf den Markt bringen: Als OAM-Card (HL-325L) kommt Gaudi 3 auf eine Leistung von 1.835 TFLOPS (FP8). Die TDP wird mit 900 W angegeben, wenn eine Luftkühlung zum Einsatz kommt. Mit einer Wasserkühlung soll sich der Beschleuniger noch mehr genehmigen dürfen.

Ein Beschleuniger wird jedoch selten alleine verwendet werden. Daher wird Intel ein Baseboard (HLB-325) anbieten, auf dem acht Gaudi 3 sitzen. Diese sind direkt über das PCB miteinander verbunden. Dazu werden die NICs des Beschleunigers verwendet. 21 oder 24 NICs kommen für die direkte Verbindung zum Einsatz. Drei werden für die Verbindung mehrere Baseboards verwendet.

Etwas später soll zudem eine dritte Umsetzung erscheinen: Die PCIe-Karte (HL-338). Hier gibt Intel ebenfalls eine Peak-Rechenleistung von 1.835 TFLOPS (FP8) an. Allerdings wird diese aufgrund der TDP von 600 W nicht dauerhaft zur Verfügung stehen. Vier Gaudi-3-PCI-Express-Karten können über ein Top-Board miteinander verbunden werden. Die Karte selbst bietet noch zwei Netzwerkanschlüsse auf der Karte selbst.

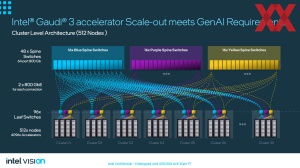

Skalierung auf über 8.000 Gaudi 3

Ein wichtiger Faktor in der Umsetzung der Gaudi-Serie und demnach auch von Gaudi 3, ist die schnelle Anbindung über die GbE-Verbindungen. Intel hat sich hier bewusst für einen offenen Standard entschieden. NVIDIA setzt für Nodes und Cluster auf NVLink, darüber hinaus geht es über InfiniBand, wenngleich Rack-übergreifend ebenfalls Ethernet zum Einsatz kommen kann.

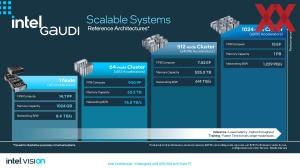

Intel sieht eine Skalierung für einen Node mit acht Beschleunigern vor. Diese können wiederum in ein Node-Cluster mit 64 Nodes und dementsprechend 512 Beschleuniger zusammengefasst werden.

Auch möglich ist der Aufbau eines Clusters mit 512 Nodes, was dann 4.096 Beschleuniger bedeuten würde, die zusammenarbeiten. Für den theoretisch höchsten Ausbau sieht Intel 1.024 Nodes mit 8.192 Beschleunigern vor. Ein solches Cluster wäre sogar noch vergleichsweise klein. NVIDIA ermöglicht einen deutlich größeren Ausbau und so sind zwei AI-Cluster von Meta bereits auf 24.576 H100-Beschleuniger angewachsen.

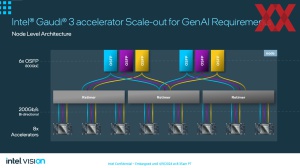

Wie bereits erwähnt, stellt jeder Gaudi-3-Beschleuniger bis zu 24 GbE-Verbindungen zur Verfügung. Auf Node-Level werden 21 NICs für die direkten Verbindungen der Beschleuniger untereinander verwendet. Jeweils drei gehen von jedem der acht Beschleuniger über Retimer und werden zu sechs OSPF-Anschlüssen gebündelt, die dann jeweils 800 GBit/s bereitstellen können.

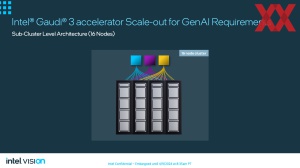

Geht man dann auf Eben des Sub-Clusters werden 16 Nodes mit jeweils acht Beschleunigern zusammenfasst. Jeder Node über 6x 800GbE, wobei immer zwei Verbindungen zu einem der drei Leaf-Switches geführt werden.

Geht man dann auf die nächsthöhere Ebene mit 32 Cluster, 512 Nodes und 4.096 Gaudi-3-Beschleunigern, kommen insgesamt 96 Leaf-Switches zum Einsatz, die wiederum untereinander über 3x 16 Spine-Switches miteinander verbunden sind. Diese Spine-Switches verfügen über jeweils 64 Ports für 800GbE. Für ein Cluster mit 512 Nodes kommen also insgesamt noch einmal 144 Switches mit 800GbE-Ports zum Einsatz, was die Komplexität eines solchen Clusters hinsichtlich der Netzwerk-Infrastruktur verdeutlicht.

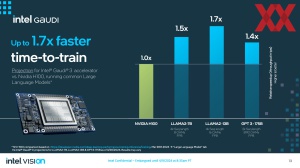

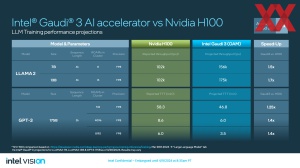

Leistungsvergleich mit NVIDIA

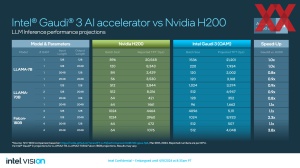

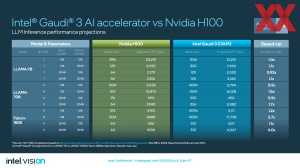

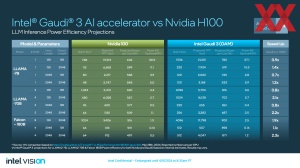

Auf Basis eigener Projektionen wagt Intel einen Vergleich zu NVIDIAs H100- und H200-Beschleuniger. Aktuell befindet sich Gaudi 3 in der Validierungsphase. Echte Chips sind in den Laboren und werden getestet, allerdings hat man noch keine finale Hardware, die auf einem Stand ist, wie später die Auslieferung geplant ist. Also macht man Projektionen und gibt somit eine Vorschau auf die erwartete Leistung.

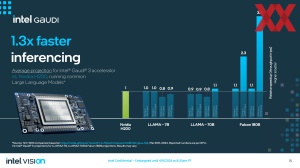

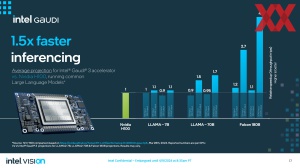

Im Rahmen dieser Projektionen zeigt man sicher sehr zuversichtlich, dass man es mit NVIDIA wird aufnehmen können. Für das Training von LLMs sieht man sich um 40 bis 70 % schneller. Beim Inferencing kommt es genau wie beim Training auf das jeweilige Modell an. Für Llama mit 7 und 70 Milliarden Parametern liegt das Leistungsplus Mal bei -10 % und Mal bei +70 %. Größere Modelle wie Falcon mit 180 Milliarden Parametern soll ein Node mit acht Gaudi-3-Beschleunigern sogar um den Faktor Vier schneller im Inferencing ausführen können.

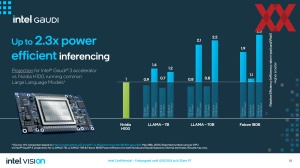

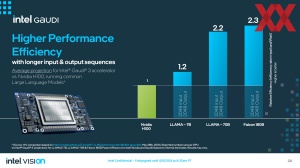

Bei der Effizienz sieht man sich ebenfalls besser aufgestellt. Auf die Leistung von acht H100-Beschleunigern normiert, geht Intel aktuell davon aus, dass Gaudi 3 eine um den Faktor 1,2 bis 2,3 höhere Effizienz (Tokens pro Sekunde pro Karte pro Watt) liefern kann. Auch hier gibt es wieder gewisse Abhängigkeiten mit dem jeweils verwendeten Modell.

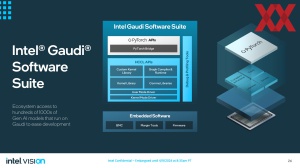

Die Software ebnet den Weg

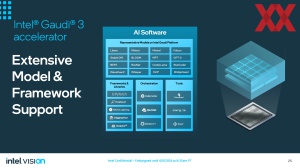

Wie wichtig die Software ist, dürfte hinlänglich bekannt sein. Für seinen Gaudi-2-Beschleuniger verbesserte Intel die Software über die vergangenen Monate immer wieder, ermöglichte neue Datenformate und optimierte den kompletten Software-Stack.

Innerhalb seiner Software sieht Intel die Unterstützung der wichtigsten Frameworks wie PyTorch, DeepSpeed, Huggingface und Mosaic vor. Hinzu kommen repräsentative KI-Modelle wie Llama, Mistral, GPT, Falcon und mehr, auf die Intel seine Software entsprechend optimiert hat.

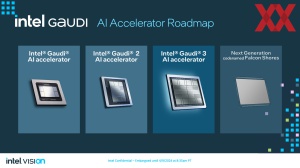

Der Gaudi-3-Beschleuniger bildet als Hardware die Brücke zu Falcon Shores. Ursprünglich sollte Falcon Shores CPU-Kerne und eine GPU einsetzen. Nach einer Umstellung der Zielvorgabe in der Entwicklung von Falcon Shores im Frühjahr 2023 machte Intel allerdings deutlich, dass Falcon Shores zunächst eine reine GPU werden wird.

Für Entwickler soll der Wechsel von Gaudi 3 auf Falcon Shores ohne eine größere Umstellung erfolgen. Auch dazu verwendet Intel seinen Software-Stack und passt diesen entsprechend an.

Man will mehr als nur eine Alternative sein

In der schnelllebigen Welt der KI-Beschleuniger konnte Intel hinsichtlich der Hardware zuletzt nicht mehr Schritthalten. Der Gaudi-2-Beschleuniger wurde bereits 2019 vorgestellt und ist seit 2020 auf den Markt. Dank zahlreicher Software-Optimierungen der verwendeten Datentypen konnte Gaudi 2 zumindest über die Verfügbarkeit und den Preis noch mithalten. Aber sicherlich hat man bei Intel den Anspruch mehr als nur eine Alternative zu NVIDIA zu sein.

Aktuell unklar ist, wie gut AMD mit den Instinct MI300A/X aufgestellt ist. Mit Gaudi 3 hat sich Intel zum Ziel gesetzt, mindestens auf Augenhöhe mit NVIDIA zu liegen, ja sogar besser will man sein. Die gezeigten Benchmarks auf Basis eigener Projektionen sollen diesen bereits belegen. Es handelt sich eben um Projektionen, die ziemlich akkurat sein können, aber es sind eben auch nur Projektionen.

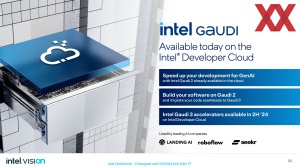

Ab der ersten Jahreshälfte 2024 will Intel die ersten Samples an die Partner liefern. Demnach müsste es in den kommenden Wochen soweit sein. Für die zweite Jahreshälfte werden dann größere Volumina erwartet, so dass man den Partnern auch große Stückzahlen liefern kann. Dies gilt allerdings zunächst einmal nur für die OAM-Variante sowie das Baseboard mit gleich acht Beschleunigern. Die PCIe-Variante wird erst später in diesem Jahr folgen.

Ob man dann tatsächlich mit NVIDIA auf Augenhöhe ist, werden die ersten echten Tests und unabhängigen Benchmarks zeigen müssen.