{{#data.error.root_cause}}

{{/data.error}}

{{^data.error}}

{{#texts.summary}}

[{{{type}}}] {{{reason}}}

{{/data.error.root_cause}}{{texts.summary}} {{#options.result.rssIcon}} RSS {{/options.result.rssIcon}}

{{/texts.summary}} {{#data.hits.hits}}

{{#_source.featured}}

FEATURED

{{/_source.featured}}

{{#_source.showImage}}

{{#_source.image}}

{{/_source.image}}

{{/_source.showImage}}

{{/data.hits.hits}}

{{{_source.title}}} {{#_source.showPrice}} {{{_source.displayPrice}}} {{/_source.showPrice}}

{{#_source.showLink}} {{/_source.showLink}} {{#_source.showDate}}{{{_source.displayDate}}}

{{/_source.showDate}}{{{_source.description}}}

{{#_source.additionalInfo}}{{#_source.additionalFields}} {{#title}} {{{label}}}: {{{title}}} {{/title}} {{/_source.additionalFields}}

{{/_source.additionalInfo}}

H200

-

Neue KI-Hardware: NVIDIA kündigt H200 NVL und GB200 NVL4 an

Zur Supercomputing-Konferenz präsentiert NVIDIA zunächst einmal neue NIM-Microservices, die im wissenschaftlichen Umfeld bei Berechnung komplexer Zusammenhänge zum Einsatz kommen sollen. Mit Omniverse Blueprint kombiniert werden verschiedene Microservices in Form eines Foundation Model, Trainings-Netzwerk sowie digitaler Stellvertreter, die dann zusammen mit 3D-Modellen komplexe Simulationen durchführen können. Für die Omniverse Blueprints... [mehr]

Zur Supercomputing-Konferenz präsentiert NVIDIA zunächst einmal neue NIM-Microservices, die im wissenschaftlichen Umfeld bei Berechnung komplexer Zusammenhänge zum Einsatz kommen sollen. Mit Omniverse Blueprint kombiniert werden verschiedene Microservices in Form eines Foundation Model, Trainings-Netzwerk sowie digitaler Stellvertreter, die dann zusammen mit 3D-Modellen komplexe Simulationen durchführen können. Für die Omniverse Blueprints... [mehr] -

Einblicke in Colossus KI-Supercomputer: NVIDIA und xAI loben gegenseitig Zusammenarbeit

Diese Sommer stellte xAI den aktuell wohl größten KI-Supercomputer namens Colossus fertig. Mit 100.000 H100-Beschleunigern bestückt stellt eine solche Installation gigantische Voraussetzungen an alle beteiligten Infrastruktur-Komponenten – über die Stromversorgung im Bereich von 155 MW, die Kühlung und auch im Hinblick auf die Netzwerk-Infrastruktur. Aktuell arbeitet xAI sogar schon an einem Ausbau. Doppelt so viele, satte 200.000 Beschleuniger... [mehr]

Diese Sommer stellte xAI den aktuell wohl größten KI-Supercomputer namens Colossus fertig. Mit 100.000 H100-Beschleunigern bestückt stellt eine solche Installation gigantische Voraussetzungen an alle beteiligten Infrastruktur-Komponenten – über die Stromversorgung im Bereich von 155 MW, die Kühlung und auch im Hinblick auf die Netzwerk-Infrastruktur. Aktuell arbeitet xAI sogar schon an einem Ausbau. Doppelt so viele, satte 200.000 Beschleuniger... [mehr] -

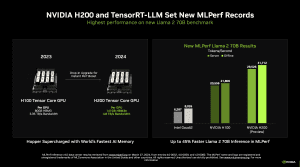

MLPerf Training v4.0: H200 und TPUv5p im Benchmark und Messung der Leistungsaufnahme

Die aktuellste Runde der MLPerf-Ergebnisse gibt Einblicke in die Leistung moderner Datacenter-Hardware im Hinblick auf die Trainings-Leistung. Häufig sind wir hier von den Daten abhängig, die uns AMD, NVIDIA, Intel und andere präsentieren. Eine Verifikation dieser Leistungswerte durch Dritte ist aber nur schwer möglich. Bereits zum Start sei allerdings gesagt, dass AMD auch an dieser Runde nicht offiziell teilgenommen hat und somit die... [mehr]

Die aktuellste Runde der MLPerf-Ergebnisse gibt Einblicke in die Leistung moderner Datacenter-Hardware im Hinblick auf die Trainings-Leistung. Häufig sind wir hier von den Daten abhängig, die uns AMD, NVIDIA, Intel und andere präsentieren. Eine Verifikation dieser Leistungswerte durch Dritte ist aber nur schwer möglich. Bereits zum Start sei allerdings gesagt, dass AMD auch an dieser Runde nicht offiziell teilgenommen hat und somit die... [mehr] -

NVIDIA: Keynote zur Computex und erstes H200-System geht an OpenAI

Bereits bekannt ist, dass AMD und Intel auf der Computex eine Keynote halten werden. Einer der großen Player fehlte bisher: NVIDIA. Nun aber verkündet der GPU-Hersteller, dass man bereits am Sonntag den 2. Juni, also vor AMD (Montag, 3. Juni) und Intel (Dienstag, 4. Juni) eine Keynote halten wird. Stattfinden wird das ganze im NTU Sports Center (National Taiwan University Sports Center) und vermutlich somit auch außerhalb des... [mehr]

Bereits bekannt ist, dass AMD und Intel auf der Computex eine Keynote halten werden. Einer der großen Player fehlte bisher: NVIDIA. Nun aber verkündet der GPU-Hersteller, dass man bereits am Sonntag den 2. Juni, also vor AMD (Montag, 3. Juni) und Intel (Dienstag, 4. Juni) eine Keynote halten wird. Stattfinden wird das ganze im NTU Sports Center (National Taiwan University Sports Center) und vermutlich somit auch außerhalb des... [mehr] -

Intel Vision 2024: Gaudi 3 soll NVIDIAs H100 und H200 starke Konkurrenz machen

Zuletzt präsentierte sich Intel mit seinem Gaudi-2-Beschleuniger als preisliche und vor allem verfügbare Alternative zu NVIDIAs allgegenwärtigen KI-Beschleunigern. Geht es jedoch um die Rohleistung, so dürfte kaum ein Weg an NVIDIA vorbeiführen und am schnellen Markt der KI-Beschleuniger wirkt Intels Lösung schon recht überholt – ohne dabei überhaupt auf AMDs Instinct MI300X/A einzugehen, die sich hinsichtlich ihrer Leistung zwischen NVIDIA und... [mehr]

Zuletzt präsentierte sich Intel mit seinem Gaudi-2-Beschleuniger als preisliche und vor allem verfügbare Alternative zu NVIDIAs allgegenwärtigen KI-Beschleunigern. Geht es jedoch um die Rohleistung, so dürfte kaum ein Weg an NVIDIA vorbeiführen und am schnellen Markt der KI-Beschleuniger wirkt Intels Lösung schon recht überholt – ohne dabei überhaupt auf AMDs Instinct MI300X/A einzugehen, die sich hinsichtlich ihrer Leistung zwischen NVIDIA und... [mehr] -

MLPerf Inference 4.0: Das Debüt der H200 von NVIDIA gelingt

Die MLCommons, ein Konsortium verschiedener Hersteller, welches es zum Ziel hat, möglichst unabhängige und vergleichbare Benchmarks zu Datacenter-Hardware anzubieten, hat die Ergebnisse der Inference-Runde 4.0 veröffentlicht. Darin ihr Debüt feiert der H200-Beschleuniger von NVIDIA, der zwar ebenfalls auf der Hopper-Architektur und der gleichen Ausbaustufe wie der H200-Beschleuniger von NVIDIA basiert, der aber anstatt 80 GB an HBM2 auf 141 GB... [mehr]

Die MLCommons, ein Konsortium verschiedener Hersteller, welches es zum Ziel hat, möglichst unabhängige und vergleichbare Benchmarks zu Datacenter-Hardware anzubieten, hat die Ergebnisse der Inference-Runde 4.0 veröffentlicht. Darin ihr Debüt feiert der H200-Beschleuniger von NVIDIA, der zwar ebenfalls auf der Hopper-Architektur und der gleichen Ausbaustufe wie der H200-Beschleuniger von NVIDIA basiert, der aber anstatt 80 GB an HBM2 auf 141 GB... [mehr] -

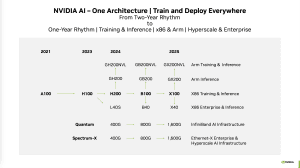

Dell zu NVIDIAs KI-Beschleunigern: B200 und bis zu 1.000 W pro Chip

Im Rahmen der Bekanntgabe der Quartalszahlen (PDF) hat Dells Chief Operating Officer Jeff Clarke einige interessante Aussagen zu zukünftigen KI-Beschleunigern von NVIDIA gemacht. Diese passen ganz gut in das, was NVIDIA höchstselbst Mitte Oktober veröffentlicht hat. Die Kadenz zwischen den einzelnen Beschleuniger-Generationen wird sich erhöhen, teilweise sprechen wir nicht von komplett neuen Chips, sondern beispielsweise von einem Update auf... [mehr]

Im Rahmen der Bekanntgabe der Quartalszahlen (PDF) hat Dells Chief Operating Officer Jeff Clarke einige interessante Aussagen zu zukünftigen KI-Beschleunigern von NVIDIA gemacht. Diese passen ganz gut in das, was NVIDIA höchstselbst Mitte Oktober veröffentlicht hat. Die Kadenz zwischen den einzelnen Beschleuniger-Generationen wird sich erhöhen, teilweise sprechen wir nicht von komplett neuen Chips, sondern beispielsweise von einem Update auf... [mehr]