Werbung

Intels Marketingabteilung hat in einem Blogbeitrag die Leistung seiner eigenen High-End-Xeon-Prozessoren gegen die Modelle von AMD verglichen. Hintergrund ist die Frage nach der Notwendigkeit nach immer mehr Kernen. AMDs aktuelle EPYC-Prozessoren bieten bis zu 64 Kerne, in einem 2S-System sind damit 128 Kerne und 256 Threads möglich. Intel stellt in Frage, dass eine Vielzahl Kernen immer ein Vorteil ist und will dies mit eigenen Zahlen belegen.

Stattdessen sollen laut Intel weitere Faktoren mit in die Betrachtung mit einbezogen werden. Dies wären die Leistung der einzelnen Kerne, die eventuell vorhandene Optimierung der Software auf eine bestimmte Hardware, die Speicherbandbreite und die Möglichkeit, solche Systeme über ein Cluster hinweg (mehr als zwei Sockel) zu skalieren.

Im Vergleich gegenübergestellt werden zwei Xeon Platinum 9282 und zwei EPYC 7742. Die beiden Xeon-Prozessoren stammen aus der 9200-Serie und bei dieser handelt es sich um ein MCM-Design, für das zwei Xeon-Chips in einem Package zusammengefügt werden. Daraus ergeben sich 2 x 28 = 56 Kerne und ein Speicherinterface mit zwölf Speicherkanälen mit einer Speicherbandbreite von 407 GB/s.

| Modell | Kerne / Threads | Basis- / Turbo | L3-Cache | TDP | Speicherbandbreite | Preis |

| Xeon Platinum 9282 | 56 / 112 | 2,6 / 3,8 GHz | 77 MB | 400 W | 407 GB/s | - |

| EPYC 7742 | 64 / 128 | 2,25 / 3,4 GHz | 256 MB | 225 W | 204,8 GB/s | 7.500 Euro |

Die beiden EPYC 7742 kommen auf jeweils 64 Kerne und haben ein Octa-Channel-Speicherinterface. Pro Sockel kommen wir hier auf eine Speicherbandbreite von 204,8 GB/s – die Speicherbandbreite ist also wesentlich geringer und dieser Punkt soll in den Benchmarks auch eine Rolle spielen. Große Unterschiede gibt es bei der Thermal Design Power. Während der EPYC 7742 mit 225 W auskommt, genehmigt sich der Xeon Platinum 9282 satte 400 W.

Während man den EPYC 7742 im Handel einzeln kaufen und in ein kompatibles Mainboard stecken kann, ist der Xeon Platinum 9282 nicht so einfach verfügbar. Intel verkauft ihn nur in fertigen Server-Systemen wie dem S9200WK. Der Prozessor sitzt dabei nicht in einem Sockel, sondern ist direkt mit dem Mainboard verlötet.

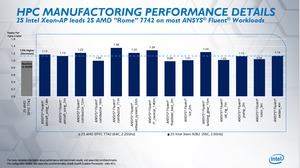

Die Benchmarks sollen nun zeigen, dass die zwei Xeon Platinum 9282 zwischen 8 und 84 % schneller sind, als die beiden EPYC 7742. Je nach Anwendung sind die Unterschiede nicht besonders groß – zumal hier der Anschaffungspreis und die Leistungsaufnahme ebenfalls mit einbezogen werden müssen.

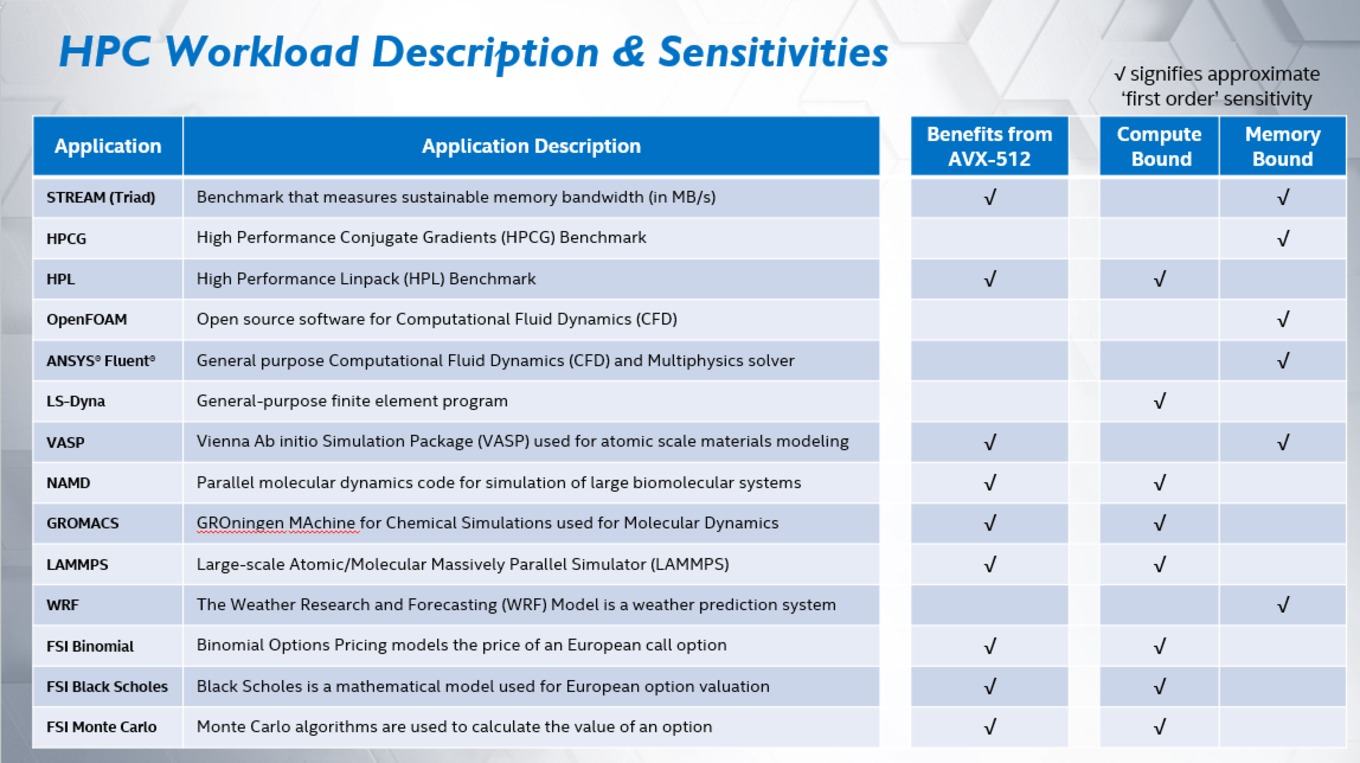

Eine große Rolle kommt den AVX-512-Erweiterungen zu. Ist eine Anwendung entsprechend angepasst, können die Befehlserweiterungen hardwarebeschleunigt ausgeführt werden. Während Intels aktuelle Xeon-Prozessoren AVX-512 unterstützen, ist dies für die EPYC-Prozessoren nicht der Fall.

In einer Übersichtstabelle sind die Benchmarks aufgeführt, die verwendet wurden. Ob eine Beschleunigung mittels AVX-512 vorhanden ist, wird ebenfalls aufgeführt. Zudem wird angegeben, ob die jeweilige Anwendung durch die Rechenleistung limitiert wird oder die Speicherbandbreite.

Intel sieht sich im HPC-Bereich also klar im Vorteil. Die Leistung sei signifikant höher, was zum einen an der Leistung der einzelnen Kerne mit und ohne AVX-512 liegt, zum anderen aber auch am breiteren Speicherinterface bzw. der höheren Speicherbandbreite.

Wir kennen die Preise der Xeon-Platinum-Serie nicht. Intel verweist immer nur auf das Angebot seiner Partner Atos, HPE/Cray, Lenovo, Inspur, Sugon, H3C und Penguin Computing. Man kann jedoch davon ausgehen, dass ein Xeon Platinum 9282 deutlich mehr als die 7.500 Euro eines EPYC 7742 kostet. Dennoch will bei den Total Cost of Ownership (TCO) die Nase vorne haben. Die Leistungsdichte sei bei den eigenen Prozessor deutlich höher und es würden geringere Kosten für einen Interconnect zwischen den Clustern anfallen. Im Fazit heiß es dann:

"More processor cores do not always translate to higher performance, and nor do more processor cores always translate to better TCO." – Mehr Kerne bedeuten nicht immer eine höhere Leistung, so Intel kurz zusammengefasst.

Auf der Supercomputing 19 Mitte November soll es weitere Ankündigungen zur Xeon-Platinum-9200-Serie geben.

Nicht optimierte Benchmarks und fragwürdige Hardware-Entscheidungen

Bei genauerem Blick auf die von Intel veröffentlichten Benchmarks und Fußnoten fallen sofort ein paar Ungereimtheiten auf. Offenbar wurde eine ältere Version von GROMACS, einem Softwarepaket zur Simulationen und Auswertungen molekulardynamischer Prozesse, verwendet. Intel verwendete die GROMACS 2019.3, es gibt aber bereits die Version GROMACS 2019.4, die für die neuen EPYC-Prozessoren optimiert wurde. Mit der neuesten Version werden die AVX2-Funktionseinheiten der Zen-2-Architektur verwendet. Der Hersteller von GROMACS in den Release Notes zur aktuellen Version:

"The AMD Zen 2 architecture is now detected as different from Zen 1 and uses 256-bit wide AVX2 SIMD instructions (GMX_SIMD=AVX2_256) by default. Also the non-bonded kernel parameters have been tuned for Zen 2. This has a significant impact on performance. "

Datenschutzhinweis für Twitter

An dieser Stelle möchten wir Ihnen einen Twitter Feed zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Twitter setzt durch das Einbinden des Applets Cookies auf ihrem Rechner, mit welchen sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf diesen Feed. Der Inhalt wird anschließend geladen und Ihnen angezeigt.Ihr Hardwareluxx-Team

Tweets ab jetzt direkt anzeigen

Es wäre nun spannend zu wissen, wie die Ergebnisse der zwei EPYC 7742 mit der optimierten Version ausgesehen hätten. ServeTheHome hat sich an einer tiefergehende Analyse versucht, allerdings fehlen hier die beiden Xeon Platinum 9282, um einen Gegentest zu erstellen.

Außerdem scheint Intel für das System mit den zwei Xeon Platinum 9282 zwei Threads pro Kern ermöglicht zu haben, bei den beiden EPYC 7742 nur ein Thread pro Kern. Aus den Fußnoten ist dies zu entnehmen:

Intel Xeon Platinum 9282 processor: Intel Compiler 2019u4, Intel® Math Kernel Library (Intel MKL) 2019u4, Intel MPI 2019u4, AVX-512 build, BIOS: HT ON, Turbo OFF, SNC OFF, 2 threads per core;

AMD EPYC 7742: Intel Compiler 2019u4, Intel MKL 2019u4, Intel MPI 2019u4, AVX2 build, BIOS: SMT ON, Boost ON, NPS 4, 1 threads per core.

Damit vergleicht man 224 gegen 128 Threads, nutzt also nicht das volle Potenzial des 2S-EPYC-Systems, welches 256 Threads bieten würde. Auch weitere Konfigurationen der GROMACS-Software sind fragwürdig, wie ServeTheHome anführt. Insgesamt lässt dies zumindest diesen einen Benchmark in keinem guten Licht dastehen.

AMD ist ebenfalls nicht frei von solchen Fehlern. Als Vorschau auf die neuen EPYC-Prozessoren veröffentlichte man mehrfach Benchmarks auf Basis von NAMD (Nanoscale Molecular Dynamics Program). Auch hier kam für die Intel-Prozessoren eine Version zum Einsatz, die keine AVX-512-Instruktionen verwendete und damit nicht auf die Xeon-Prozessoren optimiert war.

Auf der einen Seite ist es richtig, die gleiche Software bzw. den gleichen Benchmark für beide Systeme zu verwenden. Auf der anderen Seite sind gerade Serveranwendungen auf entsprechende Optimierungen ausgelegt. Die Anbieter solcher HPC-Software arbeiten ständig daran, die Hardware bestmöglich zu unterstützen. Dies gilt für Prozessoren aus dem Hause Intel ebenso wie für die von AMD. Dementsprechend sollten die jeweils optimierten Softwarepakete verwendet werden – zumal Intel durch die Verwendung von GROMACS 2019.4 keinerlei Nachteile gehabt hätte, da auch hier die AVX-512-Befehlssätze angewendet werden.

Schlussendlich verwendet Intel für die beiden EPYC-Prozessoren einen Supermicro AS-2023-TR4 Server, der ein HD11DSU-iN Mainboard verwendet. Dieses Mainboard liegt zwar in einer Revision 2.0 für die EPYC-Prozessoren vor, bietet jedoch keine Unterstützung für PCI-Express 4.0. Nun spielen Speicherlösungen oder Compute-Beschleuniger in den Benchmarks keinerlei Rolle, dennoch hätte man auf eine aktuelle Hardwareplattform setzen können, um jeglichen Angriffsvektor in dieser Form zu vermeiden.

Am Ende stellt sich die Frage, ob Intel hier bewusst versucht das Konkurrenzprodukt schlechter aussehen zu lassen oder ob es sich einfach um einen Fehler handelt. Im Falle der GROMACS-Software ist ein Fehler eher unwahrscheinlich, da die aktuellste Version bereits am 2. Oktober 2019 vorgestellt wurde. Selbst wenn die Daten damals schon erhoben wurde, hätte man sie vor der Veröffentlichung einfach weglassen müssen. So kann nur der Eindruck entstehen, dass eine bewusste Täuschung vorgenommen wurde.

Wie auch schon im Artikel zu einem weiteren Intel-Beitrag in dieser Form – Core Scaling und Gaming Performance – Wie viele Kerne sind notwendig? – muss man die Motivation eines Performance-Marketing-Teams wohl in Zukunft wohl immer mal wieder hinterfragen und genauer beleuchten.

Update:

Intel hat sich die Ergebnisse und Ausführungen noch einmal angeschaut und dabei einige Korrekturen vorgenommen.

Datenschutzhinweis für Twitter

An dieser Stelle möchten wir Ihnen einen Twitter Feed zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Twitter setzt durch das Einbinden des Applets Cookies auf ihrem Rechner, mit welchen sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf diesen Feed. Der Inhalt wird anschließend geladen und Ihnen angezeigt.Ihr Hardwareluxx-Team

Tweets ab jetzt direkt anzeigen

So hat man die Tests mit GROMACS Version 2019.4 wiederholt und konnte dabei keine signifikante Änderung der Ergebnisse feststellen. Zugleich soll es sich bei der Anzahl der Threads pro Kern für die EPYC-Prozessoren in diesem Benchmark um einen Tippfehler handeln. Sowohl der Xeon- als auch der EPYC-Prozessor wurden demnach mit zwei Threads pro Kern getestet.