Werbung

Die MLCommons hat die neuesten Ergebnisse für das Training von AI-Netzwerken veröffentlicht. Im Rahmen des MLPerf Training v2.0 geht es einmal mehr darum, eine Vergleichsbasis für solche Systeme zu bilden. Unternehmen wie Dell, HPE, Google, Inspur, Intel, Lenovo, NVIDIA, Gigabyte, Supermicro, Graphcore und viele weitere können an den Benchmarks teilnehmen, müssen sich natürlich an die aufgestellten Regeln halten und dürften auch die Ergebnisse der Konkurrenz einsehen. Offen und transparent soll es hier zugehen.

Allerdings hat es die MLCommons noch nicht geschafft, die MLPerf-Werte für das Training, Inferencing, HPC, Edge-Computing und einiges mehr hinsichtlich der teilnehmenden Unternehmen breiter aufzustellen. Als großer Hersteller fehlt beispielsweise AMD und dabei wissen wir, dass gerade AMD den etablierten Hardware-Anbietern in diesem Segment aktuell große Konkurrenz macht. Zwar gibt es im Trainings-Bereich ein paar weitere Hersteller die Ergebnisse eingereicht habt, die Diversität der Hersteller und ein ausgewogeneres Verhältnis zwischen der Anzahl der eingereichten Ergebnisse wäre dennoch wünschenswert.

Aber kommen wir zu den Ergebnissen:

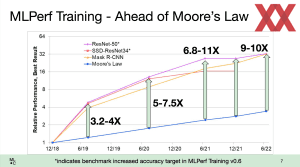

Einer der Trends der vergangenen Runden in den verschiedenen Bereichen war bereits, dass die Systeme immer größer werden. Inzwischen kommen hunderte Prozessoren und tausende GPU-Beschleuniger zum Einsatz, um AI-Netzwerke zu trainieren. Vor allem Google, Microsoft und NVIDIA liefern hier immer größere Systeme, die sich zusammenfassen und nutzen lassen. Entsprechend ist die Leistung solcher Systeme extrem gestiegen – wir sprechen hier von Faktor vier über die vergangenen vier Jahre.

Aber nicht nur skalieren die Hersteller und Anbieter ihre Systeme in immer größere, miteinander funktionierende Super-Cluster, auch die Leistung der einzelnen Komponenten liegt deutlich über dem, was Moores Law erwarten lässt. Das liegt aber nicht nur an der Hardware, sondern vor allem an der Software. Optimierungen in diesem Bereich zeigen noch immer ein Wachstum im zweistelligen Prozentbereich – wenn nicht sogar deutlich mehr.

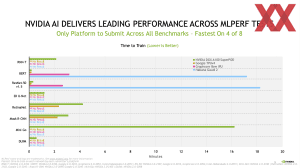

NVIDIA ist und bleibt die große Konstante in den MLPerf-Benchmarks. Man liefert die meisten Ergebnisse und skaliert von kleinen Systemen bis hin zu den Supercomputern mit mehr als 4.000 A100-Beschleunigern. Von Hopper, bzw. H100 war in dieser Runde allerdings noch nichts zu sehen.

NVIDIA liefert nicht einfach nur die meisten Ergebnisse, man zeigt sich auch innerhalb der Benchmarks sehr konstant und liefert für alle Benchmarks Ergebnisse. Allerdings scheint die Dominanz zu bröckeln, denn in vier von acht Benchmarks ist man nicht mehr Spitzenreiter. Google macht NVIDIA mit seinen neuen TPUv4-Instanzen gehörig Druck. In der geschlossenen Gruppe der Benchmarks, dort wo alle Parameter vorgegeben sind, darf sich NVIDIA aber noch immer als führend ansehen.

Neben Google bringt auch Graphcore seine neueste Hardware, die BOW IPU an den Start. Diese wurde im März vorgestellt und basiert grundsätzlich auf der gleichen Rechenhardware, allerdings mittels TSMCs WoW um bis zu 40 % höher getaktet und damit schneller.

Die MLPerf-Benchmarks belegen die im März verkündeten Zahlen. Die BOW-IPU-PODs sind tatsächlich im Bereich von 30 % und leicht darüber schneller als ihre Vorgänger, allerdings muss man hier auch die Optimierung der Software mit einbeziehen, denn diese hat einen gewissen Einfluss auf die Leistung der neuen Systeme in den aktuellen Benchmarks.

Graphcore proklamiert für sich bei gleichem Preis schneller zu sein, als NVIDIA mit seinen DGX-A100-Systemen. Dies belegen die Benchmarks auch, allerdings setzen viele Unternehmen den TCO-Fokus nicht alleine auf die Anschaffung der Systeme, sondern auf die Zeitersparnis, die auch einen gewissen Gegenwert hat. Die Systeme von NVIDIA können größer skaliert werden, sind somit schneller und sollen auf diese Art und Weise punkten. Wie immer sind solche Analysen eine Frage der Sichtweise und jedes Unternehmen wird für seinen Anwendungsfalls genau evaluieren, was wichtiger ist.

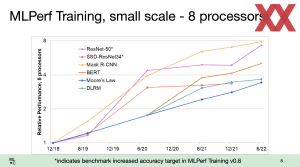

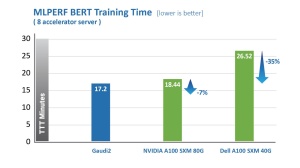

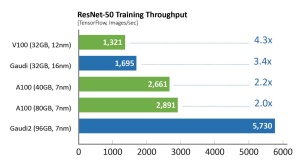

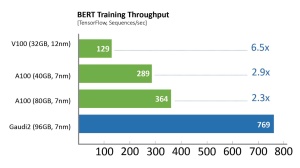

Neben Graphcore und Google steuert auch HabanaLabs (inzwischen Intel) mit dem Gaudi-Chip der zweiten Generation Ergebnisse mit neuer Hardware bei. Allerdings hat man nur ein System mit zwei Prozessoren und acht Gaudi-Beschleunigern verwendet. Der Vergleich mit den Gaudi-Systemen mit 64 oder 128 Beschleunigern ist somit nicht ganz einfach, da eine Skalierung über derart viele Chips nicht ideal verläuft und sich somit nur schwer zurückrechnen lässt, wie groß der Faktor der neuen Hardware ist.

Aber bei acht Beschleunigern schlägt sich der Gaudi 2 erstaunlich gut gegen NVIDIAs A100-System. Time-to-Train ist hier eine ebenso ausschlaggebende Kerngröße wie der Durchsatz. Die Grafiken oben zeigen den Vergleich auf Basis der MLPerf-Daten.

In der Closed-Kategorie zeigt MosaicML, dass eine Anpassung der Compiler und APIs auf eine bestimmte Anwendung einen riesigen Unterschied ausmacht. Teilweise können Workloads damit um mehrere Faktoren beschleunigt werden – bei gleicher Hardware. Dies sieht auch Graphcore als eines der Argumente, weniger auf die Hardware selbst zu schauen und stattdessen den spezifischen Anwendungsfall genau zu bewerten. So arbeiten Graphcore und Aleph Alpha an der Optimierung der jeweiligen Technologien für das Vorabtraining, die Feinoptimierung und das Inferencing von multimodalen Sprach- und Vision-KI-Modellen zusammen.

Alle interessierten können sich die aktuellen Ergebnisse der für die Trainings-Benchmarks ab sofort auf MLCommons.com anschauen.