Werbung

Die ML Commons haben neue Ergebnisse der MLPerf-Training-Benchmarks veröffentlicht. Im Trainingsbereich gibt es einen Versionssprung auf die Version 3.0 inklusive neuer LLM-Benchmarks. Auch die im Edge-Segment wichtigen Tiny-Benchmarks, die auf ein besonders energieeffizientes Inferencing ausgelegt sind, wurden aktualisiert.

Die Benchmarksergebnisse sind für eine eventuelle Auswertung direkt bei der ML Commons verfügbar (MLPerf Training 3.0 und MLPerf Tiny 1.1).

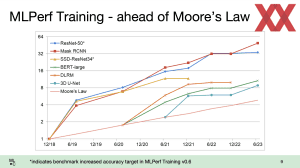

Für uns interessant sind aber die vielen Details, die sich teilweise aus den Ergebnisse und teilweise aus den Systeminformationen ergeben. So präsentiert die ML Commons immer eine Auswertung der Leistungssteigerung in den einzelnen Benchmarks und diese zeigen recht deutlich, dass über eine Skalierung der Systeme über hunderte oder gar tausende Hersteller weiterhin große Sprünge bei der Leistung möglich sind, sodass sich die Rechenleistung noch über Moore's Law bewegt. Allerdings kann man nach einem Auseinandertriften der Kurven inzwischen auch eine gewisse Abflachung der Kurve erkennen.

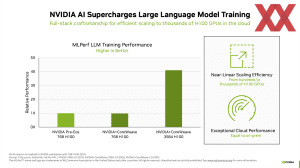

Weiterhin interessant sind die neuen Trainings-Ergebnisse, da hier ein neuer LLM-Benchmark (Large Languange Model) aufgenommen wurde. Dieser basiert auf dem C4 Dataset von HuggingFace und ist 305 GB an Daten schwer und besitzt etwa 174 Milliarden Tokens. Allerdings wird nicht das komplette Netzwerk trainiert, sondern nur ein Subset davon und dennoch sprechen wir hier davon, dass ein System bestehend aus 3.584 NVIDIA H100-Beschleunigern dafür elf Minuten benötigt hat. Bei 0,4 % vollen GPT-3-Netzwerks sprechen wir hier davon, dass besagtes System aus 3.584 NVIDIA H100-Beschleunigern 2.750 Minuten oder etwa 2 Tage benötigen würde. Man kann sich also gut vorstellen, welche Kosten Unternehmen wie OpenAI aufbringen müssen, um ein solches LLM zu trainieren – und GPT-4 dürfte noch einmal komplexer sein.

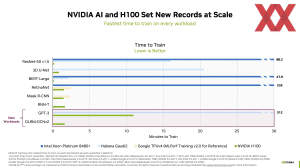

Hier kommt auch das Thema ins Spiel, welches NVIDIA immer wieder hervorbringt: Time to train. Bei einer Dauer von mehreren Wochen oder gar Monaten, aber auch wenn ein solches Netzwerk über Tage und Stunden trainiert wird, wollen Forscher so schnell wie möglich damit arbeiten. Je schneller ein Netzwerk trainiert ist, desto schneller können Optimierungen vorgenommen und ein weiteres Training gestartet werden.

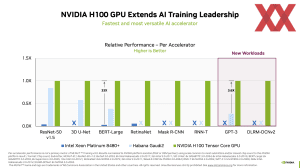

Durch den Einsatz von mehreren hundert und bis zu 4.096 H100-Beschleunigern ist NVIDIA hier natürlich im Vorteil – alleine durch die Skalierung und nicht nur isoliert auf die einzelne Hardware betrachtet. NVIDIA arbeitet in diesem Zusammenhang mit CoreWeave zusammen. Mit deren Hilfe sind auch die letzten Ergebnisse der ML Commons entstanden.

Fortschritte in diesem Zusammenhang macht auch Intel mit den Gaudi-2-Beschleunigern. Die bisher von Intel eingereichten Ergebnisse enthielten maximal acht Gaudi 2, nun sind auch Ergebnisse mit dabei, die bis zu 384 dieser Beschleuniger enthielten und die Skalierung scheint zufriedenstellend zu sein.