Werbung

Vor einigen Wochen machte das Unternehmen MosaicML auf sich aufmerksam, da man vortrainierte MPT-7B-Modelle als Open-Source veröffentlichte und somit der LLM-Forschung (Large Language Model) einen gewissen Vortrieb geben wollte. Bei MosaicML hat man sich darauf spezialisiert, das Software-Ökosystem für AI-Systeme zu optimieren, denn über eine optimierte Software lassen sich große Leistungssprünge im Training erreichen – ein um 30 % beschleunigtes Training bei gleicher Hardware ist bei einer solchen Optimierung keine Seltenheit. Man macht hier also Werbung in eigener Sache und gibt dennoch auch einen interessanten Einblick in den Stand der Dinge.

Die Veröffentlichung von PyTorch 2.0 und ROCm 5.4 hat man nun zum Anlass genommen, die Hard- und Software-Stack-Optionen von AMD und NVIDIA gegenüberzustellen. Aktuell ist NVIDIA der große Gewinner des AI-Hypes – einerseits durch schnelle Hardware, aber auch durch ein Software-Ökosystem, welches man über Jahre aufgebaut hat und vom dem man nun profitiert.

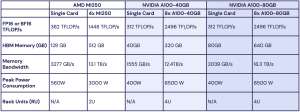

PyTorch 2.0 und ROCm 5.4 sollen es nun ermöglichen ein Training auch auf Instinct-Hardware von AMD durchzuführen und das ohne eine Zeile am dazugehörigen Code zu ändern. Ein MPT-1B LLM-Modell wurde sowohl auf vier Instinct MI250 als auch auf jeweils acht A100 mit 40 bzw. 80 GB trainiert. Dabei gab es keinerlei Abbrüche durch Instabilitäten. Die Benchmarkergebnisse wurden auf eine GPU normiert.

Offenbar liegt AMD inzwischen in der Leistung auf Niveau seines Konkurrenten, denn das System mit den Instinct-MI250-Beschleunigern erreichte in etwa 80 % der Leistung von ebenso vielen A100 mit 40 GB Speicher und etwa 73 % gegenüber den A100 mit 80 GB.

Dabei werden auch einige Unterschiede in der Auslegung der Hardware noch einmal deutlich. Während ein MI250-Beschleungier eine interne Speicherbandbreite von 3,3 TB/s und eine Kapazität von 128 GB vorzuweisen hat, kommen die A100-Beschleuniger auf "nur" 2 TB/s und besitzen auch nur 40 bzw. 80 GB an HBM-Speicher. Auf acht Beschleuniger skaliert kommt ein Rechenknoten mit Hardware von NVIDIA dann allerdings auf auf eine höhere Gesamtkapazität (bei 80 GB pro A100-Beschleuniger) und auch die aggregierte Speicherbandbreite fällt höher aus. Bei der Effizienz geben sich beiden Systeme wenig und liegen in etwa auf gleichem Niveau.

NVIDIAs Vorteil ist allerdings, dass man bereits bewiesen hat, dass die GPU-Beschleuniger zu tausenden zusammenarbeiten können und dabei gut skalieren. Dies gilt es nun auch mit den GPUs von AMD zu beweisen. MosaicML vergleicht hier mit Hardware, die zwar bereits breiter im Einsatz ist, die aber schon ihre jeweiligen Nachfolger hat. AMD Instinct MI300X vs. NVIDIA H100 müsste das Duell heißen. Während NVIDIA die H100-Beschleuniger schon zu tausenden ausliefert, wird es noch einige Monate dauern, bis die MI300-Varianten verfügbar sein werden.

Der MI300X-Beschleuniger hätte aber wiederum die Vorteile in der Kapazität (192 vs. 80 GB HBM3) und der Speicherbandbreite (5,2 vs. 3,2 TB/s). Aber auch hier hat NVIDIA bereits bewiesen, dass tausende H100-Beschleuniger gut skalieren und zusammenarbeiten können. Dieser Nachweis steht bei AMD noch aus.