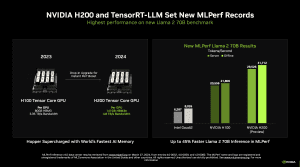

Die MLCommons, ein Konsortium verschiedener Hersteller, welches es zum Ziel hat, möglichst unabhängige und vergleichbare Benchmarks zu Datacenter-Hardware anzubieten, hat die Ergebnisse der Inference-Runde 4.0 veröffentlicht. Darin ihr Debüt feiert der H200-Beschleuniger von NVIDIA, der zwar ebenfalls auf der Hopper-Architektur und der gleichen Ausbaustufe wie der H200-Beschleuniger von NVIDIA basiert, der aber anstatt 80 GB an HBM2 auf 141 GB HBM3E setzt.

HBM3E wird auf allen zukünftigen KI-Beschleunigern zum Einsatz kommen. NVIDIA hat seine Blackwell-GPU mit HBM3E angekündigt und AMD soll eine Umstellung seiner Instinct-MI300A/X-Beschleuniger auf HBM3E vorsehen. Die hohe Bandbreite des schnelleren Speichers macht sich vor allem im Inferencing und Training von Large Language Models (LLMs) bemerkbar. Da sich im Datacenter-Umfeld aktuell fast alles auf Generative AI und LLMs konzentriert, ist es kaum verwunderlich, dass die Hardwarehersteller alles darauf konzentrieren.

Im Rahmen der Inference-4.0-Ergebnisse bekommen wir nun einen ersten unabhängigen Vergleich zwischen NVIDIAs H100-, dem neuen H200- und dem Gaudi-2-Beschleuniger von Intel. In diesem Segment der Datacenter-Anwendung verschiebt sich der Bedarf in Richtung des Inferencing. Bestehende Modelle sind (aus)trainiert und ab dann erfolgt häufig nur noch das Inferencing. NVIDIA geht aktuell davon aus, dass die Hardware zu 40 % für das Inferencing genutzt wird und dieser Anteil wird in Zukunft weiter wachsen. Dies ist auch einer der Gründe, warum NVIDIA die Blackwell-GPU in Richtung des Inferencing ausgelegt hat.

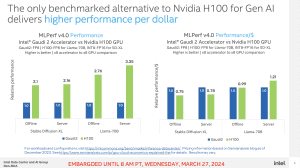

Wir haben uns ein paar der Ergebnisse herausgepickt und vergleichen die Ergebnisse für ein Llama-2-Modell mit 70 Milliarden Parametern, die einmal als Offline- und einmal als Online-System im Inferencing ihre Leistung unter Beweis stellen mussten. Wir haben Systeme mit jeweils acht Beschleunigern ausgewählt und unterscheiden zwischen den verschiedenen Leistungsprofilen.

Llama 2 mit 70 Milliarden Parameter

Server

Werbung

Llama 2 mit 70 Milliarden Parameter

Offline

Das, was die Beschleuniger hier leisten müssen, soll eine typische Ausgabe auf Fragen durch das LLM sein. Die Tokens pro Sekunde geben an, wie viele der kleinsten Einheiten eines LLMs das System verarbeiten kann.

Die H200-Beschleuniger sind mindestens um den Faktor vier schneller als die Gaudi-2-Beschleuniger von Intel. Von H100 zu H200 bei 700 W gibt es ein Plus von 30 %. Per Custom Cooling Solution (CTS) kommen die H200-Beschleuniger auf ein Plus von 45 %. Man muss allerdings auch sagen, dass die CTS-Lösung mit 1.000 W einen um 43 % höheren Verbrauch aufweist, jedoch nur um 15 % schneller ist. In dieser Konfiguration werden die H200-Beschleuniger also deutlich außerhalb des idealen Betriebsfensters betrieben.

DGX- und MGX-Systeme mit H100-Beschleunigern können auf H200-Beschleuniger aktualisiert werden. Auch die kommenden B100-Beschleuniger sind "Drop-in"-kompatibel. NVIDIA hat bereits damit begonnen, die ersten H200-Beschleuniger an Cloud Service Provider und OEMs auszuliefern. Damit steht er kurz vor der Marktverfügbarkeit.

Intel nur per TCO auf Augenhöhe

Von den Instinct-MI300A/X-Beschleunigern fehlt in den Inferencing-Ergebnissen jede Spur. Weiterhin vertreten ist Intel mit dem Gaudi 2. Wie wir bereits in den Benchmarks gesehen haben, kann der Gaudi-2-Beschleuniger hinsichtlich der Leistung nicht mithalten.

Dafür sieht man sich im Verhältnis aus Preis/Leistung vorne. Intel kann damit punkten, dass die Gaudi-2-Beschleuniger verfügbar und eben vergleichsweise günstig sind, während die Anschaffung bei den H100- und wohl auch H200-Beschleunigern aktuell noch immer etwas schwierig ist.

Wer sich die Zahlen, bzw. die MLPerf-Ergebnisse genauer anschauen möchte, kann dies direkt auf der Seite des Konsortiums tun.