Werbung

Diesen Sommer stellte xAI den aktuell wohl größten KI-Supercomputer namens Colossus fertig. Mit 100.000 H100-Beschleunigern bestückt stellt eine solche Installation gigantische Voraussetzungen an alle beteiligten Infrastruktur-Komponenten – über die Stromversorgung im Bereich von 155 MW, die Kühlung und auch im Hinblick auf die Netzwerk-Infrastruktur. Aktuell arbeitet xAI sogar an einem Ausbau. Doppelt so viele – satte 200.000 Beschleuniger – sollen es werden. Unbestätigten Meldungen zufolge soll es sich bei den zusätzlichen 100.000 Beschleunigern sogar um verbesserte H200-Varianten handeln.

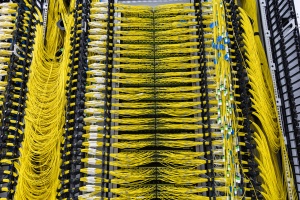

Um die bestehenden 100.000 H100-Beschleuniger miteinander zu verbinden, hat sich xAI für die Spectrum-X-Plattform von NVIDIA entschieden. Zum Einsatz kommen Spectrum SN5600 Ethernet-Switches mit bis zu 64 800-GbE-Ports und einer Gesamtkapazität von 51,2 TBit/s. Unterstützt wird ein möglichst effizienter Netzwerkverkehr von NVIDIAs BlueField-3 SuperNICs.

Über alle drei Schichten des Netzwerks hinweg will NVIDIA mit der Hard- und Software einen Durchsatz von 95 % des maximal Möglichen erreicht haben. Die Effizienz des Netzwerks wird durch eine intelligente Wahl der Routen und Suche nach Alternativen bei Ausfall oder zu hoher Last auf einem Router erreicht. NVIDIA setzt dabei grundsätzlich auf ein offenes RDMA-Netzwerk (Remote Direct Memory Access), bringt jedoch proprietäre Softwarepakete zum Einsatz. Bei AMD hingegen setzt man auf UltraEthernet und will damit im ersten Quartal 2025 Ports 400 GBit/s pro Port erreichen.

Die Kollegen von ServeTheHome hatten die Gelegenheit, einen Blick hinter die Kulissen von Colossus zu werfen. Die H100-Beschleuniger befinden sich in Servern von Supermicro. Je 4U-Server kommen acht H100-Beschleuniger zum Einsatz. Bei acht Servern ja Rack sind es demnach 64. Jedes Rack verfügt über eine Supermicro Coolant Distribution Unit (CDU). Immer acht Racks mit 512 Beschleunigern fasst xAI zu einem Mini-Cluster zusammen. Etwa 25.000 GPU befinden sich in einem größeren Cluster. Vier dieser Cluster sind miteinander verbunden und so kommt xAI aktuell auf maximal etwa 100.000 Beschleuniger, die an den riesigen Grok-Modellen arbeiten und diese trainieren.

NVIDIA und xAI haben Colossus in 122 Tagen aufgebaut, was in Anbetracht der Größe und Komplexität eines solchen Systems erstaunlich schnell ist. Bereits 19 Tage nachdem das erste Rack installiert wurde, konnte dieses in Betrieb genommen werden. Der schnelle Aufbau hat allerdings negative Folgen, bzw. anderweitige Herausforderungen. So soll das von xAI verwendete Gebäude anfangs nur über eine Stromversorgung von 8 MW verfügt haben. Insgesamt kommt Colossus aber auf etwa 155 MW und der Netzbetreiber sagte ab August einen Anschluss von 50 MW voraus, bis Jahresende sollen es dann 200 MW sein. Daher musste xAI 14 riesige Generatoren mit jeweils 2,5 MW einsetzen, um den nachfolgenden Ausbau in der Stromversorgung zu überbrücken. Aktuell werden riesige Batteriepacks installiert, welche die Spitzenlasten des KI-Superclusters abfangen sollen.

Kühlung, Stromversorgung, Verteilung der Kühlflüssigkeit – all das ist gut im Video von ServeTheHome zu erkennen, welches wir unten eingebunden haben. Dazu gibt es noch einen ausführlichen Artikel mit weiteren Bildern.

Datenschutzhinweis für Youtube

An dieser Stelle möchten wir Ihnen ein Youtube-Video zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Youtube setzt durch das Einbinden und Abspielen Cookies auf ihrem Rechner, mit welchen Sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf den Play-Button. Das Video wird anschließend geladen und danach abgespielt.

Ihr Hardwareluxx-Team

Youtube Videos ab jetzt direkt anzeigen