HWL News Bot

News

Thread Starter

- Mitglied seit

- 06.03.2017

- Beiträge

- 114.642

... weiterlesen

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

Also der große vorteil von HBM => Platzersparnis (PCB) ist schon mal komplett weg...

Warum steht hier dass sie sich mit ner 1080ti battlet? Dachte sie ist gerade mal so schnell wie ne normale 1080.

Kyle Bennet hatte die Karte für einen Tag zur Verfügung gestellt bekommen und soll gebeten worden sein, sie gegen eine GeForce GTX 1080 zu stellen.

Oder es war der VRM-Zusatz SoC für mehr PowerLimit, Spannung war gestern!Mit aktivem TBR und gescheitem Treiber scheint die 1080 non-Ti doch weiter hinten zu liegen.

Na schauen wir mal wie nah man an eine 1080 Ti rankommt.

Ziemlich clever von AMD da FreeSync und G-Sync mit einzubeziehen denn wenn man dann alles in UHD/4K präsentiert was es ja aktuell nur in 60Hz gibt

reichen 60FPS aus (weil sonst ist man außerhalb der Range und es gibt Tearing) und das schafft man mit den richtigen Settings in jedem aktuellen Spiel!

400€ für ne RX Vega XL(...)

(...)performance egal, hauptsache(...)

Die XL soll ja der Cut sein, da sind 400$ schon wahrscheinlich wenn bei XT bzw XTX nicht mehr Leistung kommt als 1080-Niveau.Da ist ein Verkaufspreis von 400,- US$ nicht wirklich realistisch?

Das glaube ich nicht, denn AMD wird auf der Siggraph zwar Vega launchen und uns ein paar cherry picked Balken zeigen (wie jeder andere Hersteller bei einer Produktvorstellung auch)Irgendwie schade, dass in einer Woche alles vorbei ist.

Vega dropt nicht und es ist alle ingame.

Du sagst also auf einem UHD/4K 60Hz Monitor mit aktiviertem G-Sync @60FPS gibt es mit einer GTX1080(Ti) Framedrops ?

In welchem Spiel soll das sein und auf wie viel FPS dropt es denn von 60 runter ? Die Antwort würde ich mir gut überlegen !

Ich rede eigentlich von 60FPS und wollte gerne wissen in welchem Spiel diese Drops sind auf wie weit die runtergehen ?

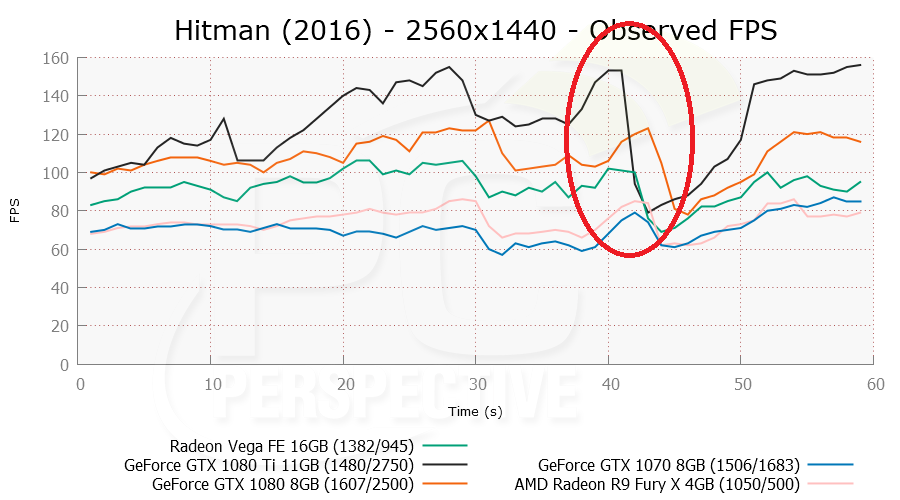

Der drop wird von Vega recht smooth weggeglättet während die pascals richtig droppen. Man sieht auch, dass die 1080 einen längeren Balken hat, spricht mehr avg fps aber bei den min fps stärker dropt.

Der zweite drop ist bei der 1080ti am heftigsten. Von 70 fps auf 40fps. Die ganzen max fps der 1080ti sind nutzlos.

Allgemein sieht pascal sehr anfällig aus:

Bei der 1080ti könnte man ja meinen, sie wirft >100fps bei 1440p raus .... denkste

Warum jetzt auf einmal der 1440p Bench und nicht der 4k Bench?!

Sämtliches AMD vs. Nvidia hat in der Realität keinerlei Bedeutung.

oder 18fps vs 13fps

oder 18fps vs 13fps

Die VEGA wird an der GTX1080 nicht vorbei kommen. Es dauert ca. 2-3 Monate (nach Release) bis man "finale" Treiber bekommt und auch HBM2 ist keine Wunderwaffe. OC gleich Null. Mehr Verbrauch & deutlich mehr Abwärme.

Erst die nexte NV / AMD Gen. (kein Refresh) wird richtig interessant. Das hier ist nur Show. Wie RyZen. Erst die 2. Gen. wird interessant (und hoffentlich weniger verbugt)