Alles richtig nur statt 4Lanes mit PCIe4.0 wäre es besser gewesen 8 Lanes PCIe3.0 zu wählen. Das mag identische Transferraten haben, aber steckt man diese PCIe4.0 Karte in ein System, was eben kein PCIe4.0 hat, dann halbiert man mit einem PCIe3.0 Steckplatz die Datentransferrate. Sprich, ne NMVe ist teilweise schneller!

Problem ist, dass Navi24 für Notebooks geplant war und dort niemals mit PCIe3.0 angebunden worden wäre. Als Steckkarte ist das bei älteren PCs aber möglich. Darauf wollte ich Hinaus ...

Für Office und Co würde auch ne 2GB Karte reichen, dann aber bitte moderne Schnittstellen, passivkühler, Verbrauch auf 35W runter und so weiter.

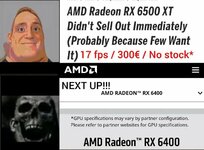

Oder gleich in den Mobile-Markt werfen. Aber das was AMD da jetzt gemacht hat, bleibt im Lager liegen.

Da hat wer im Marketing einfach nur gepennt ... am Markt vorbei ...

Als 6400 scheint das ja ok zu sein, nur ob die OEM Only bleibt? 54W ist aber dennoch ne Hausnummer und AV1 Decodierung nicht in Hardware? Schade ...