RAZ0RLIGHT

Enthusiast

Und? Lebensmittel sind allgemein teurer geworden, damals waren viele der Preisschilde identisch zur DM, nur dass das € Zeichen dahinter stand und auf einmal rutschte man von Mittelstand in den Abgrund. Wie gesagt, von Marktwirtschaft verstehe ich nichts, nicht mein Fachgebiet, aber die Auswirkungen dazu (Inflationsrate, dass es sogar günstiger statt teurer geworden sein soll und es niedriger ausfällt als zur DM-Zeiten) kann ich nirgendwo sehen.

Einzig die Preise der technischen Geräte haben sich kaum verändert und blieben günstig, zumindest in den Bereichen, welche mich interessierten, GPUs mal ausgenommen. Aber wir werden zu sehr OT

PS: Kippe 10€/Schachtel? Zum Glück bin ich weder Raucher noch Trinker.... (nicht abwertend gemeint)

@Razor,

ich weiß leider nicht, was dein Beitrag mit meinem zu tun haben sollte.

@Topic,

werde das Ganze entspannt beobachten, alle Grafikkarten sind verkauft, im Sommer wird sich mehr bewegt als in der Stube zu hocken und im Winter kann ich wieder reinschauen, was es Neues gibt und wie bis dahin die Erkenntnisse mit DX12 ausfallen und dnan sind auch erst mal die Konsolenspiele dran, 2017 wandert dann wieder eine GPU ins System wenn vermutlich 1080Ti und Vega draußen sind.

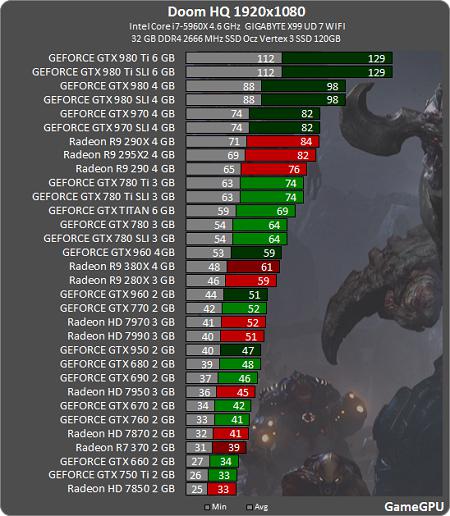

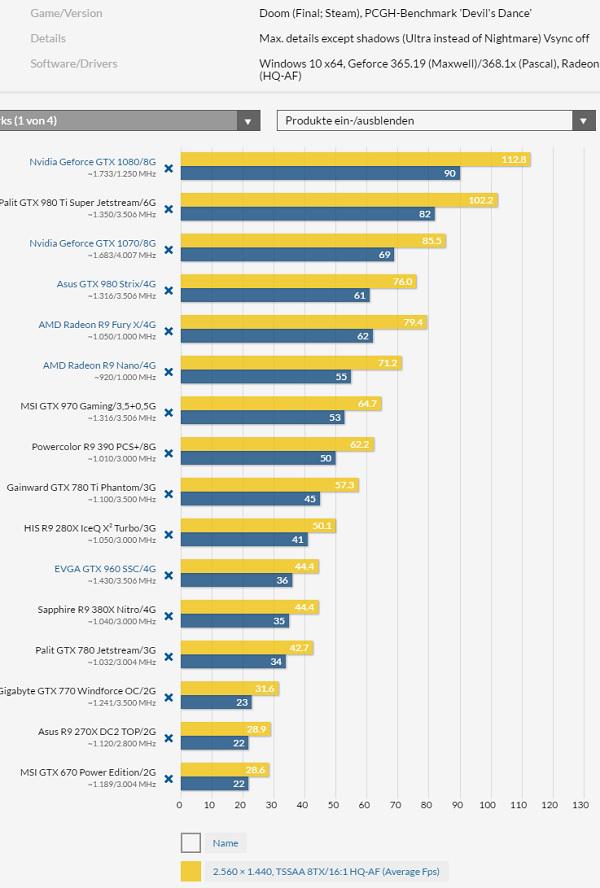

Und wenn man betrachtet, dass die AMD 480 8GB 250€ kosten könnte, welche deutlich langsamer als die GTX 1070 8GB ist (379$), steht die AMD nicht mehr in gutem Licht, wo schon die GTX 1070 in den Augen Vieler zu teuer ist. Außerdem ist eine TDP von 150W alles andere als grandios, wenn sie langsamer als die GTX 1070 ist, das mal nebenbei gesagt, und das obwohl sie eine kleinere Strukturbreite als Nvidia haben (14nm <-> 16nm). Folglich scheint AMD erneut im Bereich Effizienz das Nachspiel zu haben.

sorry hab mich verlesen, dachte weil AMD nix neues bringt, du meintest aber nur die Software ^^

mein Fehler!

) Auch bei AotS wollte Nvidia, dass es zum Benchen mindestens deaktiviert wird.

) Auch bei AotS wollte Nvidia, dass es zum Benchen mindestens deaktiviert wird.