Du hast Recht es ist schon UV, das ist richtig, aber nicht in dem Sinne, dass die Karte weniger W zieht als Stock. Also hätte ich eher unterwatten schreiben sollen

mit dem eigentlichen Ziel gleichwatten bei mehr Bildern 😜

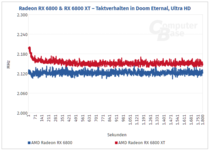

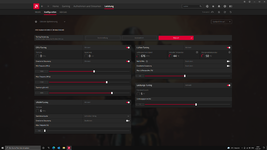

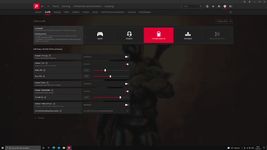

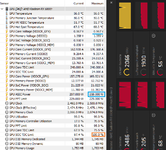

Ich habe mal die beiden Settings (WM 2460Mhz und WM 2270Mhz) und Einstellmöglichkeiten in Hunt und CP2077 getestet und verglichen. Die dargestellten Bilder sind zwar nur Momentaufnahmen aber beim Herumlaufen etc, ergaben sich diese Werte als repräsentabel:

Hunt 2460Mhz 144Hz - 120Hz:

Hunt 2270Mhz 144Hz - 120Hz:

Wie man sieht halten beide Settings die eingestellten Frames. Auch der niedrige Takt hält die 144fps, auch wenn da im Overlay 142 angezeigt wurde.

Was ich mich frage ist, wieso bei identischen 120fps Cap bei der 2460Mhz Variante auch der Takt deutlich höher liegt und die Karte weitaus mehr Leistung nimmt, obwohl Sie dies gar nicht benötigen würde?

Gibt es dazu eine Erklärung?

Für mich wäre hier somit das Setting der Wahl definitiv das niedriger taktende, da hier weniger Strom, weniger Abwärme und vor allem auch deutlich weniger Lärm durch die Spulen erzeugt wird (fast unhörbar gegenüber gut hörbarem Rasseln bei 2460Mhz).

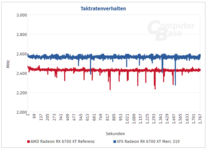

Cyberpunk 2077 2460Mhz - 2270Mhz:

CP2077 läuft auf Ultra Settings natürlich ins GPU Limit, womit man einen Unterschied der beiden Settings in den maximal Frames erkennen kann.

Allerdings finde ich 3 Frames Unterschied im Verhältnis zu 60W Unterschied schon ziemlich beachtlich.

Und zu guter Letzt auch noch das SOTTR Benchmark in beiden Settings inkl HWINFO Log zum Vergleich:

SOTTR Bench 2460Mhz:

SOTTR Bench 2270Mhz:

Für mich auch erstmal wieder ersichtlich 3 Frames Durchschnitt und 60W Unterschied im Max.

Hier ist der Unterschied an Frames im Bench Detail aber dann schon ersichtlich und im Schnitt liegt der W Verbrauch bei 30W Differenz.

Ich weiß nicht wie ihr es seht, aber für mich kommt es so vor, als würde die Karte bei 200W Verbrauch effizienter arbeiten als im anderen Setting? (Also mehr Frames/W)