Nighteye

Urgestein

- Mitglied seit

- 07.03.2005

- Beiträge

- 11.910

- Details zu meinem Desktop

- Prozessor

- AMD R5 2600 -> 5800X3D

- Mainboard

- Asus X470 Prime Pro (Seit 2018 im Einsatz)

- Kühler

- LC-Power Cosmo Cool 120 -> Thermalright Peerless Assassin 120 SE

- Speicher

- 2x 8GB 2x16GB @ 2733mhz 15 16 16 34

- Grafikprozessor

- AMD RX470 4GB (2016) -> RX6800 16GB @500mhz

- Display

- LC Power LC-M34-UWQHD-144-C-V2 - 34" Curved

- SSD

- Crucial MX 500 + WD Blue SN550

- Gehäuse

- LC-Power Silent Slinger

- Netzteil

- LC-Power GP4 Gold 650W (Seit 2018 im Einsatz)

- Keyboard

- LC-Power KEYMECH

- Mouse

- LC-Power m715R -> Bloody W95 Max

- Sonstiges

- 5x LC-Power AiRazor Black Series, 120mm rot (Seit 2018 im Einsatz)

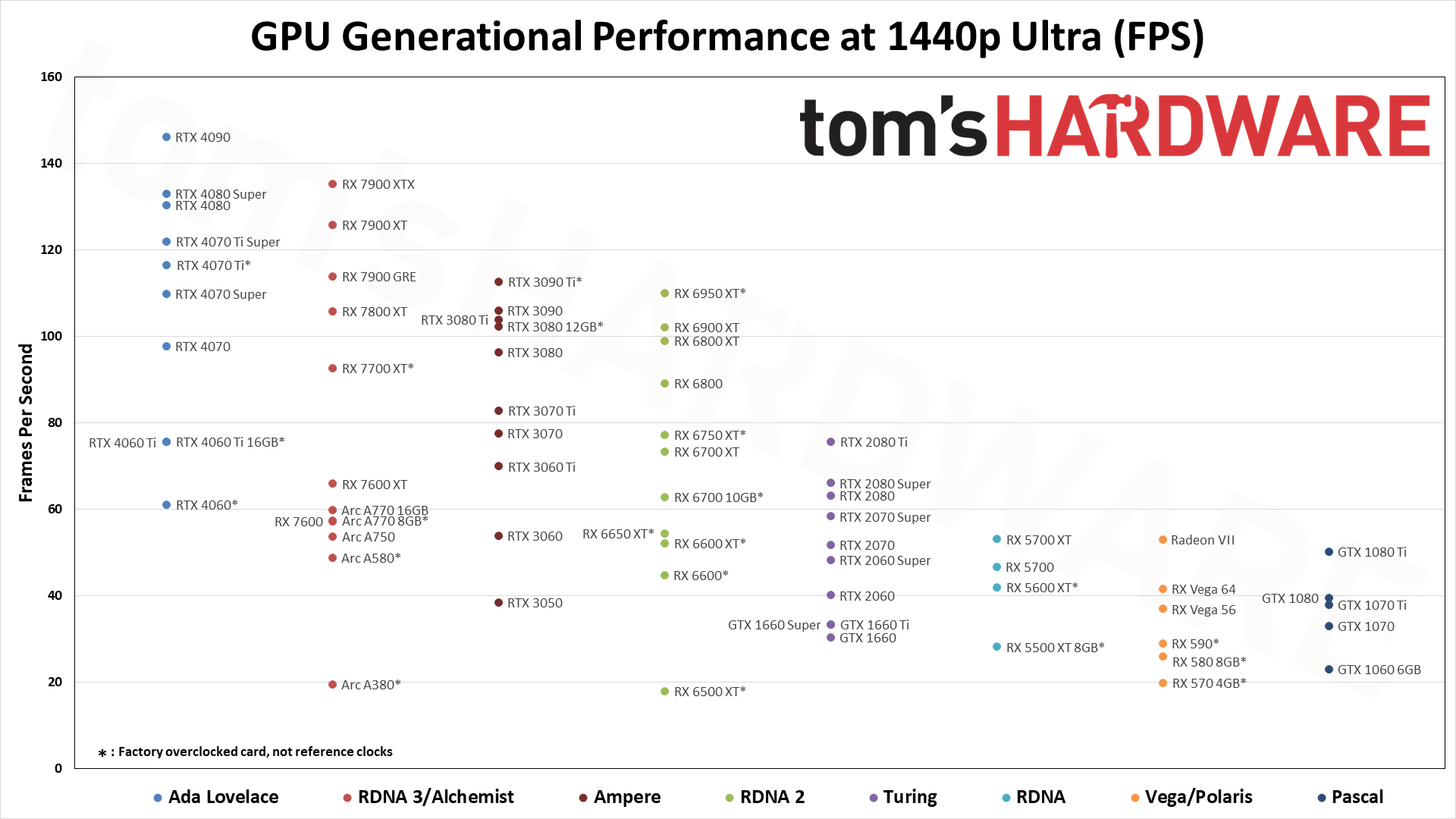

Zu Relase gabs die RTX 3080 10GB für 1000€ und die ist heute langsamer als eine 1/3 so teure RX6700XT 12GBIch hab für die RX6800 Ref über 600€ bezahlt, das waren die Preise zu Release und waren gut.

Also RDNA 2 P/L war schon Mega.

Also RDNA 2 P/L war schon Mega.Leider ist die Masse immer Dumm und verbrennt Geld mit dem Kauf von Nvidia.

Kumpel von mir hat mehr Geld für seine RTX 3070ti 8GB ausgegeben als ich für meine RX6800 nonXT.

Und in Star Citizen zocken wir beide 1440p. Und bei ihm fehlen immer viel mehr Textur Details und er ärgert sich heute nicht auch Radeon gekauft zu haben, kauft sich als nächstes aber wieder eine Nvidia.

Manche lernen es nie.