ich fühle mich grade etwas getrollt

wie bitte kann deiner meinung nach kein cpu limit vorliegen wenn die fps steigen je potenter die cpu wird?

das du nicht verstehst warum die cpu mit der nvidia karte weniger limitiert zeigt übrigens das du das ganze thema hier nicht verstehst.

Du hattest doch "getrollt", indem du einen Video gezeigt hast, dass null Aussagekraft besitzt, bitte kläre doch einfach den Sachverhalt weiter oben abschließend auf.

Solange ich mit dem besagten FX oder dem i5 4460 keine Nivida GPU getestet habe, kann man auch nichts zu dem höheren Overhead sagen.

Und es ist doch klar, dass hier keinerlei CPU Limit vorliegt, sondern wenn dann eines der API oder eines nicht aufgeräumten Treibers, von CPU Limit zu sprechen ist grotesk.

Ein CPU LImit kann man vielleicht mit synthetischen workloads wie Super PI herbeiführen, aber doch nicht mit Spielen, das siehst du doch alleine schon wenn die GRafikkarte gewechselt wird, oder auch der CPU Hersteller gewechselt wird.

Oder glaubst du ein FX-8350 wird annähernd ausgelastet? Dann müsste er ja schneller als ein i5 4460 sein.

- - - Updated - - -

Lanzelot - ganz ehrlich: Bitte ignoriere dieses Thema doch einfach. Du behauptest es gäbe kein CPU Limit? Sorry aber da widersprechen dir alle guten Fachzeitschriften und alle haben das Thema unter DX11 im CPU Limit schon mal adressiert.

Lies halt mal nach was ich geschrieben habe, das ist alles so richtig, denn wie ja auch hier schon erkannt wurde, handelt es sich keinesfalls um ein CPU Limit.

Was du nicht wahr haben willst ist wie mir scheint, dass es Leute gibt die mit weniger als einem i5 4460 zocken.

Wieso kommst du denn darauf? Das habe ich nicht gesagt, ich habe nur gesagt, dass ein FX 8350 in Relation relativ lahm ist und das kann ja niemand bestreiten.

Leute die einfach nen alten CPU haben und nur die GPU umgesteckt haben um aktuellere Spiele in reduzierten Details zu spielen und um eben diese Leute geht es hier und nicht den Hardwareenthusiasten, welcher schon seit dem i7 920 nichts anderes mehr verbaut hat und jeden als Noob bezeichnet der ne AMD APU hat ...

Ich dachte hier geht es um eine nüchterne Betrachtung der Fakten und nicht um irgendwelche Schuldzuweisungen?

Ihr müsst einfach mal ein bißchen ruhiger werden.

Das sagst gerade du, der mir anrät das Thema zu ignorieren, ohne zu kapieren was hinter meiner Aussage gesteckt hat.

Das trägt sicherlich nicht zu einer ruhigen Diskussion bei.

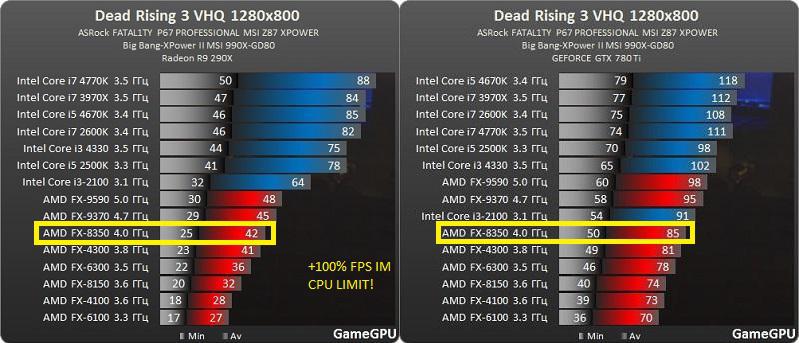

es geht um eine langsame CPU in Verbindung mit einer AMD Karte unter DX11 und da bricht die Performance einfach viel weiter ein als sie sollte.

Und dafür werden immer wieder polnische und russische Seiten herangezogen? Wieso nicht einfach mal eine langsame CPU einsetzen, mit einer gleichschnellen AMD und Nvidia GPU bestücken und danach 15 bis 20 Spiele in einer niedrigen Auflösung testen und nicht Rosinen oder Kirschen herauszupicken, denn die findet man bei Nvidia ebenso, da braucht man nur die letzten zwei Wochen anschauen.

"Nvidias Problematik" im GPU Limit, oder CPU Limit, da gibt es mindesten genausoviele Beispiele, aber die werden gekonnt ignoriert.

Ich will ja nicht sagen, dass es den größeren overhead nicht gibt, aber zB. die ca 70% Differenz in dead rising 3 einzig und allein auf den overhead zu schieben klingt nicht plausibel.

Natürlich ist das absoluter Blödsinn.