Ich meine nur, dass es spätestens zu ZEN in der Bedeutungslosigkeit verschwindet (außer bei den ganz wenigen, die dann immer noch mit einem fast >7 Jahre alten CPU unterwegs sind) und bei Polaris besser geworden ist.

Wenn die Zen CPUs in jeder erdenklichen Software aktuelle CPU Modelle förmlich deklassiert, mag das auf absehbare Zeit richtig sein, ob das aber passiert, ist mindestens mal fraglich... Die Benches von den Redaktionen werden zum Teil mit stark übertakteten CPUs der aktuellen Generation gemacht und zeigen trotzdem ein mehr oder weniger deutliches Bild. Zen müsste also noch deutlich viel mehr Performance bringen als stark übertaktete CPUs von heute, um das Thema (DX11 und älter wie auch OpenGL) in dei Bedeutungslosigkeit verschwinden zu lassen.

Auch sollte man nicht unterschlagen, die Anforderungen steigen mit jedem Monat/Jahr... Nicht nur, weil GPUs schneller werden, sondern auch weil Software eben mehr Anforderungen hat. Das Thema wird wohl NIE völlig begrabbar sein.

Rein technisch betrachtet besteht die Angabe FPS auch IMMER aus einem Anteil GPU Rechenzeit und einem Anteil CPU Rechenzeit.

Selbst 100 FPS sind noch 10ms. Wenn davon nur 1-2ms auf die CPU fallen, könnte also mit einer Leistungsverdopplung der CPU anteilig eine Menge an Leistung gewonnen werden. -> das unterschlagen halt hier recht viele Leute. Da oben, in den High-FPS Bereichen kann ein kleiner Unterschied der CPU Power schon für eklatante Unterschiede sorgen. Im Low-FPS Bereich hingegen wiegt das ungleich anders... Wenn die GPU alleine sagen wir 25ms benötigt, dann gehen 1-2ms fiktiver CPU Anteil eher unter. Das wären bspw. ca. 37 vs. 40 FPS und interessiert fast kein Mensch. 100 FPS und 2ms weniger wären aber schon 125 FPS und damit schon deutlich anders wie auch (je nach Monitor und Spiel) spürbar.

Hier spricht man irgendwie immer von CPU Limit und GPU Limit. Das gibts aber genau genommen nicht. Es limitiert IMMER beides. Weil IMMER ein Teil der Zeit von der CPU und ein Teil von der GPU kommt. Eins vollends auszuschließen, also 0ms für einen der Parts zu haben, gibts nicht. Das ist auch der Grund, warum die Steigerung/Senkung der GPU oder CPU Leistung eigentlich NIE 1:1 skalieren kann.

Auch kann es vorkommen, dass trotz vermeidlich hoher Abhängigkeit der CPU die Steigerung der GPU extrem gut FPS bringt. Einfach weil möglicherweise der CPU Anteil durch Berechnungen rein vom Spiel her deckelt auf einen gewissen Rahmen in Milisekunden, die GPU obenraus aber trotzdem pusht. Angenommen mehr oder weniger fixe 10ms CPU Anteil kann mit 30ms GPU Anteil bei verdreifachung der GPU Performance auf 10+10ms verkürzt werden. Damit steigt die FPS Rate im Schnitt von 25 auf 50 FPS. Andersrum geht das aber halt genau so, 4x mehr CPU Power (verdopplung der Cores + Takt + IPC) würde ebenso dann bspw. mit 5ms CPU + 10ms GPU in letzterem Fall noch auf 67 FPS skalieren und damit allgemein hin sicher als "CPU Limit" gelten.

Schwierig ist dabei, den Spaß sauber zu trennen, weil die Masse der Benches und angeblichen Belege einfach nur min./avg.(ggf. max.) FPS zeigt. Aber keine Frameverläufe oder Frametime-Verläufe. Bei den Avg. Messungen kommt dann noch hinzu, dass eben massive Unterschiede in der Szene dafür sorgen können, dass die avg. Werte das Problem gar nicht oder nur weniger ausgeprägt zeigen.

Wo genau ist denn für dich die Reihenfolge der Intel Cpus nicht nachvollziehbar?

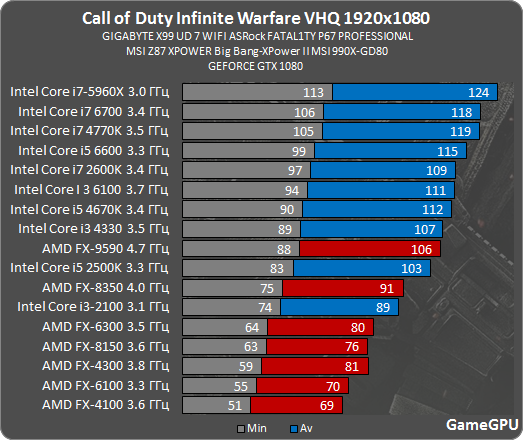

2500k vs. 2600k -> quasi gleich schnell, nach Bench sogar 2500k vorn, trotz mehr Takt, Cache und SMT beim 2600er

6600 vs. 6700 -> 3 FPS Unterschied und damit 4,3% pro 6700

Das ist nicht ganz nachvollziehbar, zeigt aber auch, dass da recht sicher Einflüsse drin sind, die nicht die reine CPU Rechenleistung betreffen. Das kann wieder alles und nix sein. Möglicherweise skaliert der AMD Treiber bei Skylake mit SMT, bei Sandy hingegen nicht?

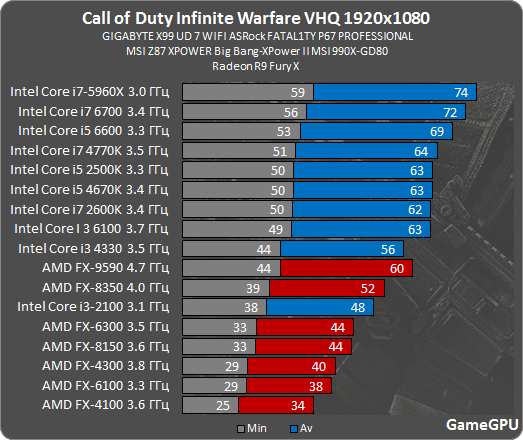

Gerade bei AMD sollte/müsste man mal die SMT Skalierung untersuchen... Es gibt Benches im Netz, da interessiert sich der AMD Treiber gar nicht für SMT (+-0% Unterschied), im gleichen Titel mit einer NV GPU hingegen teils deutlich (+-20%) -> das war bspw. in Watch Dogs der Fall damals.

Auch sollte man denke ich mal die Cachegröße und deren Einfluss auf die FPS prüfen. Der 5860X hat viel Cache, das bringt erfahrungsgemäß gut Punkte, vor allem in CPU fressenden Szenen.

Oder auch unterschiedliche Speicheranbindungen könnten hier für Unterschiede sorgen. Gerade bei weniger Cache... Alte CPUs werden ja häufiger auch mit weniger hohen Speicherbandbreiten getestet. Selten wird nem Sandy da 2400er oder mehr Speicher spendiert. Bei nem Skylake hingegen kommt das vor. Bei Haswell/Broadwell-E bspw. ist es mindestens mal standard 2133/2400er zu nutzen. Dazu noch Quadchannel. Profitiert dann der Treiber von der Bandbreite, punktet A) der Cache und B) der S2011er Prozessor. Ein 5770C wäre hier dann auch ein Kandidat, der profitiert.

?

?