Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Ampere Smalltalk-Thread (Startpost lesen, Handel nur im Marktplatz!, keine Botanfragen!)

- Ersteller Housecafe

- Erstellt am

G

Gelöschtes Mitglied 323908

Guest

"Wenn"

Ich denke Mining für Hobbyminer kann nicht mehr profitabel als jetzt werden, eher noch weniger profitabel.Wenn Hard Fork heute reibungslos passiert und Mining weiterhin profitabel bleibt, dann erwarte ich einen baldigen Preisanstieg, vor allem bei non-LHR Karten.

Tiefpunkt war vor einem Monat.

Oder was ist eure Meinung?

Wenn das mit 98% weniger Energieverbrauch stimmen sollte, bedeutet das automatisch, dass der Bedarf an Hobbyminern mit ihren Grakas massiv zurückgehen würde.

BJGucky

Urgestein

- Mitglied seit

- 22.05.2012

- Beiträge

- 1.478

- Desktop System

- Compblock

- Details zu meinem Desktop

- Prozessor

- Ryzen 9 9800X3D

- Mainboard

- MSI X870 Tomahawk Wifi

- Kühler

- Thermalright Phantom Spirit 120SE

- Speicher

- Corsair Vengeance 2x32GB 6000CL30

- Grafikprozessor

- MSI 5080 Surpim

- Display

- LG 42" C2 OLED

- SSD

- NVME: 960 Pro 512GB, SN850 1TB, 990 Evo Plus 2TB | Sata: 2x860 Evo 2TB, 870 QVO 8TB

- Soundkarte

- Shiit Modi 3E

- Gehäuse

- Fractal North

- Netzteil

- Corsair SF750

- Keyboard

- Wooting 80HE

- Mouse

- Logitech G502 Hero

- Betriebssystem

- Win 11 Pro

- Webbrowser

- Firefox

- Internet

- ▼109Mbit ▲42Mbit

3070 für 650€, 3070 Ti 750€. 3060Ti 550€, 3060 450€.und eine custom 3070 für maximal 550?

Man muss auch immer sehen wie gut die "alten" GPUs sind. z.b eine 2060 (non Super). Die 3060 ist vielleicht 30% besser und damals hat man die 2060 für 350€ bekommen.

Normalerweise bringt der Leistungszuwachs durch eine neue Generation keinen oder nur einen geringen Preisanstieg.

Um es mal ein Direkt vergleich zu nehmen: Wenn eine 2060 Non Super 350€ kostet, dann ist eine 3060 mit ca 30% mehr Leistung auch nur maximal 350€-400€ Wert.

Es geht ja nicht darum das man die Leistung bezahlt, sondern den materiellen Wert (inklusive Arbeit, etc.) der Karte.

Das man die (Mining-)Leistung der Karte bezahlt, ist ein Konstrukt der Miner, weil diese damit Geld verdienen. Es hat aber nichts mit Gaming zu tun, es wird ja z.b. das Powerlimit stark gedrosselt und hat nichts mehr damit zu tun, wofür die Karte eigentlich gedacht ist. In dem Sinne bin ich für eine 100% Bremse fürs Mining.

Einen kleinen Preisanstieg Generationsweise gab es immer mal, die GPUs sind auch größer und komplexer geworden. Aber nie wurde die Performance/Preis 1:1 in die nächste Generation mitgenommen.

Die 2000er Serie war teurer, weil man Raytracing vermarkten wollte und den Markt ausloten, wieviel man bereit ist zu zahlen. Aber auch hier ist der Preis der 2080 Ti der Preis der 3080 Ti und die 3080Ti hat mehr Leistung.

Die 3090 ist das verkorkste Kind/Marketing einer Titan Karte...

An alle die sagen das ist Utopie, denen kann ich nur sagen das es ansonsten in wenigen Generationen kein Gaming mehr am PC geben wird.

Alleine schon die Gerüchte, das die nächste Gen um ein vielfaches besser sein soll...will jemand für eine Top GPU auch >4000€ (die auch demensprechend 2-3mal die Leistung einer 3090 hat) oder mehr ausgeben?

Eine Handvoll Leute die zuviel Geld hat vielleicht, aber nicht der Rest. Und eine weitere Generationen später ist >4000€ der Preis für die kleinste GPU...

Das ist übrigends auch möglich wenn die next GPU Gen keine Bremse hat, dann werden die Preise wieder ums Vielfache steigen. Und dann wäre >4000€ für die Top GPUs warscheinlich schon nächstes Jahr der Fall.

Und 4060er nicht für unter 1000€ ^^

Jnnk12131

Enthusiast

Diese ganzen "ich denke", "ich erwarte", "ich glaube" Aussagen helfen hier leider keinem, ist reine Spekulation...

hans85

Experte

- Mitglied seit

- 22.03.2021

- Beiträge

- 4.259

- Desktop System

- Rüdiger

- Laptop

- nö

- Details zu meinem Desktop

- Prozessor

- 9900K

- Mainboard

- Gigabyte Z390 Aorus Master

- Kühler

- Corsair H150i

- Speicher

- Gigabyte 16GB Aorus Limited RGB DDR4-3600

- Grafikprozessor

- RTX 4090 FE

- Display

- AW3423DW

- SSD

- 2 x 1TB XPG GAMMIX S11 Pro

- HDD

- nö

- Opt. Laufwerk

- nö

- Soundkarte

- nö

- Gehäuse

- DARK BASE 700

- Netzteil

- Straight Power 11 Platinum 1000 Watt

- Keyboard

- Black Widow Ultimate

- Mouse

- Logitech MX Master 2S

- Betriebssystem

- Win10

- Webbrowser

- Feuerfuchs

- Internet

- ▼300 ▲300

Das verwechselst du mit ETH 2.0, welches auf Q1 22 verschoben wurde.Ich denke Mining für Hobbyminer kann nicht mehr profitabel als jetzt werden, eher noch weniger profitabel.

Wenn das mit 98% weniger Energieverbrauch stimmen sollte, bedeutet das automatisch, dass der Bedarf an Hobbyminern mit ihren Grakas massiv zurückgehen würde.

spyfly

Enthusiast

- Mitglied seit

- 21.05.2021

- Beiträge

- 6.089

- Ort

- Dresden

- Desktop System

- Gaming PC

- Laptop

- Framework Laptop | i7-1280P | 64 GB | 1 TB 980 Pro

- Details zu meinem Desktop

- Prozessor

- Intel i9 12900K | EK-Quantum Velocity

- Mainboard

- MSI MEG Z690I Unify

- Kühler

- Custom Loop | 2x HWLabs 280GTS | Aquacomputer Aqualis DDC 100 ml + DDC-1T plus PWM

- Speicher

- 2x32GB Crucial DDR5-4800

- Grafikprozessor

- NVIDIA GeForce RTX 4090 SG | Alphacool ES Geforce RTX 4090 Reference Design

- Display

- Asus PG27UQ + 2x LG 27UD68-W

- SSD

- Samsung PM9A1 2TB (PCIe 4.0 x4)

- Soundkarte

- FiiO K5 Pro ESS

- Gehäuse

- Winter One

- Netzteil

- Corsair SF750 Platinum

- Keyboard

- Corsair Strafe RGB

- Mouse

- Logitech G903 + Powerplay

- Betriebssystem

- Windows 11

- Webbrowser

- Brave

- Internet

- ▼180 ▲40

Aber machen 360 Hz vs 144 Hz einen so großen Unterschied?Also ich würde niemals freiwillig mit 144 oder 200 fps CS:GO, Valorant oder PUBG zocken, wenn ich auch 400-600 haben kann (bzw. in PUBG 200-300). Läuft damit deutlich smoother, zumal es ja schon 240 Hz und auch 360 Hz Monitore gibt (letzteren nutze ich für PUBG und CS:GO, für alle anderen Games den WQHD LG mit 144Hz.

Von 60 auf 144 Hz hat man ja eine Latenzreduktion von fast 10 ms. Das war für mich schon eine ziemlich spürbare Verbesserung. Seitdem hab ich durchaus das Gefühl, in CSGO die Köpfe öfter zu treffen

Bei 144 Hz auf 360 Hz sind es ja nur noch ein wenig über 4 ms weniger Latenz. Dafür die Auflösung von 4K auf 1080p zu droppen ist ja irgendwo schon ein ziemlicher Drawback

Aber als "Competitive" Gamer geht halt Wettbewerbsvorteil über Augenschmaus

Daher könnte ich es mir auch vorstellen, mir in Zukunft nen 480 Hz Monitor für CSGO zuzulegen

Daher könnte ich es mir auch vorstellen, mir in Zukunft nen 480 Hz Monitor für CSGO zuzulegen

in9enieur

Experte

- Mitglied seit

- 06.11.2020

- Beiträge

- 783

Die Gerüchte sagen auch, dass der Verbrauch auch sehr hoch sein wird (ähnlich oder sogar größer als bei Ampere)Alleine schon die Gerüchte, das die nächste Gen um ein vielfaches besser sein soll...will jemand für eine Top GPU auch >4000€ (die auch demensprechend 2-3mal die Leistung einer 3090 hat) oder mehr ausgeben?

Wenn mit einer Karte 300€ - 400€ pro Monat gemacht werden kann, dann kann es schon auch 3-4k€ kosten.

Beitrag automatisch zusammengeführt:

du meinst Q1 23Das verwechselst du mit ETH 2.0, welches auf Q1 22 verschoben wurde.

Mrickz2

Experte

- Mitglied seit

- 17.11.2020

- Beiträge

- 271

Aber machen 360 Hz vs 144 Hz einen so großen Unterschied?

Von 60 auf 144 Hz hat man ja eine Latenzreduktion von fast 10 ms. Das war für mich schon eine ziemlich spürbare Verbesserung. Seitdem hab ich durchaus das Gefühl, in CSGO die Köpfe öfter zu treffen

Bei 144 Hz auf 360 Hz sind es ja nur noch ein wenig über 4 ms weniger Latenz. Dafür die Auflösung von 4K auf 1080p zu droppen ist ja irgendwo schon ein ziemlicher Drawback

Aber als "Competitive" Gamer geht halt Wettbewerbsvorteil über AugenschmausDaher könnte ich es mir auch vorstellen, mir in Zukunft nen 480 Hz Monitor für CSGO zuzulegen

Nicht vergessen, dass "G4M3R" drauf steht und die RGB Lichterketter !

Spaß beiseite. Mehr ist so gesehen immer besser, irgendwann ist man natürlich so weit im Diminishing Return bereich, dass es schwierig ist den Unterschied zu merken. Damals als ich prof. CS 1.6 gespielt habe konnte ich locker 95fps und 100fps unterscheiden als ich jung und flink war ohne Probleme und man hat definitiv Vorteile mit höheren HZ und fps, ob der Unterschied zwischen 360 und 480hz spürbar ist vermag ich nicht zu sagen da ich es noch nicht getestet habe, aber solange die modernen Pro gamer dafür Werbung machen wird es sich verkaufen.

Ist die Frage ob in ein paar Jahren die Leute sagen "uff 480hz damit kannste nicht mehr spielen das ruckelt wie Sau, man braucht 960hz".

Aber höhere fps und hz können kein Nachteil sein, ob Leute die ein bisschen daddeln das dann tatsächlich brauchen ist die andere Sache.

AzRa-eL

Experte

Geht mir genauso. Ist leider aber auch ein Fluch, wenn man sich einmal daran gewöhnt hat.Wenn man mal auf dem den LG 27GN950, 4K @ 160 Hz Monitor gespielt hat, sehen kleinere Auflösungen aus wie PiPixelmatsch.

Weil ich zbsp. nicht auf niedrigere Matsch-Auflösungen mehr gehen kann, musste ich Details runterschrauben, um meine 60fps zu halten. Irgendwann war ich mit 50, dann mit 40fps einverstanden. Der Hardwarehunger ist halt enorm, um konstant UHD/60fps zu halten. Guck dann schon neidisch zu Leuten rüber, denen schon 60/70er Karten reichen, um ihr WQHD System zu befeuern.

Würde eigentlich gerne auch mal auf UHD/144Hz gehen, aber GPUs, die das gut stemmen können, bei aktuelleren Titeln gibt es halt noch nicht wirklich.

2k5lexi

Lars Christmas

- Mitglied seit

- 29.03.2010

- Beiträge

- 43.516

- Ort

- Ostallgäu

- Laptop

- Thinkpad T450S

- Details zu meinem Desktop

- Prozessor

- Ryzen 3600

- Mainboard

- MSI B550-A Pro

- Kühler

- Noctua D15

- Speicher

- 2x16GB Corsair LPX @3800MHz

- Grafikprozessor

- Palit GeForce RTX 4070 GamingPro

- Display

- Gigabyte M27Q

- SSD

- Samsung 950 pro 256GB, Kingston KC3000 2TB

- Opt. Laufwerk

- LG DVD Brenner

- Soundkarte

- onboard

- Gehäuse

- Fractal Design Pop Air solid black

- Netzteil

- Seasonic Focus PX-550

- Keyboard

- Logitech K400

- Mouse

- Logitech M705

- Betriebssystem

- Win10 x64

- Webbrowser

- Firefox

- Sonstiges

- Turtle Beach Stealth 600 G2

- Internet

- ▼120 mbit ▲5 mbit

Alle 100 Seiten zettelst du die gleiche Diskussion an?3070 für 650€, 3070 Ti 750€. 3060Ti 550€, 3060 450€.

Staubor

Experte

- Mitglied seit

- 10.12.2020

- Beiträge

- 2.263

- Ort

- s Elsàss

- Desktop System

- Abstaubor

- Laptop

- Razer Blade 14 2021 (RTX 3070)

- Details zu meinem Desktop

- Prozessor

- Ryzen 9 5900X

- Mainboard

- ROG Crosshair VIII Dark Hero

- Kühler

- EK-Quantum Velocity

- Speicher

- 32GB 3600er Trident RGB

- Grafikprozessor

- GIGABYTE RTX 5080 WATERFORCE WB

- Display

- Alienware AW3821DW | Dell U2722DE

- SSD

- Samsung 980 Pro

- Gehäuse

- BeQuiet DarkBase Pro 900

- Netzteil

- BeQuiet Straight Power Platinum 1000W

- Keyboard

- Logitech G915

- Mouse

- Logitech G902 | Razer Naga Lefthand Edition

- Betriebssystem

- Windows 10

- Internet

- ▼2.000 Mbit ▲800 Mbit

Das ist leider auch ein Optimierungsproblem. Mit meiner 3090 @ stock schaffe ich in Doom Eternal mit Raytracing auf 4k alle Details auf Max und HDR on, 80-100 FPS dauerhaft. Das macht dann in Verbindung mit GSync schon gut Spaß. Den meisten Entwicklern ist das Feintuning einfach zu teuer.Würde eigentlich gerne auch mal auf UHD/144Hz gehen, aber GPUs, die das gut stemmen können, bei aktuelleren Titeln gibt es halt noch nicht wirklich.

spyfly

Enthusiast

- Mitglied seit

- 21.05.2021

- Beiträge

- 6.089

- Ort

- Dresden

- Desktop System

- Gaming PC

- Laptop

- Framework Laptop | i7-1280P | 64 GB | 1 TB 980 Pro

- Details zu meinem Desktop

- Prozessor

- Intel i9 12900K | EK-Quantum Velocity

- Mainboard

- MSI MEG Z690I Unify

- Kühler

- Custom Loop | 2x HWLabs 280GTS | Aquacomputer Aqualis DDC 100 ml + DDC-1T plus PWM

- Speicher

- 2x32GB Crucial DDR5-4800

- Grafikprozessor

- NVIDIA GeForce RTX 4090 SG | Alphacool ES Geforce RTX 4090 Reference Design

- Display

- Asus PG27UQ + 2x LG 27UD68-W

- SSD

- Samsung PM9A1 2TB (PCIe 4.0 x4)

- Soundkarte

- FiiO K5 Pro ESS

- Gehäuse

- Winter One

- Netzteil

- Corsair SF750 Platinum

- Keyboard

- Corsair Strafe RGB

- Mouse

- Logitech G903 + Powerplay

- Betriebssystem

- Windows 11

- Webbrowser

- Brave

- Internet

- ▼180 ▲40

Dann stell dir mal vor welchen Spaß ich vor nem Jahr hatte, meinen 4K 144 Hz Monitor mit ner Titan Xp zu befeuern, als die 3000er Serie noch nicht draußen war.Geht mir genauso. Ist leider aber auch ein Fluch, wenn man sich einmal daran gewöhnt hat.

Weil ich zbsp. nicht auf niedrigere Matsch-Auflösungen mehr gehen kann, musste ich Details runterschrauben, um meine 60fps zu halten. Irgendwann war ich mit 50, dann mit 40fps einverstanden. Der Hardwarehunger ist halt enorm, um konstant UHD/60fps zu halten. Guck dann schon neidisch zu Leuten rüber, denen schon 60/70er Karten reichen, um ihr WQHD System zu befeuern.

Also CS:GO ging natürlich problemlos mit ca. 200 FPS, aber bei Dota 2 dümpelte die Karte immer bei 120-140 FPS rum, immerhin ohne Ruckler, G-SYNC Ultimate sein Dank.

PUBG war da schon eher problematisch, aber mit ein paar Abstrichen lief das auch um die 80-100 FPS.

Die Lösung nennt sich DLSS, zumindest wenn man auch noch mit Raytracing aktiv spielen möchte. Bei anspruchsvolleren Titeln muss man sich halt mit um die 60-100 FPS zufrieden geben, für Augenschmaus-Spiele reicht das allemal.Würde eigentlich gerne auch mal auf UHD/144Hz gehen, aber GPUs, die das gut stemmen können, bei aktuelleren Titeln gibt es halt noch nicht wirklich.

Also alles ab der 3080 ist halt irgendwo 4K HFR tauglich.

AzRa-eL

Experte

Stimmt! Weiß nicht ob es an der ID Engine liegt, aber selbst mit meiner 1080 ti läuft das Spiel auf max out immer noch mega geschmeidig. Daran können sich gerne andere mal ein oder zwei Scheiben abschneiden.Das ist leider auch ein Optimierungsproblem. Mit meiner 3090 @ stock schaffe ich in Doom Eternal mit Raytracing auf 4k alle Details auf Max und HDR on, 80-100 FPS dauerhaft. Das macht dann in Verbindung mit GSync schon gut Spaß Den meisten Entwicklern ist das Feintuning einfach zu teuer.

Wenn man nur aktuelle Titel spielen möchte und alles auf Ultra gestellt, dann kann man etvtl. mit einer passenden GPU Probleme kriegen, wobei eine 3090 oder 3080 TI trotzdem mit ein paar reduzierten Einstellungen locker reichen würden.Geht mir genauso. Ist leider aber auch ein Fluch, wenn man sich einmal daran gewöhnt hat.

Weil ich zbsp. nicht auf niedrigere Matsch-Auflösungen mehr gehen kann, musste ich Details runterschrauben, um meine 60fps zu halten. Irgendwann war ich mit 50, dann mit 40fps einverstanden. Der Hardwarehunger ist halt enorm, um konstant UHD/60fps zu halten. Guck dann schon neidisch zu Leuten rüber, denen schon 60/70er Karten reichen, um ihr WQHD System zu befeuern.

Würde eigentlich gerne auch mal auf UHD/144Hz gehen, aber GPUs, die das gut stemmen können, bei aktuelleren Titeln gibt es halt noch nicht wirklich.

Für leute, die auch ältere Spiele zocken und vor allem Online Shooter Spiele wie BF, COD, Warzone, Apex Legends, PUBG etc. gibt es derzeit nichts besseres als einen 4K 144Hz Monitor oder den 160 Hz LG 27GN950B.

Ich hatte mehr erwartet von den 360 Hz Monitoren, also der Unterschied zu 160 Hz war jetzt nicht deutlich zu merken im Spiel direkt, das Bild war flüssiger aber nicht deutlich flüssiger. Die deutlich matschigere PPI war allerdings schon sehr störend, das sah alles verpixelt aus ohne ende und unscharf.

Das ist wie bei Smartphones, wenn man Retina Displays (und höher als Retina) mit den ersten Smartphone Displays vergleichen würde, welche eine Auflösung von 360x250 Pixeln hatten (oder so), das kann man sich auch nicht mehr ernsthaft antun.

IMO der Sprung von 60 Hz auf 144 Hz ist sehr deutlich, von 144 Hz auf 240+ Hz dann nicht mehr so heftig, man merkt diesen Sprung nicht so deutlich. Die Auflösung von 1080p -> 1440p -> 4k merkt man aber mehr als deutlich.

AzRa-eL

Experte

Wie empfindest du die Widescreen Auflösung? 3440×1440 müsste das sein.Für leute, die auch ältere Spiele zocken und vor allem Online Shooter Spiele wie BF, COD, Warzone, Apex Legends, PUBG etc. gibt es derzeit nichts besseres als einen 4K 144Hz Monitor oder den 160 Hz LG 27GN950B.

Um ehrlich zu sein, liebäugele ich gerade mit dem Dell Alienware 38", bin mir nur halt nicht sicher, ob es nicht zu matschig für mein Empfinden wird. Vorteil wäre, dass man durch die weniger Bildpunkte mehr Ressourcen frei schaufelt.

hans85

Experte

- Mitglied seit

- 22.03.2021

- Beiträge

- 4.259

- Desktop System

- Rüdiger

- Laptop

- nö

- Details zu meinem Desktop

- Prozessor

- 9900K

- Mainboard

- Gigabyte Z390 Aorus Master

- Kühler

- Corsair H150i

- Speicher

- Gigabyte 16GB Aorus Limited RGB DDR4-3600

- Grafikprozessor

- RTX 4090 FE

- Display

- AW3423DW

- SSD

- 2 x 1TB XPG GAMMIX S11 Pro

- HDD

- nö

- Opt. Laufwerk

- nö

- Soundkarte

- nö

- Gehäuse

- DARK BASE 700

- Netzteil

- Straight Power 11 Platinum 1000 Watt

- Keyboard

- Black Widow Ultimate

- Mouse

- Logitech MX Master 2S

- Betriebssystem

- Win10

- Webbrowser

- Feuerfuchs

- Internet

- ▼300 ▲300

schau doch mal online nach einem ppi Rechner. 38" ist halt schon wieder sehr groß, da besteht Matschgefahr.Wie empfindest du die Widescreen Auflösung? 3440×1440 müsste das sein.

Um ehrlich zu sein, liebäugele ich gerade mit dem Dell Alienware 38", bin mir nur halt nicht sicher, ob es nicht zu matschig für mein Empfinden wird. Vorteil wäre, dass man durch die weniger Bildpunkte mehr Ressourcen frei schaufelt.

AzRa-eL

Experte

Mir ging es weniger um die reine Rechnung der ppi, sondern um die subjektive Wahrnehmung von Clutchschau doch mal online nach einem ppi Rechner. 38" ist halt schon wieder sehr groß, da besteht Matschgefahr.

Jnnk12131

Enthusiast

Also für ne 3080 zahl ich nicht mehr als 699€...

Generell finde ich dass so ein Monitor (Ultrawide 21:9) zum Zocken besser geeignet ist, auch für competitive Online Shooter. Durch die zusätzlichen Bildinformationen auf der horizontalen, müsste man das FOV nicht so stark erhöhen wie bei 16:9 für die optimale Übersicht. Wenn man FOV zu stark erhöht, werden die Objekte im Spiel kleiner, bei einem 21:9 Monitor müsste man das FOV nicht so aufdrehen, d. h. die Objekte wie Player Models wären etwas größer mit dennoch guter Übersicht auf der horizontalen links+rechts.Wie empfindest du die Widescreen Auflösung? 3440×1440 müsste das sein.

Um ehrlich zu sein, liebäugele ich gerade mit dem Dell Alienware 38", bin mir nur halt nicht sicher, ob es nicht zu matschig für mein Empfinden wird. Vorteil wäre, dass man durch die weniger Bildpunkte mehr Ressourcen frei schaufelt.

Das einzige Problem an den aktuellen Ultrawidescreen Monitoren ist wie du schon angesprochen hast- es besteht eine Bandbreitenlimitierung der DP 1.4 Schnittstelle, welche entweder durch geringere Auflösung oder geringere Hz Zahl der Monitore kompensiert werden muss. Deshalb find ich diese Monitore aktuell noch uninteressant.

Ab Display Port 2.0, sollte da höhere Pixeldichte @ 160+ Hz möglich sein und dann werde ich mir wahrsch. einen Ultrawide Monitor holen aber NICHT gekrümmt. Idealerweise wären bis dahin Ultrawide OLED Monitore erhältlich. Aber auch da gilt- man muss einen Sweetspot der Größe finden für die optimale competitive Gaming Erfahrung. ISt der Ultrawide Monitor zu riesig- find ich das eher kontraproduktiv für competitive Spiele. Also ab 40 Zoll ist das dann mehr was für single player spiele und solche die nicht super competitive sind.

Ich finde einen 27" oder 28" 16:9 Monitor ideal von den Maßen her (Bildschirmhöhe ca 34-35 cm.) mit Auflösung 4K oder höher für competitive online Spiele. Bei einem 21:9 Monitor wären das 34 oder 35 Zoll mit der gleichen Bildschirmhöhe. Alles drüber wird zu groß, dass man alles im Blick behält ohne den kopf viel hin und her drehen zu müssen.

Zuletzt bearbeitet:

Die UVP (FE) ist ja 719€ excl. Versandkosten, also viel ErfolgAlso für ne 3080 zahl ich nicht mehr als 699€...

Mrickz2

Experte

- Mitglied seit

- 17.11.2020

- Beiträge

- 271

Die UVP (FE) ist ja 719€ excl. Versandkosten, also viel Erfolg

Der Witz

Dein Kopf

hans85

Experte

- Mitglied seit

- 22.03.2021

- Beiträge

- 4.259

- Desktop System

- Rüdiger

- Laptop

- nö

- Details zu meinem Desktop

- Prozessor

- 9900K

- Mainboard

- Gigabyte Z390 Aorus Master

- Kühler

- Corsair H150i

- Speicher

- Gigabyte 16GB Aorus Limited RGB DDR4-3600

- Grafikprozessor

- RTX 4090 FE

- Display

- AW3423DW

- SSD

- 2 x 1TB XPG GAMMIX S11 Pro

- HDD

- nö

- Opt. Laufwerk

- nö

- Soundkarte

- nö

- Gehäuse

- DARK BASE 700

- Netzteil

- Straight Power 11 Platinum 1000 Watt

- Keyboard

- Black Widow Ultimate

- Mouse

- Logitech MX Master 2S

- Betriebssystem

- Win10

- Webbrowser

- Feuerfuchs

- Internet

- ▼300 ▲300

Ich bin mit dem LG UltraGear 34GN850-B sehr zufrieden, mein Traum wäre allerdings ein 21:9 34" OLED mit 5.120 x 2.160 Pixeln. 😍Generell finde ich dass so ein Monitor (Ultrawide 21:9) zum Zocken besser geeignet ist, auch für competitive Online Shooter. Durch die zusätzlichen Bildinformationen auf der horizontalen, müsste man das FOV nicht so stark erhöhen wie bei 16:9 für die optimale Übersicht. Wenn man FOV zu stark erhöht, werden die Objekte im Spiel kleiner, bei einem 21:9 Monitor müsste man das FOV nicht so aufdrehen, d. h. die Objekte wie Player Models wären etwas größer mit dennoch guter Übersicht auf der horizontalen links+rechts.

Das einzige Problem an den aktuellen Ultrawidescreen Monitoren ist wie du schon angesprochen hast- es besteht eine Bandbreitenlimitierung der DP 1.4 Schnittstelle, welche entweder durch geringere Auflösung oder geringere Hz Zahl der Monitore kompensiert werden muss. Deshalb find ich diese Monitore aktuell noch uninteressant.

Ab Display Port 2.0, sollte da höhere Pixeldichte @ 160+ Hz möglich sein und dann werde ich mir wahrsch. einen Ultrawide Monitor holen aber NICHT gekrümmt. Idealerweise wären bis dahin Ultrawide OLED Monitore erhältlich. Aber auch da gilt- man muss einen Sweetspot der Größe finden für die optimale competitive Gaming Erfahrung. ISt der Ultrawide Monitor zu riesig- find ich das eher kontraproduktiv für competitive Spiele. Also ab 40 Zoll ist das dann mehr was für single player spiele und solche die nicht super competitive sind.

Ich finde einen 27" oder 28" 16:9 Monitor ideal von den Maßen her (Bildschirmhöhe ca 34-35 cm.) für competitive online Spiele. Bei einem 21:9 Monitor wären das 34 oder 35 Zoll mit der gleichen Bildschirmhöhe. Alles drüber wird zu groß, dass man alles im Blick behält ohne viel den kopf hin und her drehen zu müssen.

Ja das käme schon sehr nah ran an einen perfekten allrounder Monitor mit 5K Auflösung @ 200+ Hz, 34" 21:9 OLED oder MicroLED. Danach bräuchte man den Monitor nie wieder upzugraden.Ich bin mit dem LG UltraGear 34GN850-B sehr zufrieden, mein Traum wäre allerdings ein 21:9 34" OLED mit 5.120 x 2.160 Pixeln. 😍

Außer wenn mal 8K Auflösung kommt bzw. in dem Fall dann 9K oder 10K für Ultrawide, damit 8K 16:9 Content ohne Skalierung Pixelgenau dargestellt werden kann auf dem Ultrawide 21:9 Monitor.

Außer wenn mal 8K Auflösung kommt bzw. in dem Fall dann 9K oder 10K für Ultrawide, damit 8K 16:9 Content ohne Skalierung Pixelgenau dargestellt werden kann auf dem Ultrawide 21:9 Monitor.- Mitglied seit

- 11.03.2007

- Beiträge

- 27.575

- Ort

- München

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 9800X3D @ 5,4 GHz

- Mainboard

- ASUS ROG Strix X870-F Gaming WIFI

- Kühler

- NZXT Kraken X73 RGB

- Speicher

- 32GB Corsair Vengeance DDR5 @ 6200 MHz CL28

- Grafikprozessor

- NVIDIA GeForce RTX 4090 Founders Edition

- Display

- Alienware AW2723DF @ 280 Hz

- SSD

- Western Digital WD_BLACK SN850X NVMe SSD 2TB

- Soundkarte

- Beyerdynamic T5p @ Beyerdynamic USB-DAC

- Netzteil

- Seasonic Prime TX-1000W

Wenn du Ausgabe Hardware dafür hast, dann ist das durchaus möglich. Was hälst du davon auf einem stinknormalen 60fps LCD >60fps anzeigen zu lassen bzw von Techniken wie G/Freesync? Gibt ja genug Spezialisten die darin einen Vorteil sehen.

Ich halte es für eSport Titel durchaus sinnvoll bzw. essentiell wichtig trotzdem mehr Fps als Hz zu haben, zumindest bis zur Tickrate des Servers (in CS:GO abseits vom Matchmaking in allen Ligen 128), da sonst die Inputs quasi verzögert gesendet werden und verzögert verarbeitet werden (was bei 60 fps zu 128 tick einfach mal 100% Verzögerung wären).

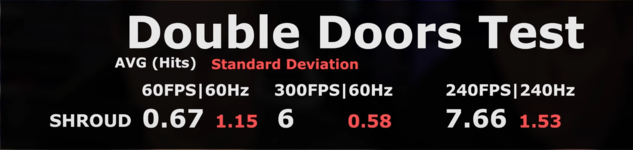

Passend dazu auch die Stelle im Video von Linus mit shroud... er empfindet es genau wie ich. Alleine die zusätzlichen Fps (auch ohne zusätzliche Hz) führen dazu dass sich das Game deutlich direkter und smoother anfühlt. Für mich fühlen sich low Fps, unabhängig von den Hz, immer so an als hätte ich Honig oder Kleber auf dem Mauspad, als wäre die Maus immer krass hinterher. Besser kann ich es nicht beschreiben. Auch die CS:GO Ergebnisse sprechen hier eine ganz klare Sprache:

Mit 60/60 trifft er nicht mal 10% der durchspringenden Gegner am Schlitz, mit 300 fps @ 60 Hz schon 60% der Gegner (ist ne krasse Verbesserung) und mit 240/240 dann 76%.

Adaptive Sync nehme ich daher persönlich als eine verbesserte V-SYNC Technik ohne Tearing oder Input Lag, ist bei mir in Solo Games immer an und in eSport Titeln immer aus (habe es in eSport Titeln ausprobiert und obwohl es keinen messbaren Inputlag erzeugt, empfinde ich die Spiele ohne G-SYNC und FPS Cap noch als "direkter" und angenehmer.

So ein hoch und runter Gejuchel der FPS macht dich in VR ganz schnell kirre, auch wenn ASW in der Regel ganz gute Ergebnisse liefert.

Da bin ich ganz bei dir, es gibt nichts schlimmeres als große FPS Drops, gerade bei VR. Da hätte ich dann lieber auch weniger Fps/Hz und die dafür stabil.

Mir wäre es wichtiger kein Tearing zu haben. Wie sieht das ein competitive Gamer, lieber Tearing und dafür 100fps auf nem 60fps Monitor?

Ja, V-SYNC immer aus und soviel Fps wie gehen. Zumal Tearing ja je mehr Fps man hat (desto schneller refresht das Panels das Bild) immer weniger wird und ab 300-400 fps nehme ich es gar nicht mehr wahr.

Aber machen 360 Hz vs 144 Hz einen so großen Unterschied?

Gar nicht so einfach das zu beantworten ^^ So krass wie der Unterschied wenn man von 60 Hz auf 144 Hz wechselt ist es natürlich nicht, eher nice to have. Als ich den Wechsel vollzogen habe fiel mir eigentlich primär auf, dass ich bei schnellen Turns im Spiel (90- oder 180°-Drehungen usw.) alles super scharf sehen konnte, vergleichbar mit der DyAc Technik bei BenQ. Das ist für Situationen, in denen man von seitwärts oder hinten beschossen wird ein klarer Vorteil und erleichtert das Spotten und die (hoffentlich) folgenden Flickshots enorm. Eigentlich so wie damals mit der guten alten Röhre, für die Leute, die sich noch erinnern

Aber ansonsten ist es keine weltbewegende Erfahrung, eher "nice to have" und ein kleiner Vorteil. Interessanterweise merkt man beim Wechsel von 360 Hz zurück auf 144 Hz komischerweise mehr davon (kommt einem die ersten Minuten, sogar im Windows beim schnellen Bewegen von Fenster usw. 144 Hz nicht mehr 100% smooth vor) mehr als man beim Wechsel von 144 Hz auf 360 Hz merkt (da kommt es einem smoother vor, ja, aber man denkt eben das 144 Hz davor auch schon smooth waren). Aber an 144 Hz gewöhnt man sich sehr schnell wieder, während ich 60 Hz sogar zum Arbeiten als ekelhaft empfinde (zumindest wenn man viel scrollt und oft Fenster bewegt).

Wobei ich mit Anfang 30 auch nicht mehr der jüngste bin, mein damaliges 18 jähriges (semi-pro) Ich könnte da vermutlich noch deutlich mehr Vorteil daraus ziehen. Bei https://humanbenchmark.com/tests/reactiontime bin ich mit 360 Hz z.B. bei 164-169ms und mit 144 Hz bei 178-185ms - nach unten hin limitiert leider meine Physiologie (heutige Pro Gamer im Alter von 16-25 machen da teilweise 130-150 ms) - wobei 16x ms zum Glück auch noch okay ist (reicht auch trotz des Alters immer noch für 5er K/D in PUBG und Global im MM bzw. zuletzt Master @Faceit in CS:GO).

Guck dann schon neidisch zu Leuten rüber, denen schon 60/70er Karten reichen, um ihr WQHD System zu befeuern.

Also mir ist die 3090 selbst für WQHD noch zu lahm. Wenn ich dann auf dem 4K LG OLED spielen will bin ich mit runtergedrehten Settings bei 20-30 Fps bei Krachern wie Cyberpunk usw... Da spiele ich dann lieber auf WQHD am Monitor, obwohl Zocken aufm 65" OLED schon echt Spaß macht ^^

Für meine Ansprüche (genug Fps und fast maximale Details in den Solo Games) wird vermutlich erst die 5080/5090 die erste brauchbare 4K Karte

Zuletzt bearbeitet:

Trinitus

Urgestein

Wenn du einen Monitor suchst und du dich mit Motion Blur befasst... Viel Spaß bei der Monitorsuche bzw. auf folgender Seite Motion Blur / GhostingDas mit den Drehungen ist interessant. Ich hasse ja motion blur wie die Pest

Mrickz2

Experte

- Mitglied seit

- 17.11.2020

- Beiträge

- 271

Wenn du einen Monitor suchst und du dich mit Motion Blur befasst... Viel Spaß bei der Monitorsuche bzw. auf folgender Seite Motion Blur / Ghosting

Yo atm läuft der 144hz IPS 27'' 1440p noch, aber irgendwann muss dann 4K OLED HDR high refresh rate irgendwas her, aber Preise müssen erstmal drastisch rutnergehen und massenadoption sehen.

Swimlanes

Profi

Ich will mich mit 4k gar nicht erst versauen und bleibe erstmal noch auf meinen 1440p, damit ich entsprechende Frames bekomme

Ähnliche Themen

- Antworten

- 7

- Aufrufe

- 2K

- Antworten

- 2

- Aufrufe

- 570

- Antworten

- 0

- Aufrufe

- 459