- Mitglied seit

- 10.05.2006

- Beiträge

- 5.654

- Details zu meinem Desktop

- Prozessor

- Ryzen 7 5800X3D @150 W

- Kühler

- Noctua NH-D15 G2

- Speicher

- 32 GB DDR4

- Grafikprozessor

- PNY 3090 @3x Noctua NF-A9

- Display

- LG OLED42C29LB

- SSD

- Samsung 990 Pro 2TB || Evo 850 4TB || PM981a 1TB

- Soundkarte

- SoundBlaster X7 LE

- Gehäuse

- Jonsbo Z20W

- Netzteil

- Corsair SF750

- Keyboard

- Cherry KW X ULP

- Mouse

- Razer Viper Ultimate

- Sonstiges

- Ora Funky Cat 400 Pro

- Internet

- ▼100 ▲40

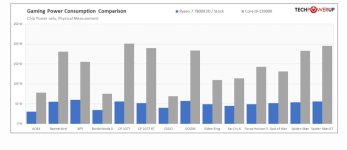

Ich mache mir die Welt, wie sie mir gefällt. 😂Ich habe Benchmark Tabellen gesehen wo der 5800X3D schlechter als ein 5800X ist. Deshalb wurde auch der 5800X schon verkauft. Rest wird hoffentlich bis Herbst den Besitzer wechseln. Der 5800X oder 5800X3D sind für mich fürs Gaming und für die Gnu Gentoo Linux Toolchain hoffnungslos veraltet. Der 3D Prozessor ist oft schon eine Krücke. Ein Allrounder ist der 3D Prozessor für mich nicht, ein 5800X3D ist ein downgrade sehr oft wenn man schon einen 5800X hatte. Persönlich derzeit, tendiere ich zu einem 7600X - der etwa gleichauf liegt wie der 5800X.

Beitrag automatisch zusammengeführt:

2023 wird das Jahr des idle Verbrauchs. Millionen von Intelianern kaufen sich die neueste CPU um sie nicht zu nutzen. Die laufen den ganzen Tag, aber werden nicht genutzt. Stattdessen sitzt man davor und freut sich darüber, dass man umso mehr spart, je länger das Teil läuft und nichts tut. 😂Ja aber was für Intel spricht ist der bessere idle Verbrauch

Zuletzt bearbeitet: