Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

-

Hardwareluxx führt derzeit die Hardware-Umfrage 2025 (mit Gewinnspiel) durch und bittet um eure Stimme.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

[Sammelthread] Dell EMC PowerEdge T40

- Ersteller Janero

- Erstellt am

- Mitglied seit

- 07.08.2012

- Beiträge

- 4.365

- Ort

- Raum Stuttgart

- Laptop

- Lenovo IdeaPad 14"

- Details zu meinem Desktop

- Prozessor

- AMD 5900x

- Mainboard

- ASUS ROG Strix B550-E

- Kühler

- Noctua NH-D15

- Speicher

- 2x16GB 3600CL14

- Grafikprozessor

- AMD Ref. 6900XT

- Display

- Dell 2721DGF 27" WQHD, Philips 275E 27" WQHD

- SSD

- Samsung 2TB EVO+

- Soundkarte

- Tascam 102i, DT990 Pro, SM7b

- Gehäuse

- Fractal Meshify C

- Netzteil

- Seasonic Focus PX 850W

- Keyboard

- Logitech MX Keys

- Mouse

- Logitech MX Master3

- Betriebssystem

- Win10Pro

- Internet

- ▼1000 Mbit ▲500 Mbit

Noch n Haken beim Arbeitsspeicher setzen.

'Gesamten Gastarbeitsspeicher reservieren (Alle gesperrt)'

'Gesamten Gastarbeitsspeicher reservieren (Alle gesperrt)'

-VBS deaktiviert

-Hardwaregestützte Virtualisierung für das Gastbetriebssystem bereitstellen deaktiviert

-Gesamten Gastarbeitsspeicher reserviert

keine Fehlermeldungen im ESXi

Ich war schon Siegessicher

Windows 10 VM geht nach dem Laderädchen aber wieder in den zustand ausgeschaltet. 🤬

Hab leider auch keine Fehlermeldung nach der ich googeln könnte.

Hätte ich durch das deaktivieren der Hardwaregestützte Virtualisierung nicht sowiso erhebliche Performance Einbußen?

sodass ich mit einem zusätzlichem Controller sowieso besser fahren würde?

-Hardwaregestützte Virtualisierung für das Gastbetriebssystem bereitstellen deaktiviert

-Gesamten Gastarbeitsspeicher reserviert

keine Fehlermeldungen im ESXi

Ich war schon Siegessicher

Windows 10 VM geht nach dem Laderädchen aber wieder in den zustand ausgeschaltet. 🤬

Hab leider auch keine Fehlermeldung nach der ich googeln könnte.

Hätte ich durch das deaktivieren der Hardwaregestützte Virtualisierung nicht sowiso erhebliche Performance Einbußen?

sodass ich mit einem zusätzlichem Controller sowieso besser fahren würde?

- Mitglied seit

- 07.08.2012

- Beiträge

- 4.365

- Ort

- Raum Stuttgart

- Laptop

- Lenovo IdeaPad 14"

- Details zu meinem Desktop

- Prozessor

- AMD 5900x

- Mainboard

- ASUS ROG Strix B550-E

- Kühler

- Noctua NH-D15

- Speicher

- 2x16GB 3600CL14

- Grafikprozessor

- AMD Ref. 6900XT

- Display

- Dell 2721DGF 27" WQHD, Philips 275E 27" WQHD

- SSD

- Samsung 2TB EVO+

- Soundkarte

- Tascam 102i, DT990 Pro, SM7b

- Gehäuse

- Fractal Meshify C

- Netzteil

- Seasonic Focus PX 850W

- Keyboard

- Logitech MX Keys

- Mouse

- Logitech MX Master3

- Betriebssystem

- Win10Pro

- Internet

- ▼1000 Mbit ▲500 Mbit

Hatte testweise auch den Chipsatz-Sata Controller des T40 auf ne Win10 VM durchgereicht.

Gibt ebenso crash, blackscreen und aus.

Scheint also ein generelles Problem zu sein.

FreeNas laeuft hingegen wunderbar mit dem durchgereichtem PCH.

Gibt ebenso crash, blackscreen und aus.

Scheint also ein generelles Problem zu sein.

FreeNas laeuft hingegen wunderbar mit dem durchgereichtem PCH.

Ich such grad für mich nach einer anderweitigen Lösung.

Ich brauch tatsächlich keine High Performance bei den beiden Platten.

Hier geht es tatsächlich nur darum alte Bilder/Dokumente dauerhaft ausfallsicher abzuspeichern.

(wenige Zugriffe im Jahr)

Ein HW Raidcontroller der sich alleine im IDLE knapp 10w reinzieht ist also unsinn.

Bin grad beim googeln auf Storage Spaces gestoßen.

Könnte es klappen die Platten per RDM durchzureichen und dann im Win10 ein StorageSpace einzurichten?

Ich brauch tatsächlich keine High Performance bei den beiden Platten.

Hier geht es tatsächlich nur darum alte Bilder/Dokumente dauerhaft ausfallsicher abzuspeichern.

(wenige Zugriffe im Jahr)

Ein HW Raidcontroller der sich alleine im IDLE knapp 10w reinzieht ist also unsinn.

Bin grad beim googeln auf Storage Spaces gestoßen.

Könnte es klappen die Platten per RDM durchzureichen und dann im Win10 ein StorageSpace einzurichten?

- Mitglied seit

- 07.08.2012

- Beiträge

- 4.365

- Ort

- Raum Stuttgart

- Laptop

- Lenovo IdeaPad 14"

- Details zu meinem Desktop

- Prozessor

- AMD 5900x

- Mainboard

- ASUS ROG Strix B550-E

- Kühler

- Noctua NH-D15

- Speicher

- 2x16GB 3600CL14

- Grafikprozessor

- AMD Ref. 6900XT

- Display

- Dell 2721DGF 27" WQHD, Philips 275E 27" WQHD

- SSD

- Samsung 2TB EVO+

- Soundkarte

- Tascam 102i, DT990 Pro, SM7b

- Gehäuse

- Fractal Meshify C

- Netzteil

- Seasonic Focus PX 850W

- Keyboard

- Logitech MX Keys

- Mouse

- Logitech MX Master3

- Betriebssystem

- Win10Pro

- Internet

- ▼1000 Mbit ▲500 Mbit

Wieso nicht einfach ne ZFS VM dafür verwenden?

Eignet sich sowieso deutlich besser wenn man Daten robust abspeichern möchte.

Eignet sich sowieso deutlich besser wenn man Daten robust abspeichern möchte.

- Mitglied seit

- 07.08.2012

- Beiträge

- 4.365

- Ort

- Raum Stuttgart

- Laptop

- Lenovo IdeaPad 14"

- Details zu meinem Desktop

- Prozessor

- AMD 5900x

- Mainboard

- ASUS ROG Strix B550-E

- Kühler

- Noctua NH-D15

- Speicher

- 2x16GB 3600CL14

- Grafikprozessor

- AMD Ref. 6900XT

- Display

- Dell 2721DGF 27" WQHD, Philips 275E 27" WQHD

- SSD

- Samsung 2TB EVO+

- Soundkarte

- Tascam 102i, DT990 Pro, SM7b

- Gehäuse

- Fractal Meshify C

- Netzteil

- Seasonic Focus PX 850W

- Keyboard

- Logitech MX Keys

- Mouse

- Logitech MX Master3

- Betriebssystem

- Win10Pro

- Internet

- ▼1000 Mbit ▲500 Mbit

2. Ich hatte beim T30 auch keinen Erfolg mit dem durchreichen des SATA controllers (an OmniOS).

Wie gesagt.

T40:

Win10 = Crash

FreeNas = Läuft

Für einen großen Datenhafen wäre deine FreeNas Variante bestimmt die beste.

Ich wollte jedoch keinen weiteren Ram Opfern und für die seltenen Zugriffe ist die StorageSpaces Lösung bestimmt nicht die schlechteste.

Zusammengefasst falls jemand ähnliche Probleme hat und es so umsetzen möchte:

1. Beide Barracudas per RDM an ESXi durchgereicht ( https://www.thomas-krenn.com/de/wiki/Raw_Device_Mapping_(RDM)_Festplatte_in_VMware_erstellen )

2. Festplatten mit der Windows Datenträgerverwaltung Partitionieren und Formatieren

3. StorageSpace erstellen ( https://it-learner.de/storage-spaces-in-windows-10/ )

🙏🙏🙏🙏🙏🙏🙏🙏🙏

und dickes Dankeschön, ohne euch hätte mich das noch einige stunden mehr gekostet ^^

Ich wollte jedoch keinen weiteren Ram Opfern und für die seltenen Zugriffe ist die StorageSpaces Lösung bestimmt nicht die schlechteste.

Zusammengefasst falls jemand ähnliche Probleme hat und es so umsetzen möchte:

1. Beide Barracudas per RDM an ESXi durchgereicht ( https://www.thomas-krenn.com/de/wiki/Raw_Device_Mapping_(RDM)_Festplatte_in_VMware_erstellen )

2. Festplatten mit der Windows Datenträgerverwaltung Partitionieren und Formatieren

3. StorageSpace erstellen ( https://it-learner.de/storage-spaces-in-windows-10/ )

🙏🙏🙏🙏🙏🙏🙏🙏🙏

und dickes Dankeschön, ohne euch hätte mich das noch einige stunden mehr gekostet ^^

maxblank

Experte

- Mitglied seit

- 14.01.2019

- Beiträge

- 350

- Desktop System

- AMD Ryzen 3 und GIGABYTE GeForce

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 3 5600

- Mainboard

- MSI B450M-VHD MAX

- Kühler

- Be Quiet! PURE ROCK SLIM 2

- Speicher

- 32GB G.Skill Aegis DDR4-3200

- Grafikprozessor

- GIGABYTE GeForce RTX 4060 OC Low Profile 8G

- Display

- Acer Predator X27U

- SSD

- WD SN850 Black 2 TB

- HDD

- Seagate Ironwolf Pro 6 TB

- Gehäuse

- Be Quiet! PURE BASE 500DX

- Netzteil

- Corsair RMx Series 2021 RM550x 550W

- Keyboard

- Logitech G213

- Mouse

- Logitech G502 Hero

- Betriebssystem

- Windows 10 / Windows 11

- Webbrowser

- Edge

- Internet

- ▼100 MBit ▲40 MBit

Backup-API ist bei VMWare free zum Beispiel dicht.

Olaf16

Legende

- Mitglied seit

- 28.09.2008

- Beiträge

- 6.700

- Desktop System

- Fujitsu T-BIRD

- Details zu meinem Desktop

- Prozessor

- Intel Pentium III 933 MHz @ 1066 MHz

- Mainboard

- Fujitsu OEM

- Kühler

- Stock

- Speicher

- 384 MB

- Grafikprozessor

- nVidia RIVA TNT2 Pro

- HDD

- 30 GB IDE

- Opt. Laufwerk

- CD-Rom

- Soundkarte

- Onboard

- Gehäuse

- Fujitsu OEM

- Netzteil

- FSP GROUP

- Keyboard

- Fujitsu PS/2

- Mouse

- Fujitsu PS/2 @ Ball

- Betriebssystem

- Windows Me

- Webbrowser

- -

Ich arbeite mich gerade in Proxmox ein. Angeblich je nach Szenario minimal schlechtere Performance.Ich auch, nur sollte es auch gut funktionieren. Werde mir Proxmox mal ansehen.

Mich stört aber das bissl rumgefrickel aktuell. Da ist ESXi weniger problematisch.

Persönlich finde ich das fehlen von Docker bei Proxmox furchtbar.

Dass man erst ne Ubuntu/Debian VM erstellen muss , dann Docker und Portainer Installieren muss damit man Docker hat ist unterirdisch, habe mir auf meinem 2. Server dann wieder Unraid installiert , der hat out of the box das alles intus.

Dass man erst ne Ubuntu/Debian VM erstellen muss , dann Docker und Portainer Installieren muss damit man Docker hat ist unterirdisch, habe mir auf meinem 2. Server dann wieder Unraid installiert , der hat out of the box das alles intus.

Ja gut, das ist (leider) die Dev Philosophie bei PVE. Haben ja schon Container, wollen kein Docker.

Aber auf meiner alten Arbeit hat das mit den VMs gut ins Konzept gepasst, da konnte ich quasi dynamisch VMs bootstrappen, die dann Docker Runner für die CI oder den Swarm Cluster waren.

Aber auf meiner alten Arbeit hat das mit den VMs gut ins Konzept gepasst, da konnte ich quasi dynamisch VMs bootstrappen, die dann Docker Runner für die CI oder den Swarm Cluster waren.

Hm, hat noch jemand Temperaturprobleme mit seinem T40? Habe meinen T40 mal mit 2 zusätzlichen 2x8TB Toshiba MG06 in den unteren Slots bestückt. Dazu dann noch eine NVMe SSD über einen PCIe-Slotadapter.

Trotz zusätzlichen 120mm Lüfter (reinfördernd) werden die HDD´s und SSD recht warm. Beim Preclearing mit Unraid wird eine knapp über 40°C und die andere um die 50°C warm. Die NVMe hat bei 68°C auch eine Temperaturwarnung rausgegeben. Ich würde nochmal versuchen an der Lüftersteuerung im Bios was einzustellen und versuchen einen zusätzlichen 80mm Lüfter in die Seitentür zu bekommen.

Sind die Platten einfach nur Hitzköpfe bzw. sind die heliumgefüllten HDD´s kälter? Was habt Ihr so verbaut?

Trotz zusätzlichen 120mm Lüfter (reinfördernd) werden die HDD´s und SSD recht warm. Beim Preclearing mit Unraid wird eine knapp über 40°C und die andere um die 50°C warm. Die NVMe hat bei 68°C auch eine Temperaturwarnung rausgegeben. Ich würde nochmal versuchen an der Lüftersteuerung im Bios was einzustellen und versuchen einen zusätzlichen 80mm Lüfter in die Seitentür zu bekommen.

Sind die Platten einfach nur Hitzköpfe bzw. sind die heliumgefüllten HDD´s kälter? Was habt Ihr so verbaut?

Die SSD (Lenovo OEM Samsung PM981a - 256GB) stammt noch aus einem Laptopupgrade. Dort wurde sie auch nur durch den Luftstrom gekühlt, hatte angenommen der 120er Lüfter reicht. Kühlkörper würde ich bestellen. Die Platten machen mir aber eher Sorgen.

[edit] Gestern nochmal mit nur der hinteren HDD den Unraid Preclear gestartet, nach 1h 49°C. Der Caselüfter lässt sich im Bios (aktuelles 1.40) nur in 2 Settings einstellen. Volllast (unerträglich laut) oder temperaturgesteuert (was wohl anscheinend nicht ausreicht). Ich werde nochmal schauen welche Möglichkeiten es gibt den Lüfter über Unraid zu steuern.

[edit] Gestern nochmal mit nur der hinteren HDD den Unraid Preclear gestartet, nach 1h 49°C. Der Caselüfter lässt sich im Bios (aktuelles 1.40) nur in 2 Settings einstellen. Volllast (unerträglich laut) oder temperaturgesteuert (was wohl anscheinend nicht ausreicht). Ich werde nochmal schauen welche Möglichkeiten es gibt den Lüfter über Unraid zu steuern.

Zuletzt bearbeitet:

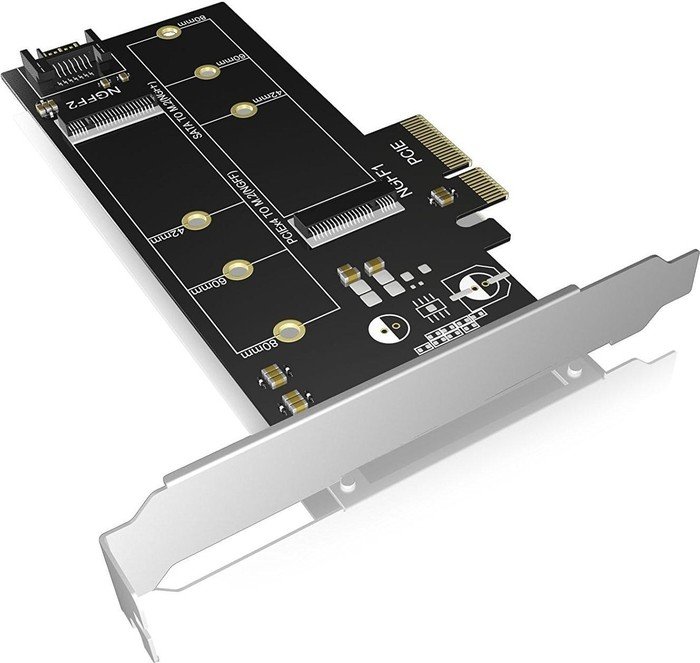

Ich hatte mir diesen PCI-E m2 Adapter zugelegt mit Kühlkörper.

Preis war auch top. Hatte ich bei einer anderen Bestellung mit bei gepackt für ~15€

Hat noch jemand Probleme mit mit esxi pci passthrough?

Hatte oben ja erwähnt das ich im Win10 StorageSpaces nutzen wollte.

Das klappt auch...jedoch ohne Spindown.

Hatte smartd im ESXi deaktiviert und bei den Platten EnableIdlePowerManagement in der Registry gesetzt.

aber es funktioniert halt nicht........habe dann irgendwann im Netz eine aussage gefunden das

Vmware uns diese möglichkeit ab Version 6~ genommen hat

Naja halb so wild.....dachte ich

PCIe Sata Controller mit nem Marvell 88SE9215 und wollte diesen nun durchreichen.

(so sollte Spindown ja wieder möglich sein)

gleiche Fehlerbild....Ladekreis und dann schaltet sich die VM wieder aus

Fehler tritt auch auf sobald das "hardwaregestützte virtualisierung" deaktiviert wird ohne den

Controller durchzureichen.

aufgrund das p4n0 keine Probleme beim durchreichen hatte mit FreeNAS hab ich das nun auch probiert.

Gab diverse Probleme, aber nachdem ich das Bios von UEFI auf BIOS gestellt hatte lief es.

Festplatten wurden erkannt, Festplatten schalten sich aus....Wunderwerk der Technik

Nun möchte ich eigntlich an der Windows Lösung festhalten um keine Ressourcen zu verschwenden.

Windows von UEFI auf Bios gestellt....Bootet natürlich nicht mehr.

Gibt es dafür eine Lösung? konnte dazu leider nichts finden.

Preis war auch top. Hatte ich bei einer anderen Bestellung mit bei gepackt für ~15€

Hat noch jemand Probleme mit mit esxi pci passthrough?

Hatte oben ja erwähnt das ich im Win10 StorageSpaces nutzen wollte.

Das klappt auch...jedoch ohne Spindown.

Hatte smartd im ESXi deaktiviert und bei den Platten EnableIdlePowerManagement in der Registry gesetzt.

aber es funktioniert halt nicht........habe dann irgendwann im Netz eine aussage gefunden das

Vmware uns diese möglichkeit ab Version 6~ genommen hat

Naja halb so wild.....dachte ich

PCIe Sata Controller mit nem Marvell 88SE9215 und wollte diesen nun durchreichen.

(so sollte Spindown ja wieder möglich sein)

gleiche Fehlerbild....Ladekreis und dann schaltet sich die VM wieder aus

Fehler tritt auch auf sobald das "hardwaregestützte virtualisierung" deaktiviert wird ohne den

Controller durchzureichen.

aufgrund das p4n0 keine Probleme beim durchreichen hatte mit FreeNAS hab ich das nun auch probiert.

Gab diverse Probleme, aber nachdem ich das Bios von UEFI auf BIOS gestellt hatte lief es.

Festplatten wurden erkannt, Festplatten schalten sich aus....Wunderwerk der Technik

Nun möchte ich eigntlich an der Windows Lösung festhalten um keine Ressourcen zu verschwenden.

Windows von UEFI auf Bios gestellt....Bootet natürlich nicht mehr.

Gibt es dafür eine Lösung? konnte dazu leider nichts finden.

Zuletzt bearbeitet:

- Mitglied seit

- 07.08.2012

- Beiträge

- 4.365

- Ort

- Raum Stuttgart

- Laptop

- Lenovo IdeaPad 14"

- Details zu meinem Desktop

- Prozessor

- AMD 5900x

- Mainboard

- ASUS ROG Strix B550-E

- Kühler

- Noctua NH-D15

- Speicher

- 2x16GB 3600CL14

- Grafikprozessor

- AMD Ref. 6900XT

- Display

- Dell 2721DGF 27" WQHD, Philips 275E 27" WQHD

- SSD

- Samsung 2TB EVO+

- Soundkarte

- Tascam 102i, DT990 Pro, SM7b

- Gehäuse

- Fractal Meshify C

- Netzteil

- Seasonic Focus PX 850W

- Keyboard

- Logitech MX Keys

- Mouse

- Logitech MX Master3

- Betriebssystem

- Win10Pro

- Internet

- ▼1000 Mbit ▲500 Mbit

Ich denke du bist da auf unbekanntem Terrain unterwegs. Try and error, viel Dokumentation dazu wirst du sicher nicht finden.

Wichtig: Wenn du auf eine Loesung kommst am besten hier Teillen. Wird sicher den ein oder anderen auch interessieren

Wichtig: Wenn du auf eine Loesung kommst am besten hier Teillen. Wird sicher den ein oder anderen auch interessieren

Ich hatte mir diesen PCI-E m2 Adapter zugelegt mit Kühlkörper.

Preis war auch top. Hatte ich bei einer anderen Bestellung mit bei gepackt für ~15€

Ich habe die Dual m.2 NVMe/Sata Variante, funktioniert einwandfrei:

RaidSonic Icy Box IB-PCI209 ab € 11,99 (2025) | Preisvergleich Geizhals Deutschland

✔ Preisvergleich für RaidSonic Icy Box IB-PCI209 ✔ Bewertungen ✔ Produktinfo ⇒ Wandlung: PCIe -> M.2 PCIe, SATA -> M.2 SATA • Host: 1x PCIe 3.0 x4 (male), 1x SATA 6Gb/s (male) • Ziel: … ✔ Adapter/Konverter ✔ Testberichte ✔ Günstig kaufen

RaidSonic Icy Box IB-M2HS-70 ab € 6,04 (2025) | Preisvergleich Geizhals Deutschland

✔ Preisvergleich für RaidSonic Icy Box IB-M2HS-70 ✔ Bewertungen ✔ Produktinfo ⇒ Typ: M.2 Kühler • Formfaktor: M.2 2280 • Kühlung: passiv • Montage: geklemmt… ✔ M.2-Kühler ✔ Testberichte ✔ Günstig kaufen

Die beiden Toshibas habe ich jetzt in den unteren vorderen Slot und den direkt an der Front verbaut. Die Brackets habe ich weggelassen und die HDD´s direkt verschraubt, hat imho 2-3°C gebracht.

Bei den vorderen slot habe ich zusätzlich einen 80 Slim Lüfter von außen verbaut, von innen einen 120er vor den beiden unteren Slots.

In den hinteren Slot habe ich eine 8TB WD White EZAZ gepackt. Heliumgefüllt und mit 5400Rpm sollte die eigentlich recht kühl bleiben (lt. Datenblatt ~5W Leistungsaufnahme). Jedoch wurde diese auch recht warm im Preclear -> knappe 50° bei 23° Raumtemperatur.

Die PWM Steuerung im Bios bot wie gesagt zu wenige Einstellungsmöglichkeiten. Unraid selber, bzw. das Plugin Dynamix Auto Fan Control findet leider keinen PWM Controller.

Es gab also keine Einstellmöglichkeit die PWM Steuerung auf die HDD Temperaturen schauen zu lassen. Also habe ich die beiden Lüfter mittels Lüftersteuerung fest eingestellt:

Noctua NA-FC1 ab € 19,95 (2025) | Preisvergleich Geizhals Deutschland

✔ Preisvergleich für Noctua NA-FC1 ✔ Bewertungen ✔ Produktinfo ⇒ Typ: Lüftersteuerung • Formfaktor: Sonderform • Lüfter: 1 • Kanäle: 1 (Drehzahl)… ✔ Steuerungen ✔ Testberichte ✔ Günstig kaufen

Jedenfalls habe ich jetzt bei jeder Platte nicht mehr als 42°C gesehen, allerdings nur bei seperaten Preclear.

Ich werde erst nochmal sehen wie es bei Last auf allen 3 HDD´s und CPU gleichzeitig aussieht.

Wie sind denn Eure Temps so?

Anhänge

Zuletzt bearbeitet:

- Mitglied seit

- 07.08.2012

- Beiträge

- 4.365

- Ort

- Raum Stuttgart

- Laptop

- Lenovo IdeaPad 14"

- Details zu meinem Desktop

- Prozessor

- AMD 5900x

- Mainboard

- ASUS ROG Strix B550-E

- Kühler

- Noctua NH-D15

- Speicher

- 2x16GB 3600CL14

- Grafikprozessor

- AMD Ref. 6900XT

- Display

- Dell 2721DGF 27" WQHD, Philips 275E 27" WQHD

- SSD

- Samsung 2TB EVO+

- Soundkarte

- Tascam 102i, DT990 Pro, SM7b

- Gehäuse

- Fractal Meshify C

- Netzteil

- Seasonic Focus PX 850W

- Keyboard

- Logitech MX Keys

- Mouse

- Logitech MX Master3

- Betriebssystem

- Win10Pro

- Internet

- ▼1000 Mbit ▲500 Mbit

Falls du das meinst:

Boot Options --> Firmware --> BIOS

Boot Options --> Firmware --> BIOS

xXThunderbyteXx

Experte

- Mitglied seit

- 15.11.2014

- Beiträge

- 1.085

Nutzt jemand den T40 als NAS?

Ich schwanke gerade zwischen einem Eigenbau, dem T40, einem HP G10 Plus und einem Synology NAS.

Pluspunkt für die Synology wäre das OS, der kleine Formfaktor und niedriger Stromverbrauch.

Mich würde daher die Lautstärke und der idle Verbrauch interessieren

Ich schwanke gerade zwischen einem Eigenbau, dem T40, einem HP G10 Plus und einem Synology NAS.

Pluspunkt für die Synology wäre das OS, der kleine Formfaktor und niedriger Stromverbrauch.

Mich würde daher die Lautstärke und der idle Verbrauch interessieren

Zuletzt bearbeitet:

Olaf16

Legende

- Mitglied seit

- 28.09.2008

- Beiträge

- 6.700

- Desktop System

- Fujitsu T-BIRD

- Details zu meinem Desktop

- Prozessor

- Intel Pentium III 933 MHz @ 1066 MHz

- Mainboard

- Fujitsu OEM

- Kühler

- Stock

- Speicher

- 384 MB

- Grafikprozessor

- nVidia RIVA TNT2 Pro

- HDD

- 30 GB IDE

- Opt. Laufwerk

- CD-Rom

- Soundkarte

- Onboard

- Gehäuse

- Fujitsu OEM

- Netzteil

- FSP GROUP

- Keyboard

- Fujitsu PS/2

- Mouse

- Fujitsu PS/2 @ Ball

- Betriebssystem

- Windows Me

- Webbrowser

- -

Zumal man in dem Preisbereich von einem T40 / G10 Plus eine Synology NAS net wirklich vergleichen kann. Aus Erfahrung sind das Welten in Performance (Selbst mit XPEnology auf als VM mit durchgeschleiften HDDs / RAID Controller  )

)

)

)- Mitglied seit

- 07.08.2012

- Beiträge

- 4.365

- Ort

- Raum Stuttgart

- Laptop

- Lenovo IdeaPad 14"

- Details zu meinem Desktop

- Prozessor

- AMD 5900x

- Mainboard

- ASUS ROG Strix B550-E

- Kühler

- Noctua NH-D15

- Speicher

- 2x16GB 3600CL14

- Grafikprozessor

- AMD Ref. 6900XT

- Display

- Dell 2721DGF 27" WQHD, Philips 275E 27" WQHD

- SSD

- Samsung 2TB EVO+

- Soundkarte

- Tascam 102i, DT990 Pro, SM7b

- Gehäuse

- Fractal Meshify C

- Netzteil

- Seasonic Focus PX 850W

- Keyboard

- Logitech MX Keys

- Mouse

- Logitech MX Master3

- Betriebssystem

- Win10Pro

- Internet

- ▼1000 Mbit ▲500 Mbit

Habe heute noch die Lüfter vom T40 getauscht.

CPU Lüfter ist jetzt ein 80er Noctua

Gehaeuse oben n 92er Noctua

Vorne (unten) nen 120er Arctic

Vorne (oben) nen 120er Noctua (flach)

Dann pusten noch 2 x 60er Lüfter auf die 10G NIC + NVMe

Im Idle bis wenig Last ist das Ding komplett unhoerbar, Bei Voller Last nur ein leichtes Rauschen.

NT Lüfter ist halt irgendwie Muell.

3h bei voller Last haben keinen Absturz / Throtteling beschert. Scheint also alles i.O zu sein.

Wer also sehr Geraeuschempfindlich ist und das Ding mit ueberschaubarer Last laeuft, kann ihn komplett leise bekommen.

CPU Lüfter ist jetzt ein 80er Noctua

Gehaeuse oben n 92er Noctua

Vorne (unten) nen 120er Arctic

Vorne (oben) nen 120er Noctua (flach)

Dann pusten noch 2 x 60er Lüfter auf die 10G NIC + NVMe

Im Idle bis wenig Last ist das Ding komplett unhoerbar, Bei Voller Last nur ein leichtes Rauschen.

NT Lüfter ist halt irgendwie Muell.

3h bei voller Last haben keinen Absturz / Throtteling beschert. Scheint also alles i.O zu sein.

Wer also sehr Geraeuschempfindlich ist und das Ding mit ueberschaubarer Last laeuft, kann ihn komplett leise bekommen.

Ähnliche Themen

- Antworten

- 16

- Aufrufe

- 901

- Antworten

- 6

- Aufrufe

- 470

- Antworten

- 9

- Aufrufe

- 906