Thread Starter

- Mitglied seit

- 11.10.2007

- Beiträge

- 1.252

- Laptop

- Dell Latitude 7490

- Details zu meinem Laptop

- Prozessor

- i7-8650U

- Speicher

- 32GB

- SSD

- Samsung SSD 870 Pro 1TB NVMe

- Betriebssystem

- Windows 11 Pro 64bit

- Internet

- ▼400 ▲40

Bin noch am Herumtesten mit meinem "TrueNAS" und auf div. Beiträge/Meinungen zum Pool gestoßen.

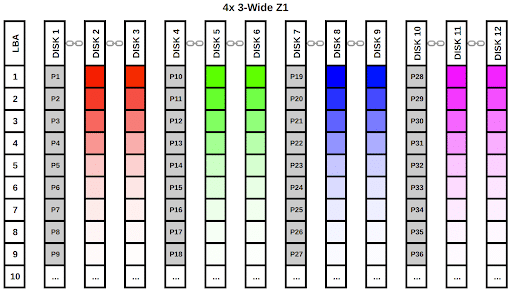

Derzeit 3x 6TB Seagate Iron Wolf mit RaidZ1.

Habe jetzt noch eine günstige neue HDD (gleiche wie oben) bekommen und werde den Pool neu aufbauen.

Was ist denn jetzt mit 4 HDD's wirklich besser - RaidZ2, oder Mirror?

Danke!

LG

Derzeit 3x 6TB Seagate Iron Wolf mit RaidZ1.

Habe jetzt noch eine günstige neue HDD (gleiche wie oben) bekommen und werde den Pool neu aufbauen.

Was ist denn jetzt mit 4 HDD's wirklich besser - RaidZ2, oder Mirror?

Danke!

LG