Hallo liebe Luxxer

Nachdem ich die GTX 680 erfolgreich überspringen konnte, habe ich mich mal wieder dazu entschlossen, ein kleines Review zu schreiben.

Grundsätzlich will ich die GTX Titan so ausführlich wie möglich testen, sowie die Leistung mit und ohne OC darzulegen.

Später werde ich noch Einfluss des CPU Taktes, Treibervergleiche und Stromverbrauch in den Test einfließen lassen.

Auch Themen wie Boost 2.0, Bios editieren/flashen, Downsampling, Displayoverclocking, Treibereinstellungen usw. werden behandelt.

Unter anderem werde ich auch noch auf Vergleiche zur GTX 580, sowie die SLI Skalierung und das damit verbundene

AFR Problem (Microruckler Problematik) in das Review aufnehmen.

==================================================

Zum Testsystem:

In den Tests kommt jeweils ein absolut identisches System zum Einsatz, so dass keine externen Parameter die Ergebnisse beeinflussen.

Ich möchte noch im Voraus sagen, dass ich bisher noch nicht alle Dinge testen konnte, sobald ich Zeit finde, kommen neue Tests hinzu!

Über Anregungen und Wünsche würde ich mich natürlich freuen, auf die ich, wenn ich die Möglichkeit habe, eingehen will!

So dann erst mal zu Beginn ein paar Bilder:

Zotac GTX Titan

(alle Bilder zum Vergrößern anklicken (1920x1200))

Zum Messen der Oberflächentemperaturen kommt folgendes Infrarotthermometer zum Einsatz:

==================================================

Erste Eindrücke

Erste Eindrücke der Karte, welche ich sammeln konnte liste ich hier einfach mal stichpunktartig auf, um die Übersicht zu wahren:

- Die GTX Titan ist sauber und ordentlich verarbeitet und macht einen soliden und sehr, sehr hochwertigen Eindruck.

- Idle ist die Karte sehr leise bzw. schlichtweg nicht hörbar (Lüfter 30%)

- Auch im 3D Betrieb ist die GTX Titan zwar kein Leisetreter, aber trotzdem noch sehr angenehm, was die Geräuschentwicklung angeht.

- Bei 85% Lüfterdrehzahl ist die Karte schon recht gut hörbar, aber so hoch muss der Lüfter in der Regel nicht drehen.

- Was die Leistung angeht, kann ich nur sagen - wow! In vielen Bereichen wird mehr als die doppelte Leistung einer GTX 580 erreicht. Aber dazu später mehr.

- Umbau des Kühlers auf Wasserkühlung ist sehr einfach. Mit etwas Geschick sollte dies für jeden zu bewerkstelligen sein.

- Die Leistungsaufnahme unter Last ist angesichts der beeindruckenden Leistung, erstaunlich niedrig.

==================================================

Spannung, Taktraten und Boost

Die GTX Titan hat einen Basistakt von 837 MHz Core und 1500(6008) MHz VRam. Wenn mehr Leistung benötigt wird, taktet die Grafikkarte auf einen sog. „Boost Clock“

welcher in dem Fall bei 876 MHz liegt. Dieser Wert hat allerdings wenig Aussagekraft, da die Karte je nach Umgebungsparametern deutlich höher taktet.

Maximaler Boosttakt:

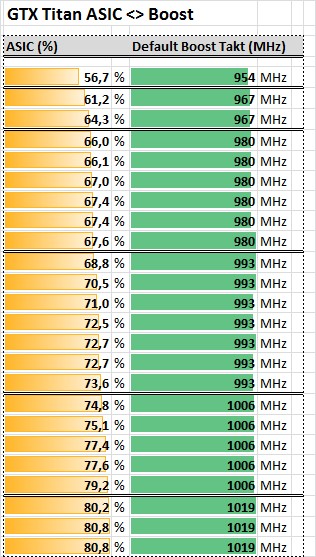

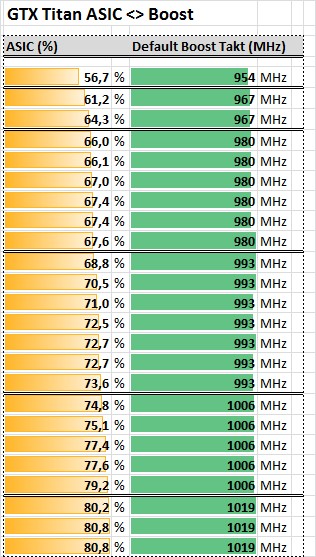

Der maximale Boosttakt den die GTX Titan annimmt hängt in erster Linie von dem ASIC Wert

der jeweiligen Karte ab. Je höher dieser "Qualitätswert" desto höher ist auch der vor gesteuerte

maximale Takt (68% ASIC ergibt zum Beispiel 980 MHz Boosttakt, 72% 993 MHz, 77% 1006 MHz und 81% ergeben 1019 MHz).

ASIC Tabelle:

Wird die GPU nun übertaktet geschieht dies über den Offsettakt (z.B. +100 MHz).

Gehen wir einmal von einem default Boosttakt von 1019 MHz aus, würden sich bei eingestellten +100 MHz theoretisch 1119 MHz ergeben.

Da diese Taktstufe aber nicht existiert (Kepler taktet in 13 MHz Schritten), wird die nächst niedrigere Stufe angenommen.

In diesem Fall 1110 MHz.

Zusätzlich wird bei jeder Anhebung der Spannungsstufe um 0,0125v, der Takt um weitere 13 MHz angehoben.

Wieder am Beispiel eines 1019 MHz Boosttaktes. 1019 MHz +100 MHz bei +0,0125v ergeben 1019 MHz +100 MHz +13 MHZ = 1132 MHz, auch diese

Taktstufe gibt es nicht, daher werden 1124 MHz angenommen.

Der jeweis max. mögliche Takt wird allerdings von dem Feature „Boost 2.0“ geregelt, dazu aber mehr im nächsten Abschnitt.

Die minimalen Taktraten für den Idle-Betrieb sind 324 MHz sowohl für den GPU Takt als auch für den Speicher.

GTX Titan verfügt über einen Spannungsbereich der von 0,825 - 1,2125v reicht.

Standardmäßig werden unter Last seitens NVIDIA max. 1,1625v für die GPU eingestellt. Dieser Wert kann allerdings per Software auf 1,200V erhöht werden

um evtl. höhere Taktraten zu erreichen. Mit einem Eingriff ins Bios lassen sich auch 1,2125v einstellen, dazu später mehr.

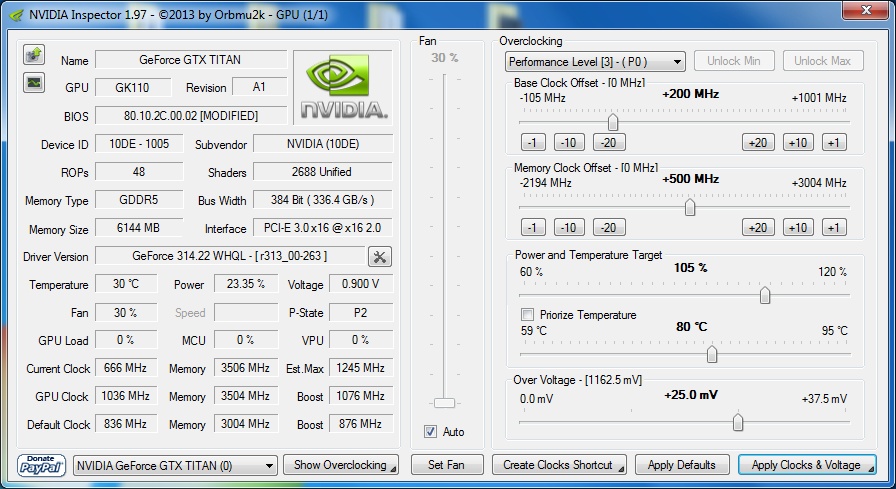

Wie erwähnt lassen sich diese Werte mittels Software verändern.

Nützliche Tools hierzu sind zur Zeit der "MSI Afterburner", "NVIDIA Inspector" oder etwa das

"EVGA Precision X" Tool in der Version 4.0.0. Später dazu mehr.

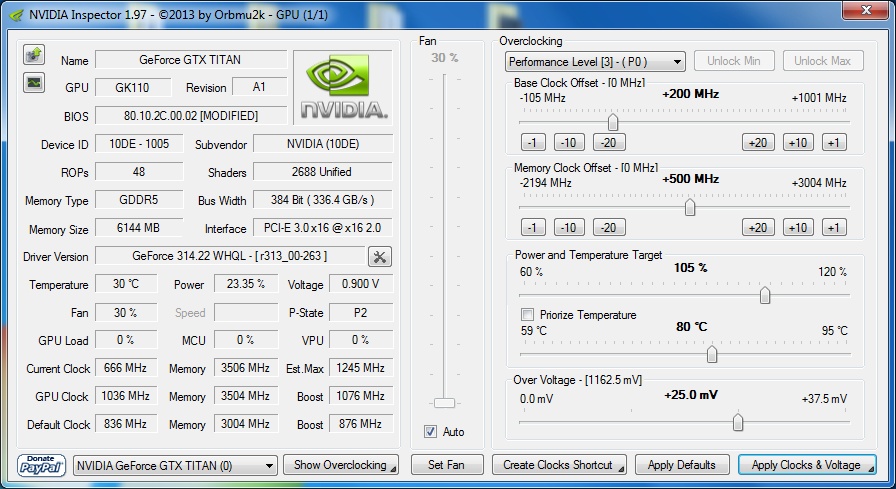

NVIDIA Inspector:

An dieser Stelle ein großes Lob an den User Orbmu2k (Profil: Orbmu2k - Forum de Luxx). Tolle, übersichtliche Software. Vielen Dank.

Natürlich lassen sich auch mit den oben genannten Tools, Parameter wie Takt, Powertarget, Temperaturlimit, Lüfterdrehzahl usw. ändern.

==================================================

Boost 2.0 verstehen

Wie bereits erwähnt ist das Feature Boost 2.0 dafür verantwortlich, welcher GPU Takt unter jeweiliger Last anliegt.

Hier sei vorab erwähnt dass nicht jede Grafikkarte die gleichen max. Boosttaktraten erreicht und diese auch je nach Anforderung verschieden hoch sein können.

Viele GTX Titan Karten takten aber per default über 1000 MHz.

Aber von was ist dieser Takt abhängig? Um den "richtigen" Takt zu finden überwacht NVIDIA einige Parameter aus deren Zusammenspiel dann der maximale Boosttakt ermittelt wird.

Dies ist kein einmaliger Vorgang, sondern ein fortlaufender Prozess, der ständig den Takt neu errechnet.

Folgende Parameter sind unter anderen ausschlaggebend:

Temperatur, Leistungsaufnahme der GPU, Lüfterdrehzahl und die Gesamtleistungsaufnahme der Karte.

Um das Taktverhalten auch in Bezug aufs Übertakten richtig einschätzen zu können, ist es wichtig zu verstehen

wie diese Parameter den anliegenden Takt und die Spannung verändern können.

Generell gilt, dass ein bestimmter Takt mit der dafür nötigen Spannung eingestellt wird, sofern alle Parameter "Grünes Licht" zeigen.

Wird nun ein, oder mehrere Parameter verletzt, wird der GPU Takt und die Spannung um einen Schritt gesenkt. Wenn dann alles "OK" ist, bleibt dieser Takt bestehen.

Reicht das Absenken nicht aus, wird Takt und Spannung weiter gesenkt.

Um das zu verdeutlichen möchte ich zu den verschiedenen Werten ein paar Worte sagen.

Temperatur:

Dieser Parameter ist recht einfach zu verstehen. Je wärmer die GPU wird, desto wahrscheinlicher ist es, dass der Takt abgesenkt werden muss.

Als Beispiel, es liegt ein Takt von 1019 MHz an und die GPU liegt bei 79°C. Bei Erreichen der nächsten Temperaturschwelle von 80°C

merkt die Karte dass der Takt offenbar etwas zu hoch ist und senkt diesen auf 1006 MHz.

Per Software lässt sich zudem ein Wert für das sog. Temperaturtarget festlegen. Dieser befindet sich per default bei 80°C. Korrigiert man diesen Wert

nach oben hat das sowohl Einfluss auf das Lüfterverhalten als auch den Zeitpunkt ab wann der Takt gesenkt werden muss.

>> Was kann ich hier tun um das Absenken (das sog. Throtteln) zu verhindern? Ganz einfach, für niedrigere Temperaturen sorgen oder den Wert für

das Temperaturtarget nach oben verändern. <<

Leistungsaufnahme der GPU:

Das sog. GPU Powertarget regelt wie viel Watt die GPU selbst max. aufnehmen darf, bevor Takt und vGPU gesenkt werden.

Im Default BIOS ist das Powertarget auf 100% = 250W gesetzt und kann ohne Eingriff ins Bios auf 106% = 265W erhöht werden.

Im Prinzip ist auch dieses Verhalten recht einfach zu erklären. Wird die GPU gerade sehr stark gefordert, braucht diese mehr Leistung.

Werden nun die 250W erreicht, passiert das gleiche wie bei Erreichen des Temperaturlimits. Die Karte throttelt den GPU Takt.

>> Wie ist hier Abhilfe zu schaffen? Man erhöht das Powertarget. Bei eingestellten 106% setzt das Throtteln nicht bei 250 sondern erst bei 265W ein. <<

Lüfter:

Der Lüfter ist ein nicht so wichtiger Parameter. Dennoch will ich hier darauf hinweisen,

dass auch der Lüfter für das Absenken des Taktes verantwortlich sein kann. Ein manuelles Einstellen des Lüfters auf 85% mag zwar die Temperaturen

nach unten drücken, kann aber auch die Karte zum throtteln bringen.

Gesamtleistungsaufnahme der Karte:

Alle bisher genannten Werte können durch den Benutzer recht leicht beeinflusst werden, so dass schlussendlich ein höheres OC Ergebnis möglich ist.

Dem ist leider nicht so bei dem Gesamtlimit der GTX Titan. Es wurde seitens NVIDIA eine max. Leistungsaufnahme von 300W definiert, welche die Karte nutzen darf.

Unter diese 300W fallen sowohl die GPU selbst, der Videospeicher als auch das PCB. Daraus resultiert, dass selbst wenn alle andern Parameter "auf Grün stehen",

die Karte trotzdem throttelt, wenn diese 300W Marke überschritten wird. Dies dient zum Schutz der Hardware, verhindert aber oftmals bessere Übertaktungsergebnisse.

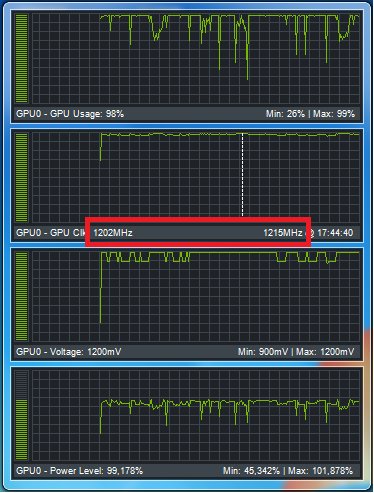

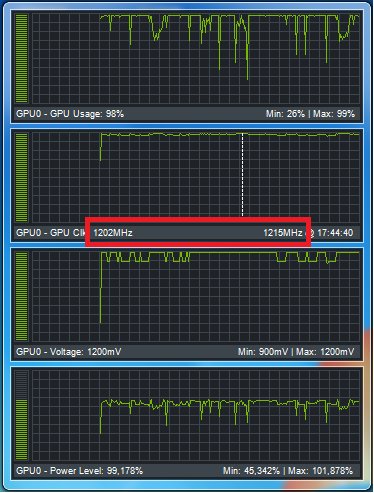

Um den letzten Abschnitt besser verstehen zu können, will ich es an einem Beispiel verdeutlichen:

Ich möchte gern einen Takt von 1215/3500 erreichen und stelle dazu 1,2v ein. Ich sorge für niedrige Temperaturen mittels Wasserkühlung.

Soweit beste Voraussetzungen um den Takt stabil zu betreiben. Erstes Problem an der Stelle ist, dass die 250W der GPU nicht ausreichen.

Auch das ist noch kein Problem, ich stelle den Powertarget Wert einfach auf 116%, somit darf die GPU 290W aufnehmen, was für den Takt ausreichen würde.

Unabhängig davon zählen aber immer noch die 300W für die gesamte Karte. In diesem Beispiel wären rein rechnerisch aber nur noch 10W für den VRam und das PCB übrig,

was nicht ausreichend wäre.

Allein für VRam und PCB sind grob 40 - 50W zu rechnen.

Ohne dieses Limit würde die GTX Titan nun 290W (GPU) + ca. 50W (VRAM und PCB) = 340W aufnehmen wollen.

Das passiert aber nicht, da die Gesamtleistungsaufnahme von 300W überschritten werden würde. Folglich behält die Karte nicht meine eingestellten 1215 MHz bei 1,200v.

Takt und Spannung werden soweit gesenkt, bis ein Takt erreicht wird für den die 300W ausreichend sind.

Wie oben schon erwähnt ist dies ein fortlaufender Prozess bei dem ständig GPU Takt und Spannung neu beurteilt werden.

Somit ist es durchaus möglich, dass zeitweilig der "gewünschte Takt" von 1215 MHz anliegt, dieser aber je nach Last deutlich unter 1200 MHz abfällt.

Typischerweise sieht die Taktkurve dann wie folgt aus:

Der Takt schwenkt zwischen 1189 und 1215 MHz und die GPU Spannung zw. 1,1625 und 1,200v.

>>> Abhilfe schafft hier nur die Möglichkeit diese 300W Sperre zu umgehen, dies soll aber nicht Teil meines Reviews sein. <<<

==================================================

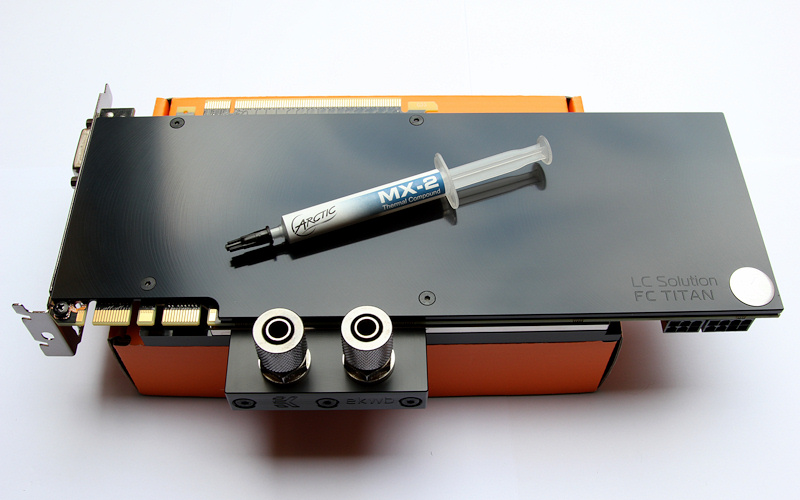

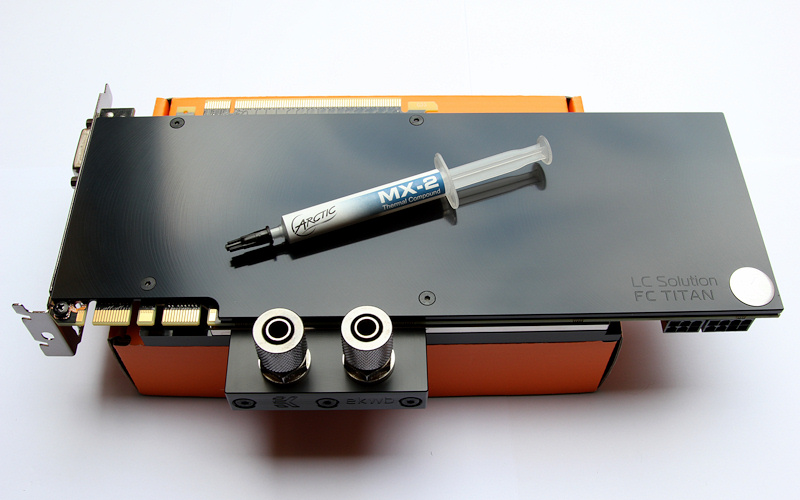

Umbau auf Wakü:

Da für mich klar war, dass die Karte, obwohl der Kühler der bisher beste ist der NVIDIA gebaut hat,

etwas zu laut sein wird für einen Silent-PC, habe ich mich schon gleich dazu entschlossen auf Wakü um zurüsten.

Ich habe mich für den EK FC-Tian als Wasserkühler entschieden.

Um die Karte optisch etwas schicker zu machen und die Rückseite zu schützen, habe ich der GTX Titan zusätzlich eine entsprechende EK Backplate spendiert.

Der Umbau ist sehr einfach und problemlos. Anleitungen liegen sowohl der EK Backplate als auch dem Kühler bei und sind ordentlich beschrieben und bebildert.

Auf Wunsch kann ich den Vorgang aber gern genauer beschreiben, aber fürs erste sollten hier einige Bilder genügen.

(alle Bilder zum Vergrößern anklicken (1920x1080))

So sieht dann die GTX Titan nach dem Umbau mit EK Kühler und Backplate aus:

Hier noch ein paar Bilder der restlichen Wasserkühlung:

Generell habe ich mein System so konfiguriert dass es sowohl idle als auch unter Last kaum hörbar ist.

Zur Lüfter- und Pumpeneinstellung sowie zur Temperaturüberwachung kommt Aquasuite in der aktuellen Version 2013 zum Einsatz.

Um das Thema Wasserkühlung abzuschließen, gehe ich an dieser Stelle noch auf die Thematik der sog. Hotspots bzw. dem oft diskutieren "Wärmestau" unter Backplates ein.

Dazu lässt sich meinerseits nur sagen, dass sämtliche Diskussionen diesbezüglich völlig gegenstandslos sind, da die Temperaturen auf der Rückseite der GTX Titan

gänzlich unbedenklich sind. Dies gilt sowohl für die Speicherchips, als auch für die Stellen an denen sich die Spannungswandler befinden.

Hinzu kommt, dass sich die Temperaturen durch das Anbringen einer Backplate nicht negativ verändern.

Die beiden Grafiken sollten dies verdeutlichen.

Im folgenden Bild sind die Temperaturen an verschiedenen Stellen der Kartenrückseite zu sehen, nachdem die Umrüstung auf einen Wasserkühler stattgefunden hat.

Wie zu sehen ist, liegen alle Temperaturen weit im grünen Bereich.

Nachdem ich dann zusätzlich die EK Backplate montiert hatte, wurden die Temperaturen nochmals an zwei Stellen mittels Temperaturfühler zwischen

PCB und Backplate (bzw. zwischen VRam und Backplate) gemessen.

Da bei der EK Backpalte die Rams "mitgekühlt" werden, verbessert sich die Temperatur sogar leicht. Was man sicher sagen kann ist, dass dort keine

Verschlechterung stattfindet. Im Bereich der Spannungswandler steigt die Temperatur um ca. 2°C an.

Hier nochmal die Bilder in größerer Auflösung:

==================================================

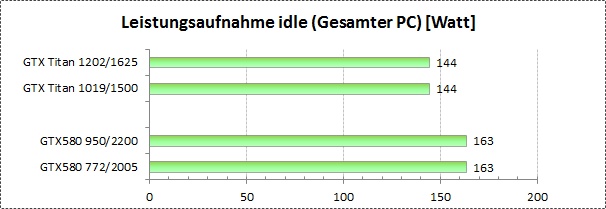

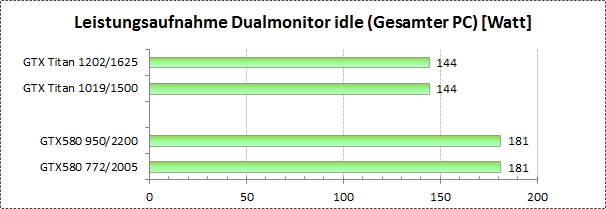

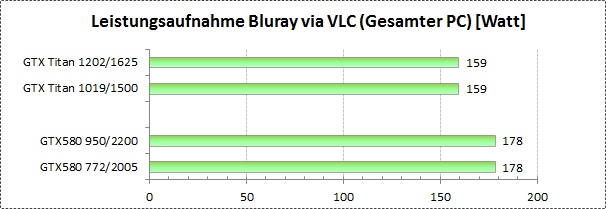

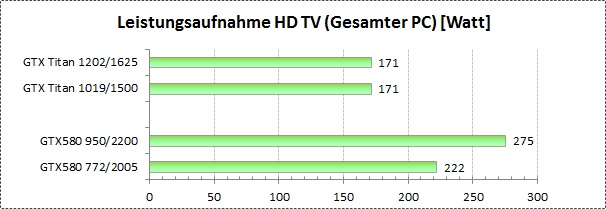

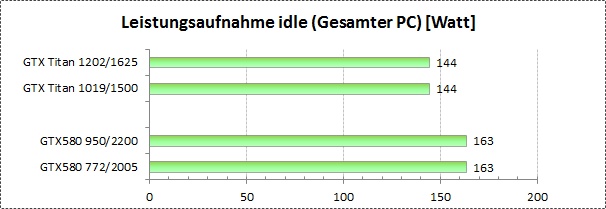

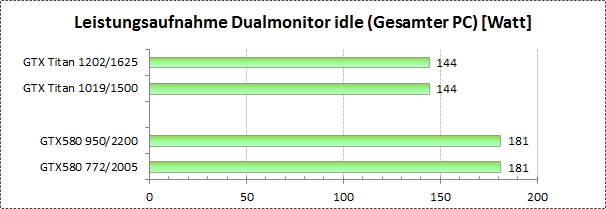

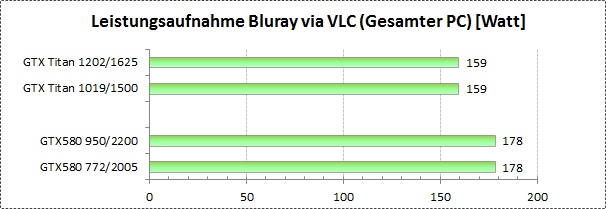

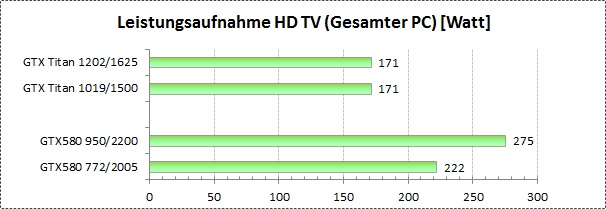

Leistungsaufnahme

Zum Messen der Leistungsaufnahme dient mir ein Energy Check 3000.

Den direkten Verbrauch an der Karte kann ich leider nicht messen, somit sind alle angegebenen Werte jeweils die Verbrauchswerte des gesamten Systems.

Was die Leistungsaufnahme ohne Last sowie im Dualmonitorbetrieb hatte AMD Lange Zeit die Nase vorne, wenn’s ums Energie sparen geht.

Aber auch hier leistet NVIDIA mittlerweile richtig gute Arbeit.

Zum ersten möchte ich hier einige Vergleiche zur GTX 580 aufzeigen,

indem ich jeweils die Leistungsaufnahme der beiden Karten in verschiedenen Situationen darstelle.

Diagramme Leistungsaufnahme:

Bei den GTX480/580 Reviews bin ich noch recht viel darauf eingegangen wie sich die Leistungsaufnahme bei jeder Spannungs- und Taktstufe steigert.

Das zu protokollieren macht bei den Kepler GPUs wegen der Boost Funktionalität wenig Sinn, da wie oben erwähnt sich Takt und Spannung oft

sehr dynamisch verhalten. Je nach Übertaktungsgrad kratzt somit die Leistungsaufnahme der Karte oftmals an der 300 Watt Marke.

Durch die Boost Technologie wird einerseits je nach Situation die maximale Leistung ermöglichst indem ein möglichst hoher

Takt angelegt wird, was sicherlich ein deutlicher Vorteil gegenüber Grafikkarten ist, die einen festen Maximaltakt haben.

Auf der anderen Seite kann diese Boost Funktion auch deutlich zum Energie sparen beitragen.

Wird zum Beispiel, gerade bei älteren Spielen, wenig Leitung benötigt, werden Takt und Spannung teilweise sehr stark gesenkt,

dass die GTX Titan weniger als ein Drittel der max. Leistungsaufnahme aufweist.

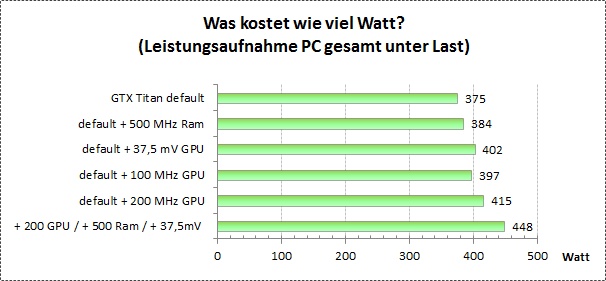

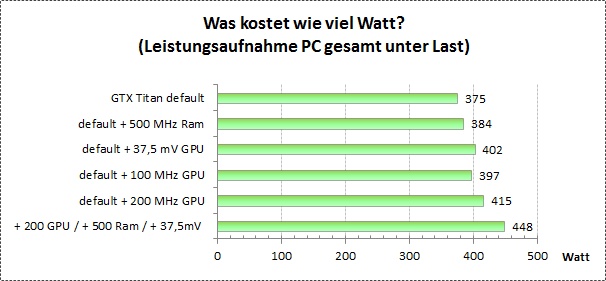

Für die Übertakter unter euch kann es dennoch recht interessant sein, welche Parameter den größten Einfluss auf die Leistungsaufnahme haben.

Wie im Abschnitt "Boost 2.0 verstehen" beschrieben wird man beim Übertakten oftmals durch das 300 Watt Limit "aufgehalten".

Da z.B. auch ein übertakteter VRam mehr verbraucht, kann es von Vorteil sein, den VRam etwas weniger hoch zu takten, um ein paar Watt mehr

für die GPU "übrig zu haben".

Um grob einschätzen zu können, welche Änderungen am meisten "fressen" hier eine kleine Übersicht:

Vergleich Leistungsaufnahme:

==================================================

Overclocking

Overclocking

Zum übertakten der GTX Titan eigenen sich mehrere Tools ganz gut.

Zum einen der NVIDIA Inspector (z.Z. in der Version 1.9.7) OrbLog » Blog Archive » NVIDIA Inspector 1.95 – Tool

Und zum andern die von MSI und EVGA bereitgestellten Tools "MSI Afterburner" und "EVGA Precision X"

Alle sind denke ich inhaltlich weitestgehend selbsterklärend, wodurch ich nicht näher auf die Funktion der Tools eingehen werde.

Taktraten:

Die GTX Titan taktet standardmäßig im Idle-Betrieb mit jeweils 324 MHz GPU- und VRam Takt.

Unter Last wird der Videospeicher mit 1502 MHz betrieben. Der maximale GPU Takt wird, wie bereits oben beschrieben, mittels der Boost 2.0 Technologie ermittelt.

Der Takt der maximal versucht wird anzustreben hängt dabei von der Güte des Chips ab. Somit ist es möglich dass einige Karten auf "nur" 980 MHz "boosten", andere

aber 1006, 1019 oder mehr MHz erreichen. Ob dieser Takt allerdings dauerhaft bestehen bleibt hängt wiederum von den Parametern ab die den Boosttakt steuern, wie etwa

die Temperatur der Karte.

Übertakten:

Wenn man, wie ich die GTX 680 übersprungen hat, wundert man sich evtl., dass man die Taktraten nicht mehr direkt einstellen kann, sondern nun viel mehr einen

Offset zum Standard definieren muss. Dies gilt sowohl für die Taktraten, als auch für die GPU Spannung.

Die GPU lässt sich in 13 MHZ Schritten übertakten. Wenn man nun, wie in meinem Fall einen Deafult Boost Takt von 1019 MHz hat, erreicht man

beispielsweise 1110 MHz wenn man einen Offset von +100 MHz definiert.

Ähnlich verhält es sich beim VRam, auch dort muss der Mehrtakt gegenüber dem Basistakt angegeben werden. Der Grundtakt liegt hier bei 1502 MHz QDR was einen effektiven

Takt von 6008 MHz ergibt. An dieser Stelle muss man etwas darauf dachten dass man den Takt auf der Basis des DDR Taktes von 3004 MHz erhöht.

Stellt man beispielsweise einen Wert von +500 (3500) MHz ein, ergibt sich ein Takt von 1750, respektive 7000 effektiven MHz.

GPU Spannung

Beim Thema Spannungen gibt es nicht so viel zu sagen. Die Standard Boost Spannung liegt bei allen Karten bei maximal 1,1625v und kann um drei Stufen

auf 1,1750, 1,18725 oder 1,2000v per Software erhöht werden. Mittels Eingriff ins Bios kann die Spannung noch um eine weitere Stufe auf 1,2125v angehoben werden.

Stabilität testen

Um sicher zu stellen dass die Karte stabil arbeitet sollten die Taktraten ausführlich auf Stabilität getestet werden.

Generell kommt es mit der GTX Titan seltener vor, dass der Takt instabil ist als es mit früheren Generationen der Fall war, da oftmals das

Powerlimit erreicht wird was zur Folge hat, dass der Takt gesenkt wird.

Dennoch eignet sich 3DMark11 und vor allem die 3DMark Firestrike Demo ganz gut um die Taktraten in Bezug auf das Powertarget zu testen. Update - Natürlich eignen sich auch Games wie Assassin's Creed 3 sowie

Far Cry 3 und Just Cause 2 ganz gut um die eingestellten Werte auf Stabilität zu prüfen.

Ist ein bestimmter Takt nicht stabil, kommst es in den meisten Fällen zu einem Treiberrest, welcher die Taktraten auf die Default Werte zurückstellt.

Dabei wird der Bildschirm kurz schwarz.

Wird allerdings das Powertarget erreicht, senkt die Grafikkarte sowohl GPU Takt als auch die Spannung, um innerhalb der Spezifikationen bzgl. der

maximalen Leistungsaufnahme zu bleiben.

Dies merkt man aber idR. nicht während dem Spielen, da es ein sehr dynamischer Prozess ist. Gegebenenfalls wird auch der Takt und die Spannung wieder nach oben

korrigiert, wenn sich die GTX Titan wieder unterhalb des Powertargets befindet.

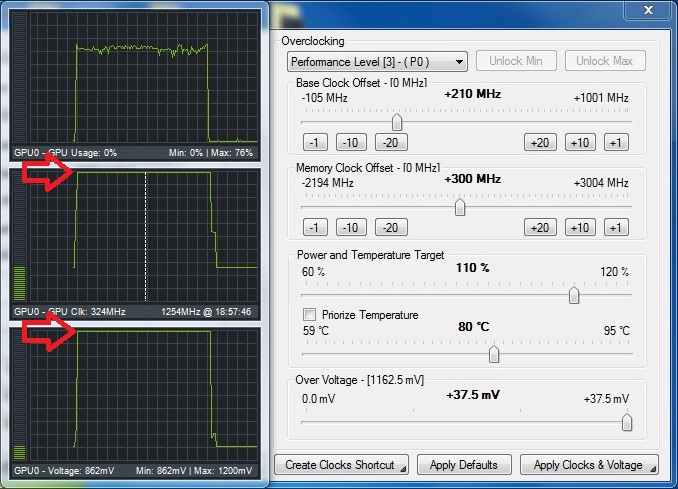

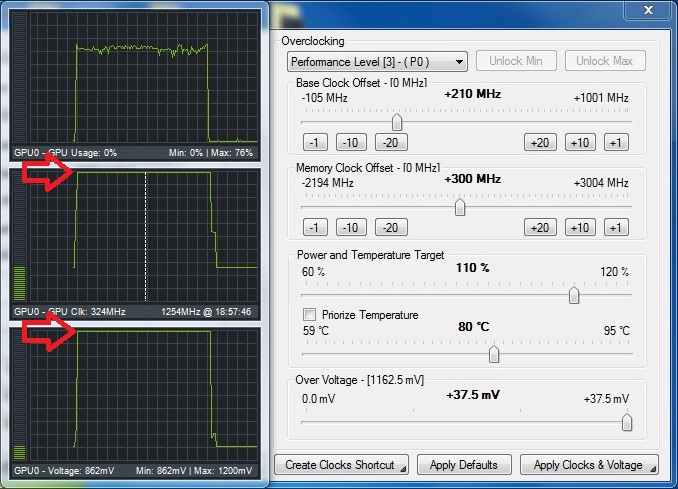

Um diese "Taktschwankungen" festzustellen, sind Tools nötig, die die Takt- und Spannungskurve aufzeichnen. NVIDIA Inspector ist hierzu gut geeignet.

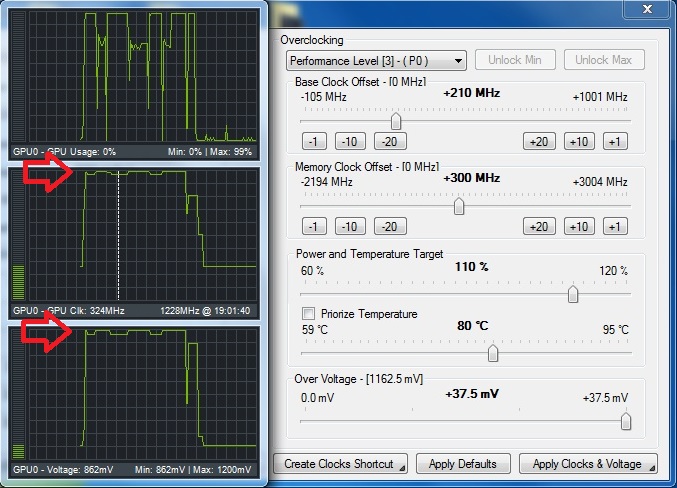

Anbei zwei Beispiele, wie das aussehen kann.

Beispiel 1:

Ich möchte einen Takt von 1254 MHz anstreben, dieser wird auch angenommen und bleibt bestehen, da sich die Karte unterhalb des Powertargets bewegt.

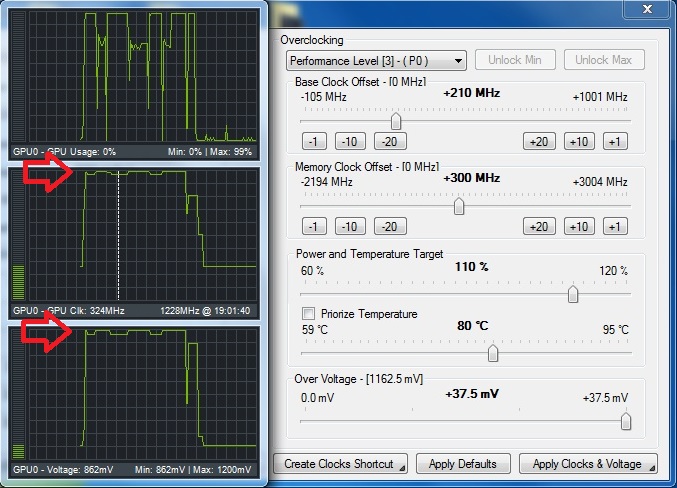

Beispiel 2:

Ich starte eine andere Anwendung, die beispielsweise etwas GPU-lastiger ist. Wieder möchte ich einen Takt von 1254 MHz.

Fürs erste versucht die Grafikkarte diesen auch zu halten. Je nach Last kommt es aber dazu, dass das Limit der Leistungsaufnahme erreicht wird.

Somit werden Takt und GPU Spannung um ein bis zwei Stufen gesenkt, bzw. wieder erhöht, sobald die max. Leistungsaufnahme dies wieder zulässt.

Ergebnis ist, dass der Takt ständig zw. 1228 und 1254 MHz schwankt.

Man sollte also schon prüfen welcher Takt unter Last tatsächlich anliegt, denn es sind nicht zwingend 1200 MHz aktiv, nur weil diese einstellt!!

==================================================

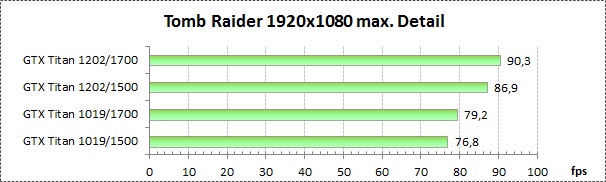

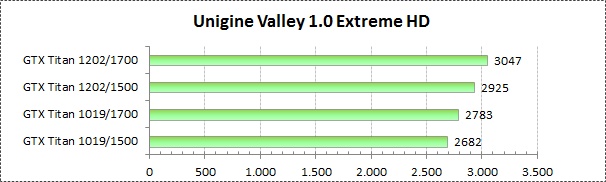

Overclocking GPU vs. VRam - Was bringt mehr?

Zu diesem Thema will ich nicht viele Worte verlieren. Das Thema ist eigentlich selbsterklärend.

Anbei einige Tests die aufzeigen sollen, ob es mehr Sinn macht die GPU oder den Speicher zu übertakten oder etwa beides.

Ja nach Anwendung können die Ergebnisse natürlich unterschiedlich ausfallen. Spiele die etwa eine hohe Speicherbandbreite benötigen

regieren natürlich stärker auf das Übertakten des Speichers als welche die weniger auf einen hohen Durchsatz angewiesen sind.

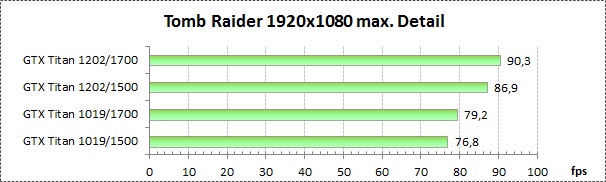

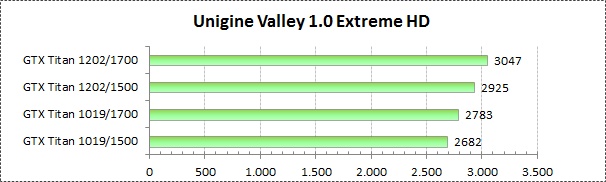

Tomb Raider:

Unigine Valley:

... weitere Tests folgen ...

==================================================

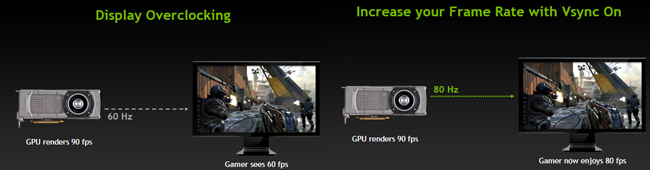

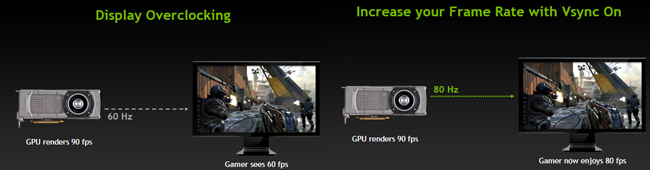

Displayoverclocking

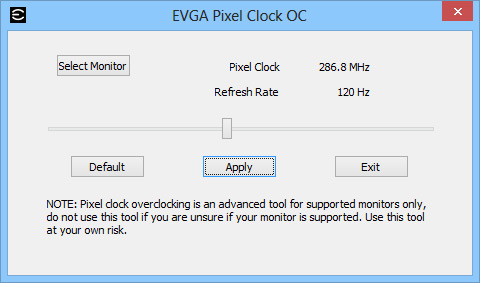

Eines der neuen Features von NVIDIA ist das sog. Displayoverclocking.

Ich möchte hier nur kurz auf das Thema eingehen.

Es hat eigentlich schon fast mehr mit dem Monitor als mit der Grafikkarte zu tun.

Bei aktivem VSync ist es in der Regel so dass die Panels die mit 60 Hz angesteuert werden, durch die VSync Funktion

auch 60 FPS darstellen, auch wenn die Grafikkarte mehr Bilder pro Sekunde liefern könnte.

Gleiches gilt natürlich bei Panels mit 120 Hz.

Das Display Overclocking erlaubt es nun die Frequenz des Monitors in 1 Hz-Schritten zu erhöhen.

Lässt beispielsweise ein 60 Hz Panel auch 80 Hz zu, werden bei aktivem VSync auch 80 FPS auf dem Monitor dargestellt,

was zu einem flüssigeren Spielerlebnis beitragen soll.

Hier das entsprechende Schaubild von NVIDIA zum Thema Displayoverclocking.

Quelle: NVIDIA

Mit dem entsprechenden Tool von EVGA lässt sich somit der Monitor "übertakten"

==================================================

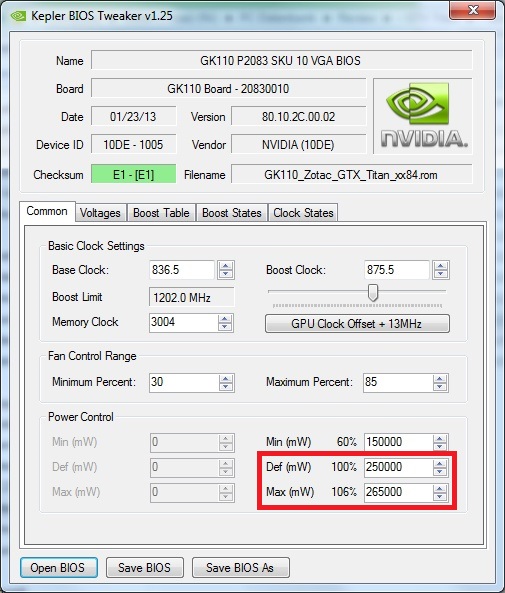

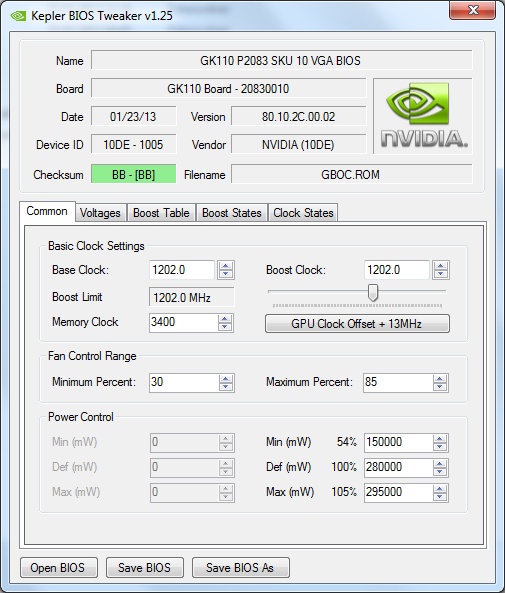

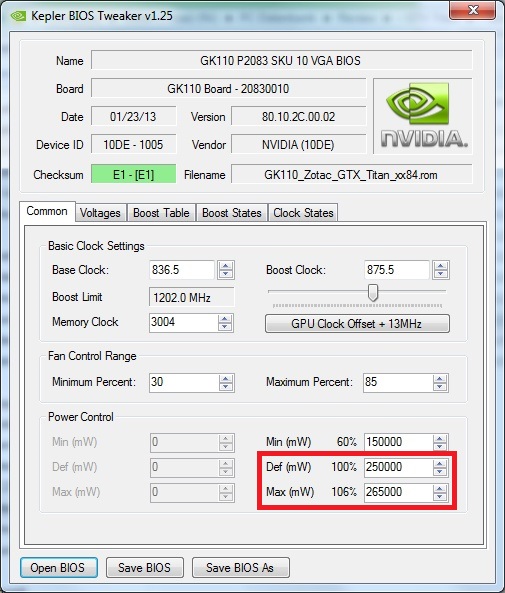

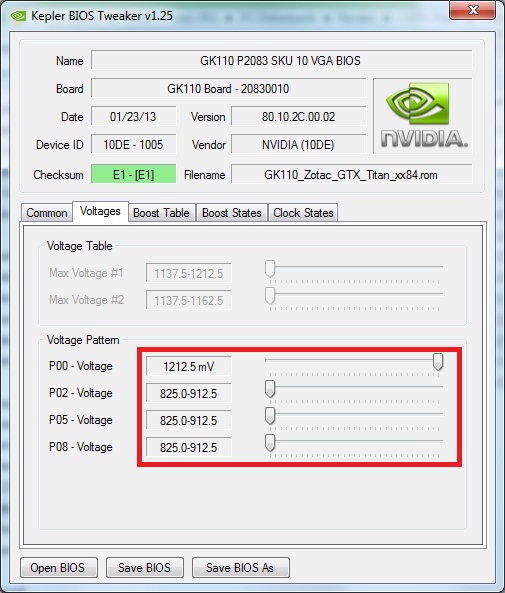

Bios anpassen

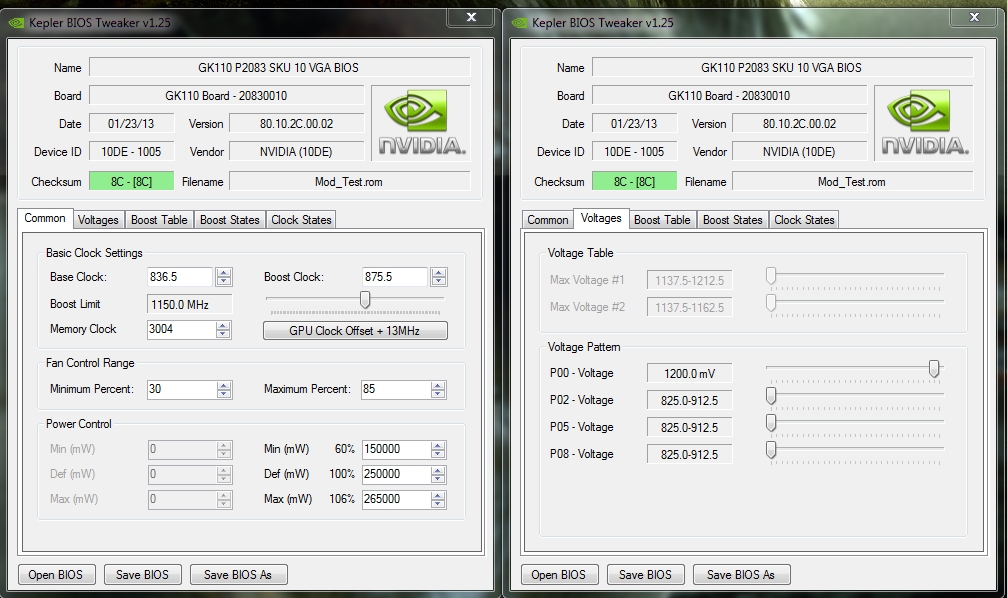

Zum editieren des Bios eignet sich zurzeit das Tool "Kepler Bios Tweaker" in der Version 1.25

In erster Line sollte es für viele interessant sein, das GPU Powertaget etwas anzupassen. Dazu gibt es mehrere Möglichkeiten.

Wie auf dem nächsten Bild zu sehen, ist für das Powertaget von 100% ein Wert von 250W respektive 265W bei 106% gesetzt.

Dies bedeutet dass die GPU bei eingestellten 100% maximal 250W nutzen darf.

Möchte man nun mehr als die 250/265W für die GPU freigeben, kann man diese Werte verändern.

Ob man dabei den 100% Wert auf 250 Watt belässt und den maximalen Prozentsatz auf z.B. 115% anhebt, oder ob man gleich eine höhere Wattzahl

für 100% definiert, kommt dabei auf gleiche raus.

Kleiner Unterschied, setzt man für 100% beispielsweise 280W ein, muss man später das Powertarget nicht mehr per Software anheben.

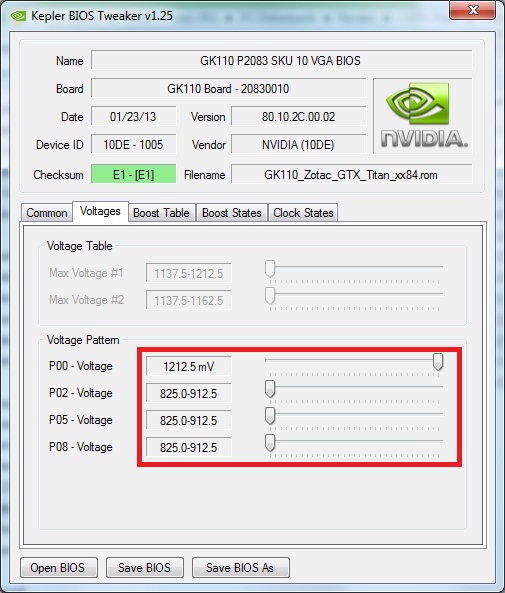

Des Weiteren kann man mittels des Editors die Spannung im Lastbetrieb auf maximale 1,2125v, wie schon zuvor erwähnt, anheben.

Hierzu muss auf dem Reiter "Voltages" der Regler P00 auf den entsprechenden Wert verändert werden.

Natürlich können auch Taktraten die zuvor auf Stabilität getestet wurden, fest im Bios eingetragen werden.

Ob man allerdings lieber per Software übertaktet oder die entsprechenden Daten gleich ins Bios einträgt, kann jeder für sich entscheiden.

Das Ergebnis sollte das gleiche sein.

==================================================

Bios flashen

Beim Flashen des Bios hat sich prinzipiell bei der GTX Titan nichts gegenüber den vorherigen Karten verändert.

Zum Aufspielen nutzt mal z.B. das Tool "nvFlash" in der aktuellen Version, welches als DOS- und Windows Version vorliegt.

Windows:

Der Vorgang selbst ist sehr simpel.

DOS:

Auch unter DOS sollte es kein Problem darstellen.

Das Ganze noch einmal bebildert um es etwas anschaulicher zu machen.

(Bilder stammen noch von der GTX480)

==================================================

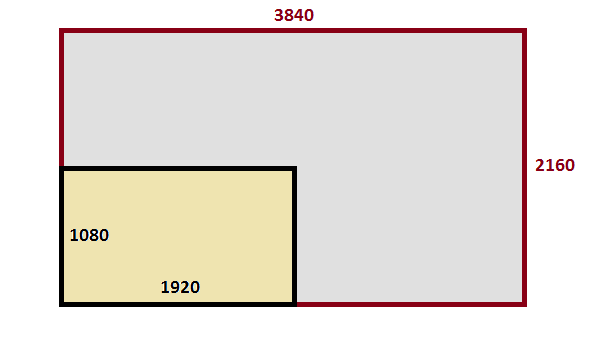

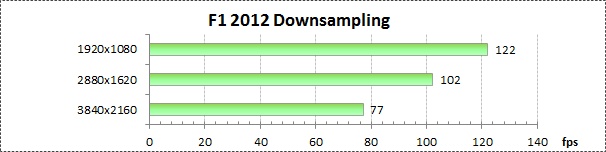

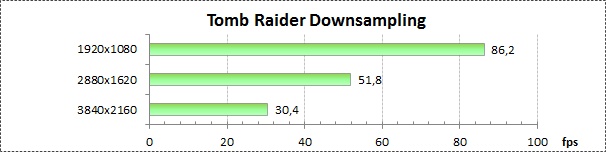

Downsampling

Downsampling ist simpel gesagt die Nutzung extrem hoher Auflösungen auf üblichen Bildschirmen.

Man hat zum Beispiel die Möglichkeit 3880x2160 Pixel, also die 4-fache Full HD Auflösung auf einem "normalen" 1080p Bildschirm zu betreiben.

Wer mehr dazu wissen möchte, kann diverse Reviews im Internet dazu lesen.

Hier z.B. ein How-To für AMD und NVIDIA Karten: Downsampling How-to: Bessere Grafik in jedem Spiel für Radeon und Geforce - Jetzt komplett überarbeitet

In diesem Fall möchte ich nur kurz auf die entsprechenden Einstellungen im NVIDIA Treibermenü eingehen.

Über die folgenden Schritte, lassen sich neue Auflösungen definieren und testen:

Ist der Test erfolgreich, wird die Auflösung gespeichert und steht nun auch in den Games zur Verfügung. Im meinem Fall zusätzlich zu 1920x1080 auch

2880x1620 und 3880x2160.

Wie sich aber sicherlich jeder denken kann, wird dafür sehr viel mehr Rechenleistung benötigt.

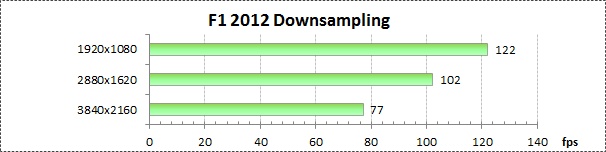

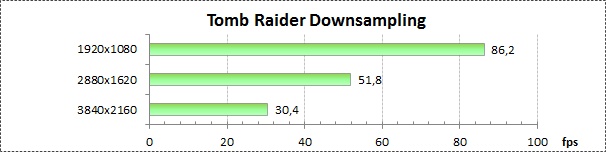

Wie sehr sich das auf die Performance in Spielen auswirkt, möchte ich ein einigen Beispielen darstellen:

Diablo 3:

F1 2012:

Tomb Raider:

==================================================

Einfluss PCIe Takt

... Tests folgen ...

==================================================

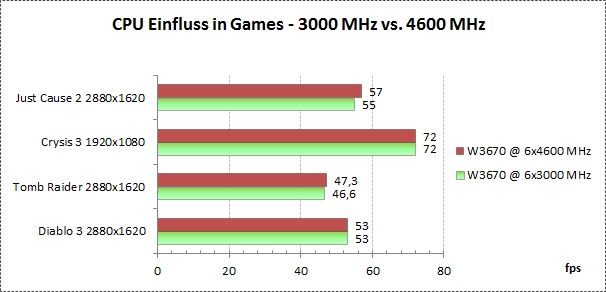

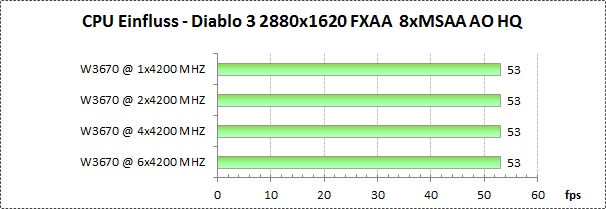

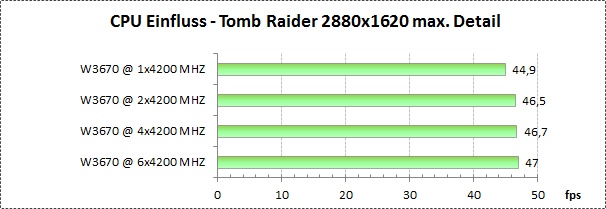

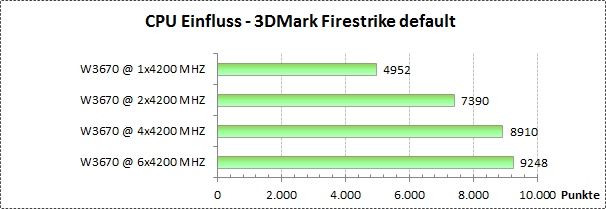

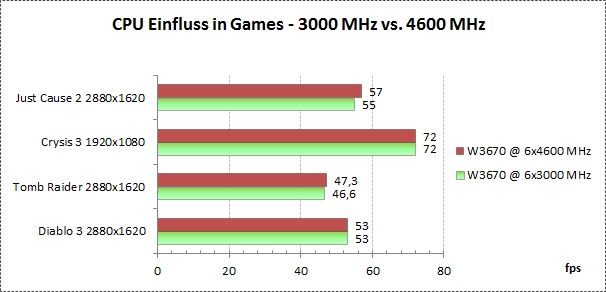

Einfluss CPU Takt

In diesem Abschnitt möchte ich erläutern wie viel, oder besser vorab schon gesagt, wie wenig Einfluss der CPU Takt auf

die Performance in Spielen hat. Sicherlich gibt es hier auch Ausnahmen, aber in den meisten Games spielt die Anzahl der

CPU Cores und auch deren Takt, zumindest im Single Betrieb einer GTX Titan bei hohen Auslösungen kaum eine Rolle.

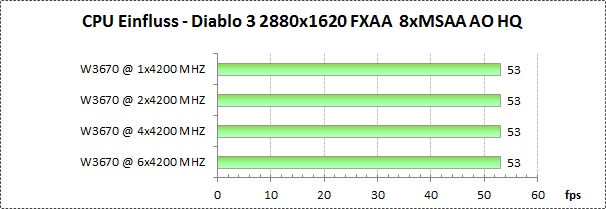

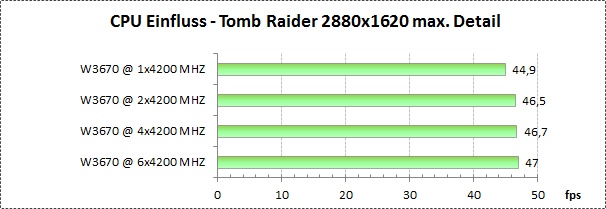

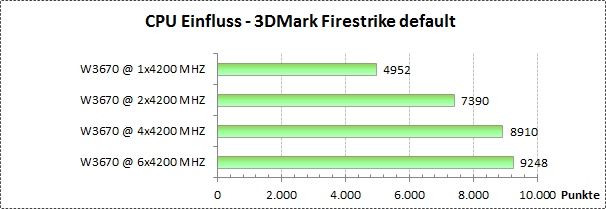

Bei Benchmarks sieht die Welt ein wenig anders aus.

Nachfolgend einige Diagramme die einmal den Leistungsunterschied bei unterschiedlichen Taktraten, und des Weiteren

bei unterschiedlicher Anzahl aktiver CPU Cores aufzeigen.

Games:

Benchmarks:

Diablo 3:

Tomb Raider:

3DMark Fire Strike:

==================================================

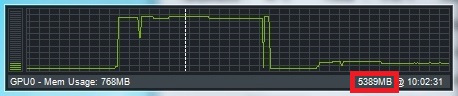

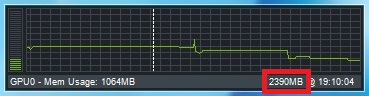

VRam Auslastung

Die GTX Titan hat ganze 6GB VRam, welche mit aktuellen Spielen nur schwer unter realistischen Bedingungen zu füllen sind.

Hier mal einige Beispiele wie stark der Speicher von verschiedenen Anwendungen ausgelastet wird.

Da die GTX Titan, gerade im SLI Verbund, richtig viel Power hat, macht es durchaus Sinn, mittels Downsampling und verschiedenster AO und AA Modi die

Darstellungsqualität nach oben zu schrauben. Solche Einstellungen belegen idR. auch mehr Grafikspeicher, sodass es nicht selten zu Speicherbelegungen

von 2-4 GB kommt. Um die 6 GB wirklich zu füllen, erfordert es schon extreme Einstellungen.

Bei einem Test hatte ich mittels Diablo 3, bei einer DS Auflösung von 3840x2160 sowie FXAA + 2x2 SSAA + 8x MSAA + AO = High Quality,

eine VRam-Belegung von knapp 5,4 GB. Bei solchen Qualitätseinstellungen werden aber oftmals nur noch sehr niedrige FPS Raten erreicht,

wodurch man solche Szenarien nicht immer als realistisch betrachten kann.

Um etwas realitätsbezogener zu bleiben, möchte ich die Speicherbelegung in einigen andern Situationen darstellen.

Nachfolgend ein paar Spiele in verschiedenen Auflösungen:

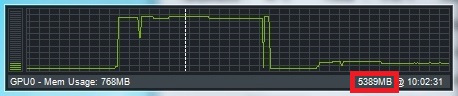

Tomb Raider 1920x1080 max. Details

Tomb Raider 2880x1620 max. Details

Tomb Raider 3840x2160 max. Details

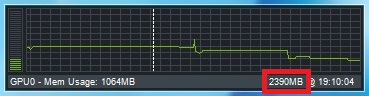

F1 2012 1920x1080 max. Details

F1 2012 2880x1620 max. Details

F1 2012 3840x2160 max. Details

Bei dem Thema fehlen natürlich noch einige wichtige Games, aber dazu hatte ich leider bisher noch nicht die Zeit.

... weitere Tests folgen ...

==================================================

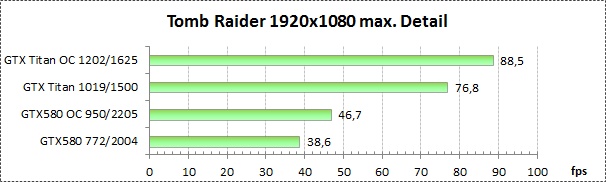

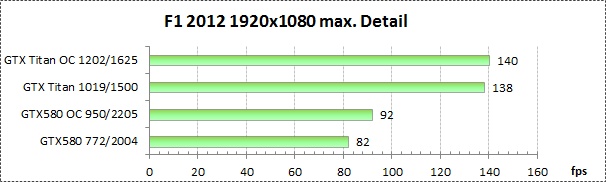

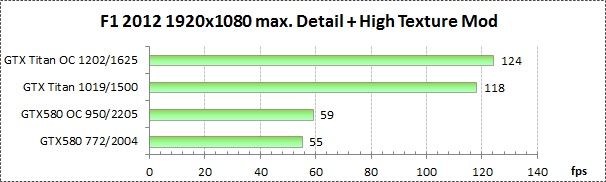

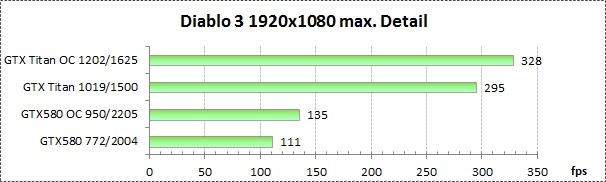

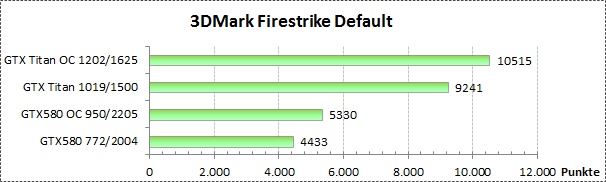

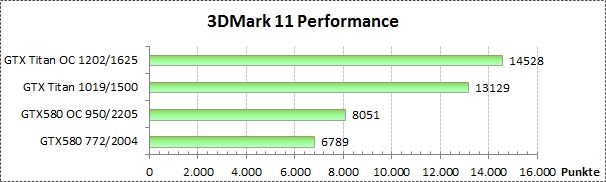

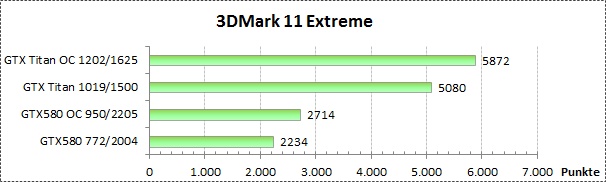

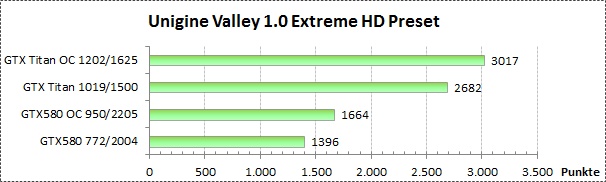

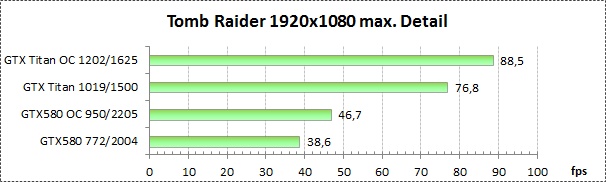

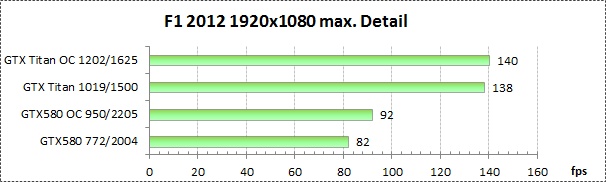

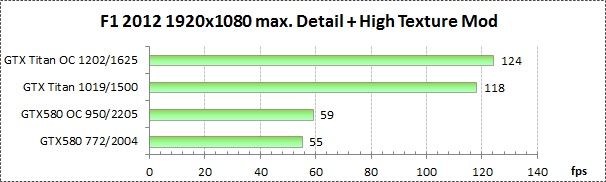

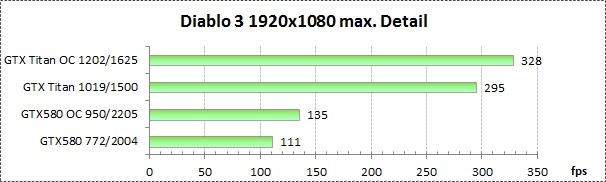

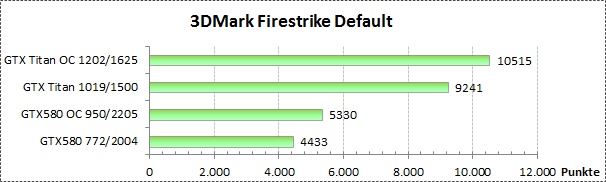

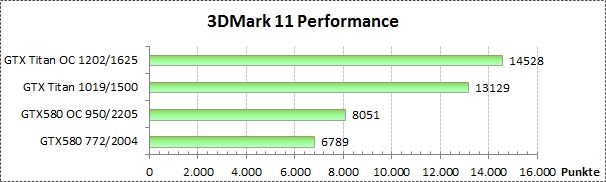

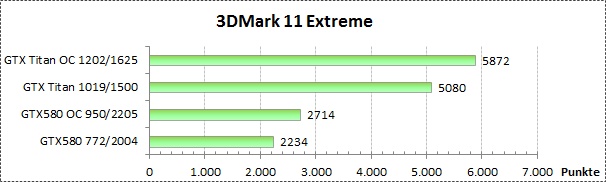

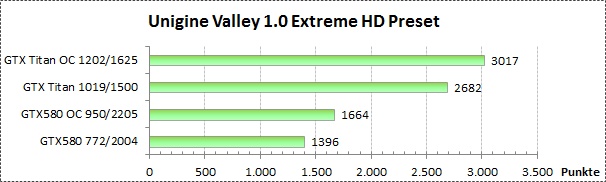

Vergleich GTX 580 / GTX Titan und Leistungszuwachs bei OC

Hier ein kleiner Vergleich zur ca. 2 Jahre alten GTX 580.

Getestet wurde im gleichen System und natürlich mit identischen Einstellungen.

Zusätzlich soll dargelegt werden, welchen Performancegewinn man durch alltags-taugliches Übertakten erreichen kann.

Zum Einsatz kommen jeweils die GTX 580 und GTX Titan bei folgenden Einstellungen:

Games

Tomb Raider:

F1 2012:

F1 2012 High Texture Mod:

Diablo 3:

Benchmarks

3DMark Firestike default:

3DMark 11 Performance:

3DMark 11 Extreme:

Unigine Heaven 4.0 Extreme:

Unigine Valley 1.0 Extreme HD:

... weitere Tests folgen ...

==================================================

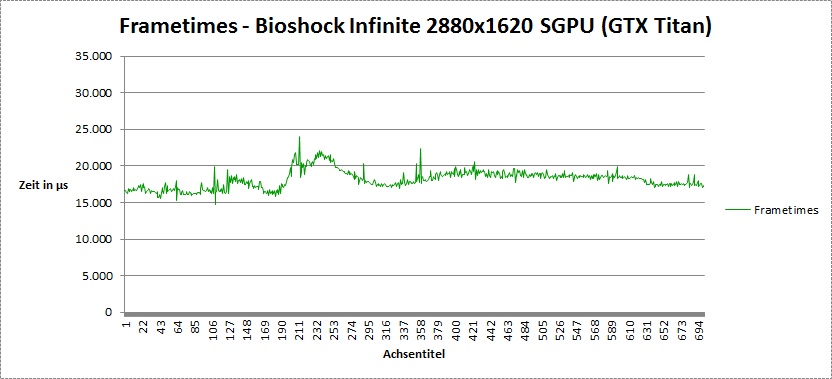

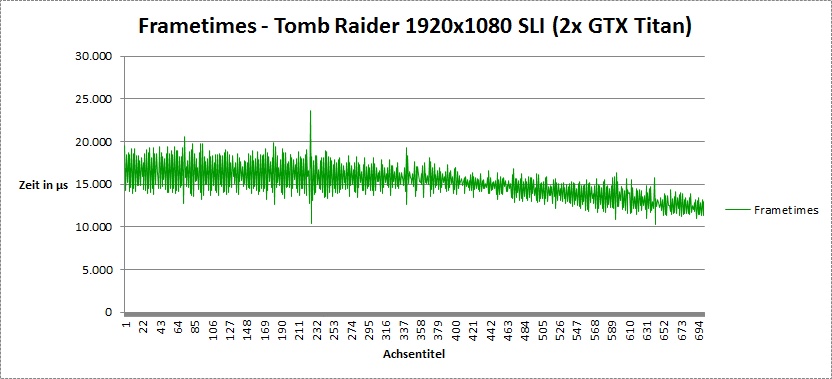

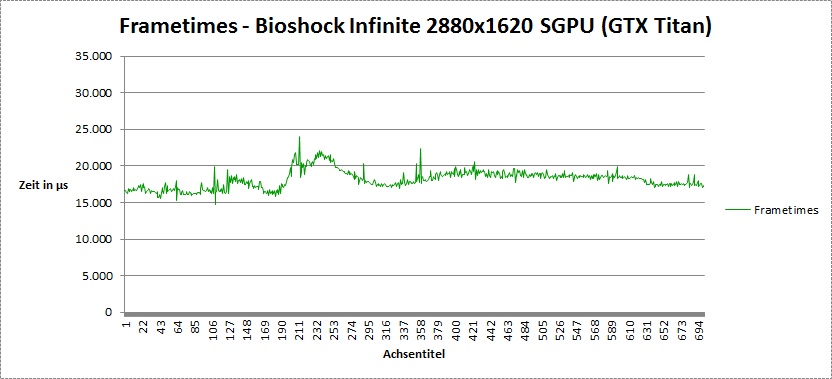

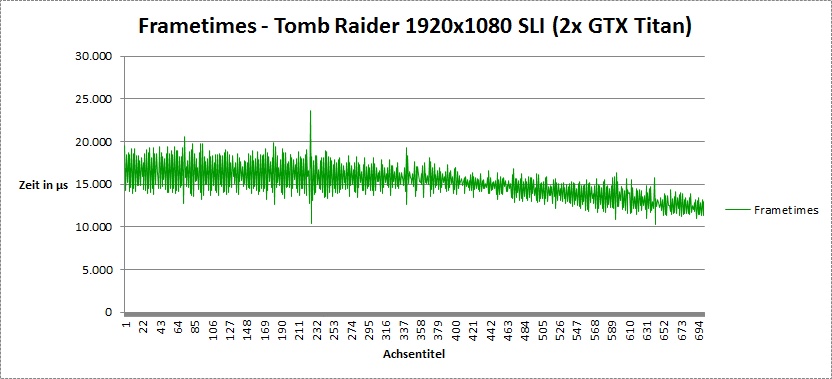

Frametimes

Da die Thematik der Microruckler immer noch ein leidiges Thema ist, werde ich auch hier kurz darauf eingehen.

Für die User, denen das kein Begriff ist, vielleicht eine kurze Erklärung.

Frametimes sind die Zeitabstände zwischen zweier Frames, sprich der Abstand zwischen Frame 1 und 2, ... und 2 und 3 ... usw.

Optimaler Weise sollten diese natürlich immer möglichst gleich groß sein. Im Single GPU Bereich ist das auch in der Regel oft der Fall.

Sobald aber mehr als eine Karte zum Einsatz kommt, ist es offenbar seitens der Hersteller nicht einfach, diese Zeitabstände gleich zu halten.

Wobei man hier auch erwähnen sollte, dass NVIDIA schon deutliche Besserungen in dieser Thematik erzielt hat, dennoch ist das Thema nach wie vor nicht vom Tisch.

Merklich störend wirken diese sog. Microruckler eigentlich nur ein Framebereichen von 0 bis ca. 50FPS.

Wenn ein Spiel mit mehr FPS läuft, sind diese nur schwer bis gar nicht wahrnehmbar.

Dennoch wirkt ein Spiel mit einer Single GPU mit 35 FPS oftmals flüssiger als gleiches mir 50 AFR Frames (2x25 FPS) eines Multi GPU Systems.

Nachfolgend jeweils Frametimemessungen mit einer GTX Titan und Zweien im SLI.

An dieser Stelle möchte ich Edgecrusher86 (Profil: Edgecrusher86 - Forum de Luxx) danken, der so freundlich war,

einige SLI Tests für mich durchzuführen, da ich selbst nicht die Möglichkeit dazu hatte.

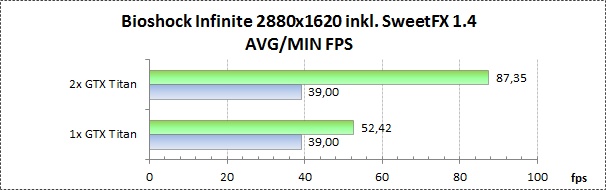

Bioshock Infinite:

Tomb Raider:

... weitere Tests folgen ...

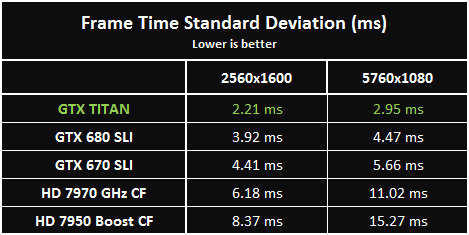

Was festzustellen ist, ist dass die MRs nach wie vor in Multi-GPU Systemen bestehen.

Früher waren diese zwar deutlich störender, was nun nicht mehr so stark der Fall ist, dennoch ist die Problematik existent.

Meiner Meinung nach versucht NVIDIA weiterhin aktiv an der AFR Problematik zu arbeiten um in diesem Bereich Besserungen zu bewirken.

Bei AMD scheint dort leider seit geraumer Zeit nichts mehr zu passieren, was eigentlich sehr schade ist. Zwar behelfen sich viele User

mittels VSync und Framelimiter um der Wahrnehmung der unterschiedlichen Frameanstände entgegen zu wirken, was aber wiederum teilweise den

Mehrwert von MGPU Systemen zunichtemacht.

Wer hier etwas mehr lesen möchte, sollte sich evtl. diesen Artikel näher ansehen:

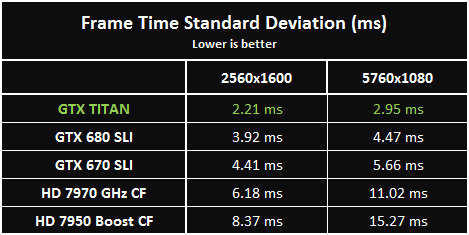

NVIDIA GTX TITAN vs. SLI & Crossfire - Page 10

An dieser Stelle ist auch eine ganz nette Zusammenfassung über die Standardabweichung der Frametimes zu finden:

Bildquelle: http://images.hardwarecanucks.com/image//skymtl/GPU/TITAN-VS-SLI/TITAN-VS-SLI-3.jpg [30.03.2013]

==================================================

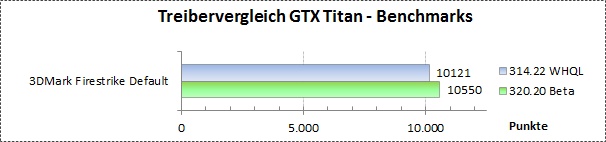

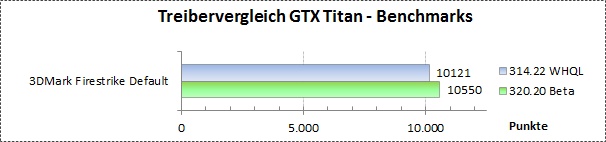

Treibervergleiche

Bisher waren nur die Treiber GeForce 314.21 Beta und 314.22 WHQL im Einsatz, welche zwar in einigen Spielen eine unterschiedliche Performance zeigen,

allerdings lässt sich im Gesamtbild kein nennenswerter Performancezuwachs feststellen.

An dieser Stelle macht es sicherlich mehr Sinn, nach einiger Zeit, weiterentwickelte Treiber mit etwa den Release Treibern zu vergleichen.

Zu gegebener Zeit folgen Vergleichstests.

Update 24.04.2013

Anlässlich des neuen Betatreibers "GeForce 320.00 Beta" NVIDIA DRIVERS 320.00BETA anbei ein kleiner Vergleich des 314.22 mit dem genannten Beta Treiber.

... weitere Tests folgen ...

==================================================

Vergleich AA und AO

... Tests folgen ...

==================================================

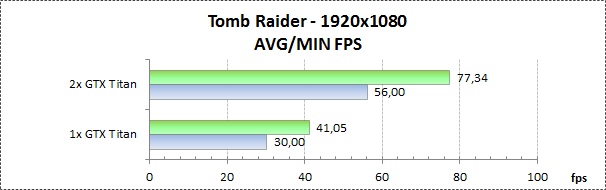

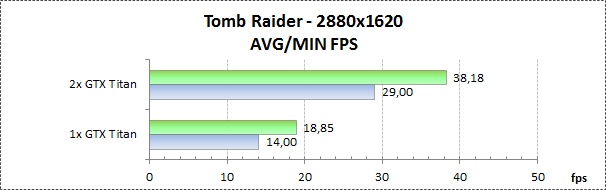

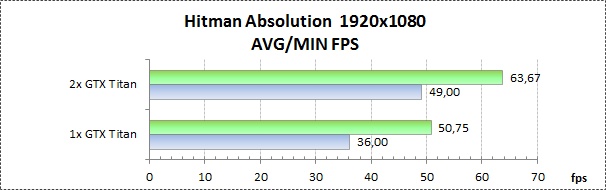

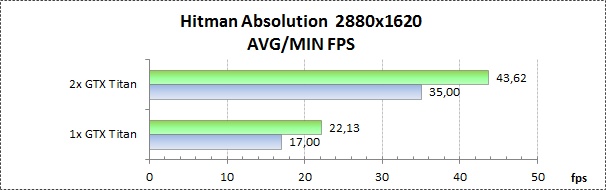

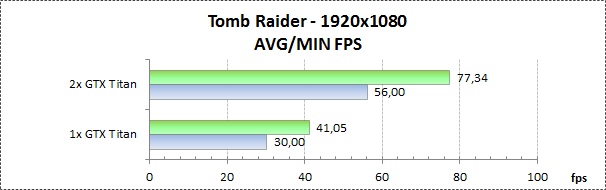

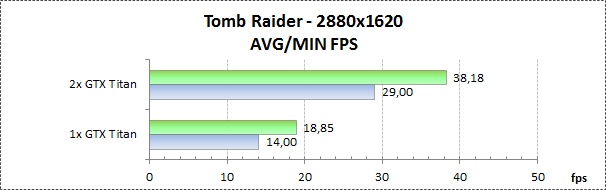

SLI Skalierung

Auch das Thema SLI wollte ich etwas anreißen.

Früher war es leider oft so, dass es noch viele Anwendungen und Spiele gab, die SLI nicht ordentlich nutzen konnten. Mittlerweile sieht das schon ganz anders aus.

Zwar werden nicht in allen Games die unten zu sehenden Werte erreicht, aber dennoch sieht die Unterstützung der Spiele bzw. die Weiterentwicklung der Treiber sehr gut aus.

Auch an dieser Stelle gilt der Dank an Edgecrusher86 (Profil: Edgecrusher86 - Forum de Luxx) von dem diese Ergebnisse stammen.

Testsystem:

Tomb Raider:

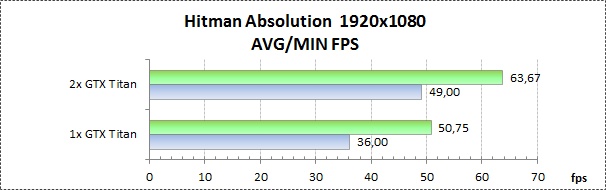

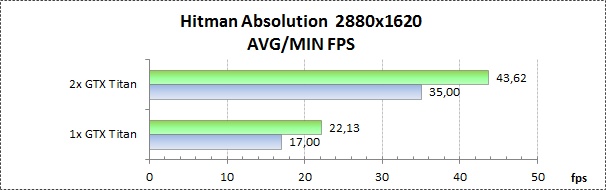

Hitman Absolution:

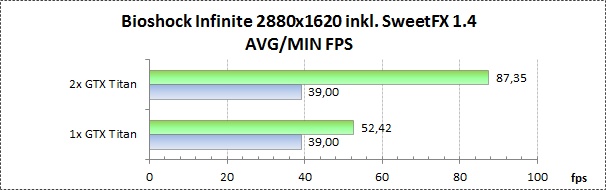

Bioshock Infinite:

... weitere Tests folgen ...

==================================================

Verschiedenes

3DMark Fire Strike Run @ 1241/1800 (7200) MHz bei 1,2v

==================================================

Am Ende möchte ich mich nochmals ganz herzlich bei Edgecrusher86 (Profil: Edgecrusher86 - Forum de Luxx) für die SLI Unterstützung und vor allem auch bei Naennon (Profil: Naennon - Forum de Luxx) für die Hilfestellung

bei den vielen technischen Fragen zum Bios und Powertarget, bedanken.

Für Anregungen und Kritik bin jederzeit dankbar und würde mich über Rückmeldung, Verbesserungsvorschläge und auch gerne Wünsche für weitere Tests freuen.

Allgemeine Fragen zu der Karte, bitte im GTX Titan Sammelthread stellen.

Vielen Dank

Gruß Olli

Wichtig! ... NEUSTE Benches/Tests/Ergebnisse fließen immer in den ersten Post mit ein.

Nachdem ich die GTX 680 erfolgreich überspringen konnte, habe ich mich mal wieder dazu entschlossen, ein kleines Review zu schreiben.

Grundsätzlich will ich die GTX Titan so ausführlich wie möglich testen, sowie die Leistung mit und ohne OC darzulegen.

Später werde ich noch Einfluss des CPU Taktes, Treibervergleiche und Stromverbrauch in den Test einfließen lassen.

Auch Themen wie Boost 2.0, Bios editieren/flashen, Downsampling, Displayoverclocking, Treibereinstellungen usw. werden behandelt.

Unter anderem werde ich auch noch auf Vergleiche zur GTX 580, sowie die SLI Skalierung und das damit verbundene

AFR Problem (Microruckler Problematik) in das Review aufnehmen.

==================================================

Zum Testsystem:

- Asus Rampage III Extreme

- Intel W3670 4,2GHz (4,6GHz)

- 6x4GB Patriot 2000EL (2000 MHz 9-11-9-27)

- Zotac GTX 580 @ 772/1544/2004 (default)

- Zotac GTX 580 @ 950/1900/2205

- Zotac GTX Titan (default)

- Zotac GTX Titan @ 1202/1625

- Crucial M4 CT128M4SSD2 SSD (128GB)

- Seasonic X-850 Semi passiv 850W

- CPU und GTX580 unter Wakü

In den Tests kommt jeweils ein absolut identisches System zum Einsatz, so dass keine externen Parameter die Ergebnisse beeinflussen.

Ich möchte noch im Voraus sagen, dass ich bisher noch nicht alle Dinge testen konnte, sobald ich Zeit finde, kommen neue Tests hinzu!

Über Anregungen und Wünsche würde ich mich natürlich freuen, auf die ich, wenn ich die Möglichkeit habe, eingehen will!

So dann erst mal zu Beginn ein paar Bilder:

Zotac GTX Titan

(alle Bilder zum Vergrößern anklicken (1920x1200))

Zum Messen der Oberflächentemperaturen kommt folgendes Infrarotthermometer zum Einsatz:

==================================================

Erste Eindrücke

Erste Eindrücke der Karte, welche ich sammeln konnte liste ich hier einfach mal stichpunktartig auf, um die Übersicht zu wahren:

- Die GTX Titan ist sauber und ordentlich verarbeitet und macht einen soliden und sehr, sehr hochwertigen Eindruck.

- Idle ist die Karte sehr leise bzw. schlichtweg nicht hörbar (Lüfter 30%)

- Auch im 3D Betrieb ist die GTX Titan zwar kein Leisetreter, aber trotzdem noch sehr angenehm, was die Geräuschentwicklung angeht.

- Bei 85% Lüfterdrehzahl ist die Karte schon recht gut hörbar, aber so hoch muss der Lüfter in der Regel nicht drehen.

- Was die Leistung angeht, kann ich nur sagen - wow! In vielen Bereichen wird mehr als die doppelte Leistung einer GTX 580 erreicht. Aber dazu später mehr.

- Umbau des Kühlers auf Wasserkühlung ist sehr einfach. Mit etwas Geschick sollte dies für jeden zu bewerkstelligen sein.

- Die Leistungsaufnahme unter Last ist angesichts der beeindruckenden Leistung, erstaunlich niedrig.

==================================================

Spannung, Taktraten und Boost

Die GTX Titan hat einen Basistakt von 837 MHz Core und 1500(6008) MHz VRam. Wenn mehr Leistung benötigt wird, taktet die Grafikkarte auf einen sog. „Boost Clock“

welcher in dem Fall bei 876 MHz liegt. Dieser Wert hat allerdings wenig Aussagekraft, da die Karte je nach Umgebungsparametern deutlich höher taktet.

Maximaler Boosttakt:

Der maximale Boosttakt den die GTX Titan annimmt hängt in erster Linie von dem ASIC Wert

der jeweiligen Karte ab. Je höher dieser "Qualitätswert" desto höher ist auch der vor gesteuerte

maximale Takt (68% ASIC ergibt zum Beispiel 980 MHz Boosttakt, 72% 993 MHz, 77% 1006 MHz und 81% ergeben 1019 MHz).

ASIC Tabelle:

Wird die GPU nun übertaktet geschieht dies über den Offsettakt (z.B. +100 MHz).

Gehen wir einmal von einem default Boosttakt von 1019 MHz aus, würden sich bei eingestellten +100 MHz theoretisch 1119 MHz ergeben.

Da diese Taktstufe aber nicht existiert (Kepler taktet in 13 MHz Schritten), wird die nächst niedrigere Stufe angenommen.

In diesem Fall 1110 MHz.

Zusätzlich wird bei jeder Anhebung der Spannungsstufe um 0,0125v, der Takt um weitere 13 MHz angehoben.

Wieder am Beispiel eines 1019 MHz Boosttaktes. 1019 MHz +100 MHz bei +0,0125v ergeben 1019 MHz +100 MHz +13 MHZ = 1132 MHz, auch diese

Taktstufe gibt es nicht, daher werden 1124 MHz angenommen.

Der jeweis max. mögliche Takt wird allerdings von dem Feature „Boost 2.0“ geregelt, dazu aber mehr im nächsten Abschnitt.

Die minimalen Taktraten für den Idle-Betrieb sind 324 MHz sowohl für den GPU Takt als auch für den Speicher.

GTX Titan verfügt über einen Spannungsbereich der von 0,825 - 1,2125v reicht.

Standardmäßig werden unter Last seitens NVIDIA max. 1,1625v für die GPU eingestellt. Dieser Wert kann allerdings per Software auf 1,200V erhöht werden

um evtl. höhere Taktraten zu erreichen. Mit einem Eingriff ins Bios lassen sich auch 1,2125v einstellen, dazu später mehr.

Wie erwähnt lassen sich diese Werte mittels Software verändern.

Nützliche Tools hierzu sind zur Zeit der "MSI Afterburner", "NVIDIA Inspector" oder etwa das

"EVGA Precision X" Tool in der Version 4.0.0. Später dazu mehr.

NVIDIA Inspector:

An dieser Stelle ein großes Lob an den User Orbmu2k (Profil: Orbmu2k - Forum de Luxx). Tolle, übersichtliche Software. Vielen Dank.

Natürlich lassen sich auch mit den oben genannten Tools, Parameter wie Takt, Powertarget, Temperaturlimit, Lüfterdrehzahl usw. ändern.

==================================================

Boost 2.0 verstehen

Wie bereits erwähnt ist das Feature Boost 2.0 dafür verantwortlich, welcher GPU Takt unter jeweiliger Last anliegt.

Hier sei vorab erwähnt dass nicht jede Grafikkarte die gleichen max. Boosttaktraten erreicht und diese auch je nach Anforderung verschieden hoch sein können.

Viele GTX Titan Karten takten aber per default über 1000 MHz.

Aber von was ist dieser Takt abhängig? Um den "richtigen" Takt zu finden überwacht NVIDIA einige Parameter aus deren Zusammenspiel dann der maximale Boosttakt ermittelt wird.

Dies ist kein einmaliger Vorgang, sondern ein fortlaufender Prozess, der ständig den Takt neu errechnet.

Folgende Parameter sind unter anderen ausschlaggebend:

Temperatur, Leistungsaufnahme der GPU, Lüfterdrehzahl und die Gesamtleistungsaufnahme der Karte.

Um das Taktverhalten auch in Bezug aufs Übertakten richtig einschätzen zu können, ist es wichtig zu verstehen

wie diese Parameter den anliegenden Takt und die Spannung verändern können.

Generell gilt, dass ein bestimmter Takt mit der dafür nötigen Spannung eingestellt wird, sofern alle Parameter "Grünes Licht" zeigen.

Wird nun ein, oder mehrere Parameter verletzt, wird der GPU Takt und die Spannung um einen Schritt gesenkt. Wenn dann alles "OK" ist, bleibt dieser Takt bestehen.

Reicht das Absenken nicht aus, wird Takt und Spannung weiter gesenkt.

Um das zu verdeutlichen möchte ich zu den verschiedenen Werten ein paar Worte sagen.

Temperatur:

Dieser Parameter ist recht einfach zu verstehen. Je wärmer die GPU wird, desto wahrscheinlicher ist es, dass der Takt abgesenkt werden muss.

Als Beispiel, es liegt ein Takt von 1019 MHz an und die GPU liegt bei 79°C. Bei Erreichen der nächsten Temperaturschwelle von 80°C

merkt die Karte dass der Takt offenbar etwas zu hoch ist und senkt diesen auf 1006 MHz.

Per Software lässt sich zudem ein Wert für das sog. Temperaturtarget festlegen. Dieser befindet sich per default bei 80°C. Korrigiert man diesen Wert

nach oben hat das sowohl Einfluss auf das Lüfterverhalten als auch den Zeitpunkt ab wann der Takt gesenkt werden muss.

>> Was kann ich hier tun um das Absenken (das sog. Throtteln) zu verhindern? Ganz einfach, für niedrigere Temperaturen sorgen oder den Wert für

das Temperaturtarget nach oben verändern. <<

Leistungsaufnahme der GPU:

Das sog. GPU Powertarget regelt wie viel Watt die GPU selbst max. aufnehmen darf, bevor Takt und vGPU gesenkt werden.

Im Default BIOS ist das Powertarget auf 100% = 250W gesetzt und kann ohne Eingriff ins Bios auf 106% = 265W erhöht werden.

Im Prinzip ist auch dieses Verhalten recht einfach zu erklären. Wird die GPU gerade sehr stark gefordert, braucht diese mehr Leistung.

Werden nun die 250W erreicht, passiert das gleiche wie bei Erreichen des Temperaturlimits. Die Karte throttelt den GPU Takt.

>> Wie ist hier Abhilfe zu schaffen? Man erhöht das Powertarget. Bei eingestellten 106% setzt das Throtteln nicht bei 250 sondern erst bei 265W ein. <<

Lüfter:

Der Lüfter ist ein nicht so wichtiger Parameter. Dennoch will ich hier darauf hinweisen,

dass auch der Lüfter für das Absenken des Taktes verantwortlich sein kann. Ein manuelles Einstellen des Lüfters auf 85% mag zwar die Temperaturen

nach unten drücken, kann aber auch die Karte zum throtteln bringen.

Gesamtleistungsaufnahme der Karte:

Alle bisher genannten Werte können durch den Benutzer recht leicht beeinflusst werden, so dass schlussendlich ein höheres OC Ergebnis möglich ist.

Dem ist leider nicht so bei dem Gesamtlimit der GTX Titan. Es wurde seitens NVIDIA eine max. Leistungsaufnahme von 300W definiert, welche die Karte nutzen darf.

Unter diese 300W fallen sowohl die GPU selbst, der Videospeicher als auch das PCB. Daraus resultiert, dass selbst wenn alle andern Parameter "auf Grün stehen",

die Karte trotzdem throttelt, wenn diese 300W Marke überschritten wird. Dies dient zum Schutz der Hardware, verhindert aber oftmals bessere Übertaktungsergebnisse.

Um den letzten Abschnitt besser verstehen zu können, will ich es an einem Beispiel verdeutlichen:

Ich möchte gern einen Takt von 1215/3500 erreichen und stelle dazu 1,2v ein. Ich sorge für niedrige Temperaturen mittels Wasserkühlung.

Soweit beste Voraussetzungen um den Takt stabil zu betreiben. Erstes Problem an der Stelle ist, dass die 250W der GPU nicht ausreichen.

Auch das ist noch kein Problem, ich stelle den Powertarget Wert einfach auf 116%, somit darf die GPU 290W aufnehmen, was für den Takt ausreichen würde.

Unabhängig davon zählen aber immer noch die 300W für die gesamte Karte. In diesem Beispiel wären rein rechnerisch aber nur noch 10W für den VRam und das PCB übrig,

was nicht ausreichend wäre.

Allein für VRam und PCB sind grob 40 - 50W zu rechnen.

Ohne dieses Limit würde die GTX Titan nun 290W (GPU) + ca. 50W (VRAM und PCB) = 340W aufnehmen wollen.

Das passiert aber nicht, da die Gesamtleistungsaufnahme von 300W überschritten werden würde. Folglich behält die Karte nicht meine eingestellten 1215 MHz bei 1,200v.

Takt und Spannung werden soweit gesenkt, bis ein Takt erreicht wird für den die 300W ausreichend sind.

Wie oben schon erwähnt ist dies ein fortlaufender Prozess bei dem ständig GPU Takt und Spannung neu beurteilt werden.

Somit ist es durchaus möglich, dass zeitweilig der "gewünschte Takt" von 1215 MHz anliegt, dieser aber je nach Last deutlich unter 1200 MHz abfällt.

Typischerweise sieht die Taktkurve dann wie folgt aus:

Der Takt schwenkt zwischen 1189 und 1215 MHz und die GPU Spannung zw. 1,1625 und 1,200v.

>>> Abhilfe schafft hier nur die Möglichkeit diese 300W Sperre zu umgehen, dies soll aber nicht Teil meines Reviews sein. <<<

==================================================

Umbau auf Wakü:

Da für mich klar war, dass die Karte, obwohl der Kühler der bisher beste ist der NVIDIA gebaut hat,

etwas zu laut sein wird für einen Silent-PC, habe ich mich schon gleich dazu entschlossen auf Wakü um zurüsten.

Ich habe mich für den EK FC-Tian als Wasserkühler entschieden.

Um die Karte optisch etwas schicker zu machen und die Rückseite zu schützen, habe ich der GTX Titan zusätzlich eine entsprechende EK Backplate spendiert.

Der Umbau ist sehr einfach und problemlos. Anleitungen liegen sowohl der EK Backplate als auch dem Kühler bei und sind ordentlich beschrieben und bebildert.

Auf Wunsch kann ich den Vorgang aber gern genauer beschreiben, aber fürs erste sollten hier einige Bilder genügen.

(alle Bilder zum Vergrößern anklicken (1920x1080))

So sieht dann die GTX Titan nach dem Umbau mit EK Kühler und Backplate aus:

Hier noch ein paar Bilder der restlichen Wasserkühlung:

Generell habe ich mein System so konfiguriert dass es sowohl idle als auch unter Last kaum hörbar ist.

Zur Lüfter- und Pumpeneinstellung sowie zur Temperaturüberwachung kommt Aquasuite in der aktuellen Version 2013 zum Einsatz.

Um das Thema Wasserkühlung abzuschließen, gehe ich an dieser Stelle noch auf die Thematik der sog. Hotspots bzw. dem oft diskutieren "Wärmestau" unter Backplates ein.

Dazu lässt sich meinerseits nur sagen, dass sämtliche Diskussionen diesbezüglich völlig gegenstandslos sind, da die Temperaturen auf der Rückseite der GTX Titan

gänzlich unbedenklich sind. Dies gilt sowohl für die Speicherchips, als auch für die Stellen an denen sich die Spannungswandler befinden.

Hinzu kommt, dass sich die Temperaturen durch das Anbringen einer Backplate nicht negativ verändern.

Die beiden Grafiken sollten dies verdeutlichen.

Im folgenden Bild sind die Temperaturen an verschiedenen Stellen der Kartenrückseite zu sehen, nachdem die Umrüstung auf einen Wasserkühler stattgefunden hat.

Wie zu sehen ist, liegen alle Temperaturen weit im grünen Bereich.

Nachdem ich dann zusätzlich die EK Backplate montiert hatte, wurden die Temperaturen nochmals an zwei Stellen mittels Temperaturfühler zwischen

PCB und Backplate (bzw. zwischen VRam und Backplate) gemessen.

Da bei der EK Backpalte die Rams "mitgekühlt" werden, verbessert sich die Temperatur sogar leicht. Was man sicher sagen kann ist, dass dort keine

Verschlechterung stattfindet. Im Bereich der Spannungswandler steigt die Temperatur um ca. 2°C an.

Hier nochmal die Bilder in größerer Auflösung:

==================================================

Leistungsaufnahme

Zum Messen der Leistungsaufnahme dient mir ein Energy Check 3000.

Den direkten Verbrauch an der Karte kann ich leider nicht messen, somit sind alle angegebenen Werte jeweils die Verbrauchswerte des gesamten Systems.

Was die Leistungsaufnahme ohne Last sowie im Dualmonitorbetrieb hatte AMD Lange Zeit die Nase vorne, wenn’s ums Energie sparen geht.

Aber auch hier leistet NVIDIA mittlerweile richtig gute Arbeit.

Zum ersten möchte ich hier einige Vergleiche zur GTX 580 aufzeigen,

indem ich jeweils die Leistungsaufnahme der beiden Karten in verschiedenen Situationen darstelle.

Diagramme Leistungsaufnahme:

Bei den GTX480/580 Reviews bin ich noch recht viel darauf eingegangen wie sich die Leistungsaufnahme bei jeder Spannungs- und Taktstufe steigert.

Das zu protokollieren macht bei den Kepler GPUs wegen der Boost Funktionalität wenig Sinn, da wie oben erwähnt sich Takt und Spannung oft

sehr dynamisch verhalten. Je nach Übertaktungsgrad kratzt somit die Leistungsaufnahme der Karte oftmals an der 300 Watt Marke.

Durch die Boost Technologie wird einerseits je nach Situation die maximale Leistung ermöglichst indem ein möglichst hoher

Takt angelegt wird, was sicherlich ein deutlicher Vorteil gegenüber Grafikkarten ist, die einen festen Maximaltakt haben.

Auf der anderen Seite kann diese Boost Funktion auch deutlich zum Energie sparen beitragen.

Wird zum Beispiel, gerade bei älteren Spielen, wenig Leitung benötigt, werden Takt und Spannung teilweise sehr stark gesenkt,

dass die GTX Titan weniger als ein Drittel der max. Leistungsaufnahme aufweist.

Für die Übertakter unter euch kann es dennoch recht interessant sein, welche Parameter den größten Einfluss auf die Leistungsaufnahme haben.

Wie im Abschnitt "Boost 2.0 verstehen" beschrieben wird man beim Übertakten oftmals durch das 300 Watt Limit "aufgehalten".

Da z.B. auch ein übertakteter VRam mehr verbraucht, kann es von Vorteil sein, den VRam etwas weniger hoch zu takten, um ein paar Watt mehr

für die GPU "übrig zu haben".

Um grob einschätzen zu können, welche Änderungen am meisten "fressen" hier eine kleine Übersicht:

Vergleich Leistungsaufnahme:

==================================================

Overclocking

Overclocking

Zum übertakten der GTX Titan eigenen sich mehrere Tools ganz gut.

Zum einen der NVIDIA Inspector (z.Z. in der Version 1.9.7) OrbLog » Blog Archive » NVIDIA Inspector 1.95 – Tool

Und zum andern die von MSI und EVGA bereitgestellten Tools "MSI Afterburner" und "EVGA Precision X"

Alle sind denke ich inhaltlich weitestgehend selbsterklärend, wodurch ich nicht näher auf die Funktion der Tools eingehen werde.

Taktraten:

Die GTX Titan taktet standardmäßig im Idle-Betrieb mit jeweils 324 MHz GPU- und VRam Takt.

Unter Last wird der Videospeicher mit 1502 MHz betrieben. Der maximale GPU Takt wird, wie bereits oben beschrieben, mittels der Boost 2.0 Technologie ermittelt.

Der Takt der maximal versucht wird anzustreben hängt dabei von der Güte des Chips ab. Somit ist es möglich dass einige Karten auf "nur" 980 MHz "boosten", andere

aber 1006, 1019 oder mehr MHz erreichen. Ob dieser Takt allerdings dauerhaft bestehen bleibt hängt wiederum von den Parametern ab die den Boosttakt steuern, wie etwa

die Temperatur der Karte.

Übertakten:

Wenn man, wie ich die GTX 680 übersprungen hat, wundert man sich evtl., dass man die Taktraten nicht mehr direkt einstellen kann, sondern nun viel mehr einen

Offset zum Standard definieren muss. Dies gilt sowohl für die Taktraten, als auch für die GPU Spannung.

Die GPU lässt sich in 13 MHZ Schritten übertakten. Wenn man nun, wie in meinem Fall einen Deafult Boost Takt von 1019 MHz hat, erreicht man

beispielsweise 1110 MHz wenn man einen Offset von +100 MHz definiert.

Ähnlich verhält es sich beim VRam, auch dort muss der Mehrtakt gegenüber dem Basistakt angegeben werden. Der Grundtakt liegt hier bei 1502 MHz QDR was einen effektiven

Takt von 6008 MHz ergibt. An dieser Stelle muss man etwas darauf dachten dass man den Takt auf der Basis des DDR Taktes von 3004 MHz erhöht.

Stellt man beispielsweise einen Wert von +500 (3500) MHz ein, ergibt sich ein Takt von 1750, respektive 7000 effektiven MHz.

GPU Spannung

Beim Thema Spannungen gibt es nicht so viel zu sagen. Die Standard Boost Spannung liegt bei allen Karten bei maximal 1,1625v und kann um drei Stufen

auf 1,1750, 1,18725 oder 1,2000v per Software erhöht werden. Mittels Eingriff ins Bios kann die Spannung noch um eine weitere Stufe auf 1,2125v angehoben werden.

Stabilität testen

Um sicher zu stellen dass die Karte stabil arbeitet sollten die Taktraten ausführlich auf Stabilität getestet werden.

Generell kommt es mit der GTX Titan seltener vor, dass der Takt instabil ist als es mit früheren Generationen der Fall war, da oftmals das

Powerlimit erreicht wird was zur Folge hat, dass der Takt gesenkt wird.

Dennoch eignet sich 3DMark11 und vor allem die 3DMark Firestrike Demo ganz gut um die Taktraten in Bezug auf das Powertarget zu testen. Update - Natürlich eignen sich auch Games wie Assassin's Creed 3 sowie

Far Cry 3 und Just Cause 2 ganz gut um die eingestellten Werte auf Stabilität zu prüfen.

Ist ein bestimmter Takt nicht stabil, kommst es in den meisten Fällen zu einem Treiberrest, welcher die Taktraten auf die Default Werte zurückstellt.

Dabei wird der Bildschirm kurz schwarz.

Wird allerdings das Powertarget erreicht, senkt die Grafikkarte sowohl GPU Takt als auch die Spannung, um innerhalb der Spezifikationen bzgl. der

maximalen Leistungsaufnahme zu bleiben.

Dies merkt man aber idR. nicht während dem Spielen, da es ein sehr dynamischer Prozess ist. Gegebenenfalls wird auch der Takt und die Spannung wieder nach oben

korrigiert, wenn sich die GTX Titan wieder unterhalb des Powertargets befindet.

Um diese "Taktschwankungen" festzustellen, sind Tools nötig, die die Takt- und Spannungskurve aufzeichnen. NVIDIA Inspector ist hierzu gut geeignet.

Anbei zwei Beispiele, wie das aussehen kann.

Beispiel 1:

Ich möchte einen Takt von 1254 MHz anstreben, dieser wird auch angenommen und bleibt bestehen, da sich die Karte unterhalb des Powertargets bewegt.

Beispiel 2:

Ich starte eine andere Anwendung, die beispielsweise etwas GPU-lastiger ist. Wieder möchte ich einen Takt von 1254 MHz.

Fürs erste versucht die Grafikkarte diesen auch zu halten. Je nach Last kommt es aber dazu, dass das Limit der Leistungsaufnahme erreicht wird.

Somit werden Takt und GPU Spannung um ein bis zwei Stufen gesenkt, bzw. wieder erhöht, sobald die max. Leistungsaufnahme dies wieder zulässt.

Ergebnis ist, dass der Takt ständig zw. 1228 und 1254 MHz schwankt.

Man sollte also schon prüfen welcher Takt unter Last tatsächlich anliegt, denn es sind nicht zwingend 1200 MHz aktiv, nur weil diese einstellt!!

==================================================

Overclocking GPU vs. VRam - Was bringt mehr?

Zu diesem Thema will ich nicht viele Worte verlieren. Das Thema ist eigentlich selbsterklärend.

Anbei einige Tests die aufzeigen sollen, ob es mehr Sinn macht die GPU oder den Speicher zu übertakten oder etwa beides.

Ja nach Anwendung können die Ergebnisse natürlich unterschiedlich ausfallen. Spiele die etwa eine hohe Speicherbandbreite benötigen

regieren natürlich stärker auf das Übertakten des Speichers als welche die weniger auf einen hohen Durchsatz angewiesen sind.

Tomb Raider:

Unigine Valley:

... weitere Tests folgen ...

==================================================

Displayoverclocking

Eines der neuen Features von NVIDIA ist das sog. Displayoverclocking.

Ich möchte hier nur kurz auf das Thema eingehen.

Es hat eigentlich schon fast mehr mit dem Monitor als mit der Grafikkarte zu tun.

Bei aktivem VSync ist es in der Regel so dass die Panels die mit 60 Hz angesteuert werden, durch die VSync Funktion

auch 60 FPS darstellen, auch wenn die Grafikkarte mehr Bilder pro Sekunde liefern könnte.

Gleiches gilt natürlich bei Panels mit 120 Hz.

Das Display Overclocking erlaubt es nun die Frequenz des Monitors in 1 Hz-Schritten zu erhöhen.

Lässt beispielsweise ein 60 Hz Panel auch 80 Hz zu, werden bei aktivem VSync auch 80 FPS auf dem Monitor dargestellt,

was zu einem flüssigeren Spielerlebnis beitragen soll.

Hier das entsprechende Schaubild von NVIDIA zum Thema Displayoverclocking.

Quelle: NVIDIA

Mit dem entsprechenden Tool von EVGA lässt sich somit der Monitor "übertakten"

==================================================

Bios anpassen

Zum editieren des Bios eignet sich zurzeit das Tool "Kepler Bios Tweaker" in der Version 1.25

In erster Line sollte es für viele interessant sein, das GPU Powertaget etwas anzupassen. Dazu gibt es mehrere Möglichkeiten.

Wie auf dem nächsten Bild zu sehen, ist für das Powertaget von 100% ein Wert von 250W respektive 265W bei 106% gesetzt.

Dies bedeutet dass die GPU bei eingestellten 100% maximal 250W nutzen darf.

Möchte man nun mehr als die 250/265W für die GPU freigeben, kann man diese Werte verändern.

Ob man dabei den 100% Wert auf 250 Watt belässt und den maximalen Prozentsatz auf z.B. 115% anhebt, oder ob man gleich eine höhere Wattzahl

für 100% definiert, kommt dabei auf gleiche raus.

Kleiner Unterschied, setzt man für 100% beispielsweise 280W ein, muss man später das Powertarget nicht mehr per Software anheben.

Des Weiteren kann man mittels des Editors die Spannung im Lastbetrieb auf maximale 1,2125v, wie schon zuvor erwähnt, anheben.

Hierzu muss auf dem Reiter "Voltages" der Regler P00 auf den entsprechenden Wert verändert werden.

Natürlich können auch Taktraten die zuvor auf Stabilität getestet wurden, fest im Bios eingetragen werden.

Ob man allerdings lieber per Software übertaktet oder die entsprechenden Daten gleich ins Bios einträgt, kann jeder für sich entscheiden.

Das Ergebnis sollte das gleiche sein.

==================================================

Bios flashen

Beim Flashen des Bios hat sich prinzipiell bei der GTX Titan nichts gegenüber den vorherigen Karten verändert.

Zum Aufspielen nutzt mal z.B. das Tool "nvFlash" in der aktuellen Version, welches als DOS- und Windows Version vorliegt.

Windows:

Der Vorgang selbst ist sehr simpel.

- Verknüpfung der nvflash.exe erstellen.

- Bios File per "Drag&Drop" auf die Verknüpfung ziehen.

- Vorgang mit "y" bestätigen.

- FERTIG! PC neustarten.

DOS:

Auch unter DOS sollte es kein Problem darstellen.

- Bootfähige CD oder USB Stick erstellen

- NVFlash und das zu flashende Bios in der Form "Biosname.rom" auf die CD kopieren

- PC neustarten

- Von CD/USB booten

- Den Befehl 'NVFLASH -4 -5 -6 Biosname.rom' ausführen

- Mit 'y' bestätigen

- FERTIG! PC neustarten.

Das Ganze noch einmal bebildert um es etwas anschaulicher zu machen.

(Bilder stammen noch von der GTX480)

==================================================

Downsampling

Downsampling ist simpel gesagt die Nutzung extrem hoher Auflösungen auf üblichen Bildschirmen.

Man hat zum Beispiel die Möglichkeit 3880x2160 Pixel, also die 4-fache Full HD Auflösung auf einem "normalen" 1080p Bildschirm zu betreiben.

Wer mehr dazu wissen möchte, kann diverse Reviews im Internet dazu lesen.

Hier z.B. ein How-To für AMD und NVIDIA Karten: Downsampling How-to: Bessere Grafik in jedem Spiel für Radeon und Geforce - Jetzt komplett überarbeitet

In diesem Fall möchte ich nur kurz auf die entsprechenden Einstellungen im NVIDIA Treibermenü eingehen.

Über die folgenden Schritte, lassen sich neue Auflösungen definieren und testen:

Ist der Test erfolgreich, wird die Auflösung gespeichert und steht nun auch in den Games zur Verfügung. Im meinem Fall zusätzlich zu 1920x1080 auch

2880x1620 und 3880x2160.

Wie sich aber sicherlich jeder denken kann, wird dafür sehr viel mehr Rechenleistung benötigt.

Wie sehr sich das auf die Performance in Spielen auswirkt, möchte ich ein einigen Beispielen darstellen:

Diablo 3:

F1 2012:

Tomb Raider:

==================================================

Einfluss PCIe Takt

... Tests folgen ...

==================================================

Einfluss CPU Takt

In diesem Abschnitt möchte ich erläutern wie viel, oder besser vorab schon gesagt, wie wenig Einfluss der CPU Takt auf

die Performance in Spielen hat. Sicherlich gibt es hier auch Ausnahmen, aber in den meisten Games spielt die Anzahl der

CPU Cores und auch deren Takt, zumindest im Single Betrieb einer GTX Titan bei hohen Auslösungen kaum eine Rolle.

Bei Benchmarks sieht die Welt ein wenig anders aus.

Nachfolgend einige Diagramme die einmal den Leistungsunterschied bei unterschiedlichen Taktraten, und des Weiteren

bei unterschiedlicher Anzahl aktiver CPU Cores aufzeigen.

Games:

Benchmarks:

Diablo 3:

Tomb Raider:

3DMark Fire Strike:

==================================================

VRam Auslastung

Die GTX Titan hat ganze 6GB VRam, welche mit aktuellen Spielen nur schwer unter realistischen Bedingungen zu füllen sind.

Hier mal einige Beispiele wie stark der Speicher von verschiedenen Anwendungen ausgelastet wird.

Da die GTX Titan, gerade im SLI Verbund, richtig viel Power hat, macht es durchaus Sinn, mittels Downsampling und verschiedenster AO und AA Modi die

Darstellungsqualität nach oben zu schrauben. Solche Einstellungen belegen idR. auch mehr Grafikspeicher, sodass es nicht selten zu Speicherbelegungen

von 2-4 GB kommt. Um die 6 GB wirklich zu füllen, erfordert es schon extreme Einstellungen.

Bei einem Test hatte ich mittels Diablo 3, bei einer DS Auflösung von 3840x2160 sowie FXAA + 2x2 SSAA + 8x MSAA + AO = High Quality,

eine VRam-Belegung von knapp 5,4 GB. Bei solchen Qualitätseinstellungen werden aber oftmals nur noch sehr niedrige FPS Raten erreicht,

wodurch man solche Szenarien nicht immer als realistisch betrachten kann.

Um etwas realitätsbezogener zu bleiben, möchte ich die Speicherbelegung in einigen andern Situationen darstellen.

Nachfolgend ein paar Spiele in verschiedenen Auflösungen:

Tomb Raider 1920x1080 max. Details

Tomb Raider 2880x1620 max. Details

Tomb Raider 3840x2160 max. Details

F1 2012 1920x1080 max. Details

F1 2012 2880x1620 max. Details

F1 2012 3840x2160 max. Details

Bei dem Thema fehlen natürlich noch einige wichtige Games, aber dazu hatte ich leider bisher noch nicht die Zeit.

... weitere Tests folgen ...

==================================================

Vergleich GTX 580 / GTX Titan und Leistungszuwachs bei OC

Hier ein kleiner Vergleich zur ca. 2 Jahre alten GTX 580.

Getestet wurde im gleichen System und natürlich mit identischen Einstellungen.

Zusätzlich soll dargelegt werden, welchen Performancegewinn man durch alltags-taugliches Übertakten erreichen kann.

Zum Einsatz kommen jeweils die GTX 580 und GTX Titan bei folgenden Einstellungen:

- GTX 580 @ default (772/2004)

- GTX 580 OC (950/2205)

- GTX Titan @ deafult Boost (1019/3004)

- GTX Titan OC (1202/3250)

Games

Tomb Raider:

F1 2012:

F1 2012 High Texture Mod:

Diablo 3:

Benchmarks

3DMark Firestike default:

3DMark 11 Performance:

3DMark 11 Extreme:

Unigine Heaven 4.0 Extreme:

Unigine Valley 1.0 Extreme HD:

... weitere Tests folgen ...

==================================================

Frametimes

Da die Thematik der Microruckler immer noch ein leidiges Thema ist, werde ich auch hier kurz darauf eingehen.

Für die User, denen das kein Begriff ist, vielleicht eine kurze Erklärung.

Frametimes sind die Zeitabstände zwischen zweier Frames, sprich der Abstand zwischen Frame 1 und 2, ... und 2 und 3 ... usw.

Optimaler Weise sollten diese natürlich immer möglichst gleich groß sein. Im Single GPU Bereich ist das auch in der Regel oft der Fall.

Sobald aber mehr als eine Karte zum Einsatz kommt, ist es offenbar seitens der Hersteller nicht einfach, diese Zeitabstände gleich zu halten.

Wobei man hier auch erwähnen sollte, dass NVIDIA schon deutliche Besserungen in dieser Thematik erzielt hat, dennoch ist das Thema nach wie vor nicht vom Tisch.

Merklich störend wirken diese sog. Microruckler eigentlich nur ein Framebereichen von 0 bis ca. 50FPS.

Wenn ein Spiel mit mehr FPS läuft, sind diese nur schwer bis gar nicht wahrnehmbar.

Dennoch wirkt ein Spiel mit einer Single GPU mit 35 FPS oftmals flüssiger als gleiches mir 50 AFR Frames (2x25 FPS) eines Multi GPU Systems.

Nachfolgend jeweils Frametimemessungen mit einer GTX Titan und Zweien im SLI.

An dieser Stelle möchte ich Edgecrusher86 (Profil: Edgecrusher86 - Forum de Luxx) danken, der so freundlich war,

einige SLI Tests für mich durchzuführen, da ich selbst nicht die Möglichkeit dazu hatte.

Bioshock Infinite:

Tomb Raider:

... weitere Tests folgen ...

Was festzustellen ist, ist dass die MRs nach wie vor in Multi-GPU Systemen bestehen.

Früher waren diese zwar deutlich störender, was nun nicht mehr so stark der Fall ist, dennoch ist die Problematik existent.

Meiner Meinung nach versucht NVIDIA weiterhin aktiv an der AFR Problematik zu arbeiten um in diesem Bereich Besserungen zu bewirken.

Bei AMD scheint dort leider seit geraumer Zeit nichts mehr zu passieren, was eigentlich sehr schade ist. Zwar behelfen sich viele User

mittels VSync und Framelimiter um der Wahrnehmung der unterschiedlichen Frameanstände entgegen zu wirken, was aber wiederum teilweise den

Mehrwert von MGPU Systemen zunichtemacht.

Wer hier etwas mehr lesen möchte, sollte sich evtl. diesen Artikel näher ansehen:

NVIDIA GTX TITAN vs. SLI & Crossfire - Page 10

An dieser Stelle ist auch eine ganz nette Zusammenfassung über die Standardabweichung der Frametimes zu finden:

Bildquelle: http://images.hardwarecanucks.com/image//skymtl/GPU/TITAN-VS-SLI/TITAN-VS-SLI-3.jpg [30.03.2013]

==================================================

Treibervergleiche

Bisher waren nur die Treiber GeForce 314.21 Beta und 314.22 WHQL im Einsatz, welche zwar in einigen Spielen eine unterschiedliche Performance zeigen,

allerdings lässt sich im Gesamtbild kein nennenswerter Performancezuwachs feststellen.

An dieser Stelle macht es sicherlich mehr Sinn, nach einiger Zeit, weiterentwickelte Treiber mit etwa den Release Treibern zu vergleichen.

Zu gegebener Zeit folgen Vergleichstests.

Update 24.04.2013

Anlässlich des neuen Betatreibers "GeForce 320.00 Beta" NVIDIA DRIVERS 320.00BETA anbei ein kleiner Vergleich des 314.22 mit dem genannten Beta Treiber.

... weitere Tests folgen ...

==================================================

Vergleich AA und AO

... Tests folgen ...

==================================================

SLI Skalierung

Auch das Thema SLI wollte ich etwas anreißen.

Früher war es leider oft so, dass es noch viele Anwendungen und Spiele gab, die SLI nicht ordentlich nutzen konnten. Mittlerweile sieht das schon ganz anders aus.

Zwar werden nicht in allen Games die unten zu sehenden Werte erreicht, aber dennoch sieht die Unterstützung der Spiele bzw. die Weiterentwicklung der Treiber sehr gut aus.

Auch an dieser Stelle gilt der Dank an Edgecrusher86 (Profil: Edgecrusher86 - Forum de Luxx) von dem diese Ergebnisse stammen.

Testsystem:

Hardware: Core i7-2600K @ 4,2 GHz, Intel Z68, 2 x 4 GB DDR3-1866

Software/Drivers: Windows 7 x64 SP1 Professional, GeForce 314.22 WHQL (HQ AF)

Tomb Raider:

Hitman Absolution:

Bioshock Infinite:

... weitere Tests folgen ...

==================================================

Verschiedenes

3DMark Fire Strike Run @ 1241/1800 (7200) MHz bei 1,2v

==================================================

Am Ende möchte ich mich nochmals ganz herzlich bei Edgecrusher86 (Profil: Edgecrusher86 - Forum de Luxx) für die SLI Unterstützung und vor allem auch bei Naennon (Profil: Naennon - Forum de Luxx) für die Hilfestellung

bei den vielen technischen Fragen zum Bios und Powertarget, bedanken.

Für Anregungen und Kritik bin jederzeit dankbar und würde mich über Rückmeldung, Verbesserungsvorschläge und auch gerne Wünsche für weitere Tests freuen.

Allgemeine Fragen zu der Karte, bitte im GTX Titan Sammelthread stellen.

Vielen Dank

Gruß Olli

Zuletzt bearbeitet:

)

)