LOL ist das Ironie oder meinst du das ernst ? GK 104 50% vor der GTX 580 ja klar träum weiter ^^

Je nachdem wie wichtig NV der Verbrauch ist wird der GK 104 bestenfalls knapp unter der 7970 sein.

Wird am Ende vermutlich wie seit der 4870 sein, die schnellste AMD Karte ist gleich schnell wie die 2t schnellste ( GTX 770 ) von NV.

Alles andere sind Traumfantasien von NV Fanboys.

Ich bin also "NV Fanboy" weil ich versuche anhand derzeitiger Gerüchte mögliche Leistung zu spekulieren? Na dann...

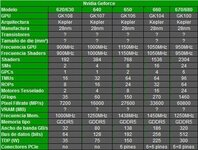

Nur mal zusammengefasst. Es stehen für den GK104 ~1000 ALUs, keine HotClocks, dafür aber deutlich über Tahiti als Basistakt sowie über 2TFlops/s im Raum. Dazu womöglich 64 TMUs und 32 ROPs + 256Bit SI und 2GB VRAM.

Mögliche 1024 ALUs wäre ne Verdopplung der 580er in Sachen ALUs, der Wegfall der HotClocks wiegt diesen Vorteil wieder auf. In Summe wäre es quasi ohne tiefgründige Architekturänderungen eine GTX580 in 28nm mit beschnittenem SI und beschnittenen ROPs, dafür aber mit spekulierten ~40% mehr Takt.

Ich als von dir betitelter NV Fanboy gehe stark davon aus, das man durch 40% mehr Takt im Vergleich dazu nicht nur 10% mehr Leistung rausbekommt im Vergleich. Das wäre in Sachen Performance pro Ausführungseinheiten ein deutlicher Rückschritt zum GF110. Daher die Ansage auf die 40-50% inkl. hier und da ner Optimierung.

Das würde sogar zum bisherigen Newsstand passen, das GK104 womöglich sehr lange Zeit die schnellste Kepler Karte wird und der GK100 erst gegen Ende des Jahres kommt (vllt auch noch später)

Ansonsten habe ich heut früh schon geschrieben, ich spekuliere damit, das NV das womöglich interne "Taktziel" nicht erreicht und die GPU irgendwo im Bereich 950-1000MHz ansetzt. Das wären dann grobe 20-25% mehr Takt. Durch die verminderte ROP Leistung könnte hier ein kleiner Flaschenhals entstehen in Sachen AA... Womöglich liegt hier der Hund begraben und das Teil als Performancekarte lässt hier leicht Federn (was nicht zu verdenken wäre)

Ansonsten zum Verbrauch steht was von TDP von 160W im Raum. Lässt sich zwar so nicht 1:1 rechnen, wäre aber gut unter der AMD... Ob das passt, ist fraglich. Damit wäre NV erstmals seit dem R600 und den Performance/HighEndkarten effizienter als die AMDs...

Das ist/sind die erste Folien die mal ein Bisschen seriös rüber kommen.Ohne gleich Dualkartenmonster,die noch nichtmal in der Phantasie existieren,mit lächerlichen Balkendiagrammen zu presentieren

Mir scheinen die ALU Angaben etwas fehl am Platze...

Vier GPCs, 16 SMs und 64 TMUs (als "gerade" Werte) passen nicht so recht zu den 1536 ("krummen") ALUs...

Da klingen 1024 ALUs eher realistisch...

Ich glaube nicht daran, das es so viele Ausführungseinheiten werden... Der Größenfaktor wäre wohl recht enorm. Und es macht den Anschein, als würde NV hier ähnlich den Vorgängergenerationen agieren. Sprich es gibt keine Vectorunits, die die Größe selbst verkleinen. Auch wenn durch weniger Takt und die womöglich kürzere Pipeline der Spaß pro Fläche durchaus etwas kleiner sein dürfte, halte ich den Vorteil in Sachen Größe da nicht für gegeben. Sprich vier mal so viele ALUs ohne HotClocks mit kürzerer Pipeline wären wohl trotzdem deutlich größer als herkömmliche HotClock ALUs.

Wobei dem gegenüber steht diese eine News von vor ner Weile, das GK100 wohl riesig werden könnte

dafür Leistungstechnisch richtig rockt. Das wäre mit so nem 2000 ALU Teil durchaus gegeben