Welches? Digital Foundry hat alleine gefühlt 5000 Videos mit Far Cry irgendwas.

"Schlechte" Programmierung ist auch ein valider Punkt, den man eben trotzdem gerne mit mehr Hardwareleistung "behebt".

Texture Streaming ist aber mittlerweile auch normal, also das Texturen (sichtbar) nachladen. Wenn der Grund dafür aber tatsächlich schlechte Programmierung sein sollte, hilft mehr VRAM aber auch nicht unbedingt. Die Software streamt die Texturen ja trotzdem und weiß nicht unbedingt was mit dem Mehr an Speicher anzufangen, bzw. ihn RICHTIG zu nutzen.

Das einzige was ich dazu sagen kann ist, das ich auf meiner 6900xt sehe, das ein paar wenige Titel tatsächlich 11-12GB belegen. Auch Mitspieler haben mir schon bestätigt, das die Auslastung auf ihren 1080ti/2080ti bei "fast voll" liegt, also über 10GB. Das war ja auch einer der Kritikpunkte von wegen "zu wenig"... nicht das es absolut wenig ist, sondern das es halt irgendwie doof ist, wenn die 2 Generationen ältere Karte schon 11GB hatte und die neuen dann mit maximal 10GB (oder dann halt gleich 24GB) kommen. Die 3080ti mit 12GB kam erst später.

Das auf diesen Karten mehr als 10GB genutzt werden muss allerdings auch nicht heißen, das es mit <=10GB gleich zu Problemen kommt.

Mit meiner alten 1070 mit 8GB hatte ich eigentlich nur ein Problem mit (wenigen) Spielen mit Ultra-Texturen, was aber auf einer 1080ti mit 11GB schonwieder problemlos lief.

Zu FarCry: PS4-Port wo das Spiel mit 8GB VRAM+RAM laufen muss... Wohl weniger schlecht programmiert, wenn es auf einer PS4 sogar mit 4+4 oder 6+2GB läuft, sondern eher dann mieserabel portiert.

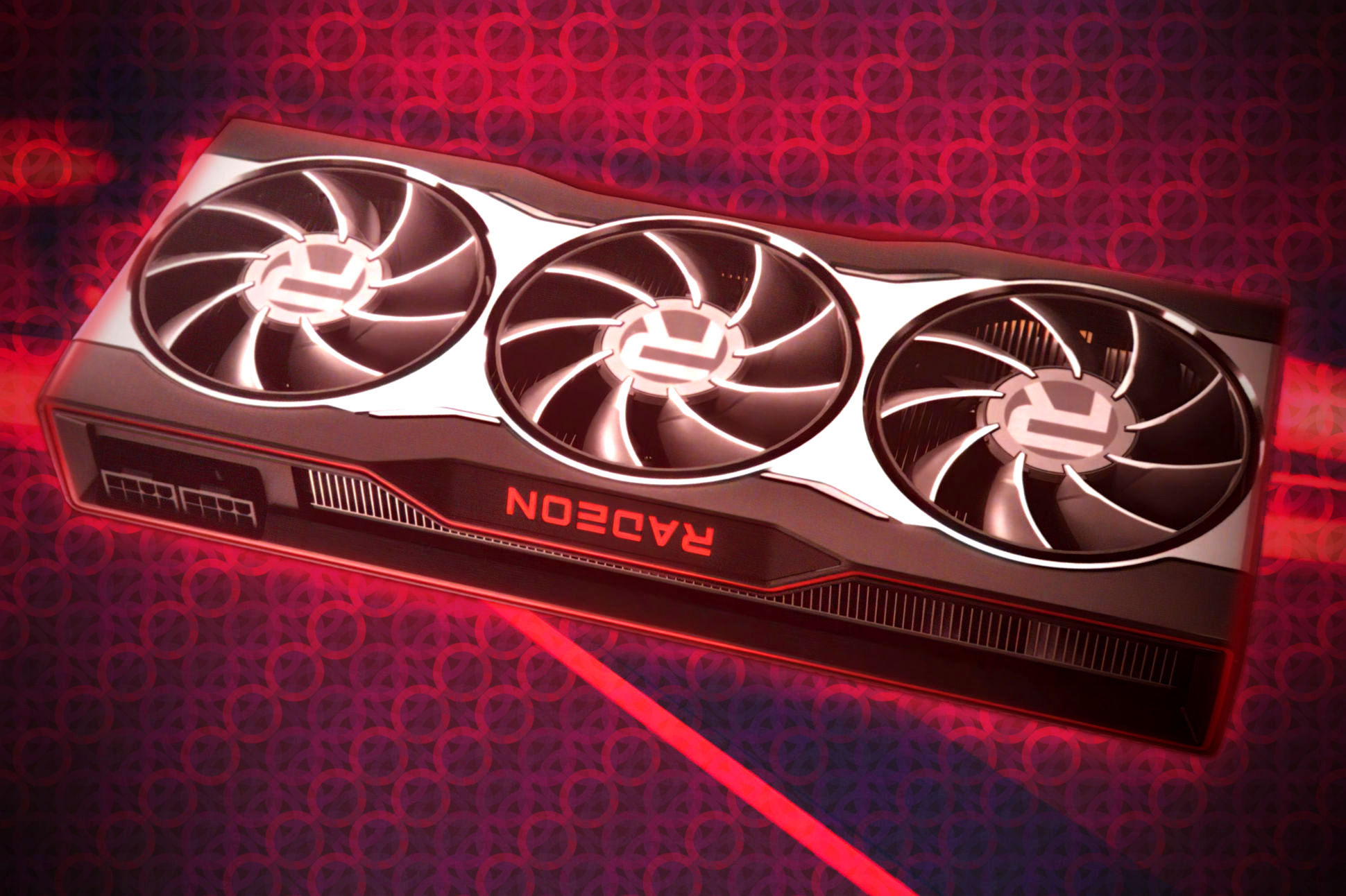

Fazit: Ich denke die 16GB auf den AMDs braucht man eigentlich nicht. Die 10GB von NVidia sind/waren mir aber irgendwie doch zu knapp, in die Zukunft schauend. Die 12GB der 3080ti finde ich dagegen ganz gut. Aber diverse 3000er mit wieder nur 8GB sind schon... naja. Also eine 3070 hätte ich mir alleine schon wegen den wieder nur 8GB nicht gekauft.

😘

😘