2k5lexi

Lars Christmas

- Mitglied seit

- 29.03.2010

- Beiträge

- 43.516

- Ort

- Ostallgäu

- Laptop

- Thinkpad T450S

- Details zu meinem Desktop

- Prozessor

- Ryzen 3600

- Mainboard

- MSI B550-A Pro

- Kühler

- Noctua D15

- Speicher

- 2x16GB Corsair LPX @3800MHz

- Grafikprozessor

- Palit GeForce RTX 4070 GamingPro

- Display

- Gigabyte M27Q

- SSD

- Samsung 950 pro 256GB, Kingston KC3000 2TB

- Opt. Laufwerk

- LG DVD Brenner

- Soundkarte

- onboard

- Gehäuse

- Fractal Design Pop Air solid black

- Netzteil

- Seasonic Focus PX-550

- Keyboard

- Logitech K400

- Mouse

- Logitech M705

- Betriebssystem

- Win10 x64

- Webbrowser

- Firefox

- Sonstiges

- Turtle Beach Stealth 600 G2

- Internet

- ▼120 mbit ▲5 mbit

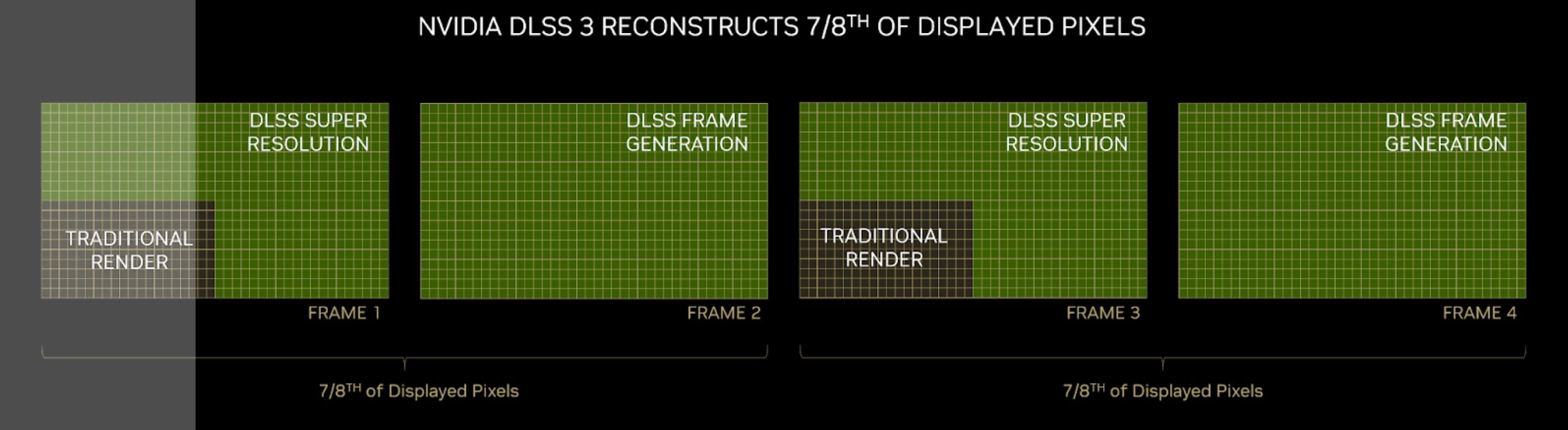

Die haben bei der GTX970 über die Menge Vram gelogen (3.5gb gate). Sie verwenden in Demos nachweislich Äpfel und Birnen Daten.So, wo ist das jetzt bitte Quatsch, Fake News oder gelogen? Warum sollte Nvidia mit DLSS3 irgendeine Marketing Lüge abziehen wollen? Was hätten sie bitte davon?

Dein Bild oben zum Beispiel.

22 FPS ohne alles und dann 96 mit DLSS 2.4+3.0+Reflex. Und was weiß ich noch alles.

Auf jeden Fall nix was irgendwas über DLSS3.0 aussagt.

Ich könnte sicher noch mehr buddeln. Mehr nachweisbare Lügen von offiziellen Nvidia Vertretern raussuchen.

Zuletzt bearbeitet: