Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Mehr Verbrauch ohne Ecores? Alder Lake, Rocket Lake

- Ersteller jaydee2k4

- Erstellt am

Nozomu

Legende

- Mitglied seit

- 11.03.2011

- Beiträge

- 16.115

- Desktop System

- Raptorlake

- Details zu meinem Desktop

- Prozessor

- Core i9 14900K @ 24 x 5700 MHz

- Mainboard

- ASUS PRIME Z690-P D4

- Kühler

- Noctua NH-D15 (3x NH-A15 Lüfter)

- Speicher

- 4x8GB 3200C14 MHz G.Skill Trident Z RGB (f4-3866c18d-16gtzr) (Samsung B-Die)

- Grafikprozessor

- ZOTAC GAMING GeForce RTX 4070 Twin Edge OC White Edition

- Display

- ASUS XG27UCS 27'' 3840 x 2160 160 Hz / Samsung 28" U28E850 3840 x 2160 60 Hz

- SSD

- System und mehr: Samsung 990 PRO NVMe M.2 SSD, 4 TB

- HDD

- Spiele SSD: Samsung 990 PRO NVMe M.2 SSD, 4 TB

- Soundkarte

- Extern: Asus Xonar U7 MKII Soundkarte 7.1 Surround

- Gehäuse

- EVGA DG-87 (Lüfter= Front: 3x 140+2x 200 / TOP: 1x 200 / Heck: 4x 140 GPU 1x 140 )

- Netzteil

- EVGA SuperNOVA 850 T2 TITANIUM

- Betriebssystem

- Windows 11 Pro

Der ist doch noch älterer als Alder Lake? wie kommst du auf Rocket Lake? bis auf Dich hat niemand ein Wort verloren über ''Rocket´´Rocket Lake ist ja völlig ineffizient was soll ich denn damit.

Spieluhr

Banned

- Mitglied seit

- 17.03.2006

- Beiträge

- 11.890

- Ort

- Dortmund

- Details zu meinem Desktop

- Prozessor

- Intel Core i5-13600KF (5,8/5,5)

- Mainboard

- MSI MEG Z690 ACE

- Kühler

- DeepCool Gammaxx L360 RGB V2 (alte Rev.) @ Push'n'Pull 6x AC P12PWM (Rev.4)

- Speicher

- 32GB Corsair Vengeance @ 6667MHz | DDR5

- Grafikprozessor

- AMD RX6500XT *Ersatz wegen defekt*

- Display

- Acer KG 272 UP (WQHD/165Hz)

- SSD

- WD SN850X (2TB) | 2x SK Hynix Platinum P41 (2TB) | Fanxiang S880 (4TB) | Fikwot FN955 (4TB)

- Gehäuse

- Corsair 5000D Airflow White @ 4x AC P12PWM (Rev.4) | 3x DeepCool RF120 RGB (alte Rev.)

- Netzteil

- Corsair RM850x (Serie 2022) 850W.

- Keyboard

- Cherry Stream V2 RGB

- Mouse

- Tecknet GM299 RGB

- Betriebssystem

- W11 Prof. Retail Version

- Webbrowser

- der beknackte Fuchs

- Sonstiges

- Satelliten: PreSonus Eris E4.5BT Studio Kevlar Subwoofer: PreSonus Eris Sub8 Studio (aktiv) Kabels: AdamHall 5Star (IRP) TS/TRS 6,5/3,5 Klinke Absorber: AdamHall Gravity IF01 / PAD ECO2

- Internet

- ▼1000 MBit ▲50 MBit

E-Core_less daddeln. Darum gehts dir u.a. auch.Rocket Lake ist ja völlig ineffizient was soll ich denn damit.

Doch ich!bis auf Dich hat niemand ein Wort verloren über ''Rocket´´

..weil die TD Telemetrie scheint doch sehr aufzustoßen.

..weil die TD Telemetrie scheint doch sehr aufzustoßen.

G

Gelöschtes Mitglied 31745

Guest

Aus eigener Erfahrung muss ich dir sagen, dass du dir selbst ein Bein stellst, wenn du Effizienz mit den Raptor Lake / Refresh Prozessoren kombiniert haben willst, aber bei Windows 10 bleiben willst. Was auch immer im Scheduler geändert wurde, er funktioniert sehr viel besser unter Windows 11 als unter Windows 10.

Unter Windows 10 musste ich z.B. Process Lasso nutzen, um z.B. DCS auf die Sprünge zu helfen und die Kernzuteilung ordentlich hinzubekommen. Unter Windows 11 kann ich mir das jetzt scheinbar sparen.

Wenn du nur die P Cores aktiv haben willst, kannst du das jederzeit im BIOS angeben (zumindest auf der Z-Plattform, die B-Plattform nutze ich nicht und kann deshalb nichts aus eigener Erfahrung berichten). Ob das dann aber wirklich effizienter wird, wage ich zu bezweifeln. Denn eigentlich sind gerade die E Cores relativ gut darin die unliebsamen Hintergrundtasks zu erledigen und den P Cores den Rücken freizuhalten.

Wenn du maximale Gaming Leistung bei minimalem Verbrauch willst, musst du fast in Richtung AMD x3D schielen. Aber da ich vermutlich was anders unter "Effizienz" im Kopf habe, musst du es selbst entscheiden.

Unter Windows 10 musste ich z.B. Process Lasso nutzen, um z.B. DCS auf die Sprünge zu helfen und die Kernzuteilung ordentlich hinzubekommen. Unter Windows 11 kann ich mir das jetzt scheinbar sparen.

Wenn du nur die P Cores aktiv haben willst, kannst du das jederzeit im BIOS angeben (zumindest auf der Z-Plattform, die B-Plattform nutze ich nicht und kann deshalb nichts aus eigener Erfahrung berichten). Ob das dann aber wirklich effizienter wird, wage ich zu bezweifeln. Denn eigentlich sind gerade die E Cores relativ gut darin die unliebsamen Hintergrundtasks zu erledigen und den P Cores den Rücken freizuhalten.

Wenn du maximale Gaming Leistung bei minimalem Verbrauch willst, musst du fast in Richtung AMD x3D schielen. Aber da ich vermutlich was anders unter "Effizienz" im Kopf habe, musst du es selbst entscheiden.

MS1988

Legende

- Mitglied seit

- 03.10.2009

- Beiträge

- 10.223

- Details zu meinem Desktop

- Prozessor

- 13900K

- Mainboard

- ASUS ROG Strix Z790-A Gaming WIFI D4

- Kühler

- NZXT Z73

- Speicher

- F4-4000C19D-32GTZKK B-Die

- Grafikprozessor

- Asus TUF OC RTX 4090

- Display

- PG32UQX

- SSD

- WD 850X 4 TB , 860 EVO 2TB, 840 EVO 1TB

- Soundkarte

- Fiio Q1 Mark II @ AKG 712 pro

- Gehäuse

- Corsair 7000D

- Netzteil

- Corsair AX 1000 Titanium

- Keyboard

- Corsair K70 RGB MK2 Low Profile @ silver Switches

- Mouse

- Logitech G502

RPL ist ja effizienter und im Prinzip ist der Sprung vom 12600 zum 14700K ok , aber da er die CPU eh verkrüppeln will und bei Win 10 bleiben möchte

würde ich doch eher den Kram verkaufen und einen 7800X3D kaufen. Das sollte einfach gut laufen unter Win 10 und man hat einen schnellen 8 Kerner der effizienter arbeitet als

es RPL tut gerade im Gaming. Habe mich jetzt nicht krass eingelesen bei AMD , aber optimieren kann man auch AMD Systeme nehme ich mal stark an.

Würde dann das alte System als Bundle verkaufen.

Kann sein das der 7800X3D im Idle 20 Watt Verbraucht , aber guck mal was meine CPU im IDLE Verbraucht nur weil NZXT CAM im Hintergrund läuft^^

Gut das ich nicht den ganzen Tag einfach den Rechner dumm anlasse und auch was mache , wenn er läuft.

würde ich doch eher den Kram verkaufen und einen 7800X3D kaufen. Das sollte einfach gut laufen unter Win 10 und man hat einen schnellen 8 Kerner der effizienter arbeitet als

es RPL tut gerade im Gaming. Habe mich jetzt nicht krass eingelesen bei AMD , aber optimieren kann man auch AMD Systeme nehme ich mal stark an.

Würde dann das alte System als Bundle verkaufen.

Kann sein das der 7800X3D im Idle 20 Watt Verbraucht , aber guck mal was meine CPU im IDLE Verbraucht nur weil NZXT CAM im Hintergrund läuft^^

Gut das ich nicht den ganzen Tag einfach den Rechner dumm anlasse und auch was mache , wenn er läuft.

Spieluhr

Banned

- Mitglied seit

- 17.03.2006

- Beiträge

- 11.890

- Ort

- Dortmund

- Details zu meinem Desktop

- Prozessor

- Intel Core i5-13600KF (5,8/5,5)

- Mainboard

- MSI MEG Z690 ACE

- Kühler

- DeepCool Gammaxx L360 RGB V2 (alte Rev.) @ Push'n'Pull 6x AC P12PWM (Rev.4)

- Speicher

- 32GB Corsair Vengeance @ 6667MHz | DDR5

- Grafikprozessor

- AMD RX6500XT *Ersatz wegen defekt*

- Display

- Acer KG 272 UP (WQHD/165Hz)

- SSD

- WD SN850X (2TB) | 2x SK Hynix Platinum P41 (2TB) | Fanxiang S880 (4TB) | Fikwot FN955 (4TB)

- Gehäuse

- Corsair 5000D Airflow White @ 4x AC P12PWM (Rev.4) | 3x DeepCool RF120 RGB (alte Rev.)

- Netzteil

- Corsair RM850x (Serie 2022) 850W.

- Keyboard

- Cherry Stream V2 RGB

- Mouse

- Tecknet GM299 RGB

- Betriebssystem

- W11 Prof. Retail Version

- Webbrowser

- der beknackte Fuchs

- Sonstiges

- Satelliten: PreSonus Eris E4.5BT Studio Kevlar Subwoofer: PreSonus Eris Sub8 Studio (aktiv) Kabels: AdamHall 5Star (IRP) TS/TRS 6,5/3,5 Klinke Absorber: AdamHall Gravity IF01 / PAD ECO2

- Internet

- ▼1000 MBit ▲50 MBit

Das hat bei meinen Z-Board via UEFI leider effektiv nie im Forced Mode (Prozess Lasso) funktioniert. Muss ich mal MSI anschreiben warum.Wenn du nur die P Cores aktiv haben willst, kannst du das jederzeit im BIOS angeben (zumindest auf der Z-Plattform, die B-Plattform nutze ich nicht und kann deshalb nichts aus eigener Erfahrung berichten). Ob das dann aber wirklich effizienter wird, wage ich zu bezweifeln.

Intel XTU CPU Stress allcore mit AVX2:

Intel XTU CPU Stress only P-Core mit AVX2:

Nachteil des ganzen, selbst wenn man den XTU Prozess wieder entfernt, dass Bitsum Tool schließt, CPU Affinities bzw. Effizience Mode wieder deaktiviert, der Intel TD lässt sich nicht mehr dazu überreden, in der aktuellen Session die E-Cores wieder effizient einzusetzen. Abhilfe schafft nur ein Rechner Neustart.

edit:

Und genau das scheinen nicht wenige, obwohl es diese hybrid Architektur seitens Intel nicht erst seit gestern gibt, immer noch nicht zu verstehen.Ob das dann aber wirklich effizienter wird, wage ich zu bezweifeln. Denn eigentlich sind gerade die E Cores relativ gut darin die unliebsamen Hintergrundtasks zu erledigen und den P Cores den Rücken freizuhalten.

Die sehen nur Kerne, viele Kerne und denken, jetzt kann ich daddeln wie der Held im Erdbeerfeld! ..gerade in der Daddel Szene scheint man da überfordert mit das einzuordnen.

Die E-Cores sind getrimmt auf Applicationeffizienz Worklow und das in vier Klassifizierungen:

Class 0: Die meisten Anwendungen

Class 1: Workloads mit AVX/AVX2-Anweisungen

Class 2: Workloads mit AVX-VNNI-Anweisungen

Class 3: Berechnungsengpässe, zb. E/A- oder Besetztschleifen die nicht skalierbar sind

Das war noch nie Intels Intention, mit der hybrid Core Architektur "Gamer" CPUs zu basteln, wurde über die Jahre nur vom Netz so aufgebauscht (großer Dank geht hierbei besonders an die Clickbait Reviewer Szene für die alles was man irgendwo sockeln kann automatisch auch unter "Daddel Silizium" katalogisiert wird) und hat sich entsprechend manifestiert.

Wer reine Daddel CPUs haben möchte der sollte halt zu AMD greifen. Ist doch ganz einfach.

Zuletzt bearbeitet:

Holt

Legende

- Mitglied seit

- 05.07.2010

- Beiträge

- 30.450

Mein 13900K braucht auf dem ASRock Z790 Steel Legend WiFi im Idle knapp über 2W, unter Win 10 und nur mit HWInfo64 Sensors am Laufen.aber guck mal was meine CPU im IDLE Verbraucht nur weil NZXT CAM im Hintergrund läuft

MS1988

Legende

- Mitglied seit

- 03.10.2009

- Beiträge

- 10.223

- Details zu meinem Desktop

- Prozessor

- 13900K

- Mainboard

- ASUS ROG Strix Z790-A Gaming WIFI D4

- Kühler

- NZXT Z73

- Speicher

- F4-4000C19D-32GTZKK B-Die

- Grafikprozessor

- Asus TUF OC RTX 4090

- Display

- PG32UQX

- SSD

- WD 850X 4 TB , 860 EVO 2TB, 840 EVO 1TB

- Soundkarte

- Fiio Q1 Mark II @ AKG 712 pro

- Gehäuse

- Corsair 7000D

- Netzteil

- Corsair AX 1000 Titanium

- Keyboard

- Corsair K70 RGB MK2 Low Profile @ silver Switches

- Mouse

- Logitech G502

Ne habe so 10-12 Watt wenn ich das Tool schließe . Habe aber auch über 1,3V SA wegen DDR4 mit höheren Takt und habe mir noch etwas Luft gelassen. Daher ist schon alles richtig. Wenn man die SA niedrig hält macht das auch paar Watt wohl aus.

Normal sind so 4-5 Watt im Optimum im Idle , aber schön das es bei dir noch weniger ist.

Normal sind so 4-5 Watt im Optimum im Idle , aber schön das es bei dir noch weniger ist.

True-Monkey

Enthusiast

- Mitglied seit

- 23.09.2009

- Beiträge

- 688

Wo kommt die hohe Vid dabei her ?Intel XTU CPU Stress only P-Core mit AVX2:

Spieluhr

Banned

- Mitglied seit

- 17.03.2006

- Beiträge

- 11.890

- Ort

- Dortmund

- Details zu meinem Desktop

- Prozessor

- Intel Core i5-13600KF (5,8/5,5)

- Mainboard

- MSI MEG Z690 ACE

- Kühler

- DeepCool Gammaxx L360 RGB V2 (alte Rev.) @ Push'n'Pull 6x AC P12PWM (Rev.4)

- Speicher

- 32GB Corsair Vengeance @ 6667MHz | DDR5

- Grafikprozessor

- AMD RX6500XT *Ersatz wegen defekt*

- Display

- Acer KG 272 UP (WQHD/165Hz)

- SSD

- WD SN850X (2TB) | 2x SK Hynix Platinum P41 (2TB) | Fanxiang S880 (4TB) | Fikwot FN955 (4TB)

- Gehäuse

- Corsair 5000D Airflow White @ 4x AC P12PWM (Rev.4) | 3x DeepCool RF120 RGB (alte Rev.)

- Netzteil

- Corsair RM850x (Serie 2022) 850W.

- Keyboard

- Cherry Stream V2 RGB

- Mouse

- Tecknet GM299 RGB

- Betriebssystem

- W11 Prof. Retail Version

- Webbrowser

- der beknackte Fuchs

- Sonstiges

- Satelliten: PreSonus Eris E4.5BT Studio Kevlar Subwoofer: PreSonus Eris Sub8 Studio (aktiv) Kabels: AdamHall 5Star (IRP) TS/TRS 6,5/3,5 Klinke Absorber: AdamHall Gravity IF01 / PAD ECO2

- Internet

- ▼1000 MBit ▲50 MBit

Das musst du wohl die HW. fragen.

ps: Ich sehe da auch keine "hohe" VID. Wie kommst du darauf? Rein rechnerisch, fällt laut XTU, bei aktiven E-Cores hier ein Mehrverbrauch von 0,06vC an.

Zeigt XTU auch so an: 6 Cores, CPU Utilization max. 60%. Normal müsste da 14 und 100% stehen.

..

ps: Ich sehe da auch keine "hohe" VID. Wie kommst du darauf? Rein rechnerisch, fällt laut XTU, bei aktiven E-Cores hier ein Mehrverbrauch von 0,06vC an.

Dann probiere das noch einmal mit irgend einen anderen Tool @ Last und lass XTU im HG laufen. Bei mir sind die E-Cores nach Bitsum CD so gut wie platt.Ne habe so 10-12 Watt wenn ich das Tool schließe .

Zeigt XTU auch so an: 6 Cores, CPU Utilization max. 60%. Normal müsste da 14 und 100% stehen.

..

Zuletzt bearbeitet:

Holt

Legende

- Mitglied seit

- 05.07.2010

- Beiträge

- 30.450

Das ist alles eine Frage der BIOS Einstellungen. ASRock optimiert die offenbar besser auf eine geringe Idle Leistungsaufnahme als andere, wie z.B. ASUS und dann spielen die Energiespareinstellungen in Windows natürlich auch eine Rolle. Ich habe da nichts geändert außer die Power Limits anzupassen und die RGB Beleuchtung zu deaktivieren. Das man sich mit ungünstigen BIOS Einstellungen die Idle Leistungsaufnahme ebenso versauen kann wie mit irgendwelchen Tools die dann unter Windows laufen, sollte klar sein.Normal sind so 4-5 Watt im Optimum im Idle , aber schön das es bei dir noch weniger ist.

MS1988

Legende

- Mitglied seit

- 03.10.2009

- Beiträge

- 10.223

- Details zu meinem Desktop

- Prozessor

- 13900K

- Mainboard

- ASUS ROG Strix Z790-A Gaming WIFI D4

- Kühler

- NZXT Z73

- Speicher

- F4-4000C19D-32GTZKK B-Die

- Grafikprozessor

- Asus TUF OC RTX 4090

- Display

- PG32UQX

- SSD

- WD 850X 4 TB , 860 EVO 2TB, 840 EVO 1TB

- Soundkarte

- Fiio Q1 Mark II @ AKG 712 pro

- Gehäuse

- Corsair 7000D

- Netzteil

- Corsair AX 1000 Titanium

- Keyboard

- Corsair K70 RGB MK2 Low Profile @ silver Switches

- Mouse

- Logitech G502

Dann probiere das noch einmal mit irgend einen anderen Tool @ Last und lass XTU im HG laufen. Bei mir sind die E-Cores nach Bitsum CD so gut wie platt.

Zeigt XTU auch so an: 6 Cores, CPU Utilization max. 60%. Normal müsste da 14 und 100% stehen.

..

Das Tool gehört zur AIO , weil diese wird via USB angeschlossen intern. Lüfter könnte ich auch via BIOS regeln , aber die Pumpe nicht . Die startet mit niedrigster Umdrehung und das wäre unter Last zu wenig Leistung. Daher ist man zwangsläufig darauf angewiesen. Nutzt leider nichts. Schmeiße deswegen nicht die gute AIO weg die 250€ rum gekostet hat.

Der Verbrauch ist mit oder ohne Tool ähnlich wenn ich Hwinfo mal paar Stunden laufen gelassen habe . Also durchschnittliche Verbrauch. Ich lasse meinen PC nicht den ganzen Tag Idlen . Ich mache ja dann irgendwas. Daher alles gut.

Spieluhr

Banned

- Mitglied seit

- 17.03.2006

- Beiträge

- 11.890

- Ort

- Dortmund

- Details zu meinem Desktop

- Prozessor

- Intel Core i5-13600KF (5,8/5,5)

- Mainboard

- MSI MEG Z690 ACE

- Kühler

- DeepCool Gammaxx L360 RGB V2 (alte Rev.) @ Push'n'Pull 6x AC P12PWM (Rev.4)

- Speicher

- 32GB Corsair Vengeance @ 6667MHz | DDR5

- Grafikprozessor

- AMD RX6500XT *Ersatz wegen defekt*

- Display

- Acer KG 272 UP (WQHD/165Hz)

- SSD

- WD SN850X (2TB) | 2x SK Hynix Platinum P41 (2TB) | Fanxiang S880 (4TB) | Fikwot FN955 (4TB)

- Gehäuse

- Corsair 5000D Airflow White @ 4x AC P12PWM (Rev.4) | 3x DeepCool RF120 RGB (alte Rev.)

- Netzteil

- Corsair RM850x (Serie 2022) 850W.

- Keyboard

- Cherry Stream V2 RGB

- Mouse

- Tecknet GM299 RGB

- Betriebssystem

- W11 Prof. Retail Version

- Webbrowser

- der beknackte Fuchs

- Sonstiges

- Satelliten: PreSonus Eris E4.5BT Studio Kevlar Subwoofer: PreSonus Eris Sub8 Studio (aktiv) Kabels: AdamHall 5Star (IRP) TS/TRS 6,5/3,5 Klinke Absorber: AdamHall Gravity IF01 / PAD ECO2

- Internet

- ▼1000 MBit ▲50 MBit

Da meinen wir beide wohl was anderes.

Es ging ja um den Intel ThreadDirector und halt deaktivieren der E-Cores. Das W11 Tool dazu heißt Bitsum CoreDirector.

Da muss ein Bug vorliegen, gerade noch einmal probiert, sobald du einen Prozess "addest" und startest, fährt der Intel TD die E-Cores runter auch wenn du sämtliche Prozesse diesbezgl. schließt.

Alles natürlich unter Energieplan Ultimative Leistung, um diesbezgl. andere Bugs zu vermeiden. Der Intel TD fährt danach mit angezogener Handbremse bis Neustart.

Es ging ja um den Intel ThreadDirector und halt deaktivieren der E-Cores. Das W11 Tool dazu heißt Bitsum CoreDirector.

Da muss ein Bug vorliegen, gerade noch einmal probiert, sobald du einen Prozess "addest" und startest, fährt der Intel TD die E-Cores runter auch wenn du sämtliche Prozesse diesbezgl. schließt.

Alles natürlich unter Energieplan Ultimative Leistung, um diesbezgl. andere Bugs zu vermeiden. Der Intel TD fährt danach mit angezogener Handbremse bis Neustart.

Zuletzt bearbeitet:

True-Monkey

Enthusiast

- Mitglied seit

- 23.09.2009

- Beiträge

- 688

Wenn man beim zweiten screen die 1 hinter dem Komma übersieht dann sieht man eine höhere Vid .....oder ich Depp zumindestch sehe da auch keine "hohe" VID. Wie kommst du darauf?

Dark_angel

Legende

- Mitglied seit

- 10.01.2007

- Beiträge

- 9.810

- Ort

- Hessen

- Details zu meinem Desktop

- Prozessor

- 14900K

- Mainboard

- MSI MAG B760M MORTAR WIFI DDR4

- Kühler

- Noctua NH-D15S chromax.black

- Speicher

- Kingston FURY Beast 128GB (4x32GB) 3200MHz DDR4 CL16

- Grafikprozessor

- RTX 4090

- SSD

- Optane 905P 960GB

- Netzteil

- MSI MAG A850G PCIE5

- Betriebssystem

- Windows 11 Pro

Was bringt dir der Support, wenn du jetzt schon eventuell Probleme hast, das wird in Zukunft nicht besser werden.Meine Win 10 Version hat bis Januar 2032 Support.

Kannst du die Win10 LTSC nicht auch einfach upgraden auf Windows 11 oder liegt es an der Umstellung, weil so schlimm ist das nicht.

zog88

Experte

- Mitglied seit

- 26.10.2023

- Beiträge

- 1.314

- Details zu meinem Desktop

- Prozessor

- i7-14700KF: 2xP-core 5,7Ghz P-allcore 5,5Ghz E-cores 4,5Ghz

- Mainboard

- MSI MAG Z790 Tomahawk Wifi

- Kühler

- Alphacool Eisbaer 420 AIO WAK

- Speicher

- G.Skill Trident Z5 RGB schwarz DIMM Kit 48GB DDR5-8000 CL40-48-48-128 (ECC)

- Grafikprozessor

- Nvidia Geforce RTX 3090 Founders Edition

- Display

- LG UltraGear 27GL850-B 1440p @ 144Hz

- SSD

- Samsung 990 Pro 1TB \ 2x Samsung 990 Pro 2TB \ Samsung 870 Evo 4TB

- Gehäuse

- Fractal Meshify 2 XL

- Netzteil

- BeQuiet StraightPower 12 1kW Platinum

- Keyboard

- Razer Huntsman V2

- Mouse

- Razer DeathAdder Elite

- Betriebssystem

- Windows 11 Pro

Vor allem, wird er bis 2032 bei derselben Hardware bleiben?

Selbst wenn man jetzt auf AMD setzt (zwecks ohne E-Cores), wer sagt das AMD nicht vielleicht auch in einigen Jahren in diese Richtung geht?

Wer jetzt kein Win11 braucht soll's lassen, ich hab auch 3 Rechner im Haus und nur einer läuft mit Win11. Weder der Devils Canyon 4790K noch der Skylake-X 7800X brauchen es. Der eine ist offiziell nicht mal kompatibel. Aber eines weiß ich sicher: bis 2032 werden die nicht als Hauptrechner laufen.

Selbst wenn man jetzt auf AMD setzt (zwecks ohne E-Cores), wer sagt das AMD nicht vielleicht auch in einigen Jahren in diese Richtung geht?

Wer jetzt kein Win11 braucht soll's lassen, ich hab auch 3 Rechner im Haus und nur einer läuft mit Win11. Weder der Devils Canyon 4790K noch der Skylake-X 7800X brauchen es. Der eine ist offiziell nicht mal kompatibel. Aber eines weiß ich sicher: bis 2032 werden die nicht als Hauptrechner laufen.

Die e-Kerne sind die Effizienzkerne, von daher ist es Schwachsinn, auch wenn du das nicht lesen willst.

Hat aber mit der Frage vom Themenersteller nichts zu tun. Ich denke Post 1 war ganz klar, was er wissen will. Es war nicht die Frage ob es sinnhaft ist.

Ich habe gelesen, dass diese Kerne minderwertig sind, da diesen gewisse CPU Instruktionen fehlen.

Für mich wäre auch nur ein Betrieb ohne E-Kerne relevant, aufgrund Softwarezwang.

Beitrag automatisch zusammengeführt:

Das System mit 416 Watt ist deutlich effizienter, als das mit 301 Watt, weil es einfach deutlich mehr leistet.

Wenn mein generierter CODE nicht lauffähig ist aufgrund der fehlenden CPU Instruktion, sagen wir Eigenschaft hinzu, dann ist der Vergleich irrelevant.

Beitrag automatisch zusammengeführt:

Gibt auch tools wo du mit einem Tastendruck die E-Cores deaktivieren kannst unter Windows ohne es dauerhaft zu deaktivieren.

Weil der Scheduler die Aufgaben nicht richtig zuweisen kann. Das ist das Problem an einer Mischlösung.

Hat aber AMD auch mit Kerne mit 3D-Cache und ohne.

--

Gut, dass man mit Zahlen arguemntieren will.

Aber Spiele Benchmarks mit veralteten Prozessoren und Grafikkarten aus 2022 sind irrelevant.

Es fehlt die Ryzen 7000er und die Intel 14000er Prozessoren.

Windows und sagen wir mal pauschaliert Grafikkartentreiberupdates verschieben oft auch noch diese Zahlen.

Hinzu kommen noch andere neuere Grafikkarten.

Beitrag automatisch zusammengeführt:

CPU im IDLE Verbraucht nur weil NZXT CAM im Hintergrund läuft

Das ist ein Problem mit dem Betriebssystem.

Mir ist das vor kurzem auch aufgefallen mit Windows 11 Pro und einem Game Launcher.

Leerlauf für mich als Einzelfall als Person vs Leerlauf für ein Windows 11 Pro.

Hat man irgendetwas offen, ist es schon wieder irrelevant. Plus die Millionen an unnötigen Helferlein die sich in den Autostart reinhängen.

Ein echter Leerlauf von einem Gaming Rechner mit Windows 11 Pro nach dem Cold Boot wird schwierig werden.

Beitrag automatisch zusammengeführt:

Die E-Cores sind getrimmt auf Applicationeffizienz Worklow und das in vier Klassifizierungen:

Das bringt nichts. Ich compiliere die Software dass Sie auf schlechteren Kernen ineffizient läuft.

Warum gibt es meiner Meinung nach immer mehr Instruktionen pro CPU Generationenwechsel?

Wäre ja schwachsinnig oder?

Wenn Software nicht die CPU Instruktionen verwendet, ist sie ineffizient.

Das sieht man wenn man mit der gnu toolchain sich beschäftigt.

Zuletzt bearbeitet:

G

Gelöschtes Mitglied 31745

Guest

@jaydee2k4

Ich habe gerade spaßeshalber mal die E Cores im BIOS deaktiviert (E Cores = 0). Den Rest habe ich unverändert gelassen (VCore, PL1=125 W, PL2= 253 W, IccMax= 307 A). Ich bin auch im Energiesparprofil "Ausbalanciert" geblieben, da ich sonst nicht sagen kann ob der Intel Thread Director ausgehebelt wird (ich vermute es aber).

Dann habe ich einen TimeSpy Extreme Benchmark laufen lassen. Ja, die P Cores können etwas häufiger und länger an ihre obere Grenze Boosten (bei meinem 14700K 5,6 GHz). Aber die CPU Package Temperatur fällt nicht, im Gegenteil sie schien im letzten Abschnitt, dem CPU Test, sogar leicht zu steigen. Der CPU Test schnitt ~4000 Punkte schlechter ab als mit aktivierten E Cores.

Das heißt jetzt erstmal nichts für Spiele. Aber zum Einen sehe ich ohne weitere Maßnahmen wie z.B. Undervolting erstmal keinen Effizienzgewinn. Und ob ein Undervolting ohne E Cores besser gelingt als mit E Cores, darauf würde ich nicht unbedingt wetten. Denn die Cores sind ja eigenständig. Sie teilen sich meines Wissens nach den L3 Cache Zugriff und sie müssten sich den Strom "teilen" bzw. werden beide gemeinsam versorgt.

Und theoretisch könnte der fehlende Wärmeeintrag helfen.

Aber so der ganz große Wurf ist das nicht.

Ich habe auch seinerzeit in DCS Multithreading damit experimentiert die E Cores komplett abzuschalten. Das hatte das Spiel in der Performance auch verschlechtert. Unter Windows 10 musste ich dafür sorgen, dass mindestens ein P Core dem Spiel nicht zur Nutzung überlassen wird und damit für Systemaufgaben frei bleibt. Das hatte dann gut geholfen. Jetzt unter Windows 11 im Profil "Ausbalanciert", Energiestatus "Beste Leistung" kriegen das das Spiel, Windows und die CPU ganz wunderbar selbst hin und es läuft sogar schneller und flüssiger. Ich fasse keine Tools mehr wie Process Lasso an, wenn mich nicht irgendwas dazu zwingt.

Ich habe gerade spaßeshalber mal die E Cores im BIOS deaktiviert (E Cores = 0). Den Rest habe ich unverändert gelassen (VCore, PL1=125 W, PL2= 253 W, IccMax= 307 A). Ich bin auch im Energiesparprofil "Ausbalanciert" geblieben, da ich sonst nicht sagen kann ob der Intel Thread Director ausgehebelt wird (ich vermute es aber).

Dann habe ich einen TimeSpy Extreme Benchmark laufen lassen. Ja, die P Cores können etwas häufiger und länger an ihre obere Grenze Boosten (bei meinem 14700K 5,6 GHz). Aber die CPU Package Temperatur fällt nicht, im Gegenteil sie schien im letzten Abschnitt, dem CPU Test, sogar leicht zu steigen. Der CPU Test schnitt ~4000 Punkte schlechter ab als mit aktivierten E Cores.

Das heißt jetzt erstmal nichts für Spiele. Aber zum Einen sehe ich ohne weitere Maßnahmen wie z.B. Undervolting erstmal keinen Effizienzgewinn. Und ob ein Undervolting ohne E Cores besser gelingt als mit E Cores, darauf würde ich nicht unbedingt wetten. Denn die Cores sind ja eigenständig. Sie teilen sich meines Wissens nach den L3 Cache Zugriff und sie müssten sich den Strom "teilen" bzw. werden beide gemeinsam versorgt.

Und theoretisch könnte der fehlende Wärmeeintrag helfen.

Aber so der ganz große Wurf ist das nicht.

Ich habe auch seinerzeit in DCS Multithreading damit experimentiert die E Cores komplett abzuschalten. Das hatte das Spiel in der Performance auch verschlechtert. Unter Windows 10 musste ich dafür sorgen, dass mindestens ein P Core dem Spiel nicht zur Nutzung überlassen wird und damit für Systemaufgaben frei bleibt. Das hatte dann gut geholfen. Jetzt unter Windows 11 im Profil "Ausbalanciert", Energiestatus "Beste Leistung" kriegen das das Spiel, Windows und die CPU ganz wunderbar selbst hin und es läuft sogar schneller und flüssiger. Ich fasse keine Tools mehr wie Process Lasso an, wenn mich nicht irgendwas dazu zwingt.

jaydee2k4

Enthusiast

Thread Starter

- Mitglied seit

- 15.12.2014

- Beiträge

- 376

Ich habe den 14700k geholt. Bei techpowerup hatte jemand sehr gute Ergebnisse mit Ecores aus Pcores auf 5 Ghz gedeckelt und -0.125mv Vcore offset. So soll er nicht mehr als 70 Watt beim Gaming schlucken, meistens weniger. Letztendlich genau wie ich das will.

G

Gelöschtes Mitglied 31745

Guest

Berichte mal bitte ob und wie sich das ausgeht. Ich meine, beim normalen Gaming ist diese Verlustleistung nicht ungewöhnlich. Es gibt schon Spiele die mehr von der CPU wollen, aber das ist eher selten.

/edit: ist das dieser Thread auf den du dich beziehst? https://www.techpowerup.com/forums/threads/14900k-tuned-for-efficiency-gaming-power-draw.315783/

/edit: ist das dieser Thread auf den du dich beziehst? https://www.techpowerup.com/forums/threads/14900k-tuned-for-efficiency-gaming-power-draw.315783/

Zuletzt bearbeitet von einem Moderator:

Holt

Legende

- Mitglied seit

- 05.07.2010

- Beiträge

- 30.450

Kein Wunder, denn die Wärme fällt auf einer kleineren Fläche an, wenn die e-Kerne deaktiviert sind und damit steigt die Temperatur. Schau Dir nur mal den Review des Xeon W9-3495X an, wo mit dem Noctua NH-U14S DX-4677 auch bei 480W noch bequem gekühlt wurde, weil die Fläche so groß ist:Aber die CPU Package Temperatur fällt nicht, im Gegenteil sie schien im letzten Abschnitt, dem CPU Test, sogar leicht zu steigen.

Nein, im Gegenteil, s.o. denn je größer die Fläche ist über die die Wärme anfällt, umso besser lässt sie sich kühlen.Und theoretisch könnte der fehlende Wärmeeintrag helfen.

jaydee2k4

Enthusiast

Thread Starter

- Mitglied seit

- 15.12.2014

- Beiträge

- 376

So CPU ist da und verbaut. Boost Offset auf -5. LLC auf Mode 5 und Vcore offset mit -0.04 bekomme ich ihn Prime stabil. Ohne Ecores. Zieht so in Cinebench 120 Watt, Prime 140 und in Spielen weniger als mein 12600. Und das bei 5 Ghz. Spürbares upgrade isses auch. Ladezeiten sind mehr als halbiert.

Bis jetzt TOP!

Bis jetzt TOP!

Holt

Legende

- Mitglied seit

- 05.07.2010

- Beiträge

- 30.450

Wunderbar, also nicht von wegen Sidegrade, sondern wirklich ein Upgrade. Bzgl. der Ladezeiten, hast Du sonst noch was verändert?Und das bei 5 Ghz. Spürbares upgrade isses auch. Ladezeiten sind mehr als halbiert.

MS1988

Legende

- Mitglied seit

- 03.10.2009

- Beiträge

- 10.223

- Details zu meinem Desktop

- Prozessor

- 13900K

- Mainboard

- ASUS ROG Strix Z790-A Gaming WIFI D4

- Kühler

- NZXT Z73

- Speicher

- F4-4000C19D-32GTZKK B-Die

- Grafikprozessor

- Asus TUF OC RTX 4090

- Display

- PG32UQX

- SSD

- WD 850X 4 TB , 860 EVO 2TB, 840 EVO 1TB

- Soundkarte

- Fiio Q1 Mark II @ AKG 712 pro

- Gehäuse

- Corsair 7000D

- Netzteil

- Corsair AX 1000 Titanium

- Keyboard

- Corsair K70 RGB MK2 Low Profile @ silver Switches

- Mouse

- Logitech G502

Vorallem hätte der 7800X3D gut dabei ausgesehen

Ne viel Spaß mit deinem Upgrade ;-)

Die Entscheidung ist ja Nachvollziehbar, weil es eben auch am einfachsten war.

www.computerbase.de

www.computerbase.de

Ne viel Spaß mit deinem Upgrade ;-)

Die Entscheidung ist ja Nachvollziehbar, weil es eben auch am einfachsten war.

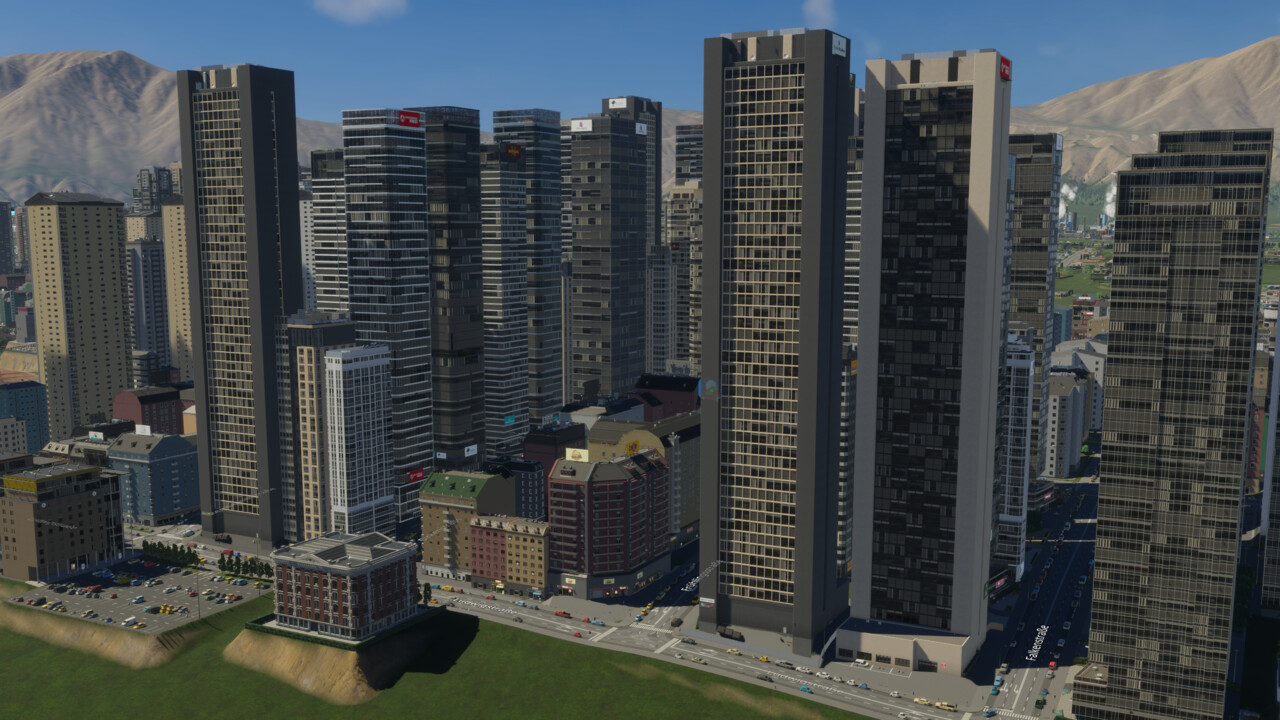

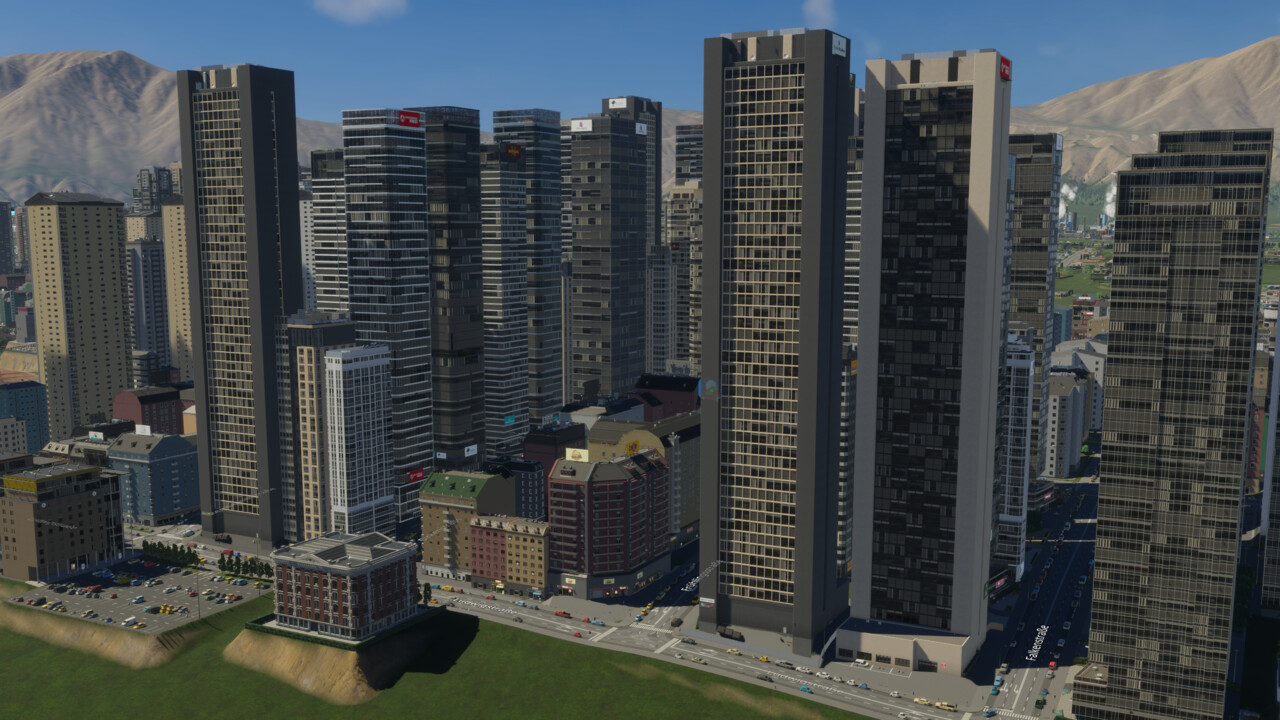

Cities Skylines II im Technik-Test: Prozessor-Benchmarks

Cities: Skylines II im Test: Prozessor-Benchmarks / Prozessor-Benchmarks in 720p auf einer GeForce RTX 4090 (Update)

AlsterwasserHH

Enthusiast

- Mitglied seit

- 04.02.2017

- Beiträge

- 1.943

- Ort

- Hamburg

- Details zu meinem Desktop

- Prozessor

- i9-13900K @stock

- Mainboard

- MSI Z690 Tomahawk WiFi DDR4

- Kühler

- Komplett WC 3x 360er 30mm / Heatkiller IV / EKWB Velocity²

- Speicher

- 4x8GB Corsair Dominator Platinum 3200 CL16

- Grafikprozessor

- ASUS TUF OC 4090 @2500MHz uv 0.870V

- Display

- Dell G3223Q 3840x2160 / 144Hz / IPS

- Gehäuse

- Lian Li Dynamic O11D EVO

- Netzteil

- BeQuiet Straight Power 11 1000W

- Betriebssystem

- Win10

Ja aber dann klär doch bitte mal die Frage auch auf: wieviel weniger Verbrauch hast Du denn jetzt?So CPU ist da und verbaut. Boost Offset auf -5. LLC auf Mode 5 und Vcore offset mit -0.04 bekomme ich ihn Prime stabil. Ohne Ecores. Zieht so in Cinebench 120 Watt, Prime 140 und in Spielen weniger als mein 12600. Und das bei 5 Ghz. Spürbares upgrade isses auch. Ladezeiten sind mehr als halbiert.

Bis jetzt TOP!

Holt

Legende

- Mitglied seit

- 05.07.2010

- Beiträge

- 30.450

Mehr Kerne die jeweils weniger hoch ausgelastet sind, verbrauchen eben weniger Energie als weniger Kerne die dafür jeweils mehr Last haben, sofern sonst kein Unterschied bzgl. der Fertigung oder Architektur dies ausgleichen kann. Raptor Lake (Refresh) wird wie Alder Lake in Intel 7 gefertigt, auch wenn der Prozess inzwischen ausgereifter ist und Raptor Lake haben eben etwas mehr L2 Cache. Wie viel das ausmacht und wie viel die Tatsache das eben mehr Kerne jeweils weniger Last haben, kann man halt schwer sagen, aber es war zu erwarten das die Leistungsaufnahme fällt, sofern man eben nicht das höhere maximale Taktpotential voll ausnutzt.