besterino

Legende

Thread Starter

- Mitglied seit

- 31.05.2010

- Beiträge

- 7.858

- Desktop System

- Rechenknecht

- Laptop

- Lenovo Legion 5 (Intel, 4080, 32GB)

- Details zu meinem Desktop

- Prozessor

- Intel i9-13900KS@6300

- Mainboard

- ASUS Maximus Z790 Hero

- Kühler

- Kryo Next S1700, 2xMora 420, Tube 150, 2x Apex VPP, Aquaero 6 Pro, DFS High Flow USB, Farbwerk360

- Speicher

- 32GB (2x16GB @7600)

- Grafikprozessor

- Inno3D RTX 4090 Frostbite

- Display

- 55" OLED (Dell AW5520QF)

- SSD

- 2x4TB NVME PCIe 5.0, Rest (~12TB NVME) über SMB Direct

- HDD

- Näh. Technik von gestern.

- Opt. Laufwerk

- Näh. Technik von gestern.

- Soundkarte

- Cambridge Audio DacMagic 200M

- Gehäuse

- Lian-Li DK-05F

- Netzteil

- Corsair 1000HXi

- Keyboard

- Keychron Q6 Pro, Maxkeyboard Custom Caps, Black Lotus / Dolphin Frankenswitch, Everest Pads

- Mouse

- Swiftpoint Z2

- Betriebssystem

- Windows 11 Pro for Workstations (SMB Direct - yeah baby)

- Sonstiges

- Mellanox ConnectX-4 (Dual 100Gbit Netzwerk + WaKü), Rode NT-USB, Nubert ampX uvm. ...

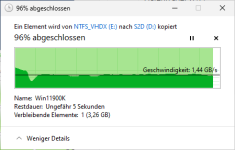

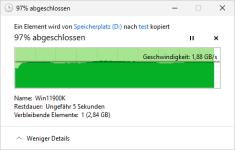

So, es wird ernst(er). Für die nächste Testphase muss die Testumgebung erweitert werden für den Zugriff durch meinen Hauptsystem.

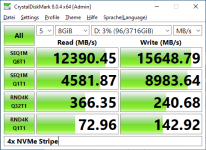

Dafür hab ich nach langer Zeit mal meinen Haupt-Server physisch geöffnet, wieder 4 NVME SSDs nachgesteckt und eine der beiden ConnectX-5. AMD's Epyc-Plattform mit den 128 Lanes (pro CPU) ist schon der Hammer. Da laufen jetzt u.a. 8 NVMEs (32 Lanes), 2x 100Gbit Dual-Port NICs (32 Lanes) und ein HBA (16 Lanes), alles unter ESXi per Passthrough durchgereicht an zurzeit 2 VMs: 1x meine "produktive" Storage-VM mit Solaris 11.4 (4x NVME + ConnectX-4 Dual-Port), und 1x die "Test" Storage-VM mit Windows Server 2022 (ebenso 4x NVME + ConnectX-5 DualPort).

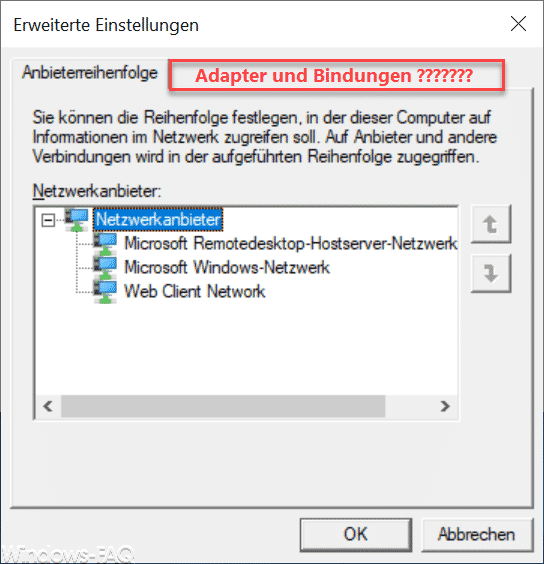

Um mir das Leben für die Testphase etwas leichter zu machen, hab ich mich erst einmal für Server 2022 mit "Desktop Experience" entschieden. Geht ja erstmal nur um Test-Spielereien rund um ZFS, ReFS, VHDX über's Netz, SMBDirect, bisserl User-Management (ohne Domäne) usw. Ich scheue mich aktuell auch noch, mich komplett von Solaris zu verabschieden, also lasse ich für die Testphase einfach mal beide parallel laufen...

Grundvoraussetzungen sind da: Server 2022 installiert, Remotedesktop aktiviert, alle Spielzeuge vorhanden:

Für mehr reicht die Zeit leider gerade nicht. Vielleicht kann's ab Freitag/Wochenende weitergehen.

Dafür hab ich nach langer Zeit mal meinen Haupt-Server physisch geöffnet, wieder 4 NVME SSDs nachgesteckt und eine der beiden ConnectX-5. AMD's Epyc-Plattform mit den 128 Lanes (pro CPU) ist schon der Hammer. Da laufen jetzt u.a. 8 NVMEs (32 Lanes), 2x 100Gbit Dual-Port NICs (32 Lanes) und ein HBA (16 Lanes), alles unter ESXi per Passthrough durchgereicht an zurzeit 2 VMs: 1x meine "produktive" Storage-VM mit Solaris 11.4 (4x NVME + ConnectX-4 Dual-Port), und 1x die "Test" Storage-VM mit Windows Server 2022 (ebenso 4x NVME + ConnectX-5 DualPort).

Um mir das Leben für die Testphase etwas leichter zu machen, hab ich mich erst einmal für Server 2022 mit "Desktop Experience" entschieden. Geht ja erstmal nur um Test-Spielereien rund um ZFS, ReFS, VHDX über's Netz, SMBDirect, bisserl User-Management (ohne Domäne) usw. Ich scheue mich aktuell auch noch, mich komplett von Solaris zu verabschieden, also lasse ich für die Testphase einfach mal beide parallel laufen...

Grundvoraussetzungen sind da: Server 2022 installiert, Remotedesktop aktiviert, alle Spielzeuge vorhanden:

Für mehr reicht die Zeit leider gerade nicht. Vielleicht kann's ab Freitag/Wochenende weitergehen.