Varianten:

- 3090

Cuda-Kerne 10496 Speichermenge 24GB GDDR6X Breite der Speicherschnittstelle 384-bit Basis/Boost-Takt 1.4/1.7Ghz

- 3080

Cuda-Kerne 8704 Speichermenge 10GB GDDR6X Breite der Speicherschnittstelle 320-bit Basis/Boost-Takt 1.44/1.71Ghz

- 3070

Cuda-Kerne 5888 Speichermenge 8GB GDDR6 Breite der Speicherschnittstelle 256-bit Basis/Boost-Takt 1.5/1.73Ghz

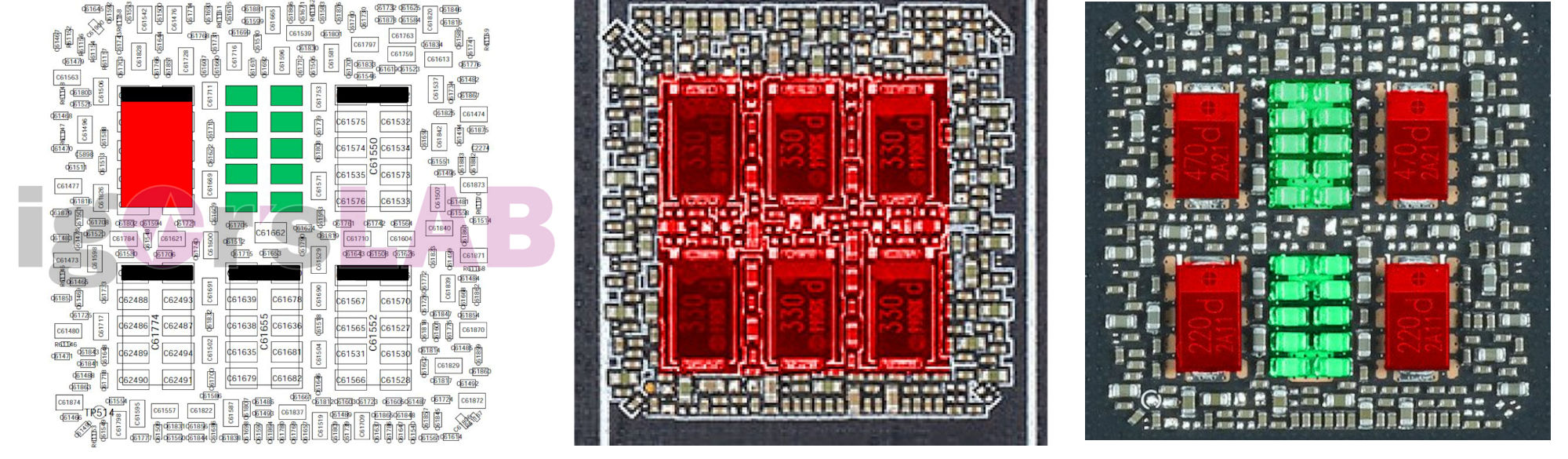

Nvflash für Ampere

[Sammelthread] - Nvidia Ampere [Sammelthread]

Varianten: 3090 Cuda-Kerne 10496 Speichermenge 24GB GDDR6X Breite der Speicherschnittstelle 384-bit Basis/Boost-Takt 1.4/1.7Ghz 3080 Cuda-Kerne 8704 Speichermenge 10GB GDDR6X Breite der Speicherschnittstelle 320-bit Basis/Boost-Takt 1.44/1.71Ghz 3070 Cuda-Kerne 5888...

Achtung Wasserkühler: Die Founders sind diesmal nicht Referenz-PCB.

This block is made for reference PCB 3080 and 3090 cards. Founders Edition does NOT have a reference PCB.

Overclock.net pflegt eine Liste um Referenz von Custom-PCBs zu trennen. Die Informationen dort bitte unter Vorbehalt genießen.

[Official] NVIDIA RTX 3090 Owner's Club

Schneller Weg wie man UV mit dem Kurve-Editor betreibt:

https://www.hardwareluxx.de/community/threads/nvidia-ampere-sammelthread.1275880/post-27788642 bzw. https://www.hardwareluxx.de/community/threads/nvidia-ampere-sammelthread.1275880/post-27789066

Dickstes Bios für die Karten mit zwei Anschlüssen bei den 3090ern zur Zeit das Gigabyte Gamer OC 390W

Crossflash zwischen Referenzboards ist möglich. Allerdings werden, dank der unterschiedlichen Graka-Ausgänge gleich mal ein oder zwei DP-Ports nicht mehr benutzbar.

Man kann natürlich auch ein Bios einer 3-Anschluss-Karte auf eine Karte mit zwei Anschlüssen flaschen, bringt aber nix, weil die Karte nun mal keinen Strom über den fehlenden dritten Anschluss aufnehmen kann.

Zuletzt bearbeitet:

meine 1080Ti ist gerade gestorben. BF5 gestartet und das Netzteil macht klack und aus. Mit der Graka drin Schutzabschaltung, so ne Scheiße. Ma schauen ob Zotac noch welche hat.

meine 1080Ti ist gerade gestorben. BF5 gestartet und das Netzteil macht klack und aus. Mit der Graka drin Schutzabschaltung, so ne Scheiße. Ma schauen ob Zotac noch welche hat.