NVIDIA GeForce GTX 780 Ti (GK110) Sammelthread + FAQ

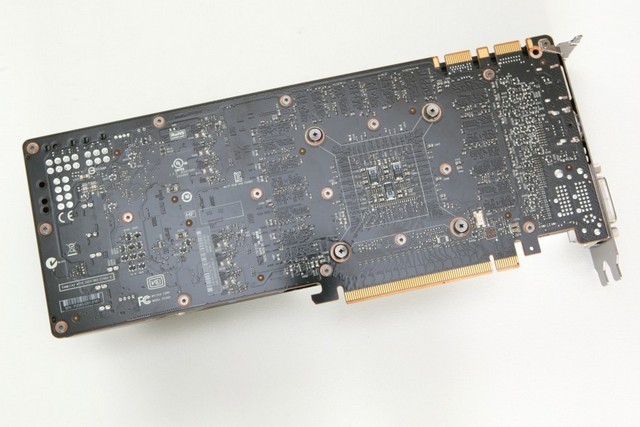

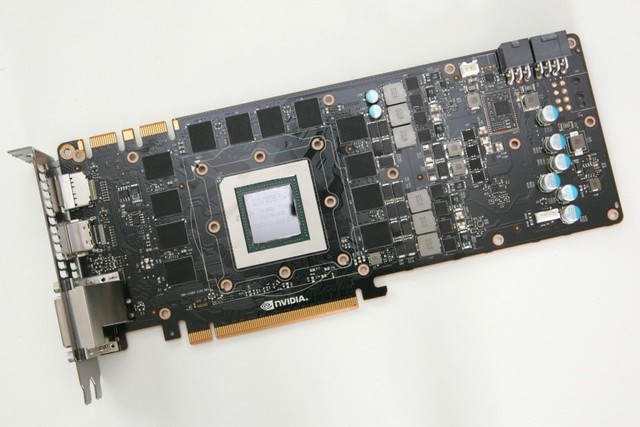

Impressionen der Karte:

Technische Daten der GeForce GTX 780

- Chip = GK110-425-B1

- Fertigung = 28 nm (TSMC)

- Transistoren = 7,1 Milliarden

- Die-Größe = 561 mm²

- Shader-Einheiten = 2880 (1D) (15 SMX)

- Texture Mapping Units (TMUs) = 240

- Raster Operations (ROPs) = 48

- Pixelfüllrate = 42,0 GPixel/s (real 35,0 GPixel/s)

- Texelfüllrate = 210,2 GTexel/s

- Chiptakt = 876 MHz Baseclock + Boost (928 MHz) + Estimated Boost

- Shadertakt = Chiptakt (876 MHz Baseclock + Boost (928 MHz)+ Estimated Boost)

- Speichertakt = 1750 MHz

- Speichergröße = 3072 MB

- Speichertyp = GDDR5 (Samsung)

- Speicherinterface = 384 Bit

- Speicherbandbreite = 336,0 GB/Sek.

- Shader Model = 5.0

- DirectX = 11.0

- Leistungsaufnahme 3D (TDP) = 250W (PCGH hat bei ihrem Sample 222W in BF: Bad Company 2 gemessen)

- Leistungsaufnahme 2D = 15 Watt

- Versorgung über jeweils einen 8-Pin & 6-Pin PCI-Express Anschluss

- Anschlussmöglichkeiten = 2 x DL-DVI (1 x DVI-D, 1 x DVI), 1 x HDMI 1.4a, 1 x DisplayPort 1.2

- Hinweis: Multi-Monitoring = Die Karte kann bis zu vier Monitore gleichzeitig ansteuern, im Surround-Modus (2D und 3D) maximal drei.

- Hinweis: Je nach Taktraten können Rechenleistung, Pixelfüllrate und Texelfüllrate sowie der Stromverbrauch abweichen.

- Die Karte nutzt PCIe 3.0, ist aber völlig abwärtskompatibel

Introducing the GeForce GTX 780 Ti | GeForce

NVIDIA GeForce GTX 780 Ti Announcement Video

Einzelkartentests:

- PCGH - Nvidia Geforce GTX 780 Ti im Test

- Computerbase - Nvidia GeForce GTX 780 Ti im Test

- Tom's HardwareTestbericht Nvidia GeForce GTX 780 Ti

- -

- englisch:

- TechPowerup: NVIDIA GeForce GTX 780 Ti Review

- AnandTech | NVIDIA GeForce GTX 780 Ti Review

- GeForce GTX 780 Ti review - Article

- NVIDIA GeForce GTX 780 Ti Review

- HARDOCP - GeForce GTX 780 Ti - NVIDIA GeForce GTX 780 Ti Video Card Review

- VIDIA GeForce GTX 780 Ti Graphics Card Review - Introduction

- NVIDIA GeForce GTX 780 Ti 3GB Graphics Card Review | PC Perspective

- -

- SLI-Tests

- Guru3D - GTX 780 Ti SLI

- -

Geizhals Link:

GeForce GTX 780 Ti | Deutschland - Hardwareluxx - Preisvergleich

Treiber:

Alle Infos und neuste Treiber findet ihr in diesem Thread hier

oder direkt bei Nvidia

Tools:

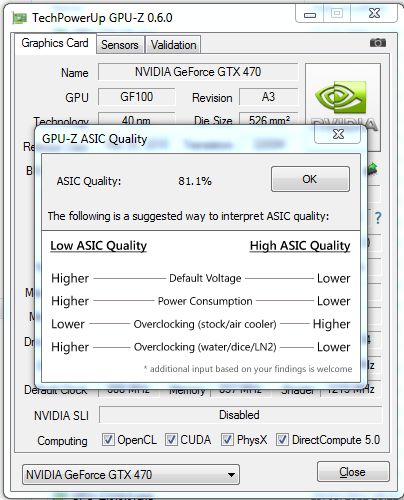

Grafikkarten Analyse Tool GPU-Z hier

NVIDIA Inspector (Analyse Tool, OC, erw. Treibersettings) hier

EVGA Precision X hier

MSI Afterburner hier

FurMark VGA Stress Test hier

Futuremark 3D Mark (2013 - Basic Edition) hier

Futuremark 3D Mark 11 (Basic Edition) hier

Unigine Heaven 4.0 Benchmark (Basic Edition) hier

Unigine Valley 1.0 Benchmark (Basic Edition) hier

FAQ (Frequently Asked Questions)

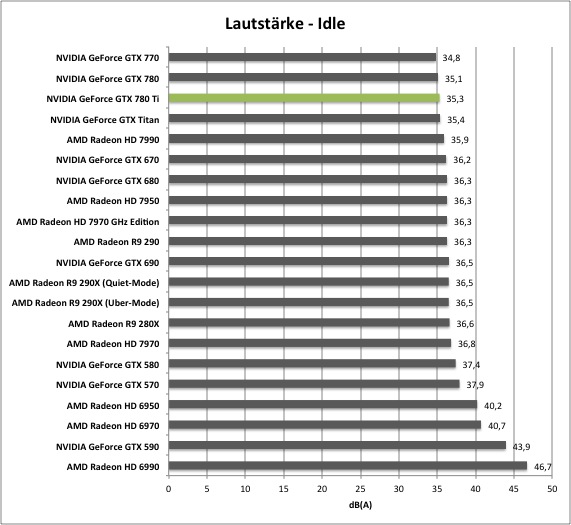

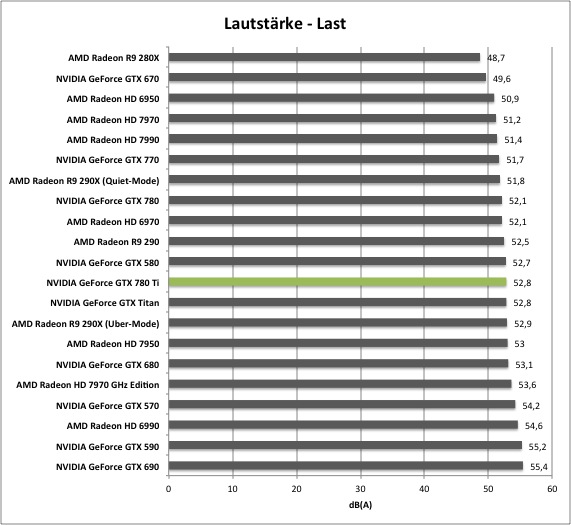

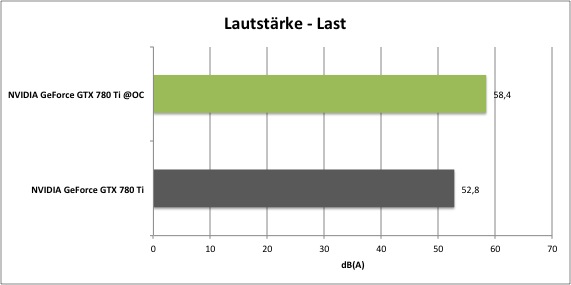

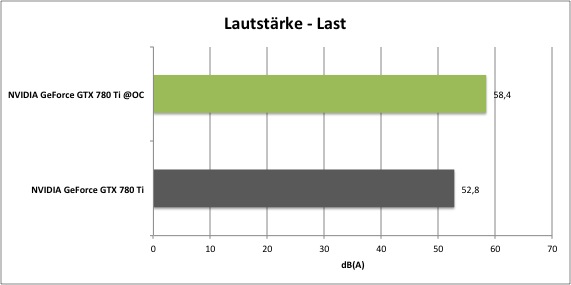

Wie laut ist die Karte?

Die GeForce GTX 780 Ti erzeugt sowohl im Idle weiterhin eine sehr gute Lautstärke, unter Last wird die Karte zuweilen etwas Lauter, da Nvidia das Temperatur-Target von 79°C auf 83°C gestellt halt. Dadurch wird die Karte zwar etwas wärmer und lauter, kann aber länger höhere Taktstufen nutzen. Unter Last ist eine GTX 780 vergleichbar mit dem "Quiet-Modus" der Radeon R9-290X.

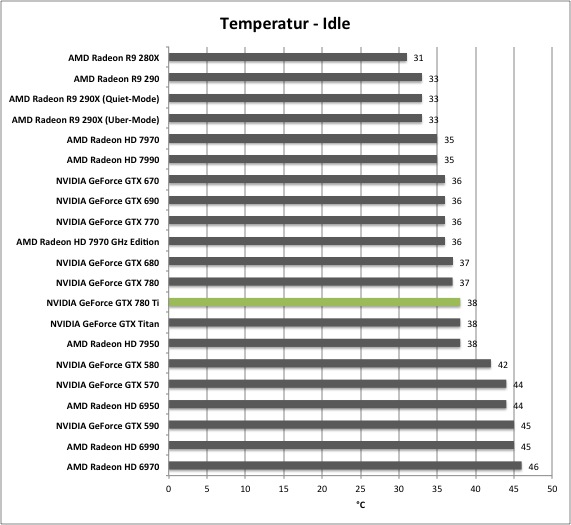

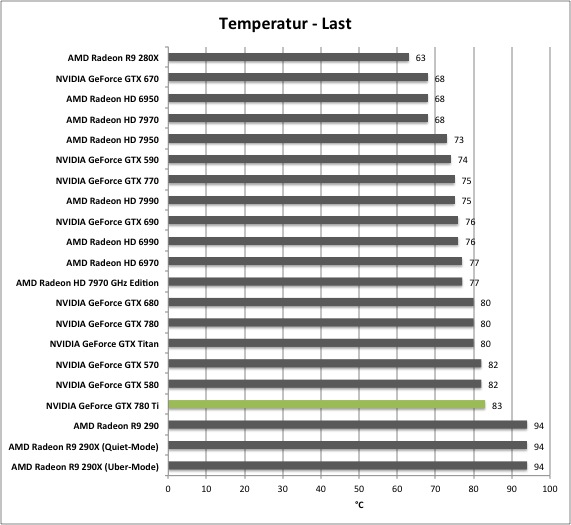

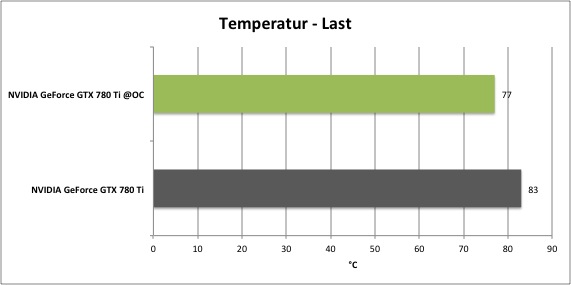

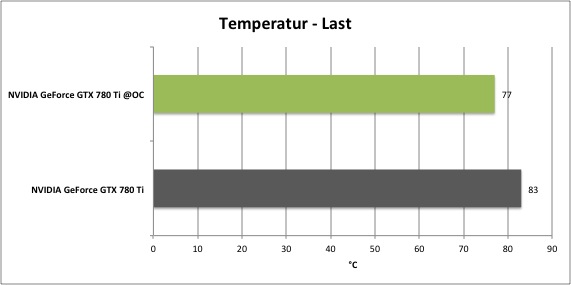

Wie hoch sind die Temperaturen der Karte?

Wie schon erwähnt liegt das Temperatur-Target der Karte anders als bei der GTX Titan, 780 und 770 nicht mehr bei 79°C, sondern bei 83°C. Dadurch erreicht die Karte unter Last zwischen 80 und 83°C.

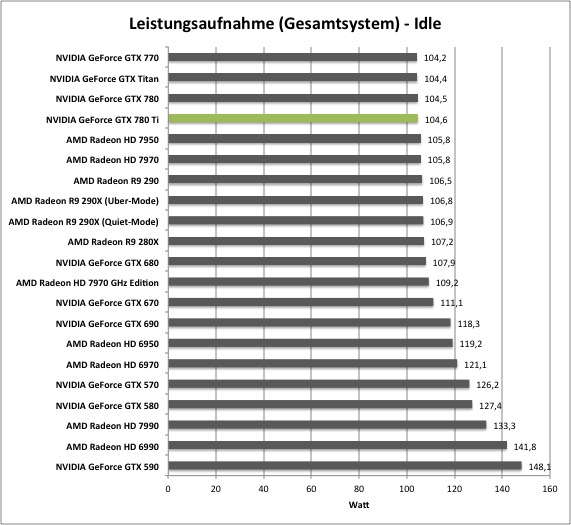

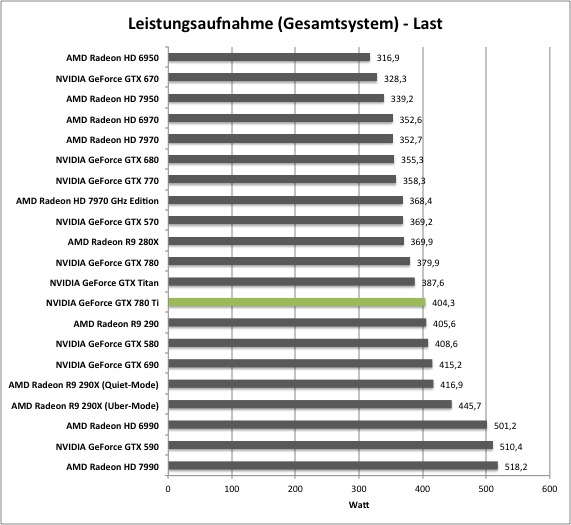

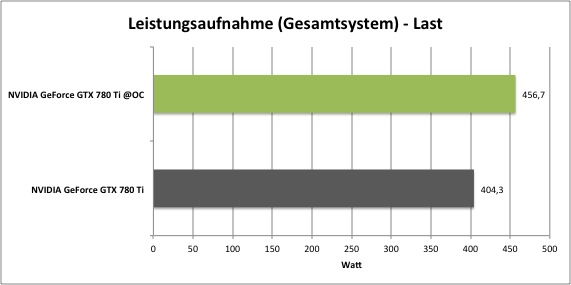

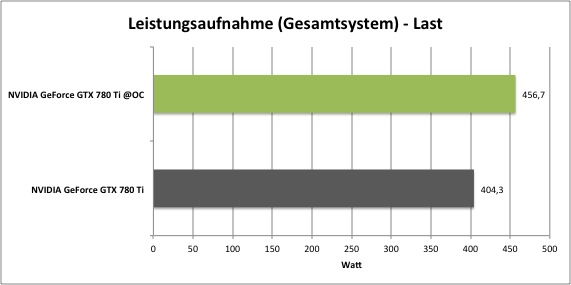

Wie hoch ist der Stromverbrauch?

Im Idle liegt die GTX 780 Ti auf dem Selben Level wie die GeForce GTX 780 und GTX TITAN. Unter Spielelast nimmt die Karte um die 240 bis 250 Watt (Messung von PCGH bei BF: Bad Company 2 und Anno 2070). Dies liegt recht nah an der TDP von 250 Watt, welche wie schon auf die GTX 780 und GTX Titan einem Power-Target von 100% entspricht.

Hier die Messungen (gesamtes System) von HardwareLUXX:

Wichtiger Hinweis: Die Verbrauchsmessungen sind immer von den eingesetzten Komponenten, etwa dem Netzteil, abhängig und somit eher als Anhaltspunkt zu sehen!

Passt die Karte in mein Gehäuse?

Bei der GeForce GTX 780 Ti misst das PCB 26,67 cm, wie bei der GTX 770, 780 und Titan, was vielen High-End Karten vergangener Generationen wie etwa der GeForce 400- oder 500-Serie entspricht.

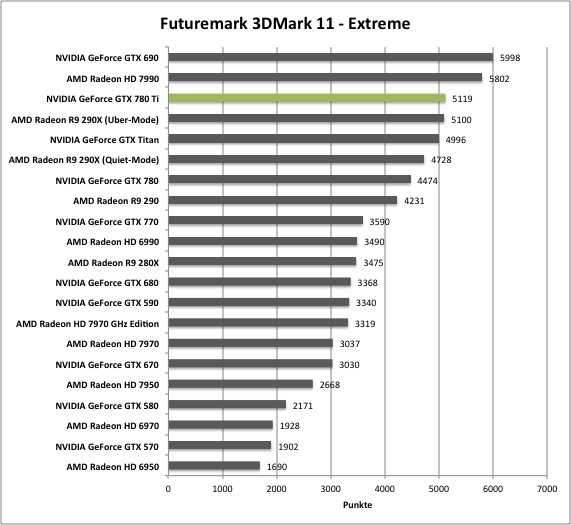

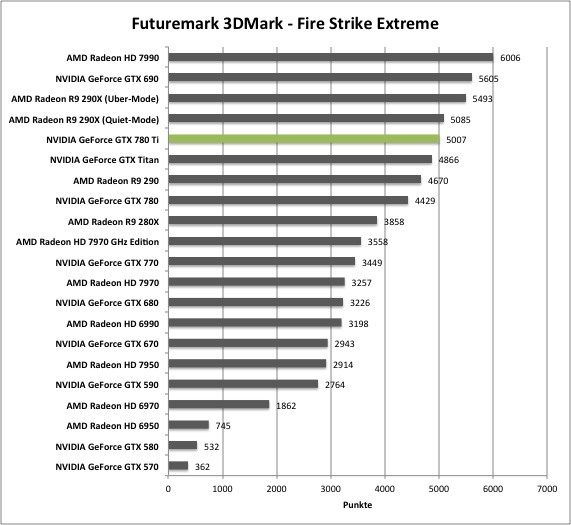

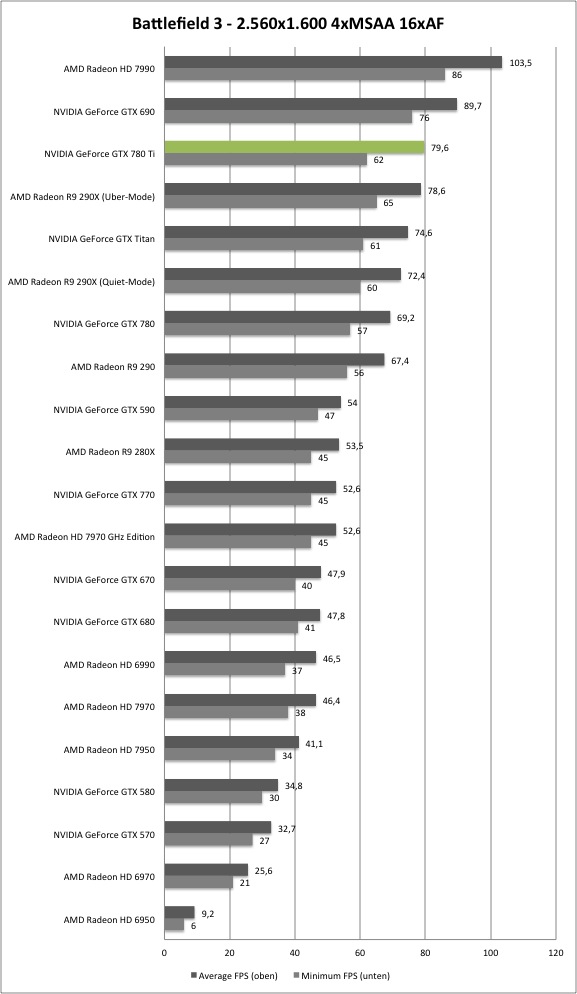

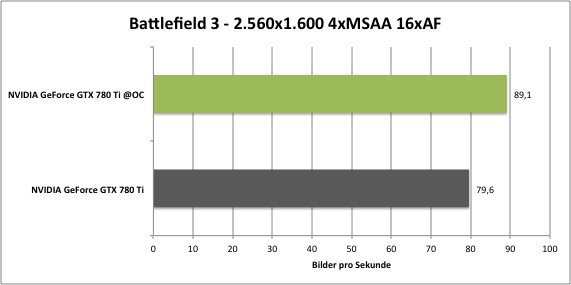

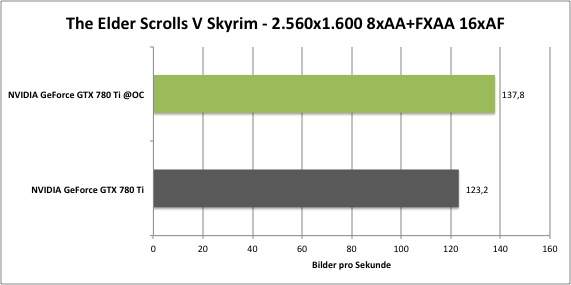

Die Performance:

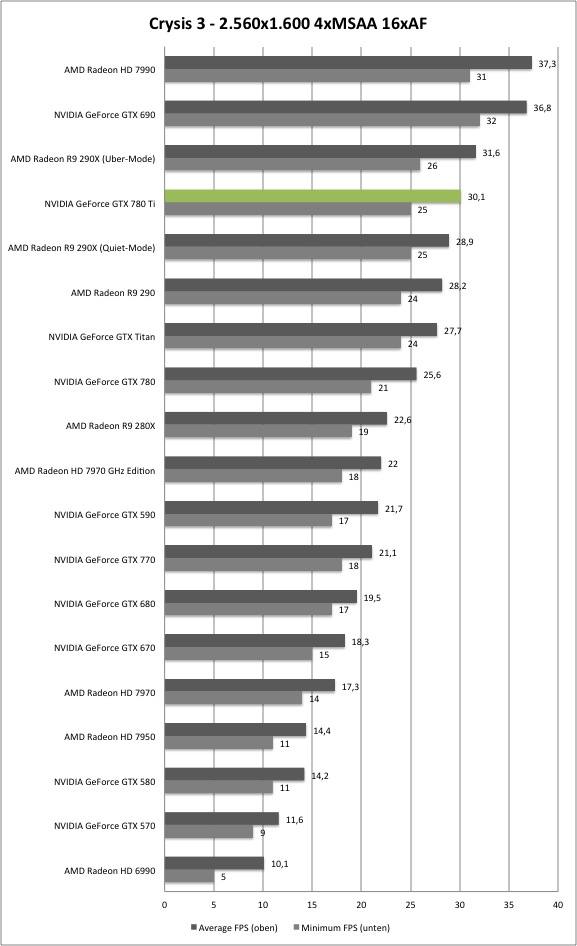

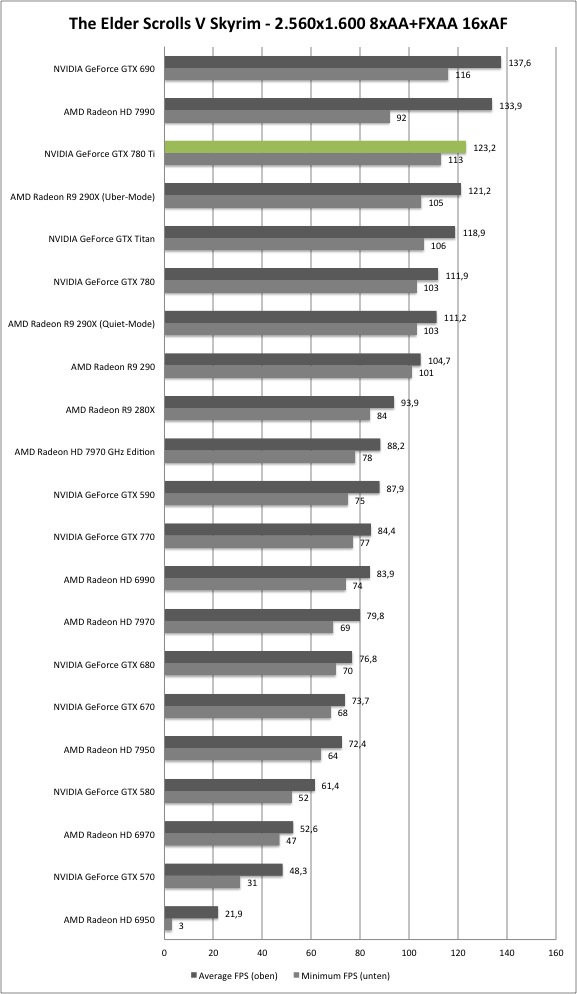

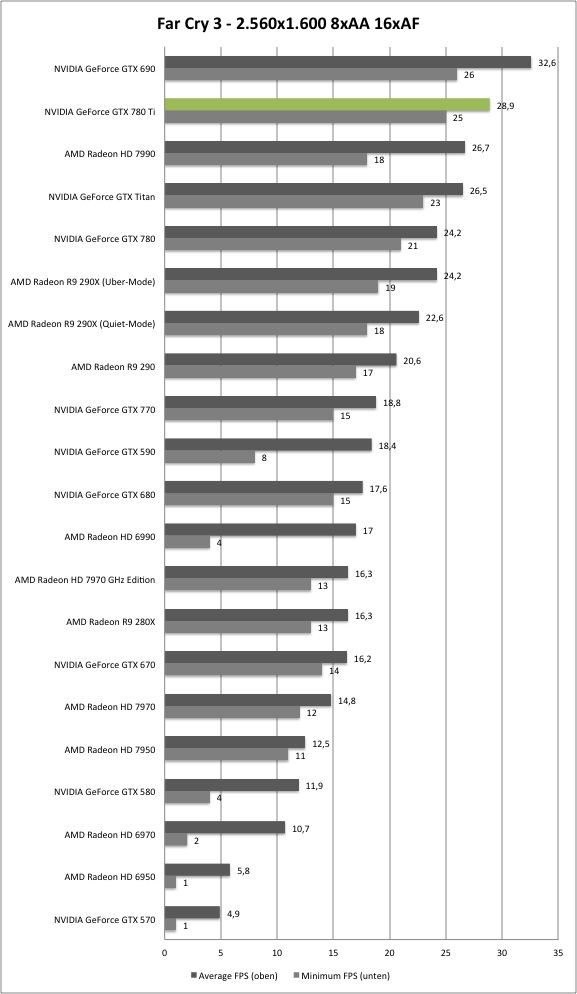

Eine Performanceeinordnung findet ihr im Hardwareluxx-test zur GeForce GTX 780. Im Schnitt erreicht die GTX 780 Ti in etwa die Performance der R9-290X im Übermodus oder knapp darüber und ist somit wieder die schnellste Single-GPU-Karte der Welt.

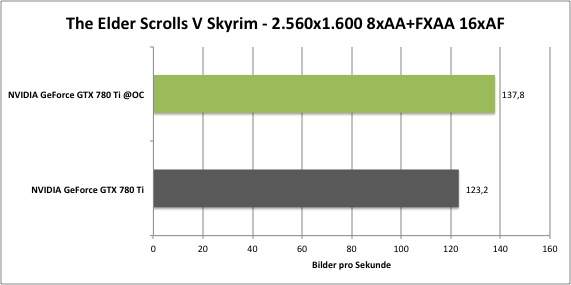

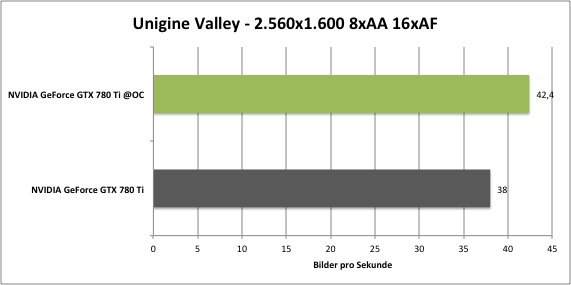

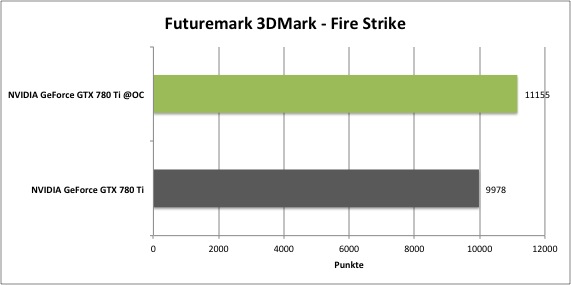

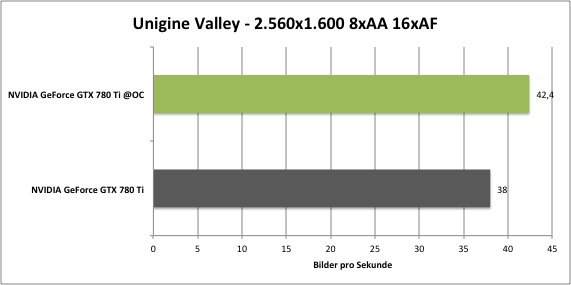

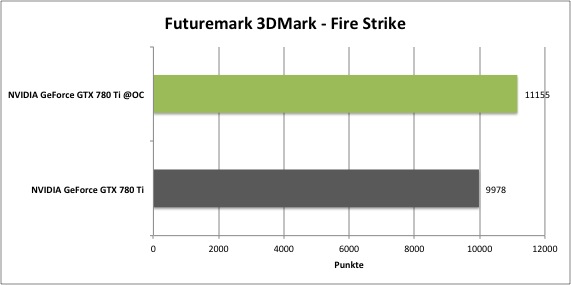

Einige Messwerte:

Eine genauere Einordnung über mehrere Benchmarks findet ihr hier:

Launch-Analyse: nVidia GeForce GTX 780

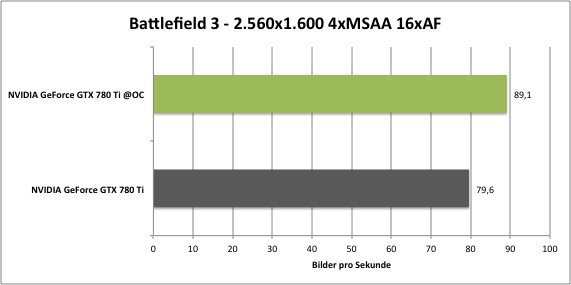

Overclocking:

Wie bei jeder Karte, die auf der Kepler-Architektur basiert, lässt sich der Takt von GPU/Shader und VRAM nicht mehr direkt absolut einstellen. Man arbeitet stattdessen über einen "Offset" zur Basistaktrate, welcher sowohl den Basistakt, als auch den Boost-Takt gleichermaßen anhebt.

(Seit der GTX 680 nimmt die GPU immer nur noch 13MHz schritte an. Wenn man z.B. +50MHz Offset angibt, erhält man aber nur +39MHz mehr GPU-Takt, da in den +50MHz nur drei +13MHz Stufen drin sind. Die nächst höhere Stufe wären +52MHz.)

Die Höhe des GPU Boostes wird vollständig durch die Hardware geregelt. Es halten aber Messwerte wie Temperatur und anliegende Last in der Ermittlung der Höhe mit Einzug. So schwankt die Taktrate der GPUs ein paar MHz während der Anwendung. Hardwareluxx erreichte bei eingestellten 1,212V, Temperatur-Target von 95°C und Power-Target von 106% eine maximale Taktrate von 1163/1825MHz.

Performance:

Allgemeine Hinweise

Dies ist ein Sammelthread für die GeForce GTX 780 Ti. Das heißt, es darf und soll hier über die Karte diskutiert werden und den Usern auch als Kaufberatung dienen.

Natürlich ist ein Vergleich, etwa in Sachen Leistung, zu anderen Karten (GTX 780, Titan und Radeon R9-290(X) uvm.) angemessen.

Dieser Thread wird in zukunft erweitert.

Zuletzt bearbeitet:

bei mir..

bei mir..