NVIDIA GeForce GTX TITAN (GK110) Sammelthread + FAQ

Impressionen der Karte:

Technische Daten der GeForce GTX Titan

- Chip = GK110-400-A1

- Fertigung = 28 nm (TSMC)

- Transistoren = 7,1 Milliarden

- Die-Größe = 551 mm²

- Shader-Einheiten = 2688 (1D) (14 SMX)

- Texture Mapping Units (TMUs) = 224

- Raster Operations (ROPs) = 48

- Pixelfüllrate = 40,2 GPixel/s

- Texelfüllrate = 187,5 GTexel/s

- Chiptakt = 837 MHz Baseclock + Boost (876 MHz) + 1006 MHz Estimated Boost

- Shadertakt = Chiptakt (837 MHz Baseclock + Boost (876 MHz)+ 1006 MHz Estimated Boost)

- Speichertakt = 1502 MHz

- Speichergröße = 6144 MB

- Speichertyp = GDDR5 (Samsung)

- Speicherinterface = 384 Bit

- Speicherbandbreite = 288,4 GB/Sek.

- Shader Model = 5.0

- DirectX = 11.0

- Leistungsaufnahme 3D (TDP) = 250W (PCGH hat bei ihrem Sample 214W in BF: Bad Company 2 gemessen)

- Leistungsaufnahme 2D = 15 Watt

- Versorgung über jeweils einen 8-Pin & 6-Pin PCI-Express Anschluss

- Anschlussmöglichkeiten = 2 x DL-DVI (1 x DVI-D, 1 x DVI), 1 x HDMI 1.4a, 1 x DisplayPort 1.2

- Hinweis: Multi-Monitoring = Die Karte kann bis zu vier Monitore gleichzeitig ansteuern, im Surround-Modus (2D und 3D) maximal drei.

- Hinweis: Je nach Taktraten können Rechenleistung, Pixelfüllrate und Texelfüllrate sowie der Stromverbrauch abweichen.

- Die Karte nutzt PCIe 3.0, ist aber völlig abwärtskompatibel

Introducing The GeForce GTX TITAN (NVIDIA, Andrew Burns)http://www.geforce.co.uk/whats-new/articles/introducing-the-geforce-gtx-titan

Download The GeForce GTX TITAN Wallpaper (NVIDIA)http://www.geforce.co.uk/whats-new/articles/nvidia-geforce-gtx-titan-wallpaper-now-available

Reviews zur Karte:

Videos zu NVIDIA GeForce GTX TITAN (NV & Previews/Reviews)

NVIDIA GeForce GTX TITAN Announcement

<iframe width="560" height="315" src="http://www.youtube.com/embed/0_xgeOZrnJI" frameborder="0" allowfullscreen></iframe>

NVIDIA GeForce GTX TITAN 6GB Live Review Recap - PC Perspective (mit Tom Petersen von NV)

<iframe width="560" height="315" src="http://www.youtube.com/embed/qsuvlg8cuWA" frameborder="0" allowfullscreen></iframe>

HardwareLUXX - NVIDIA GeForce GTX TITAN - Teil 1 & 2

<iframe width="560" height="315" src="http://www.youtube.com/embed/ABhkIpF5Dj0" frameborder="0" allowfullscreen></iframe>

<iframe width="560" height="315" src="http://www.youtube.com/embed/hUPsFBmZr9A" frameborder="0" allowfullscreen></iframe>

NVIDIA GeForce GTX Titan Unboxing & Technology Overview Linus Tech Tips

<iframe width="560" height="315" src="http://www.youtube.com/embed/bgQbcQlRoNE?list=UUXuqSBlHAE6Xw-yeJA0Tunw" frameborder="0" allowfullscreen></iframe>

GTX Titan LCD Monitor Overclocking Guide Linus Tech Tips

An dieser Stelle möchten wir Ihnen ein Youtube-Video zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Youtube setzt durch das Einbinden und Abspielen Cookies auf ihrem Rechner, mit welchen sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf den Play-Button. Das Video wird anschließend geladen und danach abgespielt.

Youtube Videos ab jetzt direkt anzeigen

GeForce GTX Titan 1080p Performance Review Linus Tech Tips

<iframe width="560" height="315" src="http://www.youtube.com/embed/dRloMkcVeus" frameborder="0" allowfullscreen></iframe>

GeForce GTX Titan 1600p Performance Review Linus Tech Tips

<iframe width="560" height="315" src="http://www.youtube.com/embed/L1dN4aN6vS0" frameborder="0" allowfullscreen></iframe>

GeForce GTX Titan Surround Performance Review Linus Tech Tips

<iframe width="560" height="315" src="http://www.youtube.com/embed/Qw24094REh0" frameborder="0" allowfullscreen></iframe>

<iframe width="560" height="315" src="http://www.youtube.com/embed/0_xgeOZrnJI" frameborder="0" allowfullscreen></iframe>

NVIDIA GeForce GTX TITAN 6GB Live Review Recap - PC Perspective (mit Tom Petersen von NV)

<iframe width="560" height="315" src="http://www.youtube.com/embed/qsuvlg8cuWA" frameborder="0" allowfullscreen></iframe>

HardwareLUXX - NVIDIA GeForce GTX TITAN - Teil 1 & 2

<iframe width="560" height="315" src="http://www.youtube.com/embed/ABhkIpF5Dj0" frameborder="0" allowfullscreen></iframe>

<iframe width="560" height="315" src="http://www.youtube.com/embed/hUPsFBmZr9A" frameborder="0" allowfullscreen></iframe>

NVIDIA GeForce GTX Titan Unboxing & Technology Overview Linus Tech Tips

<iframe width="560" height="315" src="http://www.youtube.com/embed/bgQbcQlRoNE?list=UUXuqSBlHAE6Xw-yeJA0Tunw" frameborder="0" allowfullscreen></iframe>

GTX Titan LCD Monitor Overclocking Guide Linus Tech Tips

Datenschutzhinweis für Youtube

An dieser Stelle möchten wir Ihnen ein Youtube-Video zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Youtube setzt durch das Einbinden und Abspielen Cookies auf ihrem Rechner, mit welchen sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf den Play-Button. Das Video wird anschließend geladen und danach abgespielt.

Youtube Videos ab jetzt direkt anzeigen

GeForce GTX Titan 1080p Performance Review Linus Tech Tips

<iframe width="560" height="315" src="http://www.youtube.com/embed/dRloMkcVeus" frameborder="0" allowfullscreen></iframe>

GeForce GTX Titan 1600p Performance Review Linus Tech Tips

<iframe width="560" height="315" src="http://www.youtube.com/embed/L1dN4aN6vS0" frameborder="0" allowfullscreen></iframe>

GeForce GTX Titan Surround Performance Review Linus Tech Tips

<iframe width="560" height="315" src="http://www.youtube.com/embed/Qw24094REh0" frameborder="0" allowfullscreen></iframe>

Einzelkartentests:

- deutsch:

[*]HardwareLUXX - XXL-Test: NVIDIA GeForce GTX Titan im 3-way SLI- ComputerBase - Test: NVIDIA GeForce GTX Titan (SLI)

- HT4U -NVIDIA GeForce GTX Titan (Preview)

- PCGH -NVIDIA GeForce GTX Titan (inkl. SLI-Zusatztests)

- Tom's Hardware - NVIDIA GeForce GTX Titan (3-way-SLI)

- -

- englisch:

- Anandtech - NVIDIA GeForce GTX Titan Review - Part 1

- Anandtech - NVIDIA GeForce GTX Titan Review - Part 2 inkl. Benchmarks

- Guru3D - NVIDIA GeForce GTX Titan Review

- Guru3D - NVIDIA GeForce GTX Titan Overclock Guide

- Hardware Canucks - NVIDIA GeForce GTX Titan Performance Review

- [H]ard|OCP - NVIDIA GeForce GTX TITAN Video Card Review

- Hardware.Info - Nvidia GeForce GTX Titan review incl. 5760x1080 and frametimes

- Hardware Heaven - ZOTAC NVIDIA GTX Titan Graphics Card Review

- Hexus - Review: NVIDIA GeForce GTX TITAN

- HotHardWare - NVIDIA's GeForce GTX Titan: Yes, It CAN Play Crysis 3

- Legit reviews - NVIDIA GeForce GTX Titan Video Card Preview

- PC Perspective - NVIDIA GeForce GTX Titan Preview

- PC Perspective - NVIDIA GeForce GTX TITAN Performance Review and Frame Rating Update (SLI)

- TechPowerUp! - NVIDIA GeForce GTX TITAN 6 GB

- -

- Video-Reviews englisch:

- GeForce GTX Titan 1080p Performance Review Linus Tech Tips

- GeForce GTX Titan 1600p Performance Review Linus Tech Tips

- GeForce GTX Titan Surround Performance Review Linus Tech Tips

Geizhals Link:SLI-Tests:

- deutsch:

- HardwareLUXX - XXL-Test: NVIDIA GeForce GTX Titan im 3-way SLI

- ComputerBase - Test: NVIDIA GeForce GTX Titan (SLI)

- PCGH -NVIDIA GeForce GTX Titan (inkl. SLI-Zusatztests)

- Tom's Hardware - NVIDIA GeForce GTX Titan (3-way-SLI)

- -

- englisch:

- Hardware.Info -Nvidia GeForce GTX Titan 3-way/4-way SLI review incl. 5760x1080 and frametimes

- Guru3D - GeForce GTX Titan 3-way SLI and Multi monitor review

- PC Perspective - NVIDIA GeForce GTX TITAN Performance Review and Frame Rating Update (SLI)

- -

HardwareLUXX Preisvergleich - GeForce GTX Titan

Treiber:

Alle Infos und neuste Treiber findet ihr in diesem Thread hier

oder direkt bei Nvidia

Tools:

Grafikkarten Analyse Tool GPU-Z hier

NVIDIA Inspector (Analyse Tool, OC, erw. Treibersettings) hier

EVGA Precision X hier

MSI Afterburner hier

FurMark VGA Stress Test hier

Futuremark 3D Mark (2013 - Basic Edition) hier

Futuremark 3D Mark 11 (Basic Edition) hier

Unigine Heaven 4.0 Benchmark (Basic Edition) hier

Unigine Valley 1.0 Benchmark (Basic Edition) hier

FAQ (Frequently Asked Questions)

Brauche ich nun unbedingt ein Mainboard mit PCI-E 3.0?

Laut dem Test von VR-Zone bringt der PCI-E 3.0 Slot bei einer Radeon HD 7970 keine Leistungssteigerung.

Auch die Messungen auf Hardwareluxx mit einer GTX 690 bestätigen dieses Ergebnis. Hardwareluxx - Seite 19: Sondertests: PCI-Express 3.0

Damit kann man die Messungen anderer Reviews der aktuellen Grafikkartengeneration, ob Single oder Dual GPU 1:1, an der Stelle übernehmen und muss für eine Grafikkarte nicht extra umrüsten. Tests zur Quad-SLI Performance sind aber noch nicht verfügbar.

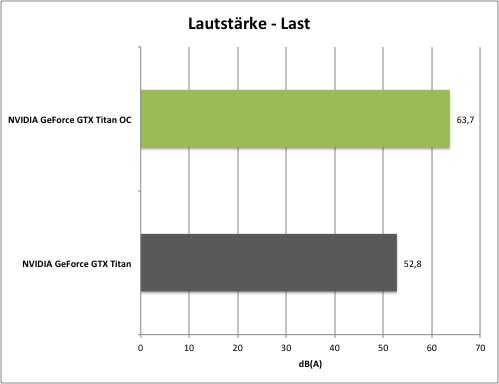

Wie laut ist die Karte?

Die GeForce GTX TITAN erzeugt sowohl im Idle, als auch unter Last eine für diese Preisklasse relativ niedrige Lautstärke und ist etwas leiser als etwa die GeForce GTX 680. Dort liegt man auf Niveau der GeForce GTX 580.

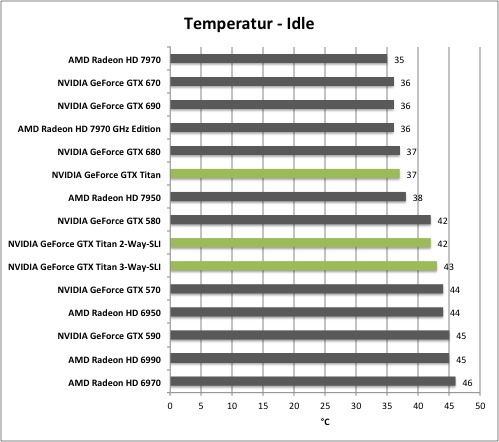

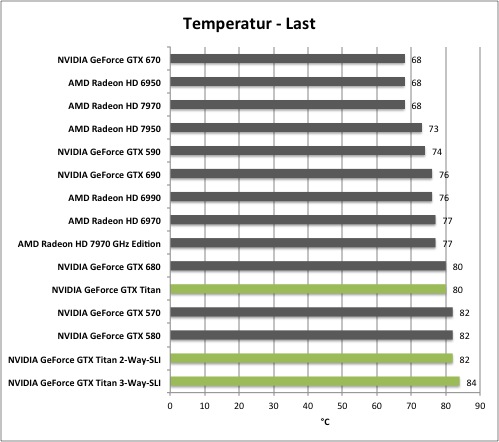

Wie hoch sind die Temperaturen der Karte?

Die Temperaturen der Karte entsprechen in etwa denen der GeForce GTX 680, was für eine Karte dieser Leistungsklasse als sehr gut zu bewerten ist.

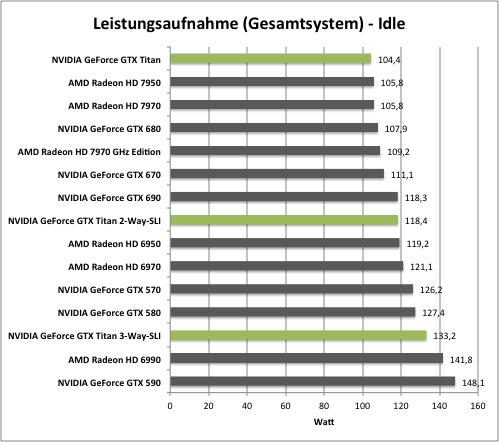

Wie hoch ist der Stromverbrauch?

Hinweis: Die Verbrauchsmessungen (Karte only) stammen von PCGH -> klick

Im Idle verbraucht die GeForce GTX Titan laut NVIDIA ca. 15 Watt, was auf einem Level mit der GeForce GTX 680 ist. Unter Spielelast nimmt die Karte etwa 214W (Messung von PCGH bei BF: Bad Company 2). Dies liegt also deutlich unter dem TDP, das wie auch das 100% Power-Target auf 250W spezifiziert ist.

Hier die Messungen (gesamtes System) von HardwareLUXX:

Wichtiger Hinweis: Die Verbrauchsmessungen sind immer von den eingesetzten Komponenten, etwa dem Netzteil, abhängig und somit eher als Anhaltspunkt zu sehen!

Passt die Karte in mein Gehäuse?

Bei der GeForce GTX Titan misst das PCB 26,67 cm, was vielen High-End Karten vergangener Generationen wie etwa der GeForce 400- oder 500-Serie entspricht.

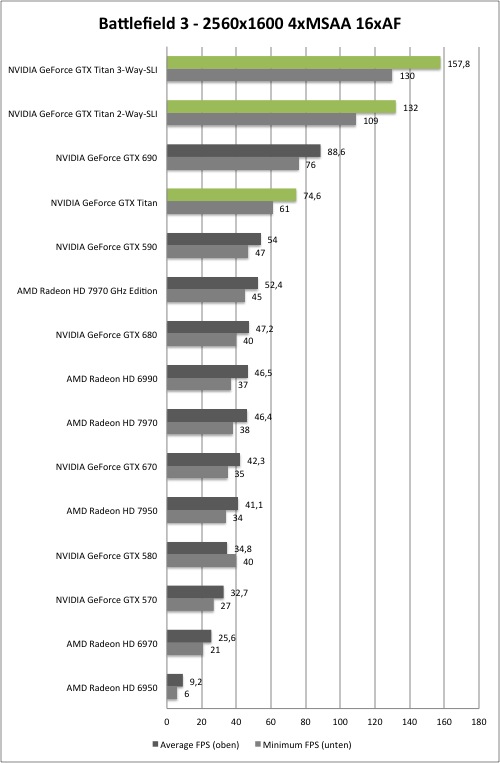

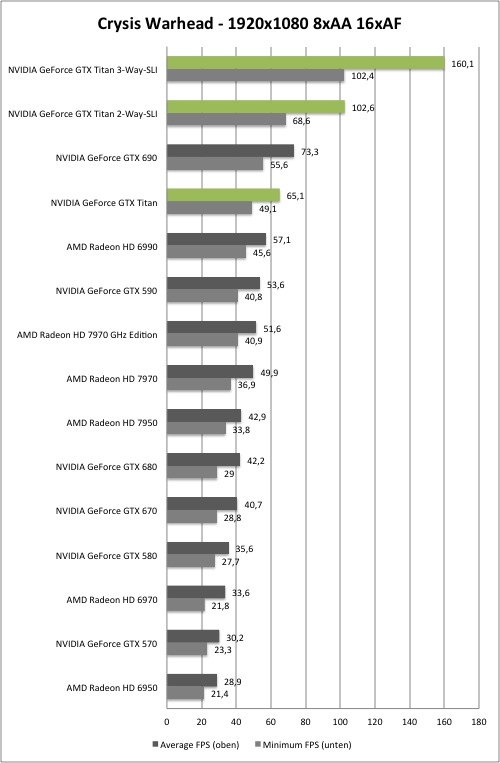

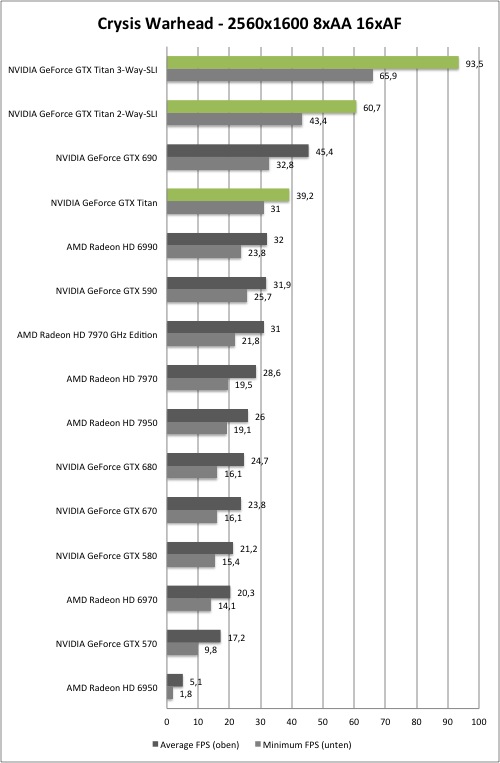

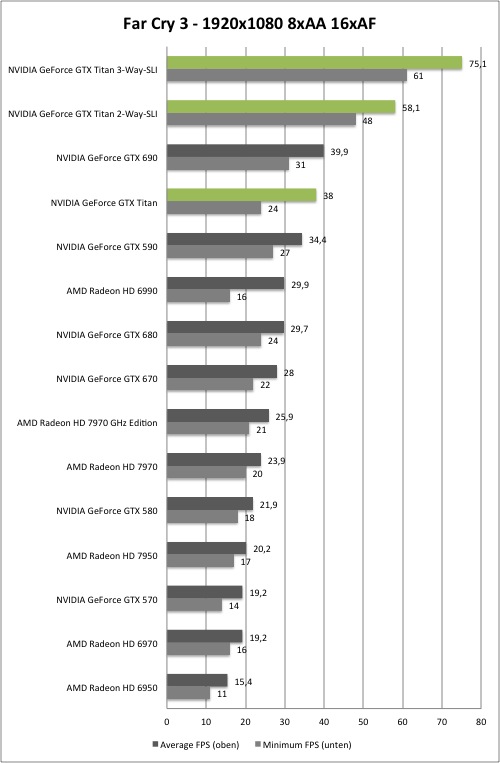

Die Performance:

Hier findet ihr eine kleine Auswahl von unseren Benchmarks um euch erstmal einen Überblick zu verschaffen, wo sich die Karte Leistungstechnisch einordnet. Alle weiteren Infos und Benchmarks findet ihr im Hardwareluxx Artikel zur GeForce GTX TITAN!

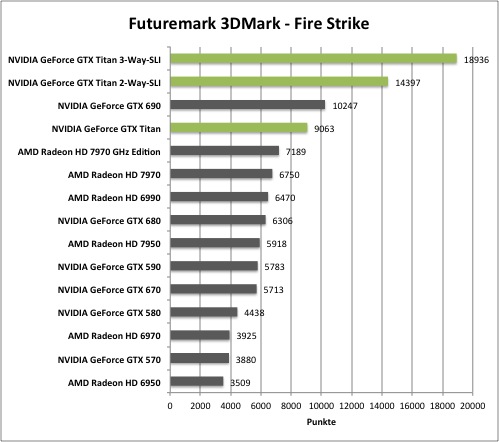

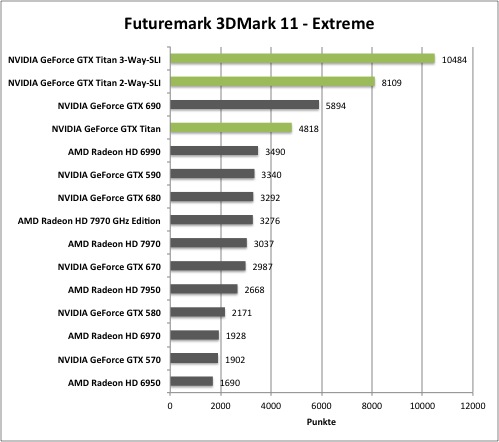

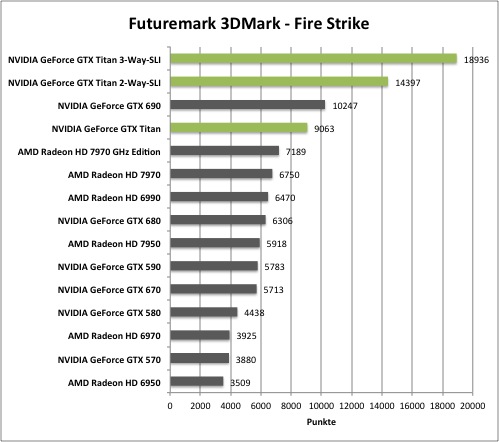

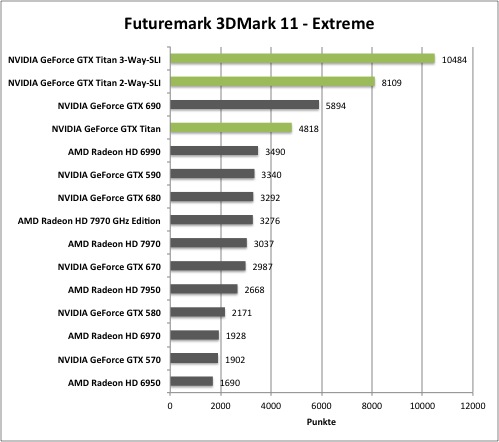

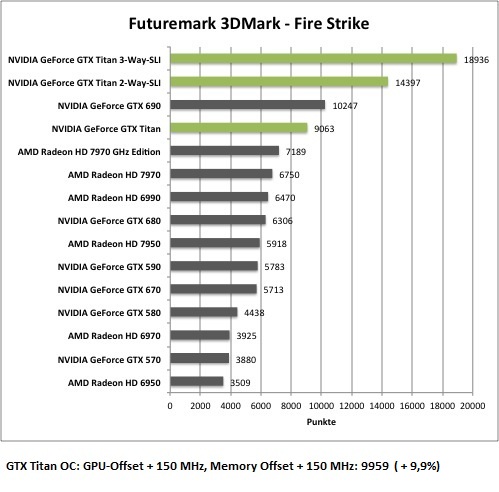

Synthetische Benchmarks

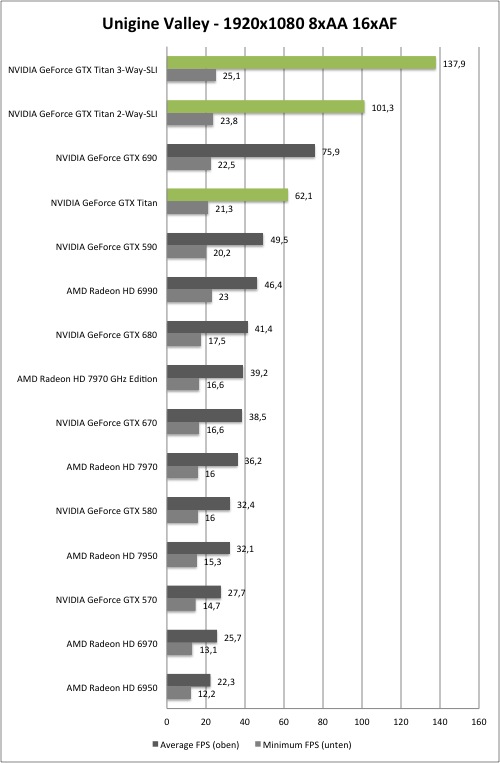

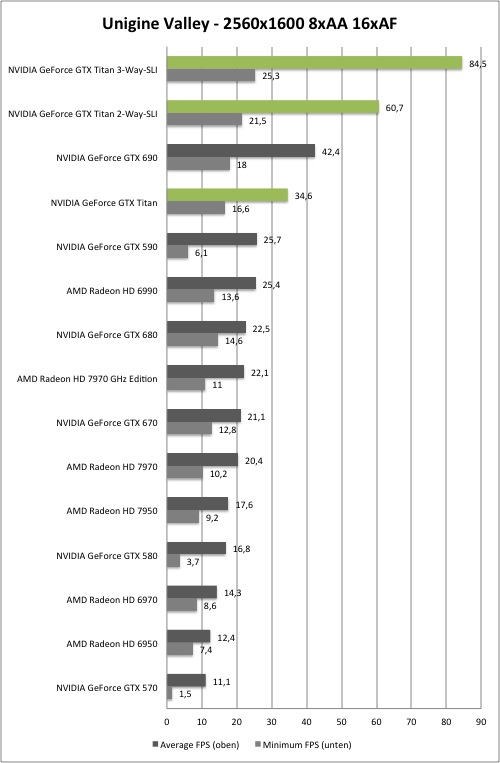

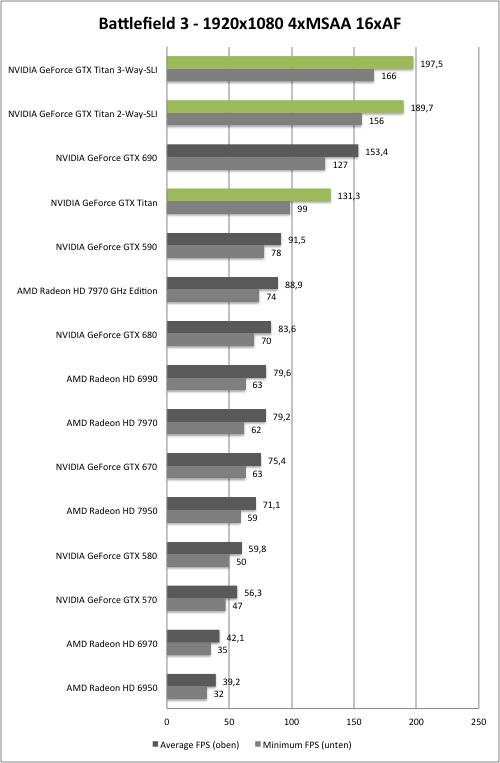

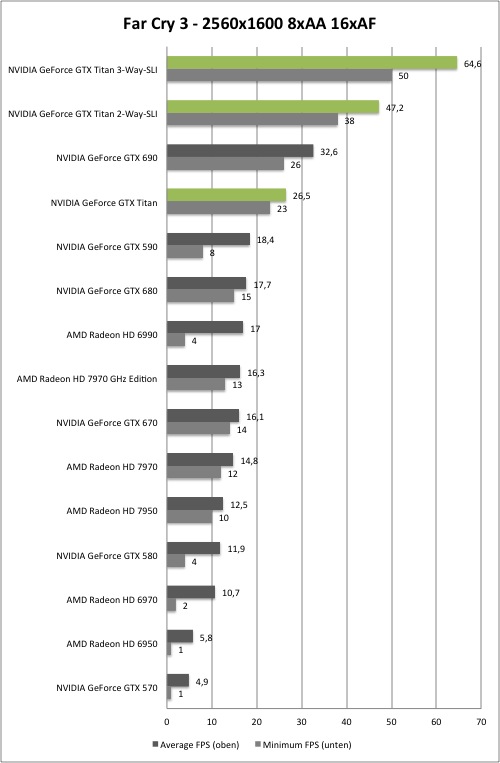

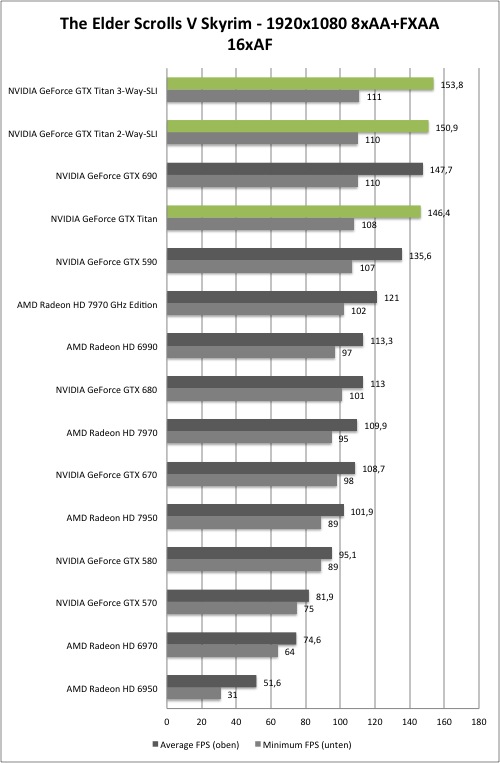

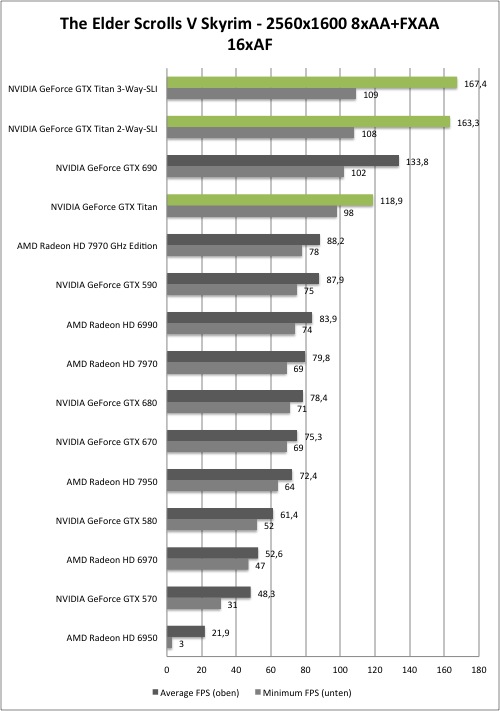

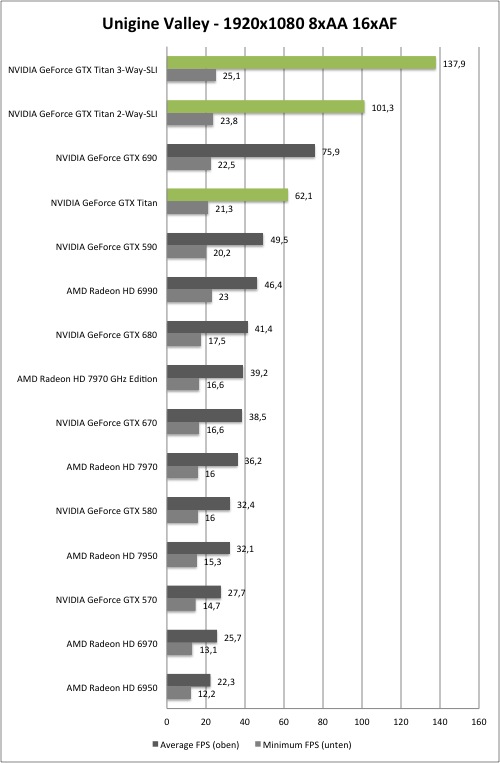

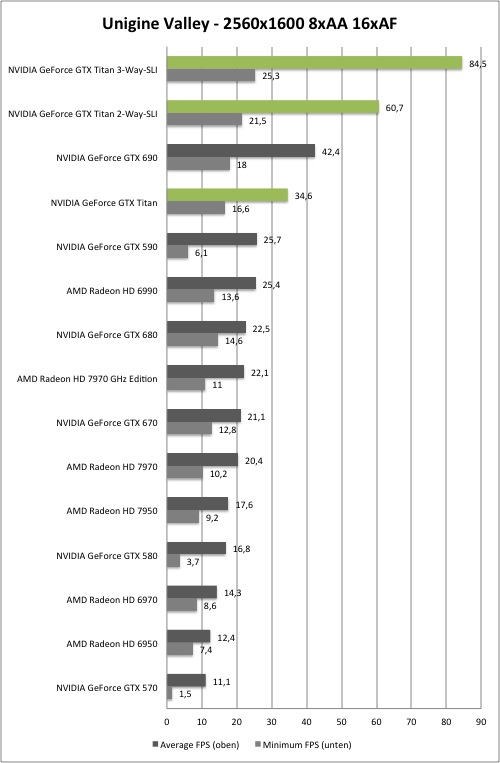

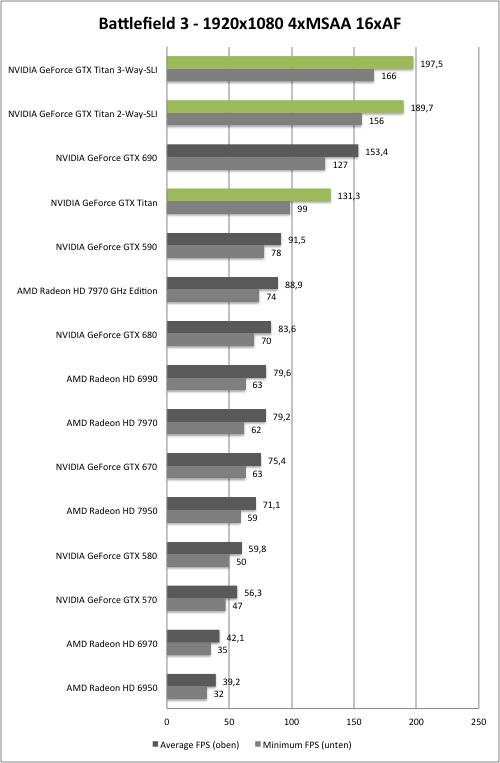

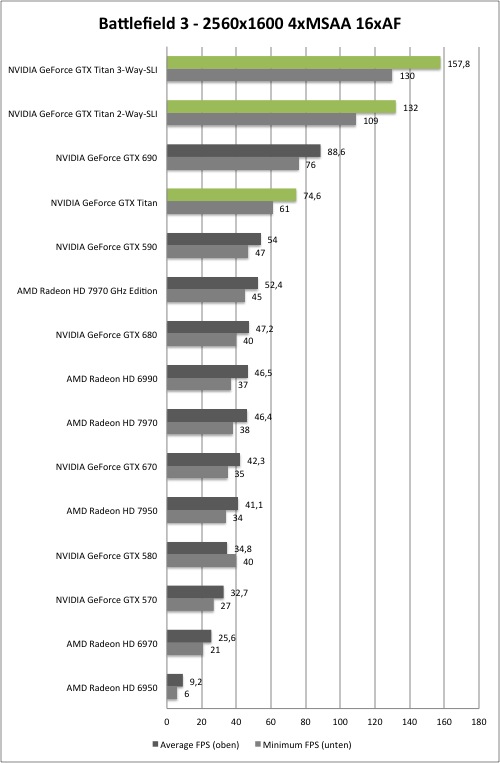

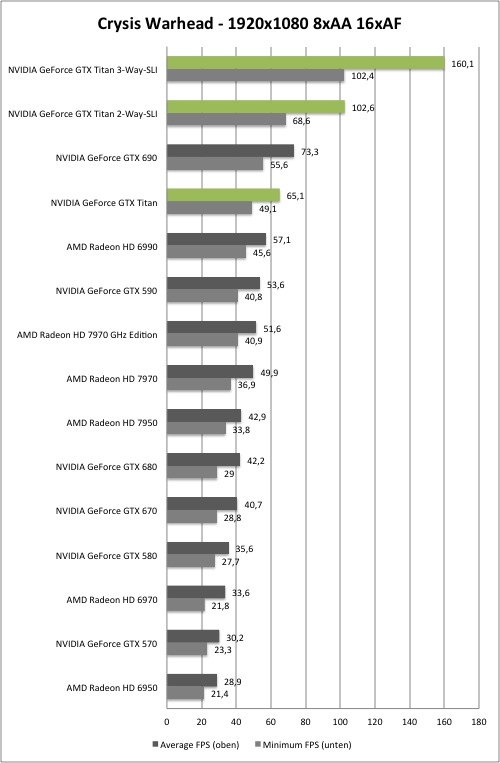

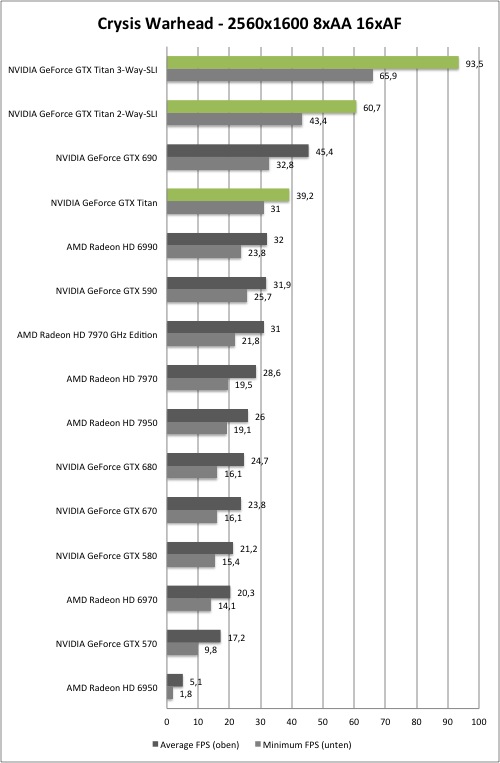

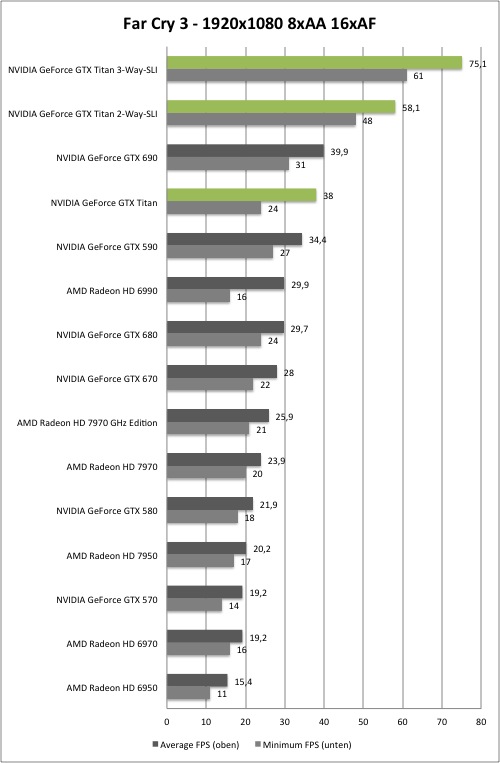

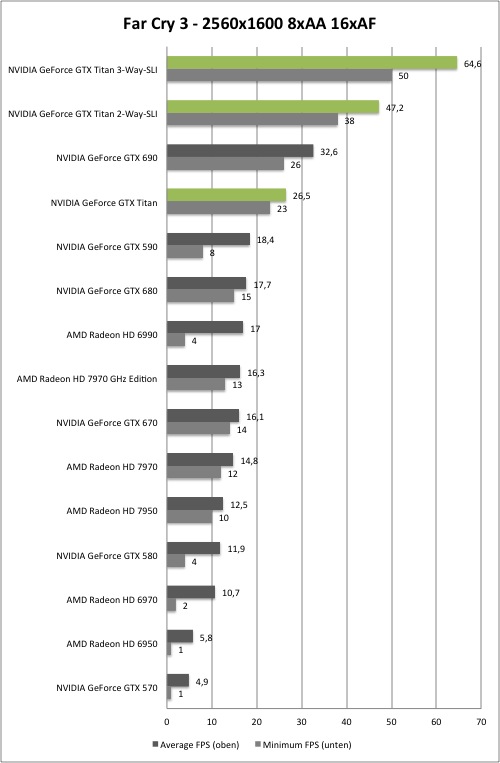

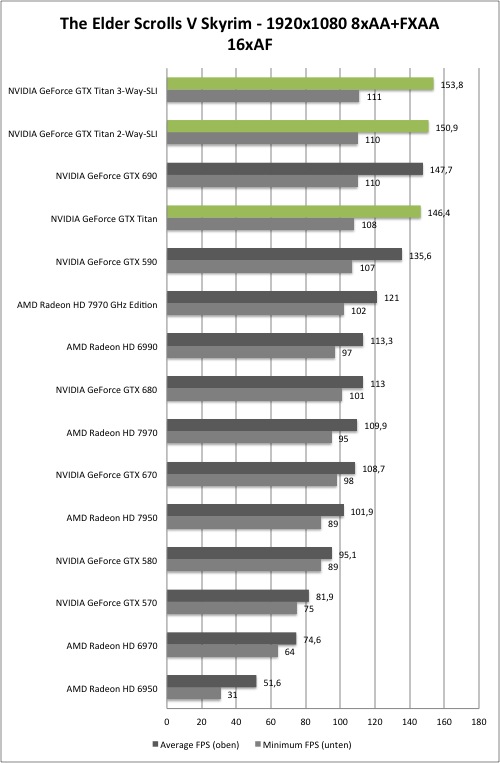

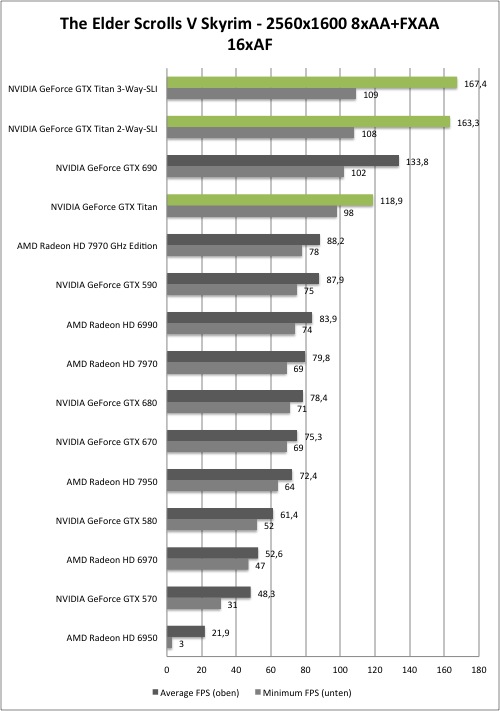

Game Benchmarks

Game Benchmarks

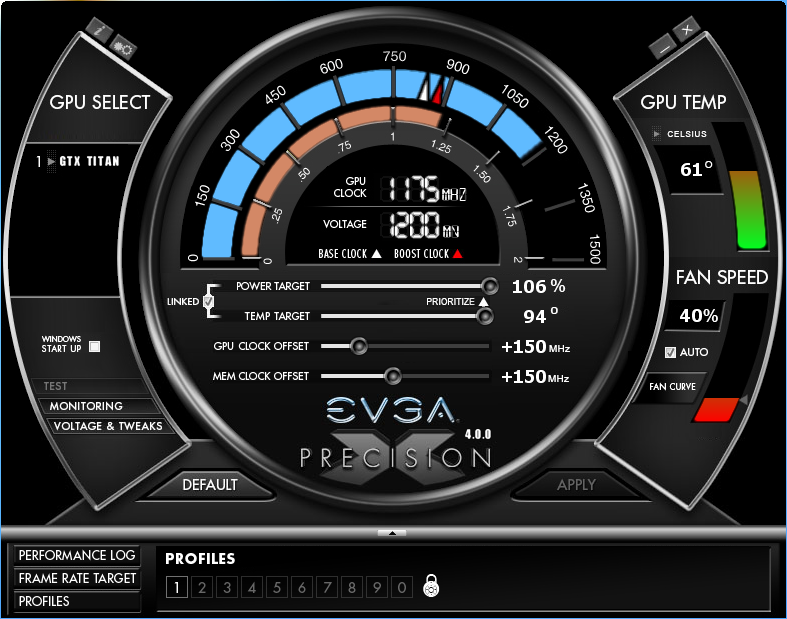

Overclocking:

Wie bei jeder Karte, die auf der Kepler-Architektur basiert, lässt sich der Takt von GPU/Shader und VRAM nicht mehr direkt absolut einstellen. Man arbeitet stattdessen über einen "Offset" zur Basistaktrate, welcher sowohl den Basistakt, als auch den Boost-Takt gleichermaßen anhebt.

Die Höhe des GPU Boostes wird vollständig durch die Hardware geregelt. Es halten aber Messwerte wie Temperatur und anliegende Last in der Ermittlung der Höhe mit Einzug. So schwankt die Taktrate der GPUs ein paar MHz während der Anwendung.

Aus dem HardwareLUXX Review

Wie frühere "Kepler"-Karten auch, spielt GPU-Boost 2.0 für das Overclocking der GeForce GTX Titan eine wichtige Rolle. Für die Overclocking-Tests haben wir folgende Voreinstellungen vorgenommen:

Power Target auf +106 Prozent, was auf Basis der 250 Watt TDP eine maximale Leistungsaufnahme von 265 Watt ergibt.

Temp Target auf 95 °C

Lüfterdrehzahl auf 85 Prozent

OverVoltaging auf 1,2 Volt

Letztendlich konnten wir einen stabilen Betrieb bei +150 MHz Takt-Offset für GPU und Speicher erreichen. Werte darüber waren mit unserem Sample nicht möglich und führten zum Absturz. Dies sind aber natürlich eine exemplarischen Werte für die GeForce GTX Titan, sondern eine von drei Karten. Aus Zeitgründen konnten wir aber nicht alle drei auf ihr OC-Potenzial hin überprüfen.

Synthetisch:

Games:

Das gewählte Offset mit einem Peak Boost von 1175 MHz auf der GPU und 1625 MHz GDDR5 steigert die Performance um durchschnittlich 10%.

Lastverbrauch im Vergleich - GTX Titan:

Temperatur im Vergleich - GTX Titan:

Lautstärke im Vergleich - GTX Titan:

Wie man sieht, fordern die oberen OC-Settings ihren Tribut in allen Bereichen, angefangen vom Verbrauch, über die Last-Temperatur (wobei dies mit dem der neuen Target-Temperatur notwendig ist - zumindest unter Luft), als auch bei der Laustärke (85% = Maximaldrehzahl).

NVIDIA GeForce GTX Titan - Teil 2 (GPU Boost 2.0)

<iframe width="560" height="315" src="http://www.youtube.com/embed/hUPsFBmZr9A" frameborder="0" allowfullscreen></iframe>

Don war so freundlich, ein Video zu schneiden, in dem er genau auf das Verhalten von GPU-Boost 2.0 inkl. Temp-Target eingeht.

Auf Guru3D gibt es einen gesonderten Artikel -> GTX Titan Overclock Guide

Andere Kühllösungen

Erhältliche WaKü-Blocks für die GeForce GTX TITAN:

Aquacomputer kryographics GTX TITAN (89,90€ im Shop):

Aquacomputer kryographics GTX TITAN vernickelte Ausführung (98,98€ bei Aquatuning):

<iframe width="640" height="360" src="http://www.youtube.com/embed/v4oN0w6_H6U?feature=player_embedded" frameborder="0" allowfullscreen></iframe>

EK Water Blocks stellt EK FC TITAN vor (Preis je nach Version zwischen 89,95 - 99,95€ im EK-Shop)

EK kündigt lange Version des Fullcover-Blocks an (Aktiv gekühlter Teil ist identisch mit kompakter-Version! Preis geschätzt 120 - 125€):

EK Waterblocks EK-FC Titan Backplate - Black (25,94€ im EK-Shop)

Watercool HEATKILLER GPU-X³ GTX TITAN (89,95 - 94,95€ im Watercool-Shop)

HEATKILLER GPU Backplate GTX TITAN (27,95€ im Watercool-Shop)

Koolance VID-NXTTN Water Block (inkl. Aluminium-Backplate - 129,99$ exkl. Versand im Koolance-Shop, Mengenrabatt möglich)

Daneben listet EVGA auch die GeForce GTX TITAN HydroCopper-Serie mit einem Block von Swiftech, gibt aber weder Preise noch Datum an:

E: Update: Taktraten -> 928 MHz Baseclock, 980 MHz Boostclock, vermutlich knapp 1,1 GHz Estimated Max. Boost, 1502 MHz GDDR5.

Allgemeine Hinweise

Dies ist ein Sammelthread für die GeForce GTX TITAN. Das heißt, es darf und soll hier über die Karte diskutiert werden und den Usern auch als Kaufberatung dienen.

Natürlich ist ein Vergleich, etwa in Sachen Leistung, zu anderen Karten (GTX 6x0 und Radeon HD 7xx0 uvm.) angemessen.

Um das Geflame, Gespamme oder sonstige Unannehmlichkeiten zu minimieren wird gebeten, im Falle eines Verstoßes gegen die Forenregeln den „Beitrag-melden“ - Button (

Solche oder nicht themenbezogene Beiträge werden dann entfernt. Ggfls. können mehrmalig auffällige User auch aus dem Thread ausgeschlossen werden.

Gruß

Die Moderation des Grafikkarten-Unterforums

Zuletzt bearbeitet:

- werde downsampling bei crysis 3 gar nit erst probieren, wäre irgendwie ein doofes gefühl, wenn man eine Titan im Rechner hat und das Spiel läuft nicht flüssig *;D - sieht auch in full hd besser aus, als alles was ich an spielen bisher je gesehen habe, also für mich kein grund da noch mehr rausholen zu wollen *;D - downsampling werde ich aber bei metro 2033 mal wagen *;D

- werde downsampling bei crysis 3 gar nit erst probieren, wäre irgendwie ein doofes gefühl, wenn man eine Titan im Rechner hat und das Spiel läuft nicht flüssig *;D - sieht auch in full hd besser aus, als alles was ich an spielen bisher je gesehen habe, also für mich kein grund da noch mehr rausholen zu wollen *;D - downsampling werde ich aber bei metro 2033 mal wagen *;D