NVIDIA GeForce RTX 3090 / 3090 TI (In Progress)

[Official] NVIDIA RTX 3090 Ti Owner's Club

NEWS

EK to launch water blocks for GeForce RTX 3090 Ti Founders Edition and popular custom models - VideoCardz.com

CAN RTX 3090 TI GET EVEN COOLER? YES – WITH EK WATER BLOCKS EK®, the leading computer liquid cooling solutions provider, is working on a plethora of new Quantum Vector² water blocks for NVIDIA® GeForce™ RTX 3090 Ti Series graphics cards. RTX 3090 GPUs are one of the most wanted cards on the...

Mehr Leistung(saufnahme) geht aktuell kaum: Inno3D GeForce RTX 3090 Ti im Test - Hardwareluxx

Mehr (Leistung) geht nicht: Inno3D GeForce RTX 3090 Ti im Test.

Schnell und mit Komplettausstattung: ASUS ROG Strix GeForce RTX 3090 OC im Test - Hardwareluxx

ASUS ROG Strix GeForce RTX 3090 OC im Test.

NVIDIA: Nachfrage nach GeForce-Karten noch bis 2021 höher als das Angebot - Hardwareluxx

NVIDIA: Nachfrage nach GeForce-Karten noch bis 2021 höher als das Angebot

Lasst das Flashen beginnen: NVFlash für Ampere-Karten verfügbar - Hardwareluxx

Lasst das Flashen beginnen: NVFlash für Ampere-Karten verfügbar.

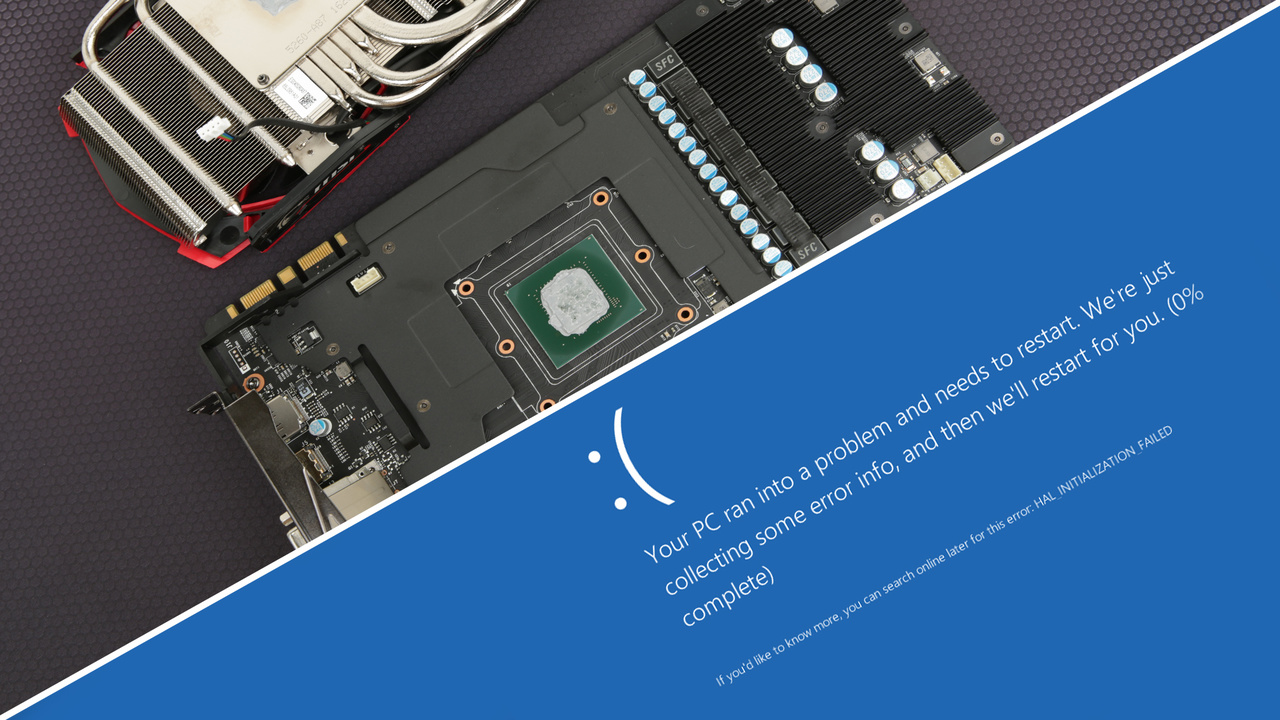

Manufacturers respond to GeForce RTX 3080/3090 crash to desktop issues - VideoCardz.com

NVIDIA GeForce RTX 3080/3090 graphics cards face Crash To Desktop (CTD) problems The ongoing problems with GeForce RTX 30 series launch are reaching new grounds. From a very limited stock, sponsored videos ahead of independent reviews to actual hardware issues with the very few cards that were...

EVGA GeForce RTX 3090: Vince „K|NGP|N“ Lucido stellt Weltrekord in 3DMark auf

Mit mehr als 16.000 Punkten im 3DMark „Port Royal“ und fast 2,6 GHz GPU-Takt, erzielte Vince „K|NGP|N“ Lucido einen neuen Weltrekord.

BIOS

Anleitung

1. Als erstes eigenes Original BIOS speichern per GPU-Z als Backup

2. Command Prompt starten per Adminstrator indem man "CMD" eingibt in der Windows Suchleiste

3. Richtigen Pfad angeben zum NVFlash Ordner mit cd: c/.....

4. Dann den Schutz deaktivieren mit "nvflash --protectoff" oder "nvflash64 --protectoff"

5. Dann die Custom ROM (BIOS) angeben mit "nvflash ROM_NAME.rom" oder "nvflash64 ROM_NAME.rom"

6. Falls es nicht funktioniert, da es zum ID-Mismatch kommt, muss man den Schutz gegen ein fremdes Bios deaktivieren mit "nvflash -6 ROM_NAME.rom" oder "nvflash64 -6 ROM_NAME.rom"

7. Enter drücken

8. 2x Y drücken zum bestätigen

9. Screen flackert und die Message sollte kommen, dass alles funktioniert hat

10. PC neu starten

11. Nach dem Neustart warten bis die Grafikkarte wieder erkannt wieder. Kann 1-2 Minuten dauern

Flashen auf eigene Gefahr. Ich übernehme keine Haftung dafür.

OVERCLOCKING | TOOLS

Kurze Info wegen Stromverbrauch: 3090 Trio auf Anschlag + 9900K mit 1,36v und 5,4 GHZ = 665W für das gesamte System bei mir (SH). Dies kann natürlich bei euch abweichen. Eine Strix kann 100W mehr ziehen. Daher würde ich jedem, der OC betreibt +850W Netzteile empfehlen

Undervolting PT Usage Tests mit meiner 3090 FTW3Kurze Info wegen Stromverbrauch: 3090 Trio auf Anschlag + 9900K mit 1,36v und 5,4 GHZ = 665W für das gesamte System bei mir (SH). Dies kann natürlich bei euch abweichen. Eine Strix kann 100W mehr ziehen. Daher würde ich jedem, der OC betreibt +850W Netzteile empfehlen

800mv = 320 Watts

850mv = 370 Watts

900mv = 430 Watts

912mv = 450 Watts

918mv = PT Limit für FTW3 mit 450

UNDERVOLTING

800mv = 320 Watts

850mv = 370 Watts

900mv = 430 Watts

912mv = 450 Watts

918mv = PT Limit für FTW3 mit 450W

| |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

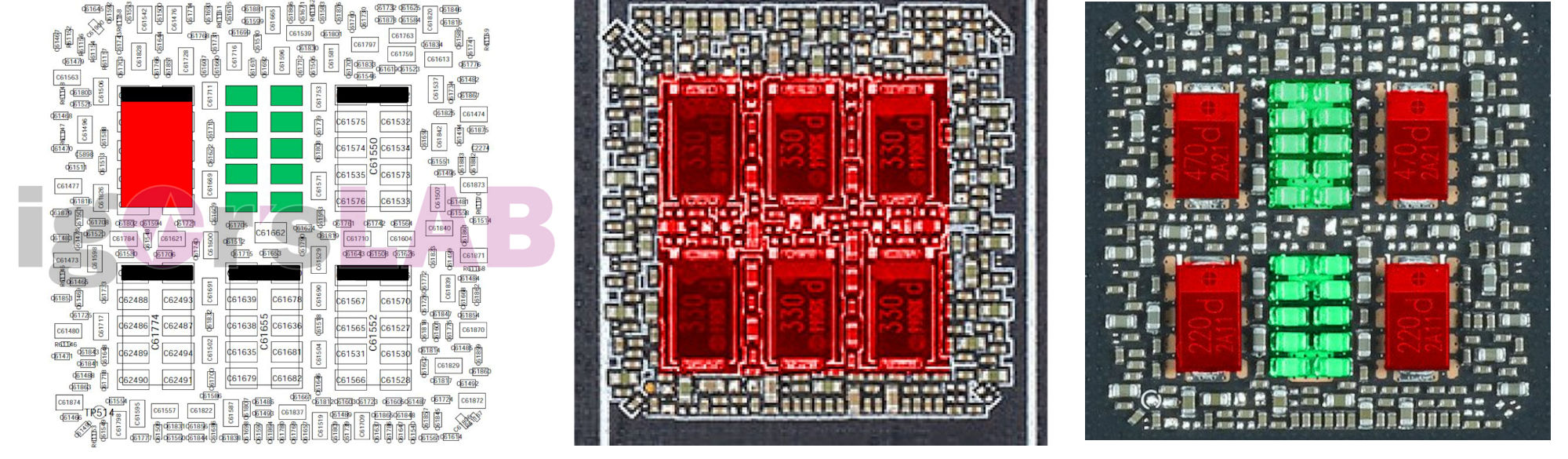

Quelle: https://www.reddit.com/r/nvidia/comments/izhpvs/the_possible_reason_for_crashes_and_instabilities/

3090 TI Power Limit Übersicht

| |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

KÜHLERTAUSCH | GARANTIE

| Hersteller | Kühlerwechsel | Overclocking | Overvolting | VBIOS flashen |

|---|---|---|---|---|

| ASRock | Kulanz5 | ✓ | – | – |

| Asus | ✓ | ✓1 | ✓1 | – |

| EVGA | ✓ | ✓ | ✓ | ✓2 |

| Gainward | – | ✓ | ✓3 | – |

| Gigabyte | ✓ | ✓ | ✓ | – |

| KFA² | ✓ | ✓ | ✓ | – |

| MSI | ✓ | ✓ | ✓ | – |

| Nvidia | – | ✓ | ✓ | – |

| Palit | – | ✓ | ✓4 | – |

| PowerColor | – | ✓ | ✓ | – |

| Sapphire | Kulanz5 | ✓ | ✓ | – |

| XFX | – | ✓ | ✓ | – |

| Zotac | ✓ (nur die ersten zwei Jahre) | ✓ | ✓ | – |

Quelle: Computerbase

Grafikkarten: Garantiebedingungen von Abwicklung bis Kühlerwechsel

Die Herstellergarantie bei Grafikkarten umfasst viele Aspekte: Dauer, Abwicklung, Kühlerwechsel und Übertaktung. ComputerBase gibt einen Überblick.

MSI:

"Sie können bei Grafikkarten die Wärmeleitpaste oder Kühler Tauschen. Dieser muss jedoch die gleiche oder eine besser Leistung besitzen.

Sofern beim Umbau nichts beschädigt wird, bleibt die Garantie der Karte erhalten.

Sollte jedoch ein Fehler an der Karte auftreten, müssten Sie für eine Garantieabwicklung über den Händler den Original Zustand der Karte wieder herstellen.

Dies gilt für alle MSI Grafikkarten welche in Deutschland und Österreich von MSI Deutschland vertrieben wurden."

ZOTAC:

"die normalen zwei Jahre bleiben erhalten, ein Erweiterung der Garantie

ist dann ungültig. Die Karte muss wenn etwas im im Originalzustand

eingereicht werden."

Gainward und Palit

"Leider müssen wir Sie auch mitteilen, wenn Sie den originale Kühlkörper umbauen, werden Sie dadurch Ihre Ansprüche auf Garantie dieser Karte verlieren. Das gilt nicht nur für Gainward Produkt , sondern auch für Palit"

Aktuelle Referenzkarten

Zotac:

| Zotac GAMING GeForce RTX 3080 Trinity | ZT-A30800D-10P |

| Zotac GAMING GeForce RTX 3080 TrinityZotac GAMING GeForce RTX 3090 Trinity | ZT-A30900D-10P |

| Galax GeForce RTX 3080 SG | 38NWM3MD99NN |

| Galax GeForce RTX 3090 SG | 38NWM3MD99NK |

| KFA2 GeForce RTX 3080 SG | 39NSM5MD1GNA |

| KFA2 GeForce RTX 3090 SG | 39NSM5MD1GNK |

| Gainward RTX 3080 Phoenix | 471056224-1952 |

| Gainward RTX 3080 Phoenix GS | 471056224-2010 |

| Gainward RTX 3090 Phoenix | 471056224-1976 |

| Gainward RTX 3090 Phoenix GS | 471056224-2034 |

| Palit GeForce RTX 3080 Gaming Pro | NED30800S19IA-132AA |

| Palit GeForce RTX 3080 Gaming Pro OC | NED3080S19IA-132AA |

| Palit GeForce RTX 3090 Gaming Pro | NED30900S19SB-132BA |

| Palit GeForce RTX 3090 Gaming Pro OC | NED3090S19SB-132BA |

| PNY GeForce RTX 3080 XLR8 Gaming EPIC-X | VCG308010TFXMPB |

| PNY GeForce RTX 3090 XLR8 Gaming EPIC-X | VCG309024TFXPPB |

| Inno3D GeForce RTX 3080 iChill X3 | C30803-106XX-1810VA37 |

| Inno3D GeForce RTX 3080 iChill X4 | C30804-106XX-1810VA36 |

| Inno3D GeForce RTX 3080 Twin X2 OC | N30802-106XX-1810VA34 |

| Inno3D GeForce RTX 3090 iChill X3 | C30903-246XX-1880VA37 |

| Inno3D GeForce RTX 3090 iChill X4 | C30904-246XX-1880VA36 |

| Inno3D GeForce RTX 3090 Gaming X3 | N30903-246X-1880VA37N |

RTX 3000 Wasserkühler: Stand der Dinge (Update 1.1.22)

Aktuellen Informationen und Übersicht zu Wasserkühlern / Wasserblöcken für die nVidia RTX 3000 (RTX 3090, 3080 (Ti) und 3070) und Custom-Designs.

Mehr Informationen gibt es hier: https://www.overclock.net/threads/official-nvidia-rtx-3090-owners-club.1753930/

Zuletzt bearbeitet:

Außerdem hat er sämtliche seiner Posts gelöscht hier im Thread.

Außerdem hat er sämtliche seiner Posts gelöscht hier im Thread.

🙌👍

🙌👍