SFVogt

Urgestein

- Mitglied seit

- 27.01.2005

- Beiträge

- 5.645

- Details zu meinem Desktop

- Prozessor

- Intel Core i9 12900K delided

- Mainboard

- Gigabyte Z690M AORUS Elite AX DDR4

- Kühler

- Heatkiller 4 Basic Acetal direct-DIE

- Speicher

- 2x16GB G.Skill F4-3600C14D-32GVK

- Display

- 65" 8K LG 65QNED999PB

- SSD

- 2TB M.2 Samsung 980 Pro

- Gehäuse

- Jonsbo RM3 black

- Netzteil

- 850W BeQuiet Dark Power Pro 11

- Keyboard

- Roccat Sova

- Mouse

- Roccat Kone Pure Ultra

- Betriebssystem

- Win10 64Bit

- Sonstiges

- Logitech Z906 5.1

- Internet

- ▼1.000Mit/s ▲50 MBit

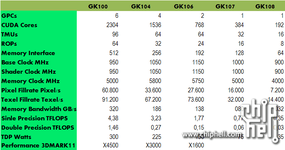

Leider kann ich kein Bild einer nackten Quadro 6000 finden. Aber Anhand der zwei folgenden Bilder einer Quadro 5000 von hothardware ist es scheinbar kein Problem die doppelte Anzahl an Speicherchips mit nem GF100 zu verbinden. Dann wären das im Falle einer Quadro 6000 stolze 24 2Gb(it) Chips um auf die 6GB(yte) Bestückung zu kommen. Wenn da mal nicht Platzprobleme auftreten bei ner Kepler Quadro mit 32 2Gbit Chips @ 512Bit SI für 8GB Speicher

Zuletzt bearbeitet:

Aber ich glaube nichmehr dran, denn die heutigen Chips sind vielzu komplex.. Ich denke unsere GTX680 mit 30% Mehr als 7970 ist da doch realistischer

Aber ich glaube nichmehr dran, denn die heutigen Chips sind vielzu komplex.. Ich denke unsere GTX680 mit 30% Mehr als 7970 ist da doch realistischer