freeman303

Enthusiast

OK, angenommen ich bekomme die Intel SSD 750 auf dem besagten Supermicro Board zum booten. Entsprechende Anfrage und ggf. sogar die Lösung wird von Supermicro angedacht. Bisher haben sie mir sogar neue BIOS-Versionen geliefert. Hoffe das mit der UEFI NVMe Unterstützung klappt für's booten. Gehen wir mal davon aus, dass es so wäre.

Wie oben beschrieben, hat das Board dank den vier integrierten LAN-Ports und dem ingegrierten SATA-RAID-Contorller mit zahlreichen Anschlüssen einige PCIe Lanes schon selbst in Verwendung, so dass nicht viele Lanes für die PCIe-Slots übrig blieben. Leider!!!

Das Supermicro hat die folgenden beiden Slots:

1x PCIe 3.0 x16

1x PCIe 3.0 x2 in einem x8-Slot

Ich hätte dann darin einzubauen:

1x LSI 9271-8i RAID-Controller an dem erst Mal 6xSeagate Enterprixe NAS 4TB HDDs im RAID-6 Modus hängen würden

1x Intel SSD 750 400GB

Vielleicht sollte ich die Intel SSD 750 in den PCIe 3.0 x16 Slot stecken, um die volle Leistung des Laufwerks zu haben.

Vielleicht sollte ich den LSI 9271-8i RAID-Controller in den PCIe 2.0 x2 Slot stecken. Vermutlich wird er dort funktionieren, obwohl der LSI Controller für 3.0 x8 Lanes ausgelegt ist. Das ist aber ja Abwärtskompatibel.

Der Rechnung hier aus dem Forum, sollten die 2 PCIe-Lanes in 2.0 Version ca. 800 MB/s an Daten liefern. Die Frage ist: Schaffen 6-8 HDDs von Seagate mit 7.200 RPM überhaupt dauerhaft im RAID-6 Modus Daten miit 800 MB/s zu schreiben oder zu lesen? Im Zusammenhang mit dem Cache, ja ganz sicher. Aber ohne Cache? Erfahrungsgemäß habe ich auch am Areca 1882ix-24er Modell keine solche Datenraten dauerhaft, ausser es kommt der Cache ins Spiel.

Was denkt ihr, wäre das eine denkbare Konfiguration, um möglichst wenig leistung der schnellen Intel SSD und des Daten RAID-6 zu vergeuden?

Bzw. würde man da den LSI durch die 2 Lanes in 2.0 Version des PCI-Steckplatzes überhaupt so drastisch beschneiden, dass man das merken würde? Ich würde erfahrungsgemäß eher zu einem vorsichtigen Nein tendieren.

Aber ich denke, die Erfahrung einiger User hier im Forum ist bei weitem höher als meine. Daher die Frage hier.

So muss nun schlafen. Freue mich schon auf Eure Antworten von morgen. Vielleicht haben wir damit ja die Lösung für das Problem gefunden?

Board, Xeon und 32 RAM würde ich ungern jetzt komplett auf neueste Generation umbauen, nur um die Intel SSD 750 einsetzen zu können. Ich wollte erst auf den nächsten oder übernächsten Xeon in der nachsten oder übernächsten Strukturbreite warten, so dass ich dann auch ordentlich DDR4 Ram zum akzeptablen Preis dazuordern kann. Dann gleich 64 bis 128 GB.

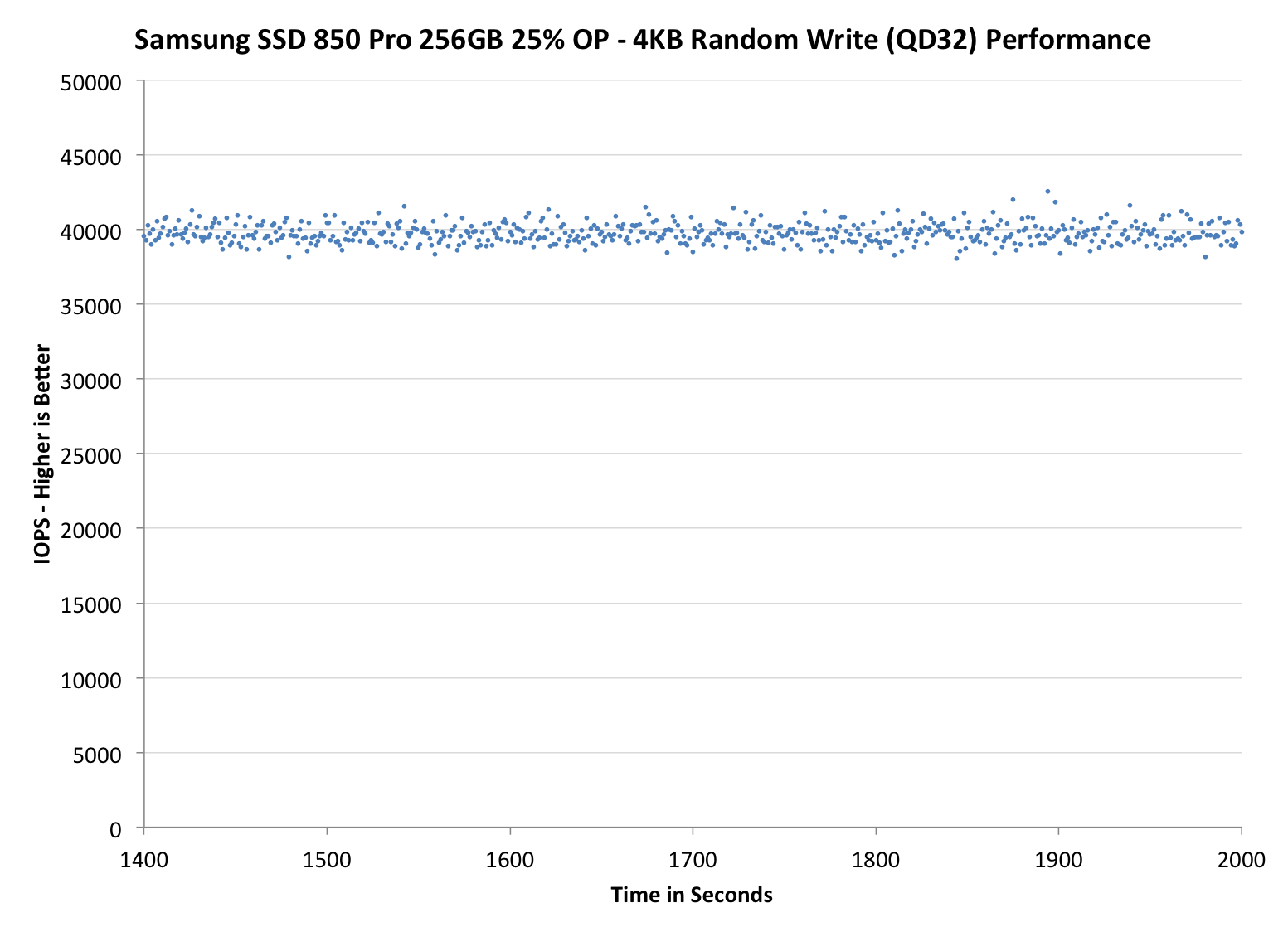

Andererseits hätte ich noch die Möglichkeit statt der Intel 750 im PCIe-Slot, zwei Samsung 850 Pro (oder Server-Schwesternmodelle) mit 512 GB im RAID-1 am Intel Mainboardcontroller zu betreiben. So einen megamäßigen Leistungsbruch bei den IOPs solle es auch da nicht geben.

Zumindest wenn man diesem Blog glaubt und den Messungen, die da veröffentlicht sind.

Aber ich wil Euch nicht auf die Folter spannen. Hier der kurze und knackige Vergleich der Super-Schnellen-SSDs von heute. Link: Some Quick Comparative CrystalDiskMark Results | Glenn Berry

Grüße

Freeman

Wie oben beschrieben, hat das Board dank den vier integrierten LAN-Ports und dem ingegrierten SATA-RAID-Contorller mit zahlreichen Anschlüssen einige PCIe Lanes schon selbst in Verwendung, so dass nicht viele Lanes für die PCIe-Slots übrig blieben. Leider!!!

Das Supermicro hat die folgenden beiden Slots:

1x PCIe 3.0 x16

1x PCIe 3.0 x2 in einem x8-Slot

Ich hätte dann darin einzubauen:

1x LSI 9271-8i RAID-Controller an dem erst Mal 6xSeagate Enterprixe NAS 4TB HDDs im RAID-6 Modus hängen würden

1x Intel SSD 750 400GB

Vielleicht sollte ich die Intel SSD 750 in den PCIe 3.0 x16 Slot stecken, um die volle Leistung des Laufwerks zu haben.

Vielleicht sollte ich den LSI 9271-8i RAID-Controller in den PCIe 2.0 x2 Slot stecken. Vermutlich wird er dort funktionieren, obwohl der LSI Controller für 3.0 x8 Lanes ausgelegt ist. Das ist aber ja Abwärtskompatibel.

Der Rechnung hier aus dem Forum, sollten die 2 PCIe-Lanes in 2.0 Version ca. 800 MB/s an Daten liefern. Die Frage ist: Schaffen 6-8 HDDs von Seagate mit 7.200 RPM überhaupt dauerhaft im RAID-6 Modus Daten miit 800 MB/s zu schreiben oder zu lesen? Im Zusammenhang mit dem Cache, ja ganz sicher. Aber ohne Cache? Erfahrungsgemäß habe ich auch am Areca 1882ix-24er Modell keine solche Datenraten dauerhaft, ausser es kommt der Cache ins Spiel.

Was denkt ihr, wäre das eine denkbare Konfiguration, um möglichst wenig leistung der schnellen Intel SSD und des Daten RAID-6 zu vergeuden?

Bzw. würde man da den LSI durch die 2 Lanes in 2.0 Version des PCI-Steckplatzes überhaupt so drastisch beschneiden, dass man das merken würde? Ich würde erfahrungsgemäß eher zu einem vorsichtigen Nein tendieren.

Aber ich denke, die Erfahrung einiger User hier im Forum ist bei weitem höher als meine. Daher die Frage hier.

So muss nun schlafen. Freue mich schon auf Eure Antworten von morgen. Vielleicht haben wir damit ja die Lösung für das Problem gefunden?

Board, Xeon und 32 RAM würde ich ungern jetzt komplett auf neueste Generation umbauen, nur um die Intel SSD 750 einsetzen zu können. Ich wollte erst auf den nächsten oder übernächsten Xeon in der nachsten oder übernächsten Strukturbreite warten, so dass ich dann auch ordentlich DDR4 Ram zum akzeptablen Preis dazuordern kann. Dann gleich 64 bis 128 GB.

Andererseits hätte ich noch die Möglichkeit statt der Intel 750 im PCIe-Slot, zwei Samsung 850 Pro (oder Server-Schwesternmodelle) mit 512 GB im RAID-1 am Intel Mainboardcontroller zu betreiben. So einen megamäßigen Leistungsbruch bei den IOPs solle es auch da nicht geben.

Zumindest wenn man diesem Blog glaubt und den Messungen, die da veröffentlicht sind.

Aber ich wil Euch nicht auf die Folter spannen. Hier der kurze und knackige Vergleich der Super-Schnellen-SSDs von heute. Link: Some Quick Comparative CrystalDiskMark Results | Glenn Berry

Grüße

Freeman

Zuletzt bearbeitet: