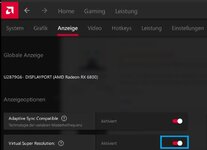

Womit wir dann insgesamt so vier bis sechs verschiedene GPU-Takte hätten:

- eingestellter Minmal- und Maximaltakt im Wattman

- anliegender Takt unter Last

- "effektiver" Takt laut HWiNFO (was immer das nun sein soll)

- Core-Takt und Durchschnittstakt während eines Laufs laut 3DMark

Nein, es gibt eigentlich nur 2. Den GPU-Takt und den Effektiven-GPU-Takt, ich nenne es im Nvidia-Style Videoclock. Genauso wie bei der CPU effektiver Takt..

Zu1 und 2: Der Minimaltakt ist der Takt den die GPU nicht unterschreiten darf. Der Maximaltakt ist der Takt den die GPU nicht überschreiten darf. In diesem Fenster taktet die GPU je nach Last, Verbrauch, Temperatur, Powerlimit...

Zu3: Wie gesagt im Nvidiastyle ist der Videoclock, der Effektive Takt. Gab da mal ein paar Referenz-Karten, die mit leicht weniger GPU-Takt, schneller waren als so manche Customkarten mit leicht höherem GPU-Takt.

Der Grund, der effektive Takt war höher als der der Customkarten und somit hatte die GPU auch mehr Leistung... Auf dem Papier liese sich so wenn man wollen würde etwas tricksen... Will hier nichts unterstellen...

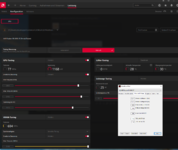

Zu4: Der Core-Takt ist dein GPU-Takt. Der Durchschnittstakt ist der den die GPU im Durchschnitt schafft bzw der der im Mittel genommen anliegt... Schätze der 3D Mark berechnet anhand dem niedrigsten und dem höchsten GPU-Takt daraus den Durchschnittswert den die Karte Insgesamt schaffte... Da der Takt durch Limitierungen wie Powerlimit, Temperaturlimit, Last usw nie gleich anliegt. Das ließe sich zum Beispiel außer Kraft setzen mit einem OC-Bios das anders programmiert wurde... Hier würde dann der GPU-Takt immer fest anliegen. Könnte man dann vergleichen mit Energiespareinstellungen auf Höchstleistung,,... Immer Vollgas...

Ich versuch es Anhand einem alten Bios von Nvidia. Es ist alles nicht ganz so einfach hinter den Kulissen.

Die Karte hat verschiedene Booststates/Boosttable bzw viele verschiedene Stufen. Je nach dem was ich der Karte sage, welche Last, Temperatur, Watt anliegt taktet die Karte mit dem was im Bios hinterlegt ist.

Glaub auch das dass zu viel werden würde wenn wir alles durchkauen... Durch Mods Beispiel XOC-Bios konnte man so einiges umgehen wie auch das Spannungslimit usw...

Ist jetzt nur mal ein Beispiel was man früher alles im Bios machen konnte wenn man wusste was man tat....

Vielleicht hilft das ein bisschen zu verstehen das es nicht ganz so einfach ist was die Karte gerade macht und warum sie das tut....

Mittlerweile geht ja so etwas nicht mehr für uns Ottonormalsterblichen... Bios auslesen, verstellen usw ist für uns Tabu...