Hallo,

ich werde zwei 4110 und dazupassende 128GB RAM kostenlos bekommen.

Aktuell habe ich eine Hardware-Firewall auf einem i3 (Sophos Home), und eine Synology NAS mit 8 HDDs.

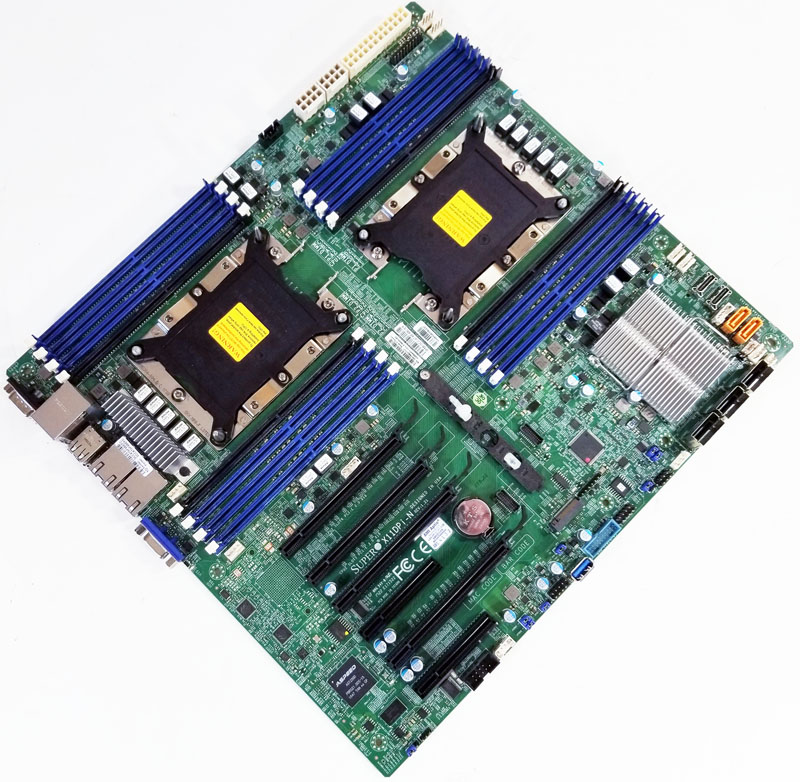

Daher überlege ich rundum einen Server zu bauen. Ein ASUS oder ähnliches Mainboard, gehen um so ca. €500, ein Fantec 19zoll Gehäuse (12 HDD), ein Netzteil, NVMe als Storage im RAID, Netzwerk-Karte mit 4 Ports.

Überlege alles zu virtualisieren. Firewall, NAS (FreeNAS), ggf. VMs für AD oder sonstige Spielereien.

Aber, ich mache mir Sorgen um den Stromverbrauch bei zwei Xeons. Schon mein i7 Skylake Rechner verbraucht im Vergleich zu der i3-Firewall und Synology wesentlich mehr.

Vorteil der Sache natürlich ist dass ich später auch von einem Server-Mainboard auf ein Consumer-Mainboard wechseln kann, denn die Xeons eigentlich so für Privatgebrauch zu teuer sind.

Hat jemand Erfahrung damit?

Danke

ich werde zwei 4110 und dazupassende 128GB RAM kostenlos bekommen.

Aktuell habe ich eine Hardware-Firewall auf einem i3 (Sophos Home), und eine Synology NAS mit 8 HDDs.

Daher überlege ich rundum einen Server zu bauen. Ein ASUS oder ähnliches Mainboard, gehen um so ca. €500, ein Fantec 19zoll Gehäuse (12 HDD), ein Netzteil, NVMe als Storage im RAID, Netzwerk-Karte mit 4 Ports.

Überlege alles zu virtualisieren. Firewall, NAS (FreeNAS), ggf. VMs für AD oder sonstige Spielereien.

Aber, ich mache mir Sorgen um den Stromverbrauch bei zwei Xeons. Schon mein i7 Skylake Rechner verbraucht im Vergleich zu der i3-Firewall und Synology wesentlich mehr.

Vorteil der Sache natürlich ist dass ich später auch von einem Server-Mainboard auf ein Consumer-Mainboard wechseln kann, denn die Xeons eigentlich so für Privatgebrauch zu teuer sind.

Hat jemand Erfahrung damit?

Danke