CDI zeigt diesen SMART-Wert korrekt an.

Mag sein, nur halt nicht dort wo der übliche 08/15 User zuerst hin schaut. Ist in

Post #260 (bei CDI) orange markiert.

______________________________________

- einer Anwendung, die über den kompletten Testzeitraum schreibt.

Daher habe ich ja, siehe

Post #260, den 550GB Schreibtransfer auf die Samsung 980 gemacht der ja bekanntermaßen dann nur "den kompletten Testzeitraum" schreiben dürfte. Richtig?

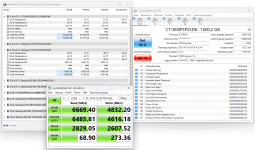

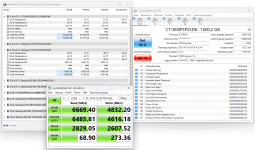

Resultat und da zitiere ich mich mal aus Post #260 selbst:

Zum Ende des Kopiervorgangs hatte die 2te Samsung 980 (Disk 2) laut HWInfo einen Drive Temperature 3 Wert von 69°, CDI hat nur 51° angezeigt (Temperature (0) bzw. Temperature 2). Da werden, vertraut man CDI, mal ebend satte 18° tatsächliche Schreiblasttemperatur unterschlagen.

______________________________________

Dann sind deine Exemplare nicht für den Durchschnitt an NVME-SSD repräsentativ.

..und Holzis Samsung SSD dann wohl auch? Bin mal gespannt welche SSDs noch (sollte man mal einen Sammler aufmachen).

______________________________________

Samsung, Intel, SK Hynix und WD teilen bei neueren Modellen zumeist nicht genau zwei Temperaturen mit, haben aber zusammen ca. 60% Anteil am SSD-Markt.

Dann sind da halt bis zu 60% "neuerer" SSDs am Markt unterwegs die einen Temperaturbug, ähnlich der Fanxiang S770, haben. Denn die S770 hat ja im Grunde

zu keiner Zeit eine falsche Temperatur -unter Last- ausgegeben, wurde halt nur "mal wieder" von CDI falsch wieder gegeben. So wie bei der Samsung. Kannst du alles, ab Seite 4, anhand zahlreicher Screens selbst nachprüfen.

Nur weil da Samsung, WD usw. drauf steht, sind die nicht automatisch bugfree.

______________________________________

Dass du gerne den höchsten der Temperaturwerte in CDI sähest, ist klar.

Ja natürlich! Was ist daran falsch? Genau das ist ja DIE Temperatur, die ja hier im Thread zu der S770 immer als -> "schau mal da, die Chinamänners unterschlagen wieder was" dieser immer als Temperaturbug angekreidet wurde und worauf sich meine zahlreichen Supportanfragen (kannst du ebenfalls hier nachlesen) an den Fanxiang Support richteten. Bei der Samsung darf und soll nun der im Grunde identische Auslesefehler als galanter "naja, Samsung darf das, ist halt Samsung" unter den Teppich Kehrer akzeptiert werden? Auch eine Logik.

______________________________________

Da es weder eine verbindliche technische Regel dafür noch besondere Mängel am Temperaturmanagement bei Samsung-SSD gibt,

Soll mir nun was genau sagen? Das jeder Hersteller da machen und pfuschen darf wie er möchte oder was genau möchtest du nun damit aussagen?

______________________________________

ist aber auch klar, dass kein Problem vorliegt und eine entsprechende Einzelanfrage beim Support rechts unten in der Eisenhower-Matrix landet.

Zeigt mir als Kunden nur, dass deren Support nichts taugt, was zu verschweigen hat oder einfach nur sehr "abgehoben" ist. Habe ich aber keine Probleme mit, da ich ja weiß wo ich die tatsächlichen Temperaturen sehe.

..andere Teilnehmer in diesen Thread scheinbar schon, die stufen aber dann auch CDI als ultima Ratio zur Temperaturanzeige ein (was mich persönlich dann aber auch weniger belastet).

edit: Ich mache es dir jetzt mal ganz einfach und stelle dir nur eine Frage. Bei welchen dieser vier folgenden Screens erkennst du einen sogenannten Temperaturauslesefehler und wo nicht? Vieleicht noch mit einer kurzen Begründung warum und wieso, wenn es nicht zu viel Arbeit macht. (von links nach rechts -> 1 bis 4):