Werbung

Anfang April stellte Intel die dritte Generation der Xeon-Scalable-Prozessoren vor. Diese basieren auf dem Ice-Lake-SP-Design, bieten bis zu 40 der Sunny-Cove-Kerne und sind zudem mit 64 PCI-Express-4.0-Lanes und einem schnelleren Octa-Channel-Speicherinterface ausgestattet. Wir haben die Leistung zweier Xeon Platinum 8380, also den Spitzenmodellen mit 40 Kernen, im Vergleich zu den beiden Vorgänger-Generationen mit jeweils 28 Kernen auf den Prüfstand gestellt.

Direkt daneben steht im Büro ein EPYC-Server der 7003-Serie, sodass wir nach diesem Test auch mit Vergleichswerten von AMD aufwarten können. Dies wird allerdings noch einige Tage dauern, da ein Server-Testing nicht ganz so trivial ist und viel Zeit in Anspruch nimmt.

In Ice Lake-SP lassen sich die Probleme, die Intel mit der Fertigung in 10 nm hatte und noch immer hat, denn die dritte Xeon-Scalable-Generation kommt reichlich spät, wohl am besten aufzeigen. Intel nutzt diese Generation für einen Plattformwechsel und eine teilweise Neuausrichtung, denn schon Ende 2021 soll es mit Saphire Rapids die nächste Generation geben.

Ice Lake und Sunny Cove

Die Ice-Lake-Generation sollte ein plattformübergreifender Wechsel sein. Notebook, Desktop und Server sollten bereits 2017 auf die neue Architektur wechseln. Doch Intel hatte große Probleme mit der Einführung der Fertigung in 10 nm und komplett überwunden sind diese noch immer nicht. Die Auswirkungen für Intel als Integrated Device Manufacturer (IDM), der die Entwicklung der Chips und die Fertigung unter einem Dach ausführt, sind enorm. Allerdings sieht Intel im IDM-Konzept nun wieder Chancen und richtet den Konzern mit IDM 2.0 in dieser Hinsicht neu aus. Bis 2023/24 will Intel wieder eine Vorreiterrolle einnehmen. Mit der Fertigung in 7 nm will man wieder auf Augenhöhe mit den anderen Halbleiterherstellern sein und die mehrjährigen Probleme, die sich kaum besser als in den Rocket-Lake-Prozessoren ausdrücken lassen, überwunden haben.

Aber auch wenn es Ice Lake-H für Notebooks mit mehr als vier Kernen oder Ice Lake-S für den Desktop nie gegeben hat, so hielt Intel dennoch an den Plänen zu Xeon-Prozessoren auf Basis von Ice Lake fest. Bereits im vierten Quartal 2020 hat man die ersten Prozessoren an Kunden ausgeliefert, inzwischen sollen es bereits 200.000 Stück sein.

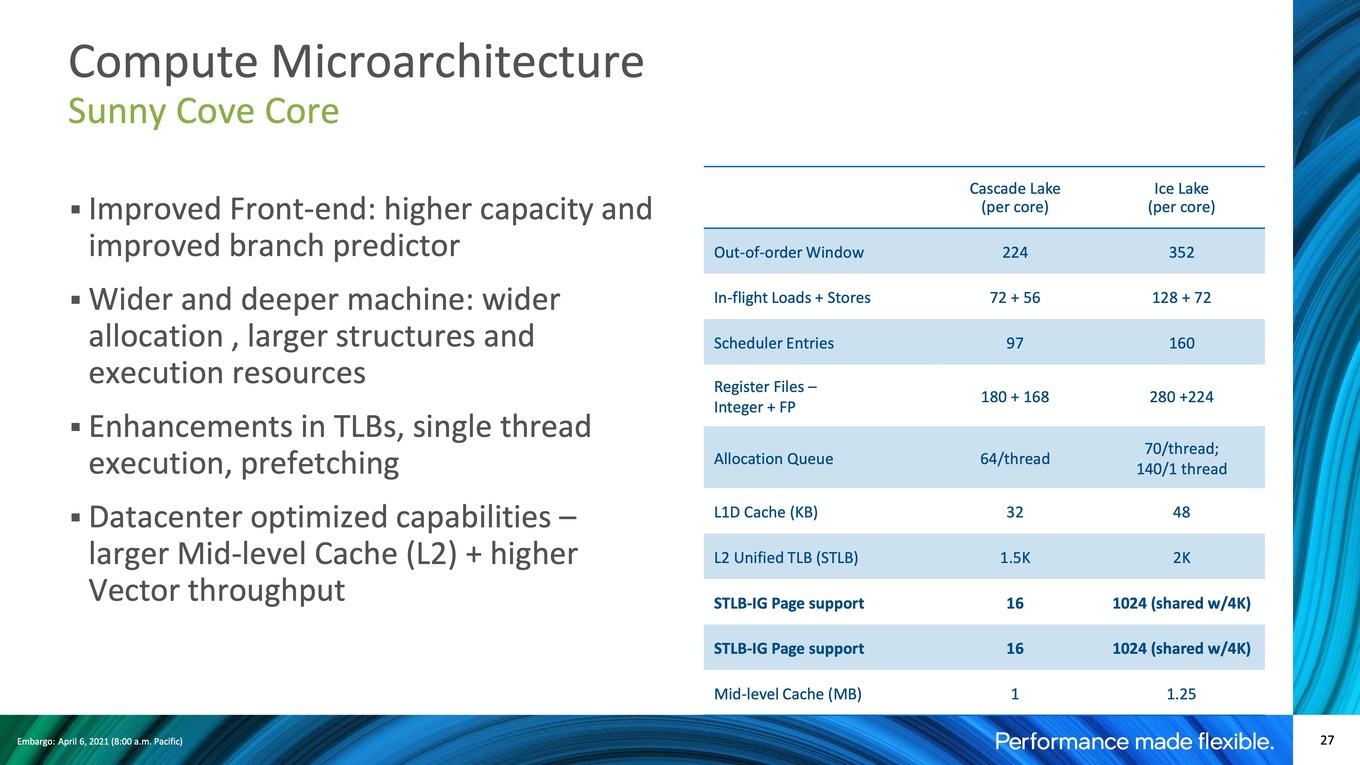

Die Sunny-Cove-Architektur bedeutet für Intel den ersten Wechsel in den grundlegenden Strukturen einer CPU-Architektur seit Skylake aus dem Jahre 2015. Sechs Jahre hat Intel nun also kleinere Verbesserungen in Skylake einfließen lassen und bei aller Kritik daran hat Intel es dennoch geschafft, die Leistung im Vergleich zur ersten Generation der Prozessoren auf Basis der Skylake-Architektur bis zu den bis vor wenigen Wochen aktuellen Comet-Lake-Refresh-Prozessoren deutlich zu steigern. Dies hängt außerdem mit den Verbesserungen der Fertigungstechnologien zusammen, denn auch wenn es Skylake auf 10 nm nur im homöopathischen Dosen in Form von Canon Lake gegeben hat, so sind die Optimierungen durch 14nm+, 14nm++ und 14nm+++ signifikant. Rocket Lake-S erreicht 5,3 GHz auf einzelnen Kernen, bis zu 5,1 GHz sind es auf allen acht Kernen.

Doch Sunny Cove bringt nun den Wechsel auf eine völlig neue Mikroarchitektur, die allerdings nun auch schon zwei Jahre alt ist. Intel nimmt ein paar Anpassungen vor, die für die Xeon-Version spezifisch sind.

Intel führt mit Sunny Cove eine 5-Wide-Out-of-Order-Architektur-Pipeline ein. Hier gibt es nun vier Unified Reservation Station (RS), was es Intel ermöglicht, die Instruktionen paralleler einfließen zu lassen, als bei Skylake. Womöglich um den Spectre-Mitigierungen entgegen zu wirken, hat Intel der AGU (Address Generation Unit) vier feste Ports zugewiesen. Jeweils zwei AGUs wird eine Load/Store-Unit. Für VEC- und INT-Berechnungen gibt es nun weitere Recheneinheiten in den jeweiligen Ports. All diese Maßnahmen sollen zur Beschleunigung der Architektur beitragen.

Das Front-end bekommt eine höhere Kapazität und die Sprungvorhersagen sollen zudem optimiert worden sein. Die eigentlichen Recheneinheiten sind mit Ice Lake in zwei Dimensionen (Pipeline-Tiefe) und der Breite vergrößert worden, können damit mehr Befehle aufnehmen und weitere Befehlssätze ausführen.

Intel hat zu diesem Zweck die Buffer und Caches im Vergleich zu Cascade Lake vergrößert. Diese können mehr Einträge aufnehmen und die dazugehörigen Load/Store-Einheiten wurden in ihrer Anzahl deutlich erweitert. Eine Änderung für Ice Lake-SP gibt es im Vergleich zur bisherigen Consumer-Version: Der L2-Cache pro Kern wächst von 512 KB pro Kern auf 1,25 MB pro Kern an. Für Cascade Lake belief sich die Kapazität noch auf 1 MB pro Kern.

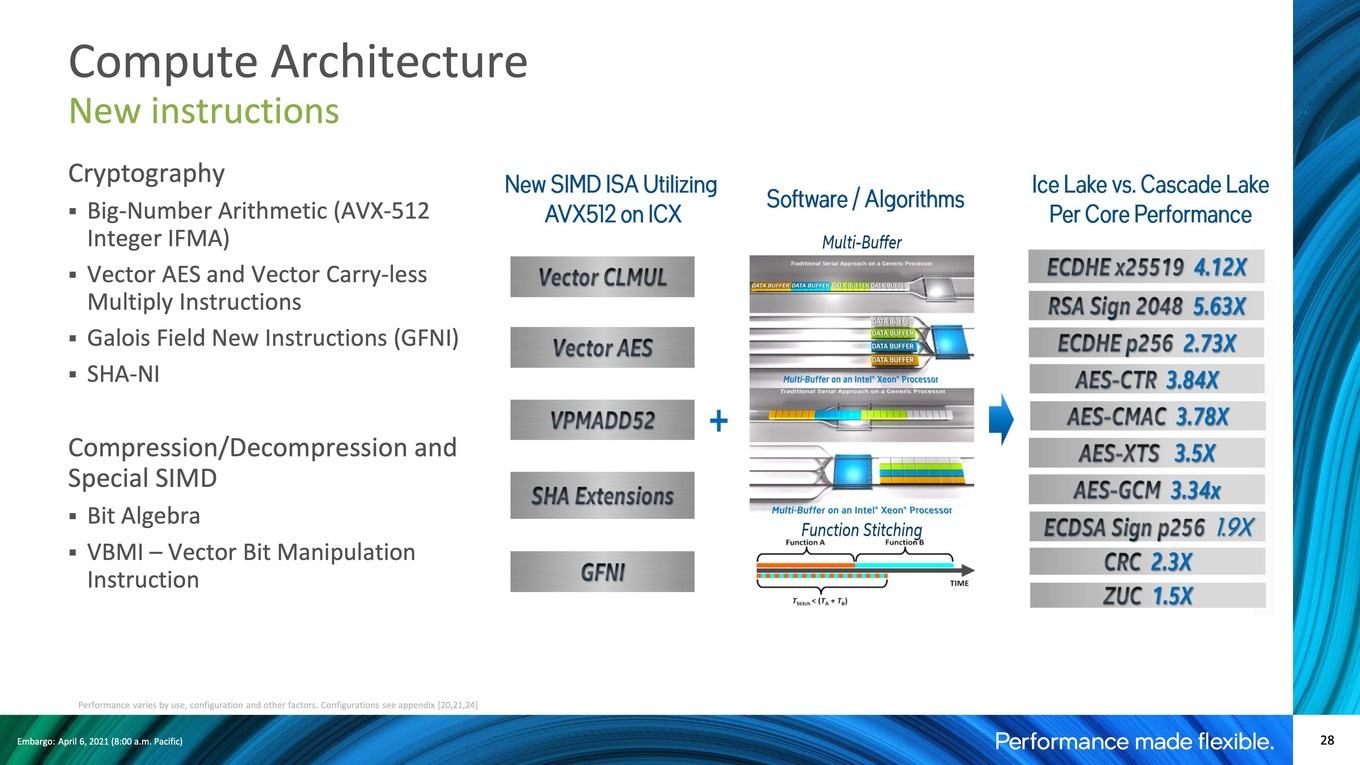

Weiterhin wird Sunny Cove neue ISA-Befehlssätze unterstützen. Dazu gehören Vector-AES, verschiedene SHA-Erweiterungen und vieles mehr – allesamt auf Basis von AVX-512. Bei den beiden erstgenannten handelt es sich um Algorithmen zur Hardwarebeschleunigung von Ver- und Entschlüsselungen. Generell soll der Fokus auf der Beschleunigung von Krypthografie-Algorithmen liegen, was wiederum die von Intel angesprochenen Optimierungen bei den speziellen Anwendungen betrifft.

Das Serverhardware-Benchmarking

Dabei wollen wir auch gleich auf einen extrem wichtigen Aspekt in diesem Bereich eingehen. Das Benchmarking von Server-Hardware ist in weiten Teilen nicht mit dem zu vergleichen, was für Endkunden-Hardware beachtet werden muss. Natürlich geht es letztendlich immer um einen möglichst effektiven Vergleich, doch die Anforderungen dahingehend sind weitaus komplexer.

So gibt es zwar auf dem Desktop einige Anwendungen (und auch Spiele), bei denen es sich lohnt, das Hyper Threading (Intel) oder Simultaneous Multithreading (AMD) abzuschalten, für einen Großteil der Anwendungen ist eine Aufteilung der Threads auf zwei pro Kern aber durchaus sinnvoll, um die zur Verfügung stehenden Ressourcen möglichst effektiv zu nutzen. Für Serveranwendungen sieht dies ganz anders aus. Hier kommt es sehr genau auf die jeweiligen Anwendungen an, ob der Einsatz von HT bzw. SMT Sinn macht oder nicht. Das Verhältnis aus Anwendungen, die vom Hyper Threading profitieren ist im Vergleich zum Desktop eher ausgeglichen, wenn nicht gar eher in Richtung ein Thread pro Kern. Diese Tendenz ist auch klar für Serverprozessoren auf Basis einer Arm-Architektur zu erkennen. Hier bieten die neuesten Prozessoren gar keine SMT mehr. Zugleich verhindern ein Abschalten von HT bzw. SMT viele Sidechannel-Attacken.

Eine Ebene weiter getrieben werden kann dies über den Non-Uniform Memory Access oder kurz NUMA. Von Belang ist dies nicht mehr nur in Multi-Socket-Systemen, in denen mehr als ein Prozessor arbeitet. Aber auch AMD hatte in der ersten EPYC-Generation durch den Aufbau das Problem, dass Daten sich in Bereichen des Arbeitsspeichers befinden konnten, die nicht direkt, sondern durch einen anderen NUMA-Knoten angebunden waren. Dies hat natürlich Auswirkungen auf die Latenzen und die Bandbreite, mit der auf die Daten zugegriffen werden kann.

Software kann sich des Vorhandenseins mehrere NUMA-Cluster bewusst sein und hält die Daten entsprechend dort vor, wo sie vermutlich am schnellsten zugänglich sind. Weiß die Software allerdings nichts von NUMA-Clustern, können Datenzugriffe durch erhöhte Latenzen und verminderte Speicherbandbreiten auch verlangsamt werden. Doch auch dieses Thema kann eine weitere Komplexitätsebene erreichen, wenn wir nicht nur über Zugriffe auf dem Arbeitsspeicher sprechen, sondern auch über solche in den inzwischen nicht unwesentlich großen Caches. Hier kommen dann sogenannte Sub NUMA Cluster (SNC) ins Spiel. Für seine aktuellen Xeon-Prozessoren sieht Intel pro Socket zwei SNCs vor. In einem 2S-System sind dies dann vier NUMA-Cluster. Auch hier gilt: Ist der Software das Vorhandensein dieser NUMA-Cluster bewusst, können die Daten entsprechend optimiert abgelegt werden und dies trägt sogar dazu bei, die Leistung zu erhöhen. Ist dies jedoch nicht der Fall, sollten die SNCs deaktiviert werden, was für einen Großteil der verwendeten Software der Fall ist.

Das Zusammenspiel aus Hard- und Software ist der letzte wichtige Aspekt, auf den wir in diesem Zusammenhang eingehen wollen. Die Intel-Prozessoren unterstützen beispielsweise AVX-512. Spezielle Befehlssätze, die darauf ausgelegt sind, können davon Gebrauch machen und Berechnungen somit deutlich schneller ausführen. Ist die Anwendung darauf ausgelegt, wird ein direkt Vergleich zwischen einem Xeon- und einem EPYC-Prozessor also schwieriger. Hier kann man nun auf dem Standpunkt stehen und sagen "ich möchte einen 1:1-Vergleich ohne AVX-512 sehen" oder aber man stellt der Hardware das zur Verfügung stehende Leistungspotenzial zur Verfügung.

Dies gilt auch für die Compiler-Einstellungen, die für die Benchmarks gewählt werden. AMD hat hier ebenso optimierte Einstellungen wie Intel. Diese 1:1 zu vergleichen, ist nicht immer ganz einfach. Aber auch hier gilt: Der Hardware sollte das zur Verfügung stehende Potenzial auch zugestanden werden, schließlich wird ein Cloud-Provider oder interessierte Käufer eben für seine spezielle Anwendung genau diese Optimierungen auch nutzen wollen.

All die oben genannten Punkte spielen für die Tests eine wichtige Rolle und sollen auch möglichst transparent aufgeführt werden. Aber nun zunächst einmal ein paar Worte zum Testsystem.

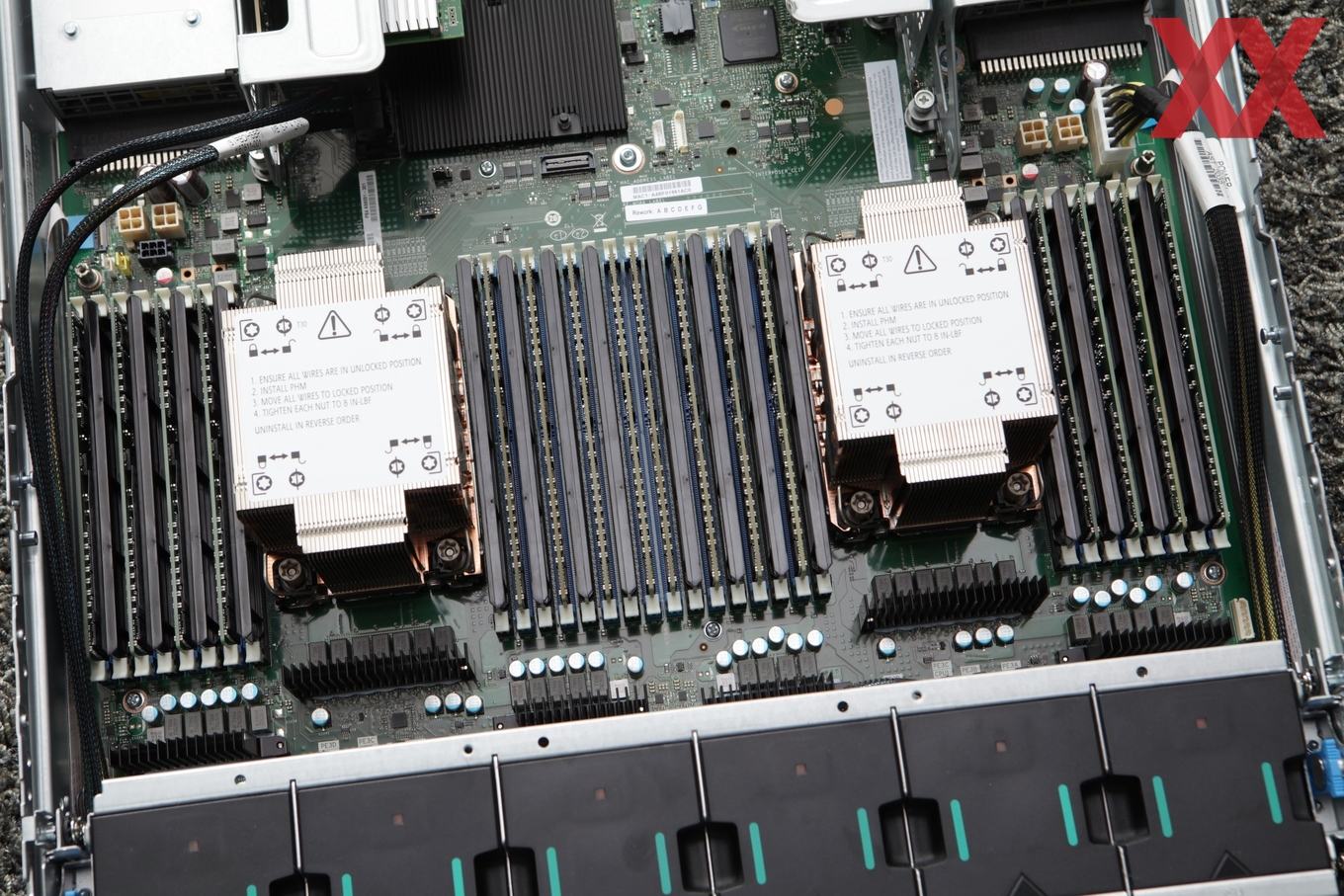

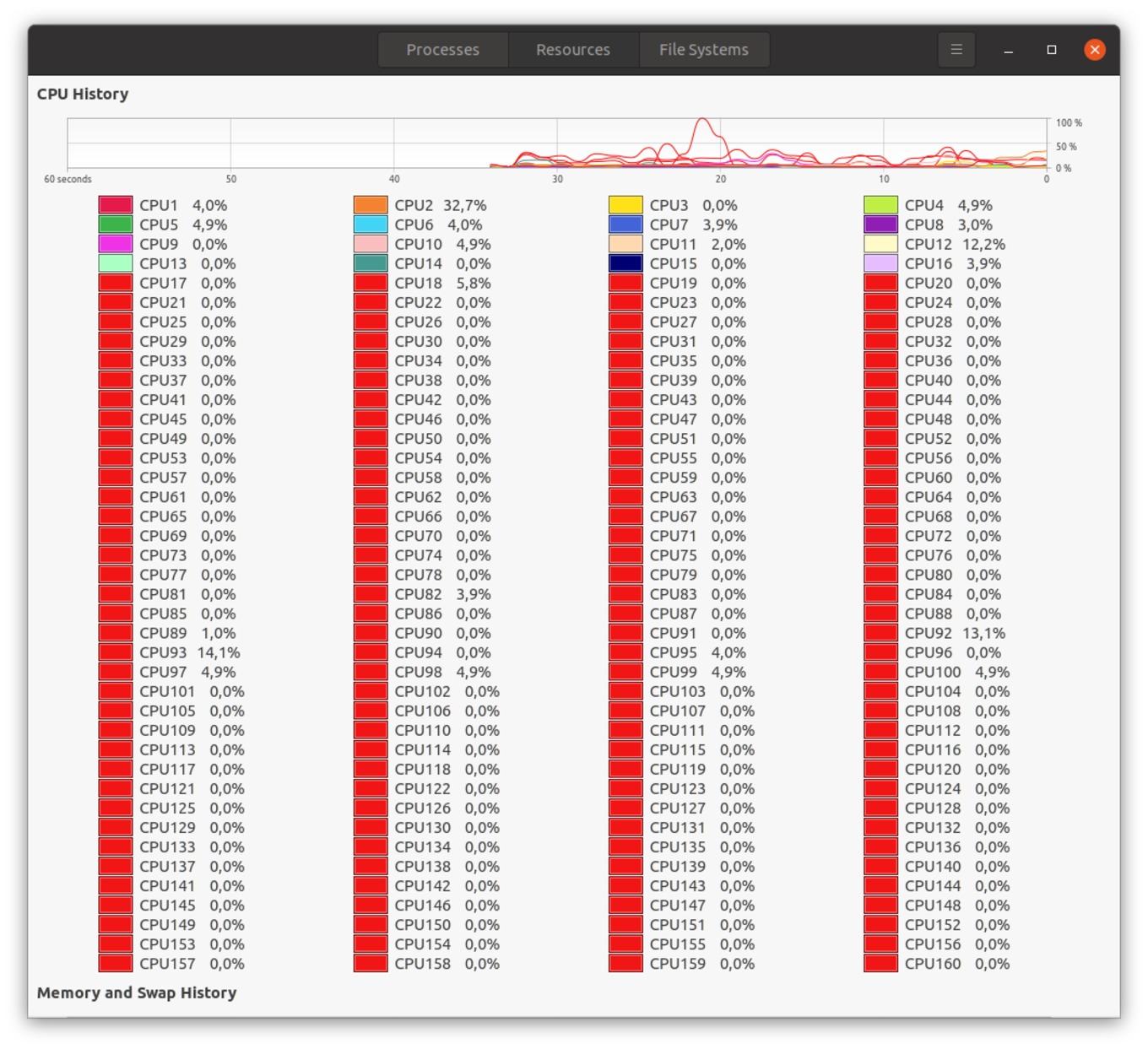

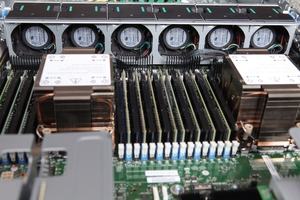

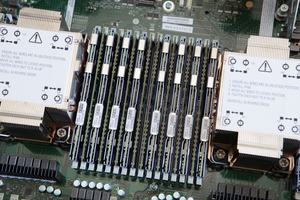

Intel stellt uns ein Ice-Lake-Referenzsystem S2W3SIL4Q zur Verfügung. Das 2S-System verwendet zwei Xeon Platinum 8380 mit jeweils 40 Kernen. An Arbeitsspeicher verbaut sind 16x 32 GB Hynix HMA84GR7CJR4N-XN, optional konnten wir noch 16x 128 GB Optane Persistent Memory 200 verbauen. Die Stromversorgung erfolgt über zwei Netzteile mit einer Ausgangsleistung von jeweils 2.100 W. An Massenspeicher vorhanden waren eine Intel SSD P5510 mit 7,68 TB, eine SSD D3-S4610 mit 960 GB sowie zwei Optane SSD P5800X mit jeweils 800 GB. Zur Netzwerkanbindung vorhanden ist noch eine Intel E810-CQDA2 NIC.

Rückblick auf Skylake-SP und Cascade Lake-SP

Mit dem Vergleich zwischen zwei Xeon Platinum 8280 und den damaligen Vorgängern Xeon Platinum 8180 haben wir uns mit dem Thema der Serverprozessoren schon einmal ausführlicher beschäftigt. Der Wechsel von Skylake-SP zu Cascade Lake-SP war aber bis auf DL-Boost-Benchmarks kaum mit bemerkenswerten Leistungsunterschieden versehen. Mit Ice Lake-SP steht nun ein echter Mikroarchitekturwechsel an.

Der Xeon Platinum 8180 und 8280 verfügen über jeweils 28 Kerne und können 56 Threads verarbeiten. Da sie beide den Sockel LGA3647 verwenden und der Purley-Plattform zugehörig sind, können wir beiden erneut auf dem identischen Mainboard (wir haben wieder ein Supermicro X11DAi-N verwendet) mit gleicher Speicherausstattung testen. Allerdings wird der Xeon Platinum 8180 den Speicher mit 2.666 MHz ansprechen, während der Xeon Platinum 8280 dies mit 2.933 MHz tut. Alle Details zur Hardware, die damals wie heute zum Einsatz gekommen ist, finden sich hier.

Aber nicht nur in der Plattform kommt es zu Unterschieden, sondern auch durch die Kühlung. Die LGA3647-Prozessoren testen wir in einem eigens zusammengestellten System. Die Ice-Lake-SP-Prozessoren in einem kompletten Rack mit zwei Höheneinheiten. Lautstärke und Temperaturen spielen für den heutigen Vergleich aber ohnehin keine Rolle. Wir mussten nur sicherstellen, dass beide Plattform und die drei Xeon-Generationen nicht durch die Temperaturen limitiert wurden. Für die Kühlung der LGA3647-Prozessoren haben wir demnach wieder auf zwei Noctua NH-U12S DX-3647 gesetzt. Auch unter Volllast wurden die Prozessoren bei 2.000 Umdrehungen pro Minute nicht wärmer als 60 °C. Damit bewegten sie sich auf Niveau mit den Ice-Lake-Modellen im Serverrack.

Für die Benchmarks der Xeon Platinum 8180 und 8280 gilt hinsichtlich der Einstellungen für das Hyper Threading, SNC und die Compiler-Einstellungen das Gleiche wie am ersten Abschnitt angemerkt.