Neben der Verwendung von bis zu 40 Sunny-Cove-Kernen betrifft eine wichtige Neuerung der Ice-Lake-SP-Prozessoren das Speicherinterface sowie die Reduzierung der Latenzen im L3-Cache und Arbeitsspeicher.

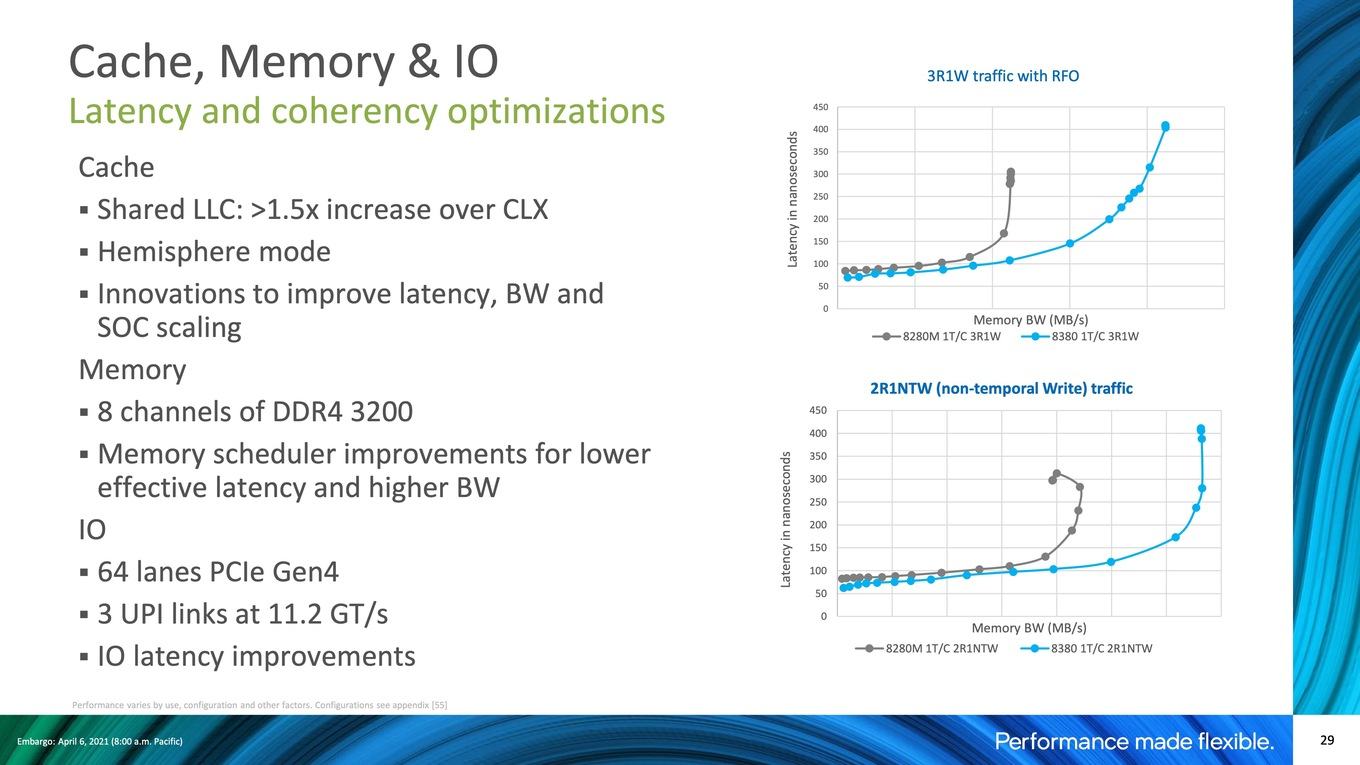

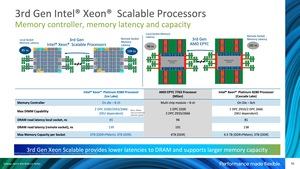

Im Vergleich zu den aktuellen Xeon-Prozessoren erhöht Intel die Anzahl der Speicherkanäle von sechs auf acht. Pro Speicherkanal können zwei Module verwendet werden. Bei der Geschwindigkeit geht Intel von DDR4-2933 auf DDR4-3200 – zumindest für die schnelleren Xeon-Modelle. Zum Vergleich: Zwar unterstützt auch AMD bei den EPYC-Prozessoren DDR4-3200, allerdings nur für ein Modul pro Speicherkanal. Eine gesteigerte Speicherbandbreite bei gleichzeitig geringeren Latenzen soll das Geheimnis des neuen Speichercontrollers sein.

Per Ultra Path Interconnect (UPI) kommunizieren mehrere Xeon-Prozessoren in einem Multi-Socket-System miteinander. Intel sieht drei UPI-Links vor, die jeweils 11,2 GT/s erreichen können. Bisher waren hier 9,6, bzw. 10,4 GT/s möglich. Intel hat die Anbindung mehrerer Prozessoren also leicht beschleunigen können. Ein weiterer wichtiger Faktor ist sicherlich die Unterstützung von PCI-Express 4.0 - mehr als zwei Jahre nachdem AMD mit der zweiten EPYC-Generation auf PCI-Express 4.0 wechselte und damit die Möglichkeit bot, externe Hardware deutlich schneller anzubinden. Mit 64 PCI-Express-Lanes bietet Intel selbst in der Ice-Lake-Generation nur halb so viele wie AMD. Ein Dual-Socket-System kommt immerhin auf 128 Lanes, da Intel den UPI als Interconnect zwischen den Sockeln verwendet. Bei AMD sind es im 2S-Betrieb 192, da 64 Lanes für die Kommunikation mit anderen Sockeln verwendet werden.

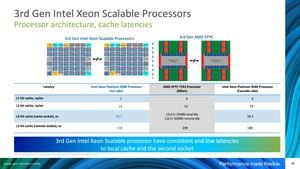

In Zahlen ausgedrückt verzeichnet Intel für den L1-Cache geringfügig höhere Latenzen durch mehr Taktzyklen, die für einen Hit durchlaufen werden müssen und auch im L2 sind die Verbesserungen gegenüber Cascade Lake nicht vorhanden und AMD geringfügig im Vorteil. Beim L3-Cache muss man etwas genauer hinschauen und unterscheiden, ob die Daten bei den EPYC-Prozessoren im lokalen L3-Cache des CCDs liegen, oder auf einem anderen CCD. Lokal liegt die Latenz bei 13,4 ns, bei Intel sind es 21,7 ns. Müssen die Daten jedoch von einem anderen CCD erst übertragen werden, ist die Latenz mit 112 ns bei AMD deutlich höher. Hier zeigt sich eben der Unterschied zwischen einem monolithischen und einem Chiplet-Design. Man muss allerdings sagen, dass AMD einen bis zu 256 MB großen L3-Cache anzubieten hat, während es bei Intel nur 38,5 MB sind.

Ein weiterer Punkt bei den Latenzen ist der Zugriff in einem Multi-Sockel-System auf den L3-Cache eines entfernten Sockels. Diese liegen bei Intel nun bei 118 ns (Cascade Lake: 180 ns) und sind im Vergleich zu AMDs EPYC-Plattform mit 209 ns ebenfalls deutlich geringer.

Auch bei den Latenzen zum Arbeitsspeicher sieht sich Intel mit 85 und 139 ns gegenüber 96 zu 191 ns besser aufgestellt. Zudem wird - wie eben schon erwähnt - DDR4-3200 für zwei DIMMs pro Speicherkanal unterstützt, während dies bei AMDs EPYC-Prozessoren nur für ein Modul pro Speicherkanal möglich ist.

Cache- und Speicherlatenzen

Natürlich aber wollen wir nicht auf die Zahlen von Intel vertrauen und habe eigene Messungen gemacht:

Intel Memory Latency Checker

Cache-Latenzen

Werbung

Unsere Messungen für die Cache-Latenzen zeigen auf, dass es durch das größere Mesh-Netzwerk zu geringfügig höheren Latenzen kommt. Dies gilt für alle Zugriffe auf den L1-, L2- und L3-Cache der neuen Ice-Lake-SP-Prozessoren. Mit Einschalten des SNC2 reduzieren sich die Latenzen für den L1- und L2-Cache, da das Mesh-Netzwerk in zwei kleinere Netzwerke aufgeteilt wird, was im Zweifel helfen kann.

Für Zugriffe auf den L3-Cache des zweiten Sockels konnte Intel aber eine große Verbesserung in der Latenz bewerkstelligen, was je nach Anwendung von Vorteil sein kann.

Intel Memory Latency Checker

DRAM-Latenz Lesen

Intel Memory Latency Checker

DRAM-Latenz Lesend - Remote-Socket

Die Latenzen für Zugriffe auf den Speicher steigen, wenn auch nur leicht, an. Aber auch hier gibt es eine Verbesserung für Zugriffe auf Speicherbereiche, deren Adressraum zum Speicher des zweiten Prozessors gehören – die sogenannten Remote-Zugriffe.

Speicherbandbreite

Stream

Copy

Stream

Scale

Stream

Triad

Stream

Add

Die Steigerung der Speicherbandbreite wird einerseits durch nun acht und zuvor sechs Speicherkanäle erreicht, aber auch der Speicher wird von DDR4-2666 (Skylake) über DDR4-2933 (Cascade Lake) auf nun DDR4-3200 (Ice Lake) beschleunigt. Auch an der internen Bandbreite in der Anbindung der Speichercontroller hat Intel einige Verbesserungen vorgenommen, sodass sich der Zugewinn an dieser Stelle auch in einer höheren Leistung in der Anbindung der Kerne niederschlagen sollte.