Werbung

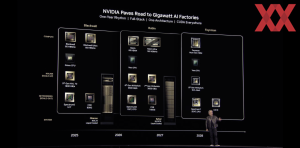

Bereits gestern startete die diesjährige GTC als "GTC AI Conference" mit einem Vorab-Programm, bevor NVIDIAs CEO Jensen Huang heute in wenigen Stunden die Bühne betreten und seine Keynote abhalten wird. Das, was 2009 als GPU Technology Conference begann, entwickelte sich über die Jahre zur mehr als nur NVIDIAs Hausmesse. CUDA entwickelte sich zu einer Compute-Plattform mit GPU-Beschleunigung, aus NVIDIA – der "Gaming Company" – wurde ein im Rechenzentrum dominantes Unternehmen für die Hardwarebeschleunigung.

Eine kluge Produktausrichtung, aber sicherlich auch der Faktor zum richtigen Zeitpunkt am richtigen Ort zu sein, sorgte dafür, dass NVIDIA mit der größte Profiteur des KI-Boom ist. Jahresumsätze von 130 Milliarden US-Dollar und Gewinne von fast 73 Milliarden US-Dollar in zwölf Monaten belegen diese Dominanz. Für Forscher, KI-Unternehmen, Entwickler und viele mehr ist NVIDIA in dieser Hinsicht die erste Anlaufstelle – für die Hardware, aber auch das Software-Ökosystem ist gewaltig.

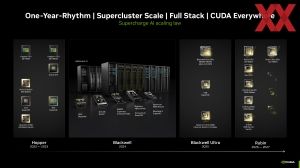

Mit der GTC will NVIDIA diese Bindung weiter stärken und zeigt zudem immer wieder neue Entwicklungen aus den Bereichen Hard- und Software. In diesem Jahr soll der Zwischenschritt von Blackwell zu Rubin, als nächst größerer Generationensprung, gemacht werden. Blackwell Ultra wird weiterhin auf der Blackwell-Architektur basieren, die GPUs bekommen aber deutlich mehr Speicher spendiert. Damit adressiert NVIDIA die für die immer größeren KI-Modelle notwendigen Anforderungen an die Größe des zur Verfügung stehenden Speichers. Ein jährlicher Rhythmus für die Einführung neuer Hardware ist angedacht.

In der aktuellen Blackwell-Generation stehen den GPUs jeweils bis zu 192 GB an HBM3E zu Seite, die auf eine Speicherbandbreite von 8 TB/s kommen. Als GB200 (Grace Blackwell Superchips) kombiniert NVIDIA eine Grace-CPU mit zwei Blackwell-GPUs und kommt demnach auf 384 GB. Dies skaliert NVIDIA als GB200 NVL4 und NVL72 mit vier oder mehr dieser GB200-Beschleuniger und kommt somit auf bis zu 36 Grace-CPUs, 72 Blackwell-GPUs und somit 13,5 TB in einem Serverrack.

Mit Blackwell Ultra setzt NVIDIA auf neuen HBM3E-Speicher mit mehr DRAM-Stapelschichten, so dass die Speicherkapazität gesteigert werden kann. Von 192 auf 288 GB pro Blackwell-GPU geht es. Damit kommt ein GB300 Grace Blackwell Ultra Superchip aus 576 GB an HBM3E, der weiterhin über eine Speicherbandbreite von 8 TB/s verfügt. Ein GB300-NVL72-System mit 36 GB300-Beschleunigern bringt es dann auf 20,25 TB an schnellem HBM3E.

Neben dem größeren Speicherausbau wird Blackwell Ultra laut NVIDIA über "mehr AI FLOPS" verfügen. Einerseits dürfte hier die Erweiterung des Speichers eine Rolle spielen. Aber auch neue Hard- und Softwareverbesserungen sowie eine stetige Weiterentwicklung der Plattform spielen eine Rolle. Zuletzt könnte NVIDIA noch an der Leistungsschraube drehen und Blackwell Ultra mehr als 1.000 W zugestehen.

Die B300-GPU hat ein komplett neues Tape-Out erfahren, wird aber weiterhin in 4NP bei TSMC gefertigt. Das neue Tape-Out wurde notwendig, da im Vergleich zur bisherigen Blackwell-GPU Designänderungen gemacht wurden. Auf dem Papier soll die B300-GPU mit zwei optimierten Blackwell-GPUs um 50 % höhere FLOPS als die B200-GPU erreichen können. Erste Details dazu hatten wir bereits kurz vor dem Jahreswechsel zusammengefasst.

NVIDIA hat inzwischen vieles selbst in der Hand: Von den Beschleuniger-Chips, über die NVLink-Chips für den extrem schnellen Interconnect bis hin zu den Quantum-, Connect-X- und Spectrum-Chips für InfiniBand und Ethernet. Das aktuelle Produktportfolio für Blackwell ist schon riesig und für Blackwell Ultra als nächste Generation beständig. Neuigkeiten könnte es in diesem Segment auf der GTC25 dennoch geben.

Rubin-GPU und Vera-CPU dann schon 2026

Für die übernächste Generation Rubin steht dann wieder eine ganze Reihe an neuen Netzwerk- und Interconnect-Chips an. Hinzu kommt die sechste Generation des NVLink-Interconnects wird 1,8 TB/s pro Richtung erreichen. Während Hopper und Blackwell für die Superchips auf die Grace-CPU setzen, wird für Rubin eine neue CPU namens Vera zum Einsatz kommen. Auf GB300 (Grace Blackwell Ultra) wird demnach VR200 (Vera Rubin) folgen. Hinzu kommen neue CX9 SuperNICs mit 1,6 TBit/s pro Port und Spectrum X1600 Ethernet/InfiniBand-Switches mit ebenfalls 1,6 TBit/s pro Port. Daneben wird Rubin offenbar auf HBM4 mit acht Stacks setzen. Mit Rubin Ultra steht dann für 2027 ein Refresh auf dem Plan – analog zu Blackwell und Blackwell Ultra in diesem Jahr.

Die Keynote der GTC startet um 18:00 Uhr unserer Zeit. Über die offiziellen Neuankündigungen werden wir berichten.

Update:

NVIDIA hat Blackwell Ultra und auch die Nachfolger Vera Rubin sowie Rubin Ultra vorgestellt. Mit technischen Details hielt man sich in der Keynote noch zurück.

Blackwell Ultra soll in der zweiten Jahreshälfte 2025 auf den Markt kommen und bietet vor allem ein Update auf 288 GB an HBM3E für jede Blackwell-GPU. Zudem erfolgt im Blackwell-Ultra-NVL72-Rack ein Update auf Connect-X 8 mit einer verdoppelten Bandbreite von 14,4 TB/s.

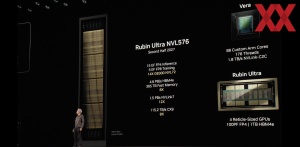

In der zweiten Jahreshälfte 2026 soll dann Vera Rubin folgen. Mit dieser Generation wird NVIDIA in der Namensgebung einen Wechsel vollziehen. Anstatt die Anzahl der Packages als NVL-System anzugeben, wird man die GPUs hernehmen. Bei Blackwell zählt NVIDIA die Anzahl der Packages – pro Package kamen zwei Blackwell-GPUs zum Einsatz. Dies ist auch bei Blackwell Ultra und Vera Rubin der Fall. Mit Vera Rubin werden nun aber die Rubin-GPUs gezählt – 144 an der Zahl. Jeder GPU stehen 288 GB an HBM4 zur Seite, die auf eine Speicherbandbreite von 13 TB/s kommen sollen. NVLink macht einen Sprung auf 1,8 TB/s.

Zusammen mit der neuen Rubin-GPU wird es eine Vera-CPU mit 88 Custom-ARM-Kernen geben. Diese ist per NVLink mit den GPUs verbunden. Insgesamt soll Vera Rubin NVL144 um den Faktor 3,3 schneller als GB300 (Blackwell Ultra) NVL72 sein.

Für die zweite Jahreshälfte 2027 plant NVIDIA mit Rubin Ultra. Als NVL576 kommt hier zum Ausdruck, dass gleich vier Rubin-GPUs in einem Package arbeiten. Zusammengenommen beträgt der Speicherausbau 1 TB an HBM4.

Auf Rubin Ultra wird Feynman folgen und ebenfalls wieder auf die Vera-CPU setzen. Der dazugehörige Speicher wird als Next-Gen HBM bezeichnet, so dass wir hier vermutlich keinen HBM4 mehr sehen werden. Bis der Feynman-GPU wird es aber bis 2028 dauern.

| Blackwell | Blackwell Ultra | Vera Rubin | Rubin Ultra | |

| Erscheinungsdatum | 2024 | H2 2025 | H2 2026 | H2 2027 |

| GPU-Architektur | Blackwell | Blackwell | Rubin | Rubin |

| GPUs pro Package | 2 | 2 | 2 | 4 |

| CPU-Architektur | Grace | Grace | Vera | Vera |

| CPU-Kerne | 72 | 72 | 88 | 88 |

| CPU-Speicher | 480 GB LPDDR5X 384 GB/s | 480 GB LPDDR5X 384 GB/s | - | - |

| GPU-Speicher | 192 GB HBM3E 8 TB/s | 288 GB HBM3E 8 TB/s | 288 GB HBM4 13 TB/s | 1 TB HBM4E |

| NVLink | NVLink 5 900 GB/s | NVLink 5 900 GB/s | NVLink 6 1,8 TB/s | NVLink 7 3,6 TB/s |

| Leistungsprojektion | - | 1,5x GB200 NVL72 | 3,3x GB300 NVL72 | 14x GB300 NVL72 |