Werbung

In einer Investoren-Präsentation für den Oktober 2023 spricht NVIDIA außergewöhnlich offen über die eigene Roadmap bei den AI-Beschleunigern. Aktuell dominiert NVIDIA den Markt, während Intel mit dem Gaudi 2 vor allem durch dessen Verfügbarkeit punkten kann, während NVIDIA die H100-Beschleuniger zu beliebigen Preisen aus den Händen gerissen werden.

Doch diese Vormachtstellung könnte bedroht sein, denn spätestens im kommenden Jahr werden AMD mit den MI300- und Intel mit dem Gaudi-3-Beschleuniger in Sachen Hardware wohl auf Augenhöhe sein. Allerdings hat NVIDIA noch die breite Softwareunterstützung auf seiner Seite.

Ein Bericht bei SemiAnalysis rückte die Investoren-Präsentation in den Fokus und hier liefert man auch etwas Kontext.

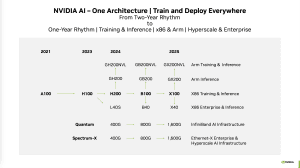

Demnach soll NVIDIA die Kadenz zwischen den Beschleuniger-Generationen erhöhen. Im kommenden Jahr sollen sogar zwei Chips in diesem Segment erscheinen.

Aktuell bietet NVIDIA den H100-Beschleuniger für das Training und Inferencing in Servern an. Bereits Ende dieses Jahres, in einer etwas schnelleren Version ab kommendem Jahr werden die Grace Hopper Superchips GH200 und GH200NVL hinzukommen. Zudem wird es offenbar eine Art Refresh in Form des H200-Beschleunigers geben, der noch auf der Hopper-Architektur basieren wird. Bis auf den H200-Beschleuniger hat NVIDIA die Produkte bereits angekündigt und zum GH200 sogar schon ein paar Leistungswerte geliefert.

Darauffolgen sollen, vermutlich ab dem zweiten Halbjahr 2024, der B100-Beschleuniger (Blackwell) sowie das nächste ARM+GPU-Kombinationspackage Grace Blackwell Superchip. Davon wird es auch wieder eine Dual-Chip-Lösung mit mehr Speicher als NVL-Variante geben. Um die Daten auch schnellstmöglich an die Beschleuniger zu übertrage,n plant NVIDIA in den InfiniBand- und Netzwerklösung mit der Backwell-Generation mit 800 GBit/s.

Auf Backwell soll dann eine Generation folgen, die bisher nur mit X bezeichnet wird. Einen Namen will NVIDIA hier offenbar nicht verraten. Analog zu den vorherigen Generationen wird es einen Standalone-Beschleuniger X100 geben, aber auch die bekannten Kombinationen mit einem ARM-Chip wie den GX200 oder auch GX200NVL. Um auch hier den Datentransfer zu den Beschleunigern zu verbessern plant NVIDIA dann schon mit 1,6 TBit/s schnellen Verbindungen.

Ob es 2025 dann mit dieser Schlagzahl weiter geht, lässt NVIDIA allerdings offen. Die Übergange werden hier ohnehin zunehmen fließend werden – ähnlich wie beiden Xeon-Prozessoren von Intel. Die Hyperscaler tauschen die alte Hardware nicht komplett aus und ersetzen sie direkt durch neue, sondern hier gibt es Übergänge, in denen mehr und mehr neue Hardware hinzukommt, während die ältere weitergenutzt wird, bis dies wirtschaftlich keinen Sinn mehr macht. Dies hängt aber auch von der Nachfrage ab, denn auch heute sind Systeme mit A100-Beschleunigern noch sehr gefragt, da der Nachfolger H100 kaum zu bekommen ist.

An dieser Stelle wollen wir noch einmal auf die von uns aufgetane Roadmap hinweisen, welche die nun neue Roadmap in etwa bestätigt.

Im Zusammenhang mit der Verfügbarkeit der AI-Beschleuniger-Hardware von NVIDIA weist SemiAnalysis daraufhin, dass Unternehmen wie Microsoft und Amazon in Form des Athena und Trainium2 sowie Inferentia3 bald eigene Beschleuniger-Chips vorstellen werden, um ihre KIs und Large-Language-Modelle zu trainieren und an die Kunden eine entsprechende Ausgabe zu liefern. Bis auf Weiteres aber hat NVIDIA alle Trümpfe in der Hand und dies wird sich auch in den nächsten Quartalszahlen zeigen.

Update:

Laut eines südkoreanisches Berichtes bei MT.co.kr wird NVIDIA den HBM3E von sk hynix exklusive erhalten. Eine entsprechende Vertragsunterzeichnung soll kurz bevorstehen. In diesem Zuge wird auch erwähnt, dass der B100-Beschleuniger, als Nachfolger des aktuellen H100, vom vierten Quartal 2024 auf das zweite Quartal 2024 vorgezogen wird. Damit will man die enorme Nachfrage nach KI-Beschleunigung besser decken können, zumal der B100 noch einmal deutlich schneller als der aktuelle H100 sein soll.

Die entsprechenden Qualifikationstests für den HBM3E sollen im ersten Quartal 2024 beginnen. Intern wird sk hynix den neuesten HBM-Speicher bereits testen. Bereits seit Juni diesen Jahres arbeitet NVIDIA am Post-Silicon-Testing des B100 und hat entsprechend frühe Samples des HBM3E erhalten. Nun gehe es seit einigen Wochen und Monaten darum Fehler zu beseitigen und die Ausbeute zu verbessern. Die Massenproduktion des HBM3E soll zusammen mit der letzten Qualifikationsphase im ersten Quartal 2024 beginnen.