Werbung

Zusammen mit der Vorstellung der Instinct MI300A und Instinct MI300X präsentierte AMD in der vergangenen Woche auch beeindruckende Leistungsdaten. Laut dieser ist der Instinct-MI300X-Beschleuniger mindestens auf Augenhöhe mit dem H100-Beschleuniger von NVIDIA.

Nun aber kontert NVIDIA die von AMD gemachten Aussagen und veröffentlicht in einem Blogpost neue Zahlen, die auch Bezug auf den Instinct-MI300X-Beschleuniger nehmen. Was dabei besonders deutlich wird, ist die Optimierung der Software auf bestimmte Aufgaben, was bei den Large Language Models (LLM) immer wieder zu Tage tritt. Egal ob AMD, Intel oder NVIDIA – immer wieder zeigen sich große Leistungssprünge von 30 % bis 100 % durch den Einsatz optimierter Software. NVIDIA bietet zu diesem Zweck TensorRT-LLM als Bibliothek an.

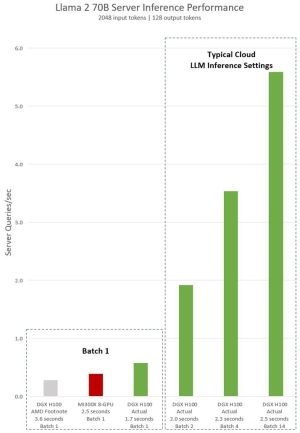

NVIDIA stellt nun einen Vergleich der von AMD präsentierten Zahlen mit eigens erhobenen Werten an. Dazu verwendet wird das Llama 2 70B mit 70 Milliarden Parametern.

NVIDIA verweist mit den Daten darauf, dass AMD hier zunächst einmal ohne TensorRT-LLM auf der H100-GPU getestet hat. Dies ist auch der Fall, wenn gleich acht GPUs in einem DGX-H100-System zum Einsatz kommen und gegen ein ebenso mit acht Instinct MI300X bestücktes System verglichen wird.

Mit der optimierten Software liefert das DGX-H100-System eine deutlich schnellere Antwortzeit, als dies für das System mit den Instinct MI300X der Fall ist. 2,5 zu 1,7 Sekunden werden hier genannt. NVIDIA führt auch Werte für größere Batch-Größen an. Üblicherweise wird mit fixen Antwortzeiten gearbeitet und entsprechend bewertet, wie viele Antworten die Hardware gleichzeitig bieten kann. Dazu machte AMD bisher noch keine Angaben.

Die Hersteller versuchen ihre eigene Hardware natürlich immer im besten Licht dazustellen. Dies ist für AMD, ebenso wie für NVIDIA und Intel der Fall. Die Tatsache, dass die Softwareoptimierung eine zunehmend wichtigere Rolle spielt, macht die Situation nicht einfacher. Als Gesamtsystem aus Hard- und Software aber sollte immer das Zusammenspiel aus allen Faktoren betrachtet werden.

Wir sind nun auf die ersten unabhängigen Benchmarks gespannt. Die MLCommons bietet dazu eine entsprechende Möglichkeit.

Update:

Schneller als erwartet gibt es nun den Konter zum Konter, denn nun hat AMD weitere Benchmarks veröffentlicht, welche den Vorsprung des Instinct MI300X gegenüber NVIDIA wieder bestätigen sollen.

In den neuen Benchmarks verwendet AMD nun TensorRT-LLM für den H100-Beschleuniger anstatt wie bisher vLLM. Verglichen wird die Leistung für FP16 auf dem Instinct-MI300X-Beschleuniger gegen FP8 für den H100. Neben den wichtigen Latenzen führt AMD auch den Durchsatz auf. Dazu sei erwähnt, dass hier immer ein System bestehend aus acht Beschleunigern herangezogen wird.

Für die Verwendung von FP16 sieht sich AMD um den Faktor 2,1 im Vorteil, wenn auf beiden Karten vLLM verwendet wird – soweit die alten und bisher bekannten Daten von AMD. Wird für den H100-Beschleuniger das verbesserte TensorRT-LLM mit FP16 verwendet, so sieht sich AMD weiterhin um 30 % schneller. Mit TensorRT-LLM und FP8 sowie auf die Latenzen bezogen nennt AMD 1,6 s für die eigene Hardware (allerdings mit FP16) und 1,7 s für NVIDIAs H100.

Die Werte und Umgebungsbedingungen einzuordnen ist nicht ganz einfach. Vieles hängt davon ab, welche Software und welche Datensätze zum Einsatz kommen. Hier werden potentielle Kunden ganz genau hinschauen und eigene Tests durchführen. Über die Cloud-Anbieter wird es als Kunde zudem möglich sein beide Umgebungen zu bewerten und sich dann für den Produktiveinsatz für die eine oder eben die andere Hardware zu entscheiden.