Werbung

Auf die letzten Monate dürfte NVIDIA als sehr erfolgreiches Unternehmen zurückblicken. Der AI-Boom verhilft dem Unternehmen zu Milliardengewinnen und noch immer ist kein Ende in der Nachfrage absehbar. GPT-3 stellt dabei nur den Einstieg dar. Text, Audio, Video, 3D, Physik, Medizin – all diese Bereiche haben inzwischen eigene Generative-AI-Ansätze, die als multimodale AIs zusammengeführt werden, um gemeinschaftlich an Lösungen und Services zu arbeiten.

Modelle wie Gemini von Google, NLLB von Meta, Mistral von Maxtral oder GPT-4 von OpenAI sind sogenannte Mixtures of Experts (MoEs), deren Funktionsumfang immer weiter erweitert wird. Riesige Datensätze für das Training, immer längere Sequenzen für die Prompts und höhere Anforderungen an die Echtzeit-Fähigkeiten stellen immer höhere Herausforderungen an die Hardware, denen NVIDIA aktuell noch mit der Hopper-Architektur begegnet.

Auf der GTC in San Jose stellte CEO Jensen Huang nun die Blackwell-Architektur und die gleichnamigen Beschleuniger vor. Das, was NVIDIA in Form der B100-, B200- und GB200-Beschleuniger geschaffen haben will, soll nicht weniger als eine industrielle Revolution in diesem Bereich sein. Im Grunde gilt das mit der Fortentwicklung der Halbleitertechnik für jede neue Generation.

Benannt ist die Blackwell-Architektur nach David H. Blackwell, einem Mathematiker und Statistiker, der sich mit den Themen Wahrscheinlichkeitsrechnung, Spieltheorie, Statistik und dynamische Programmierung beschäftigte.

Die Blackwell-GPU besteht aus zwei Chips, die in 4NP (eine Abwandlung des N4P-Prozesses) bei TSMC gefertigt werden. Laut NVIDIA bewegt man sich hier weiterhin an den Reticle-Limits in der Fertigung, was gleichbedeutend mit 800 mm² oder mehr an Chipgröße ist. Die GH100-GPU kommt auf 814 mm², etwa 858 mm² sind das Limit für eine Fertigung mit EUV-Belichtung. Sprich: Da NVIDIA in der Chipgröße limitiert ist, geht man nun ebenfalls den Weg des Chiplet-Designs. Eine kleinere Fertigung als 4N stand offensichtlich noch nicht zur Verfügung.

Verbunden sind die beiden Chips über ein Chip-2-Chip-Interface (C2C-Interface), das auf eine Bandbreite von 10 TB/s kommt. Zum Vergleich: AMDs Instinct MI300 kommen auf 17 TB/s über das gesamte Package, was sich wiederum aus 8x 2,1 TB/s pro XCD zusammensetzt. Apples UltraFusion-Interconnect für die Ultra-Chips kommt auf 2,5 TB/s. NVIDIA verbindet zwei Chips mit 10 TB/s. Auf Seiten der Fertigung verwendet NVIDIA hier TSMCs CoWoS-L-Technologie, die es laut TSMC theoretisch ermöglicht, bis zu sechs dieser riesigen Chips miteinander zu verbinden. Eine Variante der Blackwell-GPU mit nur einem Chip ist laut NVIDIA aktuell nicht geplant, wenngleich jeder dieser Chips auch alleine voll funktionsfähig wäre.

Die beiden Chips der Blackwell-GPU sollen wie ein großer Chip mit einer Fläche von 1.600 mm² arbeiten. Die Anzahl der Transistoren beläuft sich auf 208 Milliarden – 104 Milliarden pro Chip und damit jeweils 24 Milliarden mehr als bei Hopper. Beide Chips binden jeweils vier HBM3E-Speicherchips mit jeweils 24 GB an, so dass ein B100-Beschleuniger auf 192 GB an HBM3E-Speicher kommt. Die Speicherbandbreite liegt bei 8 TB/s.

| B100 | B200 | H100 | Instinct MI300X | |

| Fertigung | 4 nm | 4 nm | 4 nm | 5 / 6 nm |

| Anzahl der Transistoren | 208 Milliarden | 208 Milliarden | 80 Milliarden | 153 Milliarden |

| FP64-Rechenleistung | 30 TFLOPS (Tensor Core) | 40 TFLOPS (Tensor Core) | 67 TFLOPs | 81,7 TFLOPs |

| FP32/TF32-Rechenleistung | 1,8 PFLOPS (Tensor Cores) | 2,2 PFLOPS (Tensor Cores) | 134 TFLOPs | 163,4 TFLOPs |

| FP16-Rechenleistung | 3,5 PFLOPS (Tensor Cores) | 4,5 PFLOPS (Tensor Cores) | 1,979 PFLOPs | 1,3 PFLOPs |

| FP8-Rechenleistung | 7 PFLOPS (Tensor Core) | 9 PFLOPS (Tensor Core) | 3.958 PFLOPs | 2.61 PFLOPs |

| FP4-Rechenleistung | 14 PFLOPS (Tensor Core) | 18 PFLOPS (Tensor Core) | - | - |

| Speicher | 192 GB HBM3E 8 TB/s | 244 GB HBM3E 8 TB/s | 80 GB HBM3 3,35 TB/s | 192 GB HBM3 5,3 TB/s |

| Interconnect | NVLink 1,8 TB/s | NVLink 1,8 TB/s | NVLink 900 GB/s | Infinity Links 512 GB/s |

| PCI-Express | 6.0 | 6.0 | 5.0 | 5.0 |

| TDP | 700 | 1.000 W | 700 W | 750 W |

An dieser Stelle sei erwähnt, dass NVIDIA die H100-Beschleuniger in der zweiten Jahreshälfte 2023 um eine H200-, bzw. GH200-Generation ergänzen wird. Diese bietet 141 GB an HBM3E als Update von 80, bzw. 96 GB. Dies hatte für den H200-Beschleuniger Auswirkungen auf die Speicherbandbreite, die auf 4,8 TB/s anstieg. Bei der Rechenleistung gab es in dieser Update-Runde keinerlei Änderungen. Von Blackwell gibt es nun wieder zwei Varianten, B100 und B200. B200 wird eine weitere Speicherkonfiguration sein, zu der es aber noch keine offiziellen Informationen gibt. Vermutlich wird NVIDIA hier auf einen 12-Hi HBM3E-Speicher mit größerer Kapazität setzen. Ein B200-Beschleuniger käme damit auf 288 GB. Hinzu kommt eine Grace-GPU-Kombination namens GB200 NVL72. Zu dieser kommen wir noch.

Zur Rechenleistung sei an dieser Stellte gesagt, dass NVIDIA für die Backwell-Architektur bisher nur die Rechenleistung mit Tensor Cores nennt. Außerdem präsentieren die Hersteller gerne Zahlen mit dünn besetzten Matrizen (Sparcity). Ganz so einfach ist ein Vergleich der Rechenleistung somit nicht mehr. Die Angaben für FP8 und FP16 aber dürften die Kräfteverhältnisse in etwa abbilden.

Zumindest können wir die Zahlen zwischen den Lösungen von NVIDIA ganz gut vergleichen:

| Genauigkeit | Blackwell-GPU | H100 SXM |

| FP4 Tensor Core | 20 PFLOPS | - |

| FP8/FP6 Tensor Core | 10 PFLOPS | 3.958 PFLOPS |

| INT8 Tensor Core | 10.000 TOPS | 3.958 TOPS |

| FP16/BF16 Tensor Core | 5 PFLOPS | 1.979 TFLOPS |

| TF32 Tensor Core | 2,5 PFLOPS | 989 TFLOPS |

| FP64 Tensor Core | 45 TFLOPS | 67 TFLOPS |

Für die niedrigeren Genauigkeiten besitzt die Blackwell-GPU eine um den Faktor 2,5 höhere Rechenleistung. Für FP64 über die Tensor Cores sinkt die theoretische Rechenleistung von 67 auf 45 TFLOPS. Leider macht NVIDIA aktuell noch keine Angaben zur FP64-Rechenleistung der Shadereinheiten, bzw. zu deren Anzahl. Viele Fragen zur Blackwell-Architektur sind noch offen.

Mit 192 GB an Speicherkapazität kann NVIDIA nun einen Punkt ausgleichen, den AMD mit der Instinct-MI300-Serie für sich verbuchen konnte. Die Speicherbandbreite ist mit 8 TB/s allerdings ungleich höher. Besonders in AI-Anwendungen spielen Speicherkapazität und Geschwindigkeit eine wichtige Rolle. Nachaußen kommuniziert die Blackwell-GPU über eine 1,8 TB/s schnelle NVLink-Verbindung.

Die TDP für Blackwell gibt NVIDIA mit 700 bis 1.200 W an. Die luftgekühlten Varianten B100 und B200 sollen auf 700 bzw. 1.000 W kommen. 1.200 W lassen sich sicherlich nur wassergekühlt abführen. Die Blackwell-GPU ist mit einem PCI-Express-Controller versehen, der bereits den 6.0-Standard unterstützt.

Zur Blackwell-Architektur wird NVIDIA sicherlich im Rahmen der GTC noch einiges Verraten, bzw. das Whitepaper veröffentlichen. Die zweite Generation der Transformer Engine soll den Durchsatz bei einer Genauigkeit von 4 Bit deutlich erhöhen. Die Transformer Engine in der Ada-Lovelace- und Hopper-Architektur unterstützt 8 Bit Fließkommazahlen (FP8) an Genauigkeit. FP4 ermöglicht im Vergleich zu FP8 den doppelten Durchsatz, wenn auf die Genauigkeit von FP8 verzichtet werden kann.

| GB200 NVL722 | HGX B200 | HGX B100 | |

| Anzahl der GPUs im System | 72 | 8 | 8 |

| FP4 (Tensor Core) | 1,4 EFLOPS | 144 PFLOPS | 112 PFLOPS |

| FP8/FP6/INT8 | 720 PFLOPS | 72 PFLOPS | 56 PFLOPS |

| HBM-Gesamtkapazität | 30 TB | bis zu 1,5 TB | bis zu 1,5 TB |

| aggregierte Speicherbandbreite | 600 TB/s | bis zu 64 TB/s | bis zu 64 TB/s |

| aggregierte NVLink-Bandbreite | 130 TB/s | 14,4 TB/s | 14,4 TB/s |

| CPU-Kerne | 2.592 | - | - |

Die HGX-B200-Systeme beschreibt NVIDIA grundsätzlich mit Unterschieden in der Speicherausstattung. Uns nannte NVIDIA aber auch einen Unterschied in der Leistungsaufnahme, was letztendlich die unterschiedliche Rechenleistung erklärt. Der B100-Beschleuniger kommt auf jeweils 700 W, ein HGX-B100-System auf 112 PFLOPS für FP4. Der B200-Beschleuniger soll sich auf bis zu 1.000 W (+40 % gegenüber den 700 W von B100) konfigurieren lassen, die Rechenleistung fällt dann etwa 30 % höher aus. Die B100-Beschleuniger sollen aber als SXM5-Modul in bestehende Server passen, während dies für B200 nicht mehr der Fall ist.

Grace plus Backwell: GB200 NVL72

Zur Computex im vergangenen Jahr stellte NVIDIA die H100 NVL vor. Dabei handelt es sich um zwei H100-Beschleuniger auf jeweils einem PCB mit ebenfalls jeweils 94 GB HBM3, die per NVLink zu einer Karte – man könnte sagen – zusammengezurrt werden.

GB200 NVL72 ist eine Rack-Lösung von NVIDIA, in der 36 GB200-Beschleuniger zusammengefasst sind. Für den GB200-Beschleuniger gibt es jedoch eine entscheidende Änderung im Aufbau. Während der GH200-Beschleuniger aus jeweils einer Grace-CPU plus einer Hopper-GPU bestand, sind es beim GB200-Beschleuniger nun eine Grace-CPU plus zwei Blackwell-GPUs. Die GPUs sitzen nicht mehr auf dem gleichen Board wie die der Grace-CPU, sondern auf einem getrennten Modul innerhalb des Servers.

| GB200 | GH200 (2024) | |

| FP64-Rechenleistung (GPU) | 90 PFLOPS (Tensor Core Dense) | 34 TFLOPS |

| FP32-Rechenleistung (GPU) | 2,5 / 5 PFLOPS (Tensor Core) | 67 TFLOPS |

| FP8-Rechenleistung (GPU) | 10 / 20 PFLOPS (Tensor Core) | 3,958 TFLOPS |

| INT8-Rechenleistung (GPU) | 10 / 20 PFLOPS (Tensor Core) | 3,958 TOPS |

| CPU-Speicher | 480 GB (LPDDR5X) 512 GB/s | 480 GB (LPDDR5X) 512 GB/s |

| GPU-Speicher | 384 GB HBM3E | 141 GB HBM3E |

| Speicherbandbreite (GPU) | 2x 8 TB/s | 4,9 TB/s |

| CPU-GPU (C2C) | 900 GB/s | 900 GB/s |

| TDP | 1.200 W | 450 bis 1.000 W |

Ein GB200-Beschleuniger besteht aus einer Grace-CPU und zwei Blackwell-GPUs. Die Grace-CPU ist zu GH100/GH200 identisch. NVIDIA gibt die zusammengenommene Speicherkapazität von GB200 mit 864 GB an – 2x 192 GB HBM3E für die beiden Blackwell-Beschleuniger und 480 GB LPDDR5X, die an die Grace-CPU angebunden sind. Die Verbindung zwischen der Grace-CPU und den Blackwell-GPUs geschieht bei NVLink C2C mit 900 GB/s an bidirektionaler Bandbreite. Nach Außen hin ist jeder GB200-Beschleuniger per NVLink mit zweimal 1,8 TB/s angebunden.

Als GB200 NVL72 arbeiten also 36 GB200-Beschleuniger in einem Rack. Die Beschleuniger sitzen in 1U hohen Servern und werden wassergekühlt. Hinzu kommt ein NVLink-Switch-Tray mit zwei NVLink-Switches, der dafür sorgt, dass alle Beschleuniger untereinander möglichst schnell angebunden sind. Zu den Switches und den Netzwerk-Optionen haben wir eine gesonderte News vorbereitet.

Auf einem GB200-NVL72-Rack sollen LLMs mit bis zu 27 Billionen Parameters trainieren sollen. Für die aktuellen LLMs reden wir von mehreren Milliarden Parametern. NVIDIA bereitet die Infrastruktur also auf die kommenden LLMs vor.

Die GB200-NVL72-Hardware wird von Cloud-Anbietern wie AWS, Google Cloud, Microsoft Azure und der Oracle Cloud angeboten werden. AWS plant zudem den Aufbau eines AI-Supercomputers namens Ceiba, der auf dem GB200-NVL72-System basieren und aus mehr als 20.000 Blackwell-GPU bestehen soll. Die AI-Rechenleistung soll bei mehr als 400 EFLOPs liegen, was das System zu einem der schnellsten AI-Supercomputer machen würde.

Benchmarks auf Basis von Projektionen

Im Rahmen der Keynote sprach Jensen Huang einige Leistungswerte, vor allem für den Grace Blackwell Superchip (GB200) an. Leistungssteigerungen im den Faktor vier bis 30 wurden hier genannt. Diese Daten basieren meist noch auf Hochrechnungen bzw. Projektionen, denn ein wenn überhaupt läuft die Blackwell-GPU aktuell im Labor, aber noch nicht auf ihrem vollen Leistungspotential.

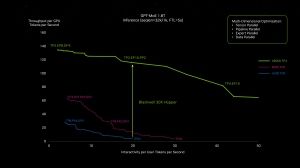

Für obigen ersten Benchmark vergleicht NVIDIA ein HGX-H100-System mit acht H100-Beschleunigern gegen 18 GB200 Grace Blackwell Superchips für ein 1.8T GPT-MoE Inferencing. Das zweite Diagramm zeigt das entsprechende Training – einmal auf 32.768 H100-Beschleunigern als Referenzwert und dann entsprechend viermal schneller auf 456 GB200 NVL72.

Deutlich mehr Leistung bei gleicher Leistungsaufnahme oder aber bei einer gewissen Leistungsvorgabe eine deutliche Reduzierung der notwendigen Hardware und Leistungsaufnahme sollen B100, B200 und GB200 ermöglichen.