Werbung

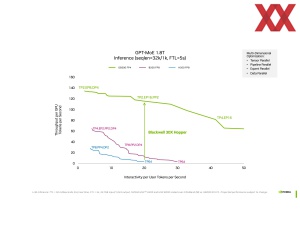

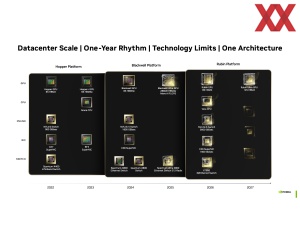

Im Vorfeld der Hot Chips 2024 sprach NVIDIA bereits über die Blackwell-Infrastruktur in Form des NVLink-Interconnects und der dazugehörigen Switches. Auf der Konferenz selbst verriet NVIDIA etwas mehr zur Blackwell-Architektur, bzw. der darin verbauten Tensor-Kerne. Diese können zwar weiterhin große Matrizen in einem Durchlauf berechnen, mit Hilfe neuer Datenformate wird der Durchsatz jedoch deutlich erhöht.

Durch ein neues Quantisierungs-System will NVIDIA die Leistung für das Inferencing großer Modelle deutlich steigern. Bei der Quantisierung handelt es sich um eine Art der Komprimierung des Modells. Für eine vergleichbare Informationsdichte (zum Beispiel in der Qualität eines der KI erstellten Bildes) sind weniger Daten notwendig. Dies beschleunigt die Prozesse für das Inferencing natürlich. Daher sind die Soft- und Hardwarehersteller in den vergangenen Monaten bestrebt, Datenformate wie INT8, FP8 und noch einfachere wie FP4 und INT4 zu verwenden. Bisher hielt sich der Leistungsvorteil in Grenzen, da für INT4- oder FP4-Berechnungen noch immer die vollen INT8- oder FP8-Recheneinheiten belegt wurden.

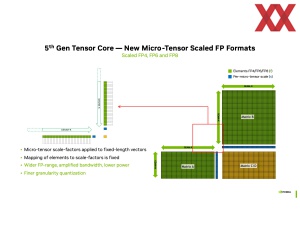

Mit den neuen Micro-Tensor Scaled Datenformaten für die 5. Generation der Tensor-Kerne in der Blackwell-Architektur soll sich dies nun ändern. Die Tensor-Kerne können FP8-, FP6- und FP4-Berechnungen auf die volle Vektorlänge verteilen und so bestenfalls mehrere gleichzeitig ausführen.

Wo sonst nur eine FP16-Berechnung durchgeführt werden konnte, sind zweimal FP8 oder viermal FP4 möglich. Im Vergleich zur Hopper-Architektur und der 4. Generation der Tensor-Kerne steigt der Durchsatz deutlich an:

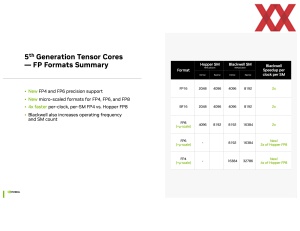

| Format | Hopper SM | Blackwell SM |

| FP16 | 2.048 / 4.096 MACs/Takt | 4.096 / 8.192 MACs/Takt |

| BF16 | 2.048 / 4.096 MACs/Takt | 4.096 / 8.192 MACs/Takt |

| FP8 | 4.096 / 8.192 MACs/Takt | 16.384 MACs/Takt |

| FP6 | - | 16.384 MACs/Takt |

| FP4 | - | 32.768 MACs/Takt |

vollbesetzte / dünnbesetzte Matrix

NVIDIA gibt die MACs pro Takt, also die Anzahl der Multiply-Accumulate-Operationen pro Taktzyklus, an. Für die Datenformate FP16, BF16 und FP8 kann deren Anzahl von Hopper zu Blackwell verdoppelt werden. FP6 und FP4 werden von Hopper gar nicht unterstützt. Für FP4 verdoppelt sich der Durchsatz im Vergleich zu FP8 logischerweise noch einmal.

An dieser Stelle noch nicht mit einberechnet ist, dass eine Blackwell-GPU über mehr SMs und damit mehr Tensor-Kerne verfügen wird und der Chip zudem höher taktet. Die Leistung steigt also um mehr als Faktor zwei.

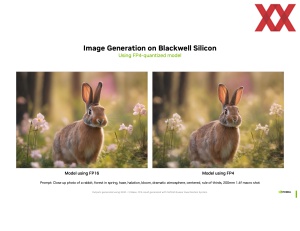

Wichtig ist aber, dass selbst unter Verwendung einfacherer Datenformate der Informationsgehalt im KI-Modell nicht verloren gehen darf. Dies sicherzustellen, ist eine entscheidende Aufgabe in der Quantisierung der Modelle. Für den Wechsel von FP16 auf FP8 kann dies auf Hardwareebene geschehen, ohne dass der Nutzer des Modells davon etwas mitbekommt oder eine entsprechende Optimierung durchführen muss. Obiges Beispiel eines durch KI erstellten Bildes soll verdeutlichen, dass trotz Nutzung von FP4 kaum bis keine reduzierte Qualität im Bild zu erkennen ist und der Prompt weiterhin bestmöglich umgesetzt wird.

Auch in Zahlen ausgedrückt sieht NVIDIA keinerlei Reduzierung in der Qualität des Modells:

| Modell | BF16 | Quantized FP4 |

| Nemotron-4 15B | 64,2 | 64,5 |

| Nemotron-4 340B | 81,1 | 81,1 |

Das MMLU-Ergebnis (Massive Multitask Language Understanding) ist unter Verwendung von BF16 zu FP4 fast identisch. Die Qualität des KI-Modells im Inferencing bleibt erhalten.

Neben der immer schnelleren Hardware ist die Software-Optimierung und dazu gehört die Quantifizierung großer KI-Modelle ein entscheidender Faktor für die Leistung.

NVIDIA beschränkt sich im Hinblick auf die Details zur Blackwell-Architektur weiterhin auf einige Details. Selbst mit der KI-Brille betrachtet schränkt man sich auf das Inferencing ein. Das Große Ganze fehlt uns noch, wenngleich bereits jetzt deutlich wird, dass NVIDIA mit den verschiedenen Varianten der Blackwell-Beschleuniger seinen Vorsprung vor der Konkurrenz weiter ausbauen wird.