Werbung

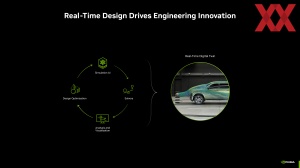

Zur Supercomputing-Konferenz präsentiert NVIDIA zunächst einmal neue NIM-Microservices, die im wissenschaftlichen Umfeld bei Berechnung komplexer Zusammenhänge zum Einsatz kommen sollen. Mit Omniverse Blueprint kombiniert werden verschiedene Microservices in Form eines Foundation Model, Trainings-Netzwerk sowie digitaler Stellvertreter, die dann zusammen mit 3D-Modellen komplexe Simulationen durchführen können. Für die Omniverse Blueprints arbeitet NVIDIA auch mit Ansys zusammen, die mit Fluent eine Multiphysis CFD-Software bereitstellen.

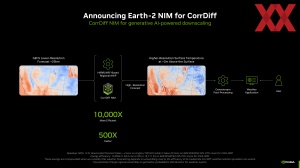

Für Wetter- und Klimasimulationen steht ab sofort Earth-2 NIM zur Verfügung. Über den Microservice sollen Klima- und Wettersimulationen um den Faktor 500 schneller möglich sein und sind zudem auch um den Faktor 10.000 effizienter. NVIDIA Alchemi NIM zielt auf Simulationen um Bereich der Materialforschung und Chemie ab.

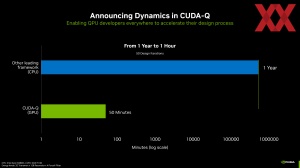

In der Erforschung der Quantencomputer ein wichtiger Faktor ist die Auswertung der Ergebnisse und hier die Eliminierung falscher Ergebnisse. Wochen, Monate und sogar Jahre können mehrere Iterationen an Zeit benötigen, um verifiziert zu werden. Diese Zeit will NVIDIA mit CUDA-Q von einem Jahr auf eine Stunde verkürzen können.

Google hat CUDA-Q in seinem Quantum-AI-Forschungs bereits übernommen. Google soll damit nun in der Lage sein umfassende Dynamiksimulationen neuer QPU-Designs durchzuführen.

Ein weiterer Aspekt im Angebot der Frameworks ist NumPy. NumPy ist eine Programmbibliothek, welche für die Simulation in den Bereichen Astronomie, Biologie, Chemie, Klimaforschung, Materialforschung, Physik und vielem mehr verwendet wird. Die GPU-Beschleunigung per cuPyNumeric soll Berechnung auf Basis von NumPy um den Faktor sechs beschleunigen können.

H200 NVL und GB200 NVL4 angekündigt

Eine der Hardwareankündigungen zur Supercomputing-Konferenz ist der H200-NVL-Beschleuniger. Dieser basiert auf der Hopper-Architektur und setzt auf das klassische PCI-Express-Format. Im Vergleich zur SMX-Variante mit einer TDP von bis zu 700 W, reduziert NVIDIA bei der H200 NVL die TDP auf bis zu 600 W, was auch einen Einfluss auf die Rechenleistung hat. Es bleibt allerdings bei der Speicherausstattung von 141 GB HBM3E mit einer Speicherbandbreite von 4,8 TB/s.

Über eine NVLink-Bridge können zwei oder vier Karten miteinander verbunden werden. Die Interconnect-Bandbreite liegt bei 900 GB/s pro GPU.

Bis zu 600 W auf einer PCI-Express-Karte mit zwei Slots abzuführen, ist sicherlich kein leichtes Unterfangen. Die Serverhersteller werden eine entsprechende Kühlung in Form eines Luftstroms im Server vorsehen müssen.

| H200 SXM | H200 NVL | |

| Chip | Hopper | Hopper |

| Formfaktor | SXM5 | PCI-Express |

| Speicher | 141 GB (HBM3E) | 141 GB (HBM3E) |

| Speicherbandbreite | 4,8 TB/s | 4,8 TB/s |

| cTDP | bis zu 700 W | bis zu 600 W |

| FP64-Rechenleistung | 34 TFLOPS | 30 TFLOPS |

| FP64-Rechenleistung (Tensor Cores) | 67 TFLOPS | 60 TFLOPS |

| FP32-Rechenleistung | 67 TFLOPS | 60 TFLOPS |

| TF32-Rechenleistung (Tensor Cores) | 989 TFLOPS | 835 TFLOPS |

| BFLOAT16-Rechenleistung (Tensor Cores) | 1.979 TFLOPS | 1.671 TFLOPS |

| FP16-Rechenleistung (Tensor Cores) | 1.979 TFLOPS | 1.671 TFLOPS |

| FP8-Rechenleistung (Tensor Cores) | 3.958 TFLOPS | 3.341 TFLOPS |

| INT8-Rechenleistung (Tensor Cores) | 3.958 TFLOPS | 3.341 TFLOPS |

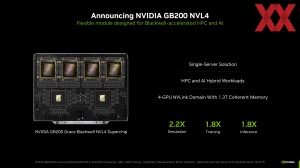

Als Erweiterung der Blackwell-Serie stellt NVIDIA zudem die Single-Server-Lösung GB200 NVL4 vor. Diese ergänzt die bereits erhältliche Lösung GB200 NVL2 mit jeweils zwei Grace-CPUs und zwei Blackwell-GPUs. Das GB200-NVL4-Modul besitzt ebenfalls zwei Grace-CPUs, aber vier Blackwell-GPUs.

Allesamt sind die Chips via NVLink miteinander verbunden. Insgesamt sprechen wir hier bei vier Blackwell-GPUs von 768 GB HBM3E mit einer Speicherbandbreite von zusammengenommen 32 TB/s. Hinzu kommen 960 GB an LPDDR5X, die an die zwei Grace-CPUs angebunden sind. Die Leistungsaufnahme des Moduls liegt bei 5.400 W – nicht weiter verwunderlich, denn ein GB200 NVL2 ist nichts anderes wie zwei GB200 Grace Blackwell Superchips mit jeweils 2.700 W.

Zusammen mit seinen Partnern im OEM-Bereich will NVIDIA nun die Auslieferung der Blackwell-Systeme hochfahren. Dazu gehören die Blackwell-Lösungen DGX B200, GB200 Grace Blackwell Superchip, GB200 Grace Blackwell NVL2, GB200 Grace Blackwell NVL4 und GB200 Grace Blackwell NVL72. Hinzu kommen die bestehenden Hopper-Lösungen.