Werbung

Nach der Vorstellung der EPYC-Prozessoren mit 3D V-Cache und der neuen Instinct-MI200-Serie als erste Datacenter-GPU im MCM-Design will AMD eine weitere Lücke im Portfolio schließen, die zwar wie ein kleines Detail klingt, jedoch einen großen Einfluss auf das Gesamtpaket hat.

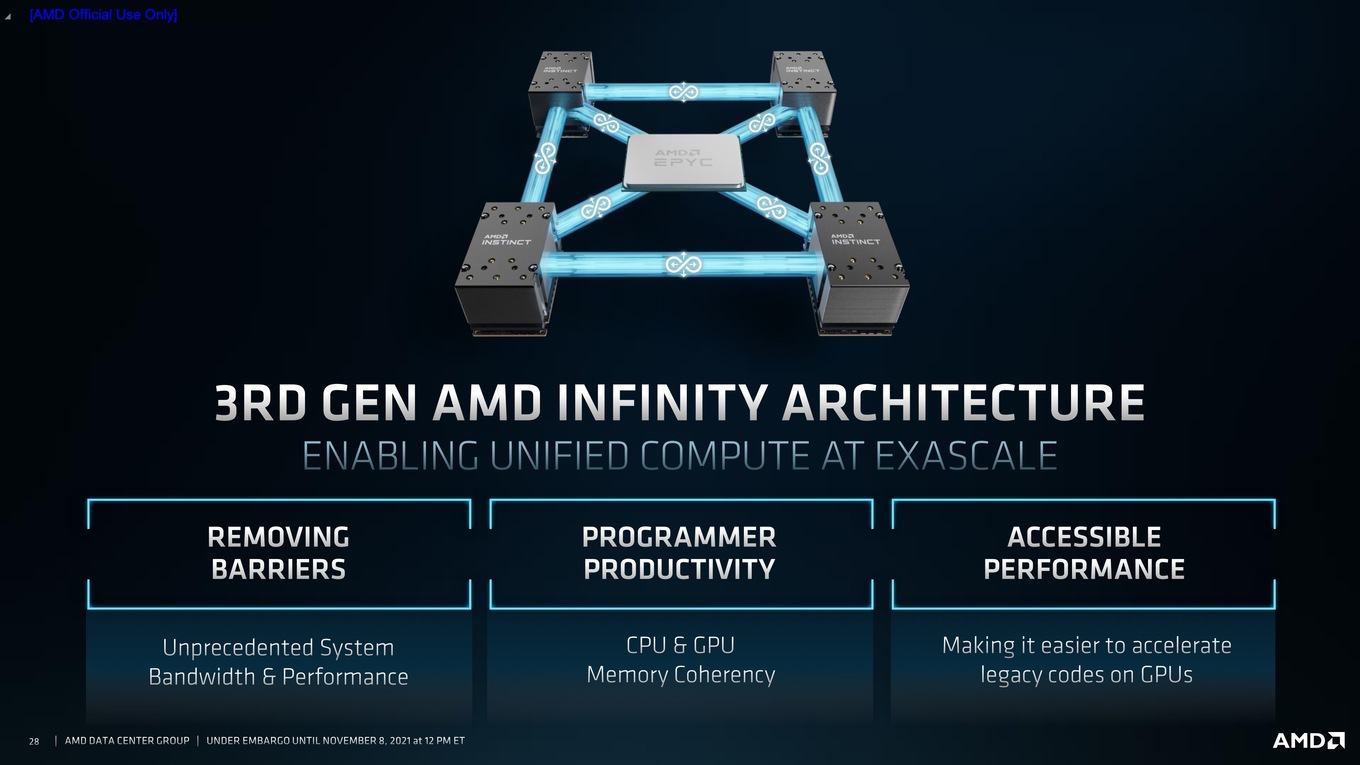

Der Infinity Fabric ist das Rückgrat aller aktuellen Prozessoren und GPUs von AMD. Der Infinity Fabric ist dabei nur der Oberbegriff für zahlreiche Interconnects, die bei AMD zum Einsatz kommen. Bei den GPUs ist dies beispielsweise die Anbindung des Infinity Cache, aber auch der Verbindung zwischen mehreren GPUs, die dann auf einen gemeinsamen kohärenten Speicher zugreifen können. Bei den Prozessoren wird der Infinity Fabric verwendet, um die CCDs mit dem IOD zu verbinden, aber auch der L3-Cache verwendet intern einen Interconnect zur Anbindung der acht Kerne.

Bereits im März 2020 sprach AMD über seine weiteren Pläne mit dem Infinity Fabric, denn bisher war es noch noch nicht möglich, eine solch kohärente Verbindung zwischen GPUs und Prozessoren aufzubauen. Mit der dritten Generation des Infinity Fabric soll dies nun anders sein. Die bisherige Anbindung über PCI-Express weicht der Möglichkeit dies zukünftig per Infinity Fabric zu tun.

Dazu kommen spezielle Prozessoren der dritten EPYC-Generation zum Einsatz. Sie basieren also weiterhin auf der Zen-3-Architektur, die bisher erhältlichen Modellen verfügen allerdings noch nicht über die externen Links für den Infinity Fabric.

Je nach Topologie können die EPYC-Prozessoren mit ihren acht Links des Infinity Fabric bis zu vier Beschleuniger der Instinct-MI200-Serie anbinden. Jeder Link wird direkt an einen GCD geführt. Die GCDs kommunizieren untereinander ebenfalls über direkte Links, bzw. es kann ein Infinity-Fabric-Ring aufgebaut werden. Jeder der Links verfügt über eine Bandbreite von 100 GB/s. Die EPYC-Prozessoren und die GPUs der Instinct-MI200-Serie kommen also auf jeweils 800 GB/s aufgeteilt in jeweils acht Links.

Die speziellen EPYC-Prozessoren sind aber nicht nur in der Lage, per Infinity Fabric eine Verbindung zu den GPUs aufzubauen, sondern kommunizieren untereinander weiterhin über den Infinity Fabric. Das Gesamtnetz des Infinity Fabric umfasst nun aber nicht mehr nur die EPYC-Prozessoren und die GPU-Beschleuniger jeweils untereinander, sondern das komplette System bestehend aus bis zu zwei EPYC-Prozessoren und bis zu acht Instinct MI250.